Die KI-Industrie steht vor einem kritischen Infrastruktur-Engpass. Das Training großer Sprachmodelle erfordert enorme Rechenressourcen, Edge-Geräte vervielfachen sich exponentiell, und GPU-Knappheit ist zur prägenden Einschränkung des KI-Zeitalters geworden. Gleichzeitig haben traditionelle Cloud-Anbieter Schwierigkeiten, die explodierende Nachfrage zu bedienen und zugleich ihre monopolartige Kontrolle über Zugang und Preisgestaltung zu bewahren.

Over 50% of generative AI companies report GPU shortages als großes Hindernis für das Skalieren ihrer Aktivitäten. AI computing power is expected to increase by roughly 60 times by the end of 2025 im Vergleich zu Q1 2023. Dieses Wettrüsten um Rechenleistung hat eine Chance für Krypto-Protokolle geschaffen, eine dezentrale Alternative vorzuschlagen.

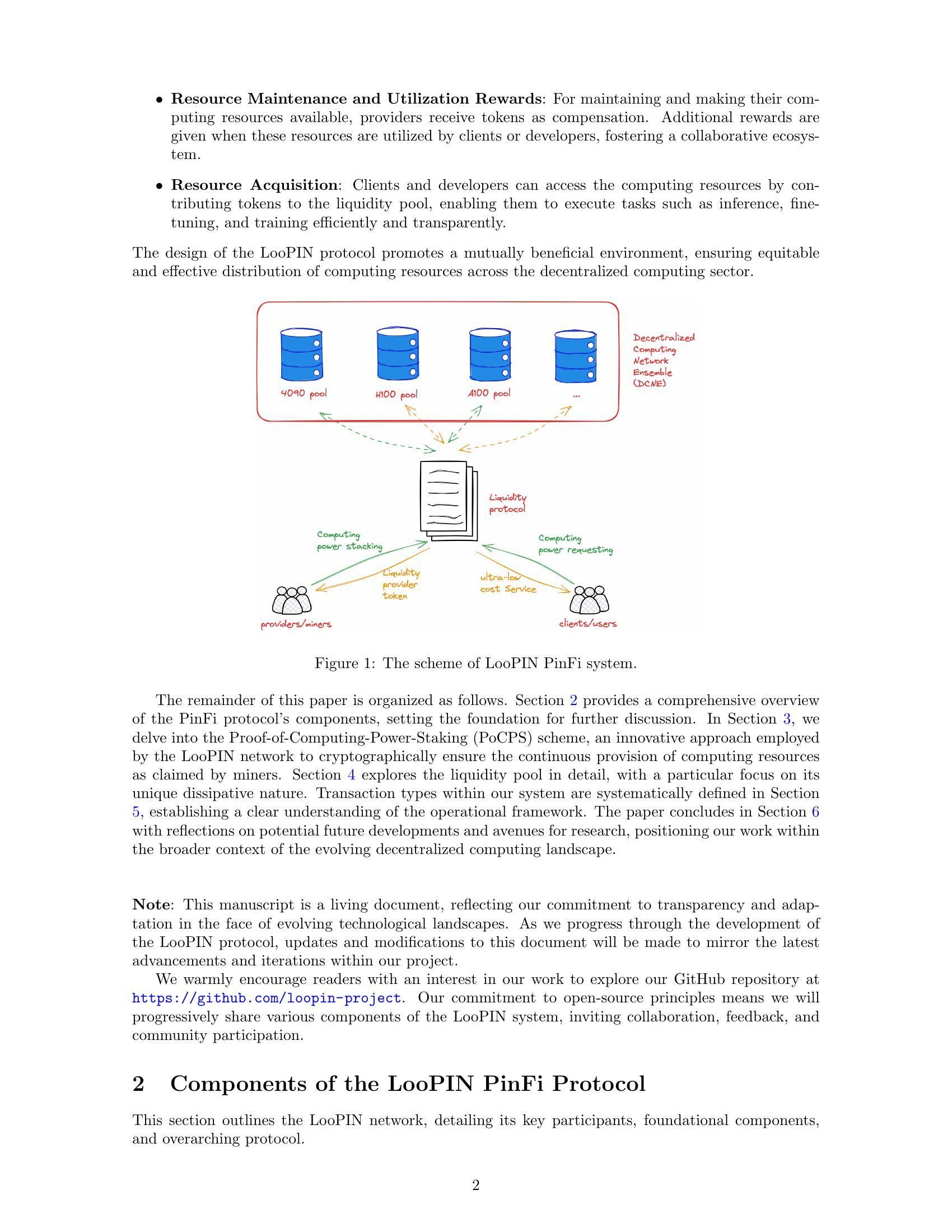

Hier kommt Physical Infrastructure Finance, oder PinFi, ins Spiel. Dieses aufkommende Rahmenwerk behandelt Rechenkapazität als tokenisierten Vermögenswert, der über blockchain-basierte Netzwerke gehandelt, gestakt und monetarisiert werden kann. Anstatt sich auf zentralisierte Rechenzentren zu stützen, bündeln PinFi-Protokolle ungenutzte GPU-Leistung von unabhängigen Betreibern, Gaming-Rigs, Mining-Farmen und Edge-Geräten in verteilten Marktplätzen, die KI-Entwicklern weltweit offenstehen.

Im Folgenden untersuchen wir, wie reale Rechenleistung in krypto-ökonomische Infrastruktur verwandelt wird, indem wir die Mechanik tokenisierter Compute-Netzwerke, die wirtschaftlichen Modelle zur Anreizsetzung für die Teilnahme, die Architektur zur Verifizierung und Abrechnung sowie die Auswirkungen auf die Krypto- und KI-Industrie verstehen.

Warum PinFi gerade jetzt? Die makroökonomischen & technischen Treiber

Der Rechen-Engpass der KI-Branche geht auf grundlegende Angebotsbeschränkungen zurück. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, wodurch viele Nutzer um Zugang ringen. The global AI chip market reached $123.16 billion in 2024 und soll bis 2029 auf 311,58 Milliarden US-Dollar steigen – ein explosionsartiges Wachstum, das die Produktionskapazitäten deutlich übersteigt.

Die GPU-Knappheit zeigt sich auf verschiedene Weise. Traditionelle Cloud-Anbieter führen Wartelisten für Premium-GPU-Instanzen. AWS charges $98.32 per hour for an 8-GPU H100 instance – eine Preisgestaltung, die fortgeschrittene KI-Fähigkeiten für viele Entwickler und Startups unerschwinglich macht. Die Hardwarepreise bleiben aufgrund von Engpässen hoch, HBM3 pricing rising 20-30% year-over-year.

Die Konzentration von Rechenleistung bei wenigen großen Cloud-Providern erzeugt zusätzliche Reibungen. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, doch der Zugang bleibt durch Verträge, geografische Beschränkungen und KYC-Anforderungen reglementiert. Diese Zentralisierung bremst Innovationen und schafft Single Points of Failure für kritische Infrastruktur.

Gleichzeitig bleiben enorme Rechenkapazitäten ungenutzt. Gaming-PCs stehen während der Arbeitszeit still. Krypto-Miner suchen nach neuen Einnahmequellen, da sich die Mining-Ökonomie wandelt. Rechenzentren halten in Nebenzeiten Überkapazitäten vor. The decentralized compute market has grown from $9 billion in 2024 und könnte bis 2032 auf 100 Milliarden US-Dollar anwachsen – ein Signal dafür, dass der Markt erkennt, wie verteilte Modelle dieses latente Angebot erschließen können.

Die Schnittstelle zwischen Blockchain-Technologie und physischer Infrastruktur ist durch dezentrale physische Infrastrukturnetzwerke (DePIN) gereift. DePIN-Protokolle nutzen Token-Anreize, um Aufbau und Betrieb realer Infrastrukturen zu koordinieren. Messari identified DePIN's total addressable market at $2.2 trillion, mit einem möglichen Anstieg auf 3,5 Billionen US-Dollar bis 2028.

PinFi überträgt die DePIN-Prinzipien gezielt auf Recheninfrastruktur. Rechenressourcen werden als tokenisierbare Vermögenswerte behandelt, die durch produktive Nutzung Rendite generieren. Dieses Rahmenwerk verwandelt Computing von einem Dienst, den man von zentralisierten Anbietern mietet, in eine Ware, die auf offenen, erlaubnisfreien Märkten gehandelt wird.

Was ist PinFi & tokenisierte Rechenleistung?

Physical Infrastructure Finance definiert ein Modell, bei dem physische Rechenressourcen als digitale Token auf Blockchains repräsentiert werden. So werden dezentrale Eigentumsverhältnisse, der Betrieb und die Monetarisierung ermöglicht. Anders als traditionelle DeFi-Protokolle, die sich mit rein digitalen Vermögenswerten befassen, schlägt PinFi Brücken zwischen physischen Off-Chain-Ressourcen und On-Chain-Ökosystemen.

Academic research defines tokenization als „den Prozess, bei dem Rechte, eine Einheit von Eigentum an einem Vermögenswert, Schulden oder sogar ein physischer Vermögenswert in einen digitalen Token auf einer Blockchain umgewandelt werden“. Für Rechenressourcen bedeutet dies, dass einzelne GPUs, Server-Cluster oder Edge-Geräte durch Token repräsentiert werden, die ihre Kapazität, Verfügbarkeit und Nutzung abbilden.

PinFi unterscheidet sich grundlegend von herkömmlicher Infrastrukturfinanzierung oder typischen DeFi-Protokollen. Klassische Infrastrukturfinanzierung umfasst langfristige Fremd- oder Eigenkapitalinvestitionen in große Kapitalprojekte. DeFi-Protokolle erleichtern hauptsächlich Handel, Kreditvergabe oder Renditegenerierung auf kryptonativen Assets. PinFi sitzt an der Schnittstelle: Es nutzt krypto-ökonomische Anreize, um reale Rechenressourcen zu koordinieren, während Abwicklung und Governance on-chain bleiben.

Mehrere Protokolle veranschaulichen das PinFi-Modell. Bittensor operates as a decentralized AI network, in dem Teilnehmer Machine-Learning-Modelle und Rechenressourcen zu spezialisierten Subnetzen beitragen, die auf bestimmte Aufgaben fokussiert sind. Der TAO-Token belohnt Beiträge anhand des Informationswerts, den sie zur kollektiven Intelligenz des Netzwerks liefern. With over 7,000 miners, die Rechenleistung bereitstellen, schafft Bittensor Märkte für KI-Inferenz und Modelltraining.

Render Network aggregates idle GPUs globally für verteilte GPU-Rendering-Aufgaben. Ursprünglich auf 3D-Rendering für Künstler und Content-Creator konzentriert, hat Render sein Angebot auf KI-Workloads ausgeweitet. Der RNDR-Token dient als Zahlungsmittel für Rendering-Jobs und belohnt GPU-Anbieter für ihre bereitgestellte Kapazität.

Akash Network operates as a decentralized cloud marketplace, der ungenutzte Rechenzentrums-Kapazitäten nutzt. Über ein Reverse-Auktionssystem definieren Compute-Nachfrager ihre Anforderungen, und Anbieter bieten darauf, diese zu erfüllen. Der AKT-Token ermöglicht Governance, Staking und Abrechnungen im Netzwerk. Akash witnessed notable surge in quarterly active leases, nachdem das Netzwerk seinen Fokus neben klassischen CPU-Ressourcen auf GPUs ausgeweitet hatte.

io.net has aggregated over 300,000 verified GPUs, indem Ressourcen unabhängiger Rechenzentren, Krypto-Miner und anderer DePIN-Netzwerke wie Render und Filecoin integriert wurden. Die Plattform konzentriert sich speziell auf KI- und Machine-Learning-Workloads und ermöglicht es Entwicklern, GPU-Cluster in über 130 Ländern innerhalb von Minuten zu deployen.

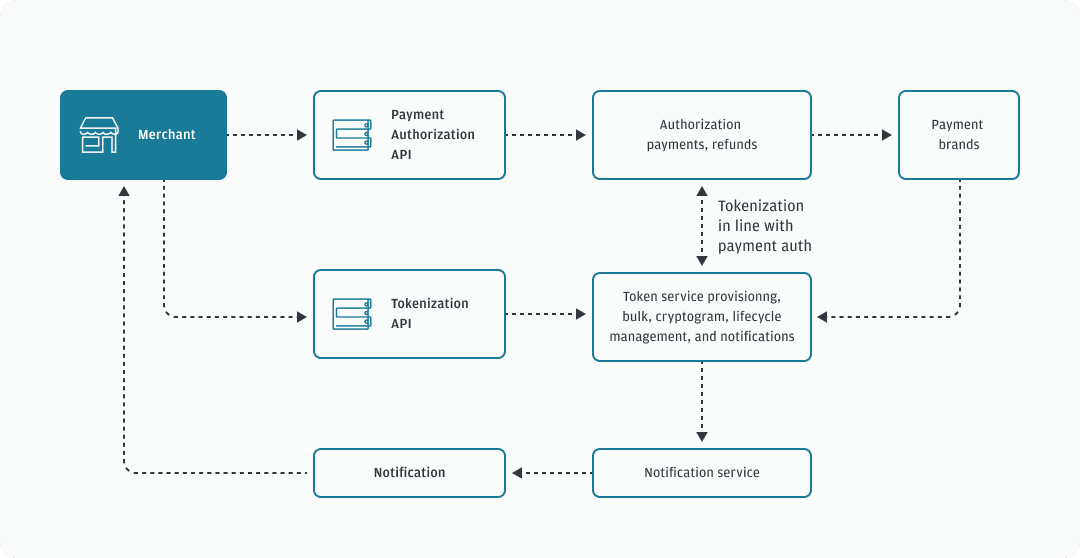

Die Mechanik tokenisierter Rechenleistung folgt über diese Protokolle hinweg einem ähnlichen Muster. Compute-Anbieter registrieren ihre Hardware im Netzwerk und durchlaufen Verifizierungsprozesse, um Kapazität und Fähigkeiten nachzuweisen. Smart Contracts steuern das Verhältnis von Angebot und Nachfrage, indem sie Jobs nach Anforderungen, Preis und geografischen Vorgaben an verfügbare Nodes routen. Token-Belohnungen schaffen Anreize sowohl für die Bereitstellung von Hardware als auch für qualitativ hochwertige Service-Erbringung.

Wertschöpfung erfolgt durch tatsächliche Nutzung statt durch Spekulation. Wenn ein KI-Entwickler ein Modell mit verteilten GPU-Ressourcen trainiert, fließen Zahlungen an die Anbieter, deren Hardware die Arbeit ausgeführt hat. Die Rechenleistung wird zu einem produktiven Asset, das Rendite generiert – ähnlich wie Proof-of-Stake-Validatoren Belohnungen für die Netzwerksicherung erhalten. So entstehen nachhaltige Ökonomien, in denen der Tokenwert mit dem Nutzen des Netzwerks korreliert.

Infrastruktur-Architektur: Nodes, Marktplätze, Abrechnung

Die Architektur tokenisierter Rechenleistung erfordert Koordination über mehrere Ebenen. An der Basis steht ein Netzwerk unabhängiger Compute-Anbieter, die Hardware bereitstellen, sich bei Protokollen registrieren und Kapazitäten zur Vermietung anbieten. Diese Anbieter reichen von Einzelpersonen mit Gaming-PCs über professionelle Rechenzentrumsbetreiber bis hin zu Krypto-Mining-Operationen, die zusätzliche Erlösquellen suchen.

Die Bereitstellung von Nodes beginnt, wenn ein Compute-Anbieter seine Hardware mit dem Netzwerk verbindet. Protocols like io.net support diverse GPU types, von Consumer-GPUs wie NVIDIA RTX 4090 bis hin zu Enterprise-GPUs wie H100 und A100. Der Anbieter installiert eine Client-Software, die die Kapazität gegenüber der Orchestrierungsschicht des Netzwerks sichtbar macht und zugleich Sicherheitsgrenzen wahrt, die unbefugten Zugriff verhindern.

Verifizierungsmechanismen stellen sicher, dass die beworbene Kapazität den tatsächlichen Fähigkeiten entspricht. Manche Protokolle nutzen kryptografische „Proofs of Compute“, bei denen Knoten müssen nachweisen, dass sie bestimmte Berechnungen korrekt durchgeführt haben. Bittensor verwendet seinen Yuma-Consensus-Mechanismus, bei dem Validatoren die Qualität der Machine-Learning-Ergebnisse der Miner bewerten und Scores vergeben, die die Verteilung der Rewards bestimmen. Knoten, die minderwertige Ergebnisse liefern oder versuchen zu betrügen, erhalten reduzierte Vergütungen oder werden durch das Slashing der gestakten Token bestraft.

Latenz-Benchmarking hilft dabei, Workloads mit geeigneter Hardware zu matchen. KI-Inferenz erfordert andere Performance-Eigenschaften als Modelltraining oder 3D-Rendering. Der geografische Standort beeinflusst die Latenz bei Edge-Computing-Anwendungen, bei denen die Verarbeitung in der Nähe der Datenquellen erfolgen muss. Der Edge-Computing-Markt erreichte 2024 ein Volumen von 23,65 Milliarden US‑Dollar und wird voraussichtlich bis 2033 auf 327,79 Milliarden US‑Dollar anwachsen, getrieben durch die Nachfrage nach lokalisierter Verarbeitung.

Die Marktplatz-Schicht verbindet Compute-Nachfrage mit -Angebot. Wenn Entwickler GPU-Ressourcen benötigen, geben sie Anforderungen an, einschließlich Rechenleistung, Speicher, Dauer und maximalem Preis. Akash verwendet ein Reverse-Auktionsmodell, bei dem Deployers Bedingungen festlegen und Anbieter bieten, um Aufträge zu gewinnen. Render nutzt dynamische Preisalgorithmen, die die Preise anhand von Netzauslastung und Marktbedingungen anpassen.

Job-Routing-Algorithmen optimieren die Platzierung von Compute-Aufgaben über die verfügbaren Knoten hinweg. Berücksichtigt werden Faktoren wie Hardwarespezifikationen, aktuelle Auslastung, geografische Nähe, historische Performance und Preis. Die Orchestrierungsschicht von io.net verarbeitet containerisierte Workflows und unterstützt Ray-native Orchestrierung für verteilte Machine-Learning-Workloads.

Settlement erfolgt on-chain über Smart Contracts, die Zahlungen treuhänderisch verwahren und Gelder nach verifizierter Aufgabenerfüllung freigeben. Dieses trustless Settlement eliminiert Gegenparteirisiko und ermöglicht Mikrotransaktionen für kurz laufende Compute-Jobs. Protokolle auf Hochdurchsatz-Blockchains wie Solana können das Transaktionsvolumen bewältigen, das durch Tausende gleichzeitiger Inferenzanfragen entsteht.

Staking-Mechanismen richten die Anreize der Teilnehmer aus. Compute-Anbieter staken häufig Token, um Commitment zu demonstrieren und Sicherheiten bereitzustellen, die bei schlechter Performance geslasht werden können. Validatoren in Bittensor staken TAO-Token, um Einfluss auf die Bewertung der Miner zu gewinnen und Teile der Block-Rewards zu verdienen. Token-Inhaber können Stake an Validatoren delegieren, denen sie vertrauen, ähnlich wie bei Proof-of-Stake-Konsensmechanismen.

Governance ermöglicht es Token-Inhabern, über Protokollparameter wie Reward-Verteilung, Gebührenstrukturen und Netzwerk-Upgrades abzustimmen. Dezentrale Governance stellt sicher, dass keine zentrale Instanz einseitig Regeln ändern oder den Zugang beschränken kann, und erhält so die Permissionless-Eigenschaften, die diese Netzwerke von traditionellen Cloud-Anbietern unterscheiden.

Die Architektur steht in starkem Kontrast zu zentralisiertem Cloud Computing. Große Anbieter besitzen ihre eigene Infrastruktur, setzen Preise ohne echten Marktwettbewerb fest, verlangen Accounts und Compliance-Prüfungen und behalten die Kontrolle über Zugang und Zensur. PinFi-Protokolle verteilen das Eigentum auf Tausende unabhängiger Betreiber, ermöglichen transparente, marktbasiere Preisbildung, arbeiten permissionless und sind aufgrund ihrer Dezentralisierung zensurresistent.

Tokenomics & Anreizmodelle

Token-Ökonomie stellt die Anreizstruktur bereit, die verteilte Compute-Netzwerke koordiniert. Native Token erfüllen mehrere Funktionen, darunter Bezahlung für Services, Rewards für die Bereitstellung von Ressourcen, Governance-Rechte und Staking-Anforderungen für die Teilnahme am Netzwerk.

Emissionsmechanismen bestimmen, wie Token in Umlauf kommen. Bittensor folgt dem Bitcoin-Modell mit einem begrenzten Angebot von 21 Millionen TAO-Token und periodischen Halvings, die die Emission im Laufe der Zeit verringern. Derzeit werden täglich 7.200 TAO gemintet, aufgeteilt zwischen Minern, die Rechenressourcen bereitstellen, und Validatoren, die die Netzwerkqualität sicherstellen. Dies schafft eine Knappheit ähnlich wie bei Bitcoin und lenkt die Inflation zugleich in produktive Infrastruktur.

Andere Protokolle geben Token basierend auf der Netzwerknutzung aus. Wenn Compute-Jobs ausgeführt werden, fließen neu gemintete Token proportional zu den bereitgestellten Ressourcen an die Anbieter. Diese direkte Kopplung von Wertschöpfung und Token-Emission stellt sicher, dass Inflation tatsächliche Produktivität statt passives Token-Halten belohnt.

Staking sorgt für „Skin in the Game“ bei Netzwerkteilnehmern. Compute-Anbieter staken Token, um Knoten zu registrieren und Commitment zu zeigen. Schlechte Performance oder Betrugsversuche führen zu Slashing, bei dem gestakte Token zerstört oder an geschädigte Parteien umverteilt werden. Diese wirtschaftliche Strafe schafft Anreize für zuverlässige Servicebereitstellung und ehrliches Verhalten.

Validatoren staken größere Beträge, um Einfluss auf Qualitätsbewertungen und Governance-Entscheidungen zu gewinnen. Im Bittensor-Modell bewerten Validatoren die Outputs der Miner und reichen Gewichtungsmatrizen ein, die angeben, welche Knoten wertvolle Beiträge geleistet haben. Der Yuma Consensus aggregiert diese Einschätzungen, gewichtet nach Validator-Stake, um die endgültige Reward-Verteilung festzulegen.

Die Angebots-Nachfrage-Dynamik für Compute-Token wirkt auf zwei Ebenen. Auf der Angebotsseite erhöht eine größere Zahl von Knoten die verfügbare Rechenkapazität. Token-Rewards müssen ausreichen, um Hardwarekosten, Strom und Opportunitätskosten gegenüber alternativen Nutzungsmöglichkeiten zu decken. Steigende Token-Preise machen die Bereitstellung von Compute profitabler und ziehen zusätzliches Angebot an.

Auf der Nachfrageseite spiegelt der Tokenpreis wider, welchen Wert Nutzer dem Zugang zum Netzwerk beimessen. Mit der Verbreitung von KI-Anwendungen und zunehmender Compute-Knappheit steigt die Zahlungsbereitschaft für dezentrale Ressourcen. Es wird erwartet, dass der Markt für KI-Hardware von 66,8 Milliarden US‑Dollar im Jahr 2025 auf 296,3 Milliarden US‑Dollar im Jahr 2034 wächst, was eine anhaltende Nachfrage nach alternativen Compute-Quellen schafft.

Die Wertsteigerung der Token kommt allen Teilnehmern zugute. Hardware-Anbieter verdienen mehr für dieselbe Rechenleistung. Frühe Knotenbetreiber profitieren von der Wertsteigerung angesammelter Rewards. Entwickler gewinnen eine dezentrale Alternative zu teuren zentralisierten Anbietern. Token-Inhaber, die staken oder Liquidität bereitstellen, partizipieren an Gebühren aus der Netzwerkaktivität.

Risikomodelle adressieren potenzielle Fehlermodi. Node-Ausfälle verringern Einnahmen, da Jobs an verfügbare Alternativen umgeleitet werden. Geografische Konzentration erzeugt Latenzprobleme für Edge-Anwendungen, die lokale Verarbeitung erfordern. Netzwerkeffekte begünstigen größere Protokolle mit vielfältigerer Hardware und geografischer Verteilung.

Token-Inflation muss den Anreiz für neues Angebot mit dem Werterhalt für bestehende Inhaber ausbalancieren. Forschung zu dezentralen Infrastrukturprotokollen stellt fest, dass nachhaltige Tokenomics erfordern, dass die Nachfrage schneller wächst als das Angebot. Protokolle implementieren Burning-Mechanismen, bei denen für Zahlungen verwendete Token dauerhaft aus dem Umlauf entfernt werden und so deflationären Druck erzeugen, der inflationäre Emissionen ausgleicht.

Gebührenstrukturen variieren zwischen Netzwerken. Einige verlangen von Nutzern direkt Zahlungen in nativen Token. Andere akzeptieren Stablecoins oder Wrapped-Versionen großer Kryptowährungen, wobei Protokoll-Token vor allem Governance- und Staking-Funktionen erfüllen. Hybride Modelle nutzen Token für den Netzzugang, während Compute-Zahlungen in stabilen Assets abgewickelt werden, um Volatilitätsrisiken zu reduzieren.

Der Designraum für Anreizmodelle entwickelt sich weiter, da Protokolle mit unterschiedlichen Ansätzen experimentieren, um die Interessen der Stakeholder auszubalancieren und nachhaltiges langfristiges Wachstum zu sichern.

KI, Edge und reale Infrastruktur

Tokenisierte Compute-Netzwerke ermöglichen Anwendungen, die verteilte Hardware für KI-Workloads, Edge-Verarbeitung und spezialisierte Infrastrukturbedarfe nutzen. Die Vielfalt der Anwendungsfälle zeigt, wie dezentrale Modelle Engpässe in der gesamten Rechen-Stack adressieren können.

Verteiltes Training von KI-Modellen stellt einen primären Anwendungsfall dar. Das Training großer Sprachmodelle oder Computer-Vision-Systeme erfordert massive parallele Berechnung über viele GPUs. Herkömmliche Ansätze konzentrieren dieses Training in zentralisierten Rechenzentren im Besitz großer Cloud-Anbieter. Dezentrale Netzwerke ermöglichen es, Training über geografisch verteilte Knoten hinweg durchzuführen, wobei jeder Knoten Rechenarbeit beisteuert, die über Blockchain-basierte Orchestrierung koordiniert wird.

Die Subnet-Architektur von Bittensor ermöglicht spezialisierte KI-Märkte, die sich auf bestimmte Aufgaben wie Textgenerierung, Bildsynthese oder Datenscraping konzentrieren. Miner konkurrieren darum, hochwertige Ergebnisse in ihren gewählten Domänen zu liefern, während Validatoren die Performance bewerten und Rewards entsprechend verteilen. So entstehen kompetitive Märkte, in denen sich die besten Modelle und effizientesten Implementierungen durch wirtschaftliche Selektion natürlicherweise durchsetzen.

Edge-Computing-Workloads profitieren besonders von dezentraler Infrastruktur. Der globale Edge-Computing-Markt wurde 2024 mit 23,65 Milliarden US‑Dollar bewertet, angetrieben von Anwendungen, die …geringe Latenz und lokale Verarbeitung. IoT‑Geräte, die kontinuierliche Sensordaten erzeugen, benötigen eine sofortige Analyse ohne Round‑Trip‑Verzögerungen zu weit entfernten Rechenzentren. Autonome Fahrzeuge erfordern Entscheidungen im Millisekundenbereich, die keine Netzwerklatenz tolerieren können.

Dezentrale Compute‑Netzwerke können Rechenkapazität physisch nahe an den Datenquellen platzieren. Eine Fabrik, die industrielle IoT‑Sensoren einsetzt, kann Edge‑Knoten in derselben Stadt oder Region mieten, anstatt sich auf zentralisierte Clouds hunderte Meilen entfernt zu verlassen. Industrial IoT applications accounted for the largest market share in edge computing in 2024, was die kritische Bedeutung lokalisierter Verarbeitung für Fertigung und Logistik widerspiegelt.

Content‑Rendering und kreative Workflows verbrauchen erhebliche GPU‑Ressourcen. Künstler, die 3D‑Szenen rendern, Animatoren, die Filme produzieren, und Spieleentwickler, die Assets kompilieren, benötigen alle intensive Parallelverarbeitung. Render Network specializes in distributed GPU rendering, verbindet Kreative mit ungenutzter GPU‑Kapazität weltweit. Dieses Marktplatzmodell senkt die Rendering‑Kosten und bietet gleichzeitig Einnahmequellen für GPU‑Besitzer in Nebenzeiten.

Wissenschaftliches Rechnen und Forschungsanwendungen stehen vor Budgetbeschränkungen beim Zugriff auf teure Cloud‑Ressourcen. Akademische Einrichtungen, unabhängige Forscher und kleinere Organisationen können dezentrale Netzwerke nutzen, um Simulationen auszuführen, Datensätze zu analysieren oder spezialisierte Modelle zu trainieren. Die permissionless‑Struktur bedeutet, dass Forscher in jeder Region auf Rechenressourcen zugreifen können, ohne institutionelle Cloud‑Konten oder Bonitätsprüfungen.

Gaming‑ und Metaverse‑Plattformen benötigen Rendering‑ und Physikberechnungen für immersive Erlebnisse. Mit zunehmender Komplexität virtueller Welten steigen die Rechenanforderungen zur Aufrechterhaltung persistenter Umgebungen und zur Unterstützung von Tausenden gleichzeitiger Nutzer. Edge‑verteilte Compute‑Knoten können lokale Verarbeitung für regionale Spielerpopulationen bereitstellen, die Latenz reduzieren und gleichzeitig die Infrastrukturkosten auf token‑inzentivierte Anbieter verteilen.

KI‑Inference im großen Maßstab erfordert kontinuierlichen GPU‑Zugriff, um Vorhersagen aus trainierten Modellen bereitzustellen. Ein Chatbot, der Millionen von Anfragen bedient, ein Bildgenerierungsdienst, der Nutzereingaben verarbeitet, oder eine Empfehlungsmaschine, die Nutzerverhalten analysiert, benötigen alle jederzeit verfügbare Rechenleistung. Dezentrale Netzwerke bieten Redundanz und geografische Verteilung, die die Zuverlässigkeit im Vergleich zu Abhängigkeiten von einzelnen Anbietern erhöhen.

Geografische Zonen, die von großen Cloud‑Anbietern unterversorgt sind, bieten Chancen für PinFi‑Protokolle. Regionen mit begrenzter Rechenzentrumspräsenz sehen sich mit höherer Latenz und höheren Kosten beim Zugriff auf zentralisierte Infrastrukturen konfrontiert. Lokale Hardwareanbieter in diesen Gebieten können Rechenkapazität bereitstellen, die auf die regionale Nachfrage zugeschnitten ist, Token‑Belohnungen verdienen und gleichzeitig den lokalen Zugang zu KI‑Fähigkeiten verbessern.

Anforderungen an die Datensouveränität verlangen zunehmend, dass bestimmte Workloads Daten innerhalb spezifischer Rechtsräume verarbeiten. Regulations like the EU Data Act require sensitive information to be processed locally und fördern die Bereitstellung von Edge‑Infrastruktur, die Residenzanforderungen erfüllt. Dezentrale Netzwerke unterstützen von Natur aus die Bereitstellung von Knoten in bestimmten Jurisdiktionen, während sie durch blockchain‑basierte Abwicklung globale Koordination aufrechterhalten.

Why It Matters: Implications for Crypto & Infrastructure

Das Aufkommen von PinFi steht für die Ausweitung von Krypto über rein finanzielle Anwendungen hinaus hin zur Koordination realer Infrastruktur. Dieser Wandel hat Auswirkungen sowohl auf das Krypto‑Ökosystem als auch auf die breiteren Computer‑Industrien.

Krypto‑Protokolle zeigen Nutzen jenseits von Spekulation, wenn sie greifbare Infrastrukturprobleme lösen. DePIN und PinFi schaffen ökonomische Systeme, die physische Ressourcen koordinieren, und beweisen, dass blockchain‑basierte Anreize reale Netzwerke aus dem Nichts aufbauen können. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, was ungefähr dem Dreifachen der heutigen gesamten Krypto‑Marktkapitalisierung entspricht.

Die Demokratisierung des Zugangs zu Rechenleistung adressiert eine grundlegende Asymmetrie in der KI‑Entwicklung. Derzeit sind fortgeschrittene KI‑Fähigkeiten weitgehend auf gut finanzierte Technologieunternehmen konzentriert, die sich massive GPU‑Cluster leisten können. Startups, Forscher und Entwickler in ressourcenbeschränkten Umgebungen sehen sich Barrieren gegenüber, an KI‑Innovation teilzunehmen. Dezentrale Compute‑Netzwerke senken diese Hürden, indem sie permissionless Zugriff auf verteilte Hardware zu marktbasierten Preisen bieten.

Die Schaffung neuer Anlageklassen erweitert das Krypto‑Investitionsspektrum. Tokens, die Rechenkapazität repräsentieren, verkörpern Eigentum an produktiver Infrastruktur, die durch reale Nutzung Einnahmen generiert. Dies unterscheidet sich von rein spekulativen Assets oder Governance‑Tokens ohne klare Wertabschöpfungsmechanismen. Token‑Inhaber besitzen im Wesentlichen Anteile an einem dezentralen Cloud‑Anbieter, wobei der Wert an die Nachfrage nach Rechendienstleistungen gekoppelt ist.

Traditionelle Infrastrukture‑Monopole sehen sich potenzieller Disruption gegenüber. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control über Computemärkte und setzen Preise ohne direkten Wettbewerb fest. Dezentrale Alternativen führen Marktdynamiken ein, in denen Tausende unabhängiger Anbieter konkurrieren und so potenziell Kosten senken und die Zugänglichkeit verbessern.

Die KI‑Industrie profitiert von einer verringerten Abhängigkeit von zentralisierter Infrastruktur. Derzeit konzentriert sich KI‑Entwicklung um große Cloud‑Provider, was Single Points of Failure und Klumpenrisiken schafft. Over 50% of generative AI companies report GPU shortages as major obstacles. Verteilte Netzwerke stellen alternative Kapazitäten bereit, die Nachfragespitzen abfedern und Redundanz gegenüber Störungen in den Lieferketten bieten können.

Verbesserungen der Energieeffizienz können sich aus besserer Auslastung der Kapazitäten ergeben. Gaming‑Rigs im Leerlauf verbrauchen Standby‑Strom ohne produktiven Output. Mining‑Operationen mit überschüssiger Kapazität suchen nach zusätzlichen Einnahmequellen. Distributed networks put idle GPUs to productive use und verbessern die Ressourceneffizienz im gesamten Rechenökosystem.

Zensurresistenz wird für KI‑Anwendungen relevant. Zentralisierte Cloud‑Anbieter können bestimmten Nutzern, Anwendungen oder ganzen Regionen den Dienst verweigern. Dezentrale Netzwerke arbeiten permissionless und ermöglichen KI‑Entwicklung und ‑Bereitstellung ohne Zustimmung von Gatekeepern. Dies ist besonders wichtig für kontroverse Anwendungen oder Nutzer in restriktiven Rechtsräumen.

Datenschutzarchitekturen verbessern sich durch lokale Verarbeitung. Edge computing keeps sensitive data near its source, statt sie an weit entfernte Rechenzentren zu übertragen. Dezentrale Netzwerke können datenschutzfreundliche Techniken wie föderiertes Lernen implementieren, bei denen Modelle auf verteilten Daten trainieren, ohne Rohinformationen zu zentralisieren.

Die Markteffizienz steigt durch transparente Preisfindung. Traditionelle Cloud‑Preise bleiben intransparent, mit komplexen Gebührenstrukturen und ausgehandelten Enterprise‑Verträgen. Dezentrale Marktplätze etablieren klare Spot‑Preise für Rechenressourcen und ermöglichen es Entwicklern, Kosten zu optimieren und Anbietern, ihre Einnahmen durch Wettbewerbsdynamiken zu maximieren.

Langfristige Relevanz ergibt sich aus anhaltenden Nachfragetreibern. KI‑Workloads werden weiter wachsen, da Anwendungen sich verbreiten. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Compute wird ein grundlegender Engpass bleiben und damit eine anhaltende Nachfrage nach alternativen Infrastruktumodellen sicherstellen.

Netzwerkeffekte begünstigen frühe Protokolle, die kritische Masse erreichen. Mit jedem neuen Hardwareanbieter steigt die Vielfalt der verfügbaren Ressourcen. Die geografische Verteilung verbessert sich, wodurch die Latenz für Edge‑Anwendungen sinkt. Größere Netzwerke ziehen mehr Entwickler an und schaffen positive Rückkopplungsschleifen des Wachstums. First Mover in spezifischen Domänen können dauerhafte Vorteile etablieren.

Challenges & Risks

Trotz vielversprechender Anwendungen stehen tokenisierte Compute‑Netzwerke vor erheblichen technischen, wirtschaftlichen und regulatorischen Herausforderungen, die Wachstum bremsen oder die Adoption begrenzen könnten.

Technische Zuverlässigkeit bleibt eine Hauptsorge. Zentralisierte Cloud‑Anbieter bieten Service Level Agreements, die Verfügbarkeit und Performance garantieren. Verteilte Netzwerke koordinieren Hardware unabhängiger Betreiber mit unterschiedlichen Professionalitätsgraden und Infrastrukturqualität. Knotenausfälle, Netzausfälle oder Wartungsfenster erzeugen Verfügbarkeitslücken, die durch Redundanz und Routing‑Algorithmen gemanagt werden müssen.

Die Verifikation der tatsächlich erbrachten Arbeit stellt eine fortlaufende Herausforderung dar. Sicherzustellen, dass Knoten Berechnungen ehrlich ausführen, statt falsche Ergebnisse zurückzugeben, erfordert ausgefeilte Nachweissysteme. Cryptographic proofs of compute verursachen Overhead, bleiben aber notwendig, um Betrug zu verhindern. Unvollkommene Verifikationsmechanismen ermöglichen potenzielle Angriffe, bei denen böswillige Knoten Belohnungen beanspruchen, ohne die versprochenen Dienste zu erbringen.

Latenz- und Bandbreitenbeschränkungen beeinträchtigen verteilte Workloads. Running computations across geographically dispersed locations can cause …Verzögerungen im Vergleich zu gemeinsam untergebrachter Hardware in einzelnen Rechenzentren. Die Netzwerkbandbreite zwischen den Knoten begrenzt die Arten von Workloads, die sich für verteilte Verarbeitung eignen. Eng gekoppelte Parallelberechnungen, die häufige Kommunikation zwischen Knoten erfordern, sind von Leistungseinbußen betroffen.

Die Variabilität der Dienstgüte erzeugt Unsicherheit für produktive Anwendungen. Anders als in verwalteten Cloud-Umgebungen mit vorhersehbarer Performance führen heterogene Hardware-Pools zu inkonsistenten Ergebnissen. Ein Trainingslauf kann je nach Verfügbarkeit entweder auf Enterprise-H100s oder auf Consumer-RTX-Karten ausgeführt werden. Anwendungsentwickler müssen diese Variabilität einplanen oder Filtermechanismen implementieren, die Jobs auf bestimmte Hardware-Tiers beschränken.

Ökonomische Nachhaltigkeit erfordert ein Gleichgewicht zwischen Angebotswachstum und Nachfrageausweitung. Ein schneller Anstieg der verfügbaren Rechenkapazität ohne entsprechendes Nachfragewachstum würde Tokenpreise drücken und die Rentabilität der Provider verringern. Protokolle müssen die Token-Emission sorgfältig steuern, um eine Inflation zu vermeiden, die das Nutzungswachstum übersteigt. Nachhaltige Tokenomics erfordern, dass das Nachfragewachstum die Angebotsausweitung übertrifft.

Token-Wertkompression birgt Risiken für langfristige Teilnehmer. Wenn neue Provider den Netzwerken beitreten, um Rewards zu erhalten, senkt der zunehmende Wettbewerb die Erträge pro Knoten. Frühe Teilnehmer, die von höheren anfänglichen Rewards profitieren, können im Zeitverlauf sinkende Renditen beobachten. Gelingt es der Token-Aufwertung nicht, diese Verwässerung auszugleichen, steigt die Abwanderung der Provider und die Netzstabilität leidet.

Marktvolatilität führt zu finanziellem Risiko für Teilnehmer. Provider erhalten Rewards in nativen Tokens, deren Wert schwankt. Ein Hardware-Betreiber könnte Kapital in GPU-Käufe investieren, in der Erwartung stabiler Tokenpreise, und dennoch Verluste erleiden, falls die Kurse fallen. Absicherungsmechanismen und Stablecoin-Zahlungsoptionen können die Volatilität abmildern, erhöhen aber die Komplexität.

Regulatorische Unsicherheit in Bezug auf die Einstufung von Tokens schafft Compliance-Herausforderungen. Wertpapieraufsichtsbehörden in verschiedenen Jurisdiktionen prüfen, ob Compute-Tokens Wertpapiere darstellen, die registrierungspflichtig sind. Ein unklarer Rechtsstatus schränkt die institutionelle Teilnahme ein und erzeugt Haftungsrisiken für Protokollentwickler. Die Tokenisierung von Infrastruktur ist mit regulatorischen Unsicherheiten konfrontiert, die die Adoption im Vergleich zu traditionellen Finanzstrukturen begrenzt haben.

Datenschutzvorschriften legen Anforderungen fest, die verteilte Netzwerke erfüllen müssen. Die Verarbeitung von Daten europäischer Bürger erfordert DSGVO-Konformität, einschließlich Datenminimierung und Recht auf Löschung. Healthcare-Anwendungen müssen HIPAA-Anforderungen erfüllen. Finanzanwendungen unterliegen Auflagen zur Bekämpfung von Geldwäsche. Dezentralisierte Netzwerke erschweren die Compliance, wenn Daten über mehrere Jurisdiktionen und unabhängige Betreiber hinweg übertragen werden.

Hardware-Beiträge können je nach Ausgestaltung der Vereinbarungen regulatorische Prüfungen auslösen. Jurisdiktionen könnten bestimmte Provider-Beziehungen als Wertpapierangebote oder regulierte Finanzprodukte einstufen. Die Grenze zwischen Infrastrukturbereitstellung und Investmentverträgen ist in vielen Rechtsrahmen weiterhin unklar.

Der Wettbewerb mit Hyperscale-Cloud-Providern verschärft sich weiter. Große Anbieter investieren Milliarden in neue Rechenzentrumskapazitäten und kundenspezifische AI-Beschleuniger. AWS, Microsoft und Google gaben 2024 36 % mehr für Investitionsausgaben aus, größtenteils für AI-Infrastruktur. Diese gut kapitalisierten Platzhirsche können Preise unterbieten oder Compute zusammen mit anderen Services bündeln, um ihre Marktanteile zu verteidigen.

Netzwerkfragmentierung könnte die Komponierbarkeit einschränken. Mehrere konkurrierende Protokolle schaffen isolierte Ökosysteme, in denen Rechenressourcen nicht einfach zwischen Netzwerken transferiert werden können. Fehlende Standardisierung bei APIs, Verifikationsmechanismen oder Tokenstandards verringert die Effizienz und erhöht die Wechselkosten für Entwickler.

Early-Adopter-Risiko betrifft Protokolle ohne nachgewiesene Erfolgsbilanz. Neue Netzwerke stehen vor Henne-Ei-Problemen, gleichzeitig Hardware-Provider und Compute-Nachfrager anzuziehen. Protokolle könnten es nicht schaffen, die kritische Masse für einen nachhaltigen Betrieb zu erreichen. Token-Investoren sehen sich dem Risiko eines Totalverlusts ausgesetzt, falls Netzwerke kollabieren oder keine Adoption erzielen.

Sicherheitslücken in Smart Contracts oder Koordinationsebenen könnten Diebstahl von Geldern oder Störungen des Netzwerks ermöglichen. Dezentrale Netzwerke stehen vor Sicherheitsherausforderungen, die sorgfältige Smart-Contract-Audits und Bug-Bounty-Programme erfordern. Exploits, die Treasuries leeren oder Double-Payment-Angriffe ermöglichen, schädigen das Vertrauen und den Netzwerkwert.

Der Weg nach vorn & Wichtige Beobachtungspunkte

Die Verfolgung zentraler Kennzahlen und Entwicklungen liefert Einblicke in Reifegrad und Wachstumskurs tokenisierter Compute-Netzwerke.

Wachstumsindikatoren des Netzwerks umfassen die Anzahl aktiver Compute-Knoten, geografische Verteilung, Hardware-Diversität und die insgesamt verfügbare Kapazität, gemessen in Rechenleistung oder GPU-Äquivalenten. Eine Ausweitung dieser Kennzahlen signalisiert steigendes Angebot und Resilienz des Netzwerks. io.net sammelte über 300.000 verifizierte GPUs, indem mehrere Quellen integriert wurden, was das schnelle Skalierungspotenzial zeigt, wenn Protokolle disparate Ressourcen effektiv koordinieren.

Nutzungsmetriken zeigen die tatsächliche Nachfrage nach dezentralem Compute. Aktive Compute-Jobs, insgesamt gelieferte Rechenstunden und der Mix der Workload-Typen verdeutlichen, ob Netzwerke reale Anwendungen jenseits von Spekulation bedienen. Akash verzeichnete einen deutlichen Anstieg der vierteljährlich aktiven Leases, nachdem der GPU-Support ausgebaut wurde, was auf Marktinteresse an dezentralen Alternativen zu traditionellen Clouds hinweist.

Token-Marktkapitalisierung und vollständig verwässerte Bewertungen liefern Markteinschätzungen des Protokollwerts. Der Vergleich der Bewertungen mit tatsächlichen Umsätzen oder Compute-Durchsatz zeigt, ob Tokens zukünftiges Wachstum einpreisen oder die aktuelle Utility widerspiegeln. Bittensors TAO-Token erreichte während des Hypes im März 2024 einen Wert von 750 US-Dollar und illustriert damit spekulatives Interesse neben echter Adoption.

Partnerschaften mit AI-Unternehmen und Enterprise-Adoptern signalisieren Mainstream-Validierung. Wenn etablierte AI-Labs, Modellentwickler oder produktive Anwendungen Workloads auf dezentralen Netzwerken ausführen, zeigt das, dass verteilte Infrastruktur realen Anforderungen genügt. Toyota und NTT gaben eine Investition von 3,3 Milliarden US-Dollar in eine Mobility-AI-Plattform mit Edge Computing bekannt, was das Engagement von Unternehmen für verteilte Architekturen verdeutlicht.

Protokoll-Upgrades und neue Features zeigen anhaltende Entwicklungsmomentum. Die Integration neuer GPU-Typen, verbesserte Orchestrierungssysteme, erweiterte Verifikationsmechanismen oder Governance-Verbesserungen deuten auf eine aktive Weiterentwicklung zu besserer Infrastruktur hin. Bittensors Dynamic-TAO-Upgrade im Jahr 2025 verlagerte mehr Rewards auf leistungsstarke Subnets und zeigt adaptive Tokenomics.

Regulatorische Entwicklungen prägen das Betriebsumfeld. Eine vorteilhafte Einstufung von Infrastruktur-Tokens oder klare Leitlinien zu Compliance-Anforderungen würden rechtliche Unsicherheit verringern und breitere institutionelle Teilnahme ermöglichen. Umgekehrt könnten restriktive Vorschriften das Wachstum in bestimmten Jurisdiktionen begrenzen.

Wettbewerbsdynamiken zwischen Protokollen bestimmen die Marktstruktur. Der Bereich der Compute-Infrastruktur könnte sich um einige dominante Netzwerke mit starken Netzwerkeffekten konsolidieren oder fragmentiert bleiben, mit spezialisierten Protokollen für unterschiedliche Nischen. Interoperabilitätsstandards könnten eine netzwerkübergreifende Koordination ermöglichen und so die Effizienz des gesamten Ökosystems erhöhen.

Hybride Modelle, die zentrale und dezentrale Elemente kombinieren, könnten entstehen. Unternehmen könnten traditionelle Clouds für Basiskapazität nutzen und bei Spitzenlasten auf dezentrale Netzwerke ausweichen. Dieser Ansatz bietet die Vorhersehbarkeit verwalteter Services und nutzt zugleich Kostenvorteile verteilter Alternativen in Überlaufphasen.

Konsortialnetzwerke könnten entstehen, in denen Branchenakteure gemeinsam dezentrale Infrastruktur betreiben. AI-Unternehmen, Cloud-Provider, Hardware-Hersteller oder akademische Institutionen könnten gemeinsame Netzwerke aufbauen, die individuelle Kapitalanforderungen reduzieren und gleichzeitig dezentrale Governance beibehalten. Dieses Modell könnte die Adoption bei risikoscheuen Organisationen beschleunigen.

Vertikale Spezialisierung ist wahrscheinlich, da Protokolle für spezifische Anwendungsfälle optimieren. Einige Netzwerke könnten sich ausschließlich auf AI-Training konzentrieren, andere auf Inferenz, einige auf Edge Computing, wieder andere auf Rendering oder wissenschaftliches Rechnen. Spezialisierte Infrastruktur bedient bestimmte Workload-Anforderungen besser als allgemeine Alternativen.

Die Integration mit bestehenden AI-Tools und -Frameworks wird entscheidend sein. Nahtlose Kompatibilität mit gängigen Machine-Learning-Bibliotheken, Orchestrierungssystemen und Deployment-Pipelines verringert Reibung für Entwickler. io.net unterstützt Ray-native Orchestrierung und erkennt an, dass Entwickler standardisierte Workflows gegenüber protokollspezifischen Sonderlösungen bevorzugen.

Nachhaltigkeitsaspekte könnten das Protokolldesign zunehmend beeinflussen. Energieeffiziente Konsensmechanismen, Anreize für erneuerbare Energien bei Node-Betreibern oder die Integration von Emissionszertifikaten könnten Protokolle differenzieren, die umweltbewusste Nutzer ansprechen. Da der Energieverbrauch von AI zunehmend kritisch betrachtet wird, könnten dezentrale Netzwerke Effizienz als Wettbewerbsvorteil positionieren.

Medienberichterstattungund die Aufmerksamkeit der Krypto-Community dienen als Frühindikatoren für ein breiteres Mainstream-Bewusstsein. Eine verstärkte Diskussion über bestimmte Protokolle, steigendes Suchinteresse oder wachsende Social-Media-Followerzahlen gehen häufig einer breiteren Adoption und einem Anstieg der Tokenpreise voraus. Allerdings können Hype-Zyklen irreführende Signale erzeugen, die von fundamentalem Wachstum abgekoppelt sind.

Schlussfolgerung

Physical Infrastructure Finance stellt die Weiterentwicklung von Krypto hin zur Koordination realer, physischer Rechenressourcen dar. Durch die Tokenisierung von Rechenkapazität schaffen PinFi-Protokolle Märkte, in denen ungenutzte GPUs zu produktiven Vermögenswerten werden, die Rendite durch KI-Workloads, Edge-Processing und spezialisierte Infrastrukturbedarfe generieren.

Die Konvergenz zwischen der unstillbaren Nachfrage der KI nach Rechenleistung und der Fähigkeit von Krypto, verteilte Systeme über ökonomische Anreize zu koordinieren, schafft ein überzeugendes Wertversprechen. GPU shortages affecting over 50% of generative AI companies demonstrieren die Schwere der Infrastrukturbeschränkungen. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 signalisieren das Marktverständnis, dass verteilte Modelle ungenutztes Angebot erschließen können.

Protokolle wie Bittensor, Render, Akash und io.net demonstrieren unterschiedliche Ansätze für dieselbe grundlegende Herausforderung: das effiziente Matching von Angebot und Nachfrage nach Rechenleistung durch erlaubnisfreie, blockchain-basierte Koordination. Jedes Netzwerk experimentiert mit verschiedenen Tokenomics, Verifizierungsmechanismen und Zielanwendungen und trägt so zu einem breiteren Ökosystem bei, das den Designraum für dezentrale Infrastruktur erforscht.

Die Implikationen reichen über Krypto hinaus in die KI-Industrie und die Recheninfrastruktur im weiteren Sinne. Demokratisierter Zugang zu GPU-Ressourcen senkt die Eintrittsbarrieren für KI-Innovation. Eine geringere Abhängigkeit von zentralisierten Cloud-Oligopolen führt zu Wettbewerbsdynamiken, die Preise und Zugänglichkeit verbessern können. Neue Anlageklassen entstehen, da Tokens Eigentum an produktiver Infrastruktur statt reiner Spekulation repräsentieren.

Erhebliche Herausforderungen bleiben bestehen. Technische Zuverlässigkeit, Verifizierungsmechanismen, ökonomische Nachhaltigkeit, regulatorische Unsicherheit und Konkurrenz durch gut kapitalisierte etablierte Unternehmen stellen allesamt Risiken dar. Nicht jedes Protokoll wird überleben, und viele Tokens könnten sich im Verhältnis zu ihrem grundlegenden Nutzen als überbewertet erweisen. Doch die Kernthese, die PinFi antreibt, wirkt stichhaltig: Weltweit liegt enorme Rechenkapazität ungenutzt brach, es besteht eine massive Nachfrage nach KI-Infrastruktur, und blockchain-basierte Koordination kann diese fehlangepassten Angebots- und Nachfragekurven zusammenführen.

Während die KI-Nachfrage weiter explodiert, wird die Infrastrukturebene, die diese Technologie unterstützt, zunehmend kritisch. Ob diese Infrastruktur bei einigen wenigen zentralisierten Anbietern konzentriert bleibt oder sich hin zu verteilten Eigentumsmodellen entwickelt, die durch kryptowirtschaftliche Anreize koordiniert werden, könnte die Wettbewerbslandschaft der KI-Entwicklung für das nächste Jahrzehnt definieren.

Die Infrastrukturfinanzierung der Zukunft könnte weniger wie traditionelle Projektfinanzierung aussehen und mehr wie tokenisierte Netzwerke global verteilter Hardware, in denen jeder mit einer GPU zum Infrastrukturanbieter werden kann und in denen der Zugang keine andere Erlaubnis erfordert als eine Zahlung zum Marktpreis. Dies stellt ein grundlegendes Neu-Denken darüber dar, wie Rechenressourcen besessen, betrieben und monetarisiert werden – eines, in dem Krypto-Protokolle einen Nutzen jenseits finanzieller Spekulation demonstrieren, indem sie greifbare Probleme in der physischen Welt lösen.