La industria de la inteligencia artificial se enfrenta a un cuello de botella crítico de infraestructura. Entrenar grandes modelos de lenguaje requiere recursos computacionales masivos, los dispositivos perimetrales se multiplican a ritmos exponenciales y la escasez de GPU se ha convertido en la restricción definitoria de la era de la IA. Mientras tanto, los proveedores tradicionales de nube luchan por satisfacer la creciente demanda y, al mismo tiempo, mantener su control monopolístico sobre el acceso y los precios.

Over 50% of generative AI companies report GPU shortages como un gran obstáculo para escalar sus operaciones. AI computing power is expected to increase by roughly 60 times by the end of 2025 en comparación con el primer trimestre de 2023. Esta carrera armamentista computacional ha creado una oportunidad para que los protocolos cripto propongan una alternativa descentralizada.

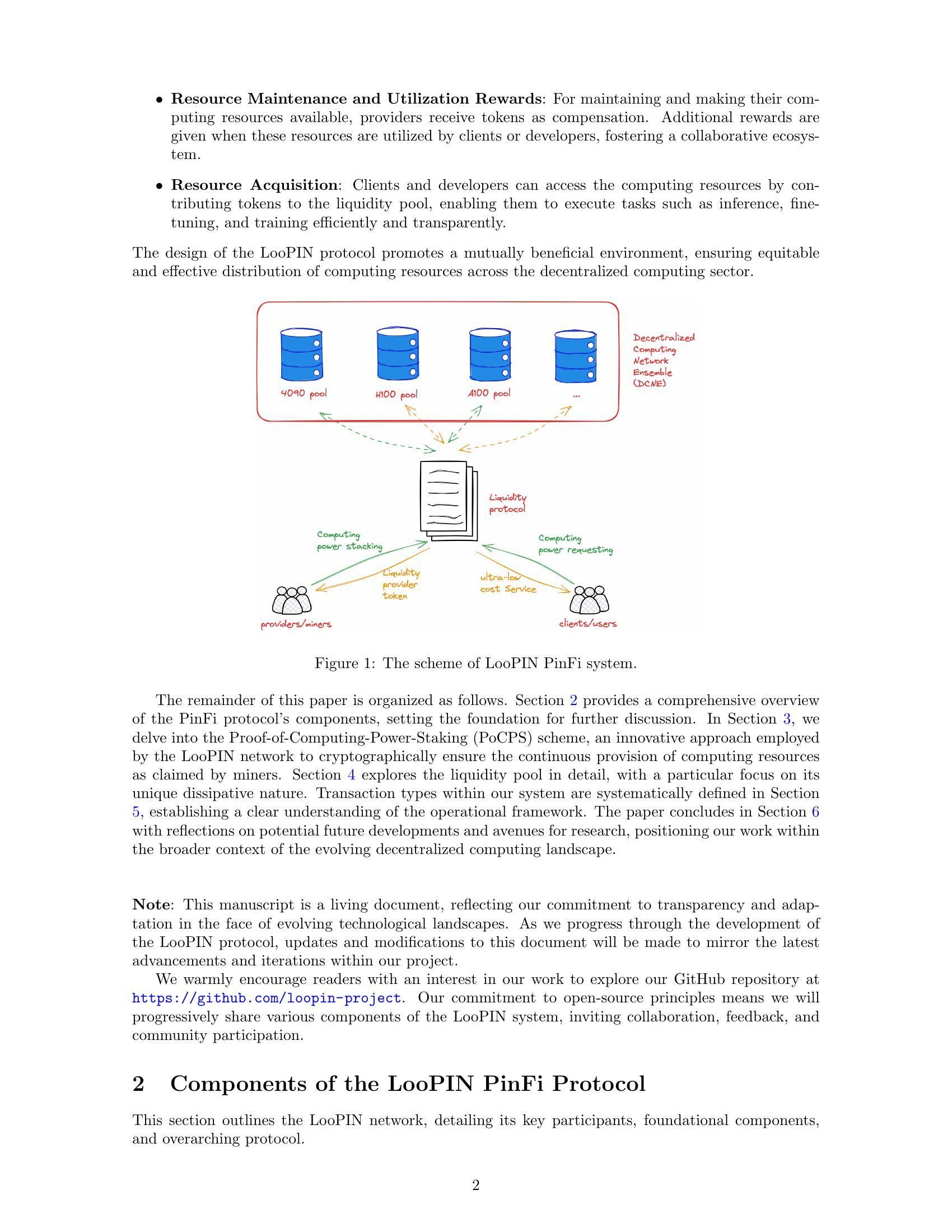

Entra en escena Physical Infrastructure Finance, o PinFi. Este marco emergente trata la capacidad de cómputo como un activo tokenizado que puede ser intercambiado, apostado y monetizado a través de redes basadas en blockchain. En lugar de depender de centros de datos centralizados, los protocolos PinFi agregan la potencia de GPU no utilizada de operadores independientes, equipos de gaming, granjas de minería y dispositivos perimetrales en mercados distribuidos accesibles para desarrolladores de IA de todo el mundo.

A continuación exploramos cómo la potencia de cómputo real se está transformando en infraestructura criptoeconómica, entendiendo la mecánica de las redes de cómputo tokenizado, los modelos económicos que incentivan la participación, la arquitectura que permite la verificación y la liquidación, y las implicaciones tanto para la industria cripto como para la de IA.

¿Por qué PinFi ahora? Impulsores macro y técnicos

El cuello de botella de cómputo que enfrenta la industria de la IA proviene de restricciones fundamentales de oferta. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, dejando a muchos usuarios luchando por conseguir acceso. The global AI chip market reached $123.16 billion in 2024 y se proyecta que alcance los 311,58 mil millones de dólares para 2029, reflejando una demanda explosiva que supera ampliamente la capacidad de fabricación.

La escasez de GPU se manifiesta de múltiples maneras. Los proveedores de nube tradicionales mantienen listas de espera para las instancias GPU premium. AWS charges $98.32 per hour for an 8-GPU H100 instance, una estructura de precios que deja las capacidades avanzadas de IA fuera del alcance de muchos desarrolladores y startups. Los precios del hardware se mantienen elevados debido a las restricciones de oferta, con HBM3 pricing rising 20-30% year-over-year.

La concentración de potencia de cómputo en manos de unos pocos grandes proveedores de nube crea fricciones adicionales. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, pero el acceso continúa estando limitado por contratos, restricciones geográficas y requisitos de conocimiento del cliente (KYC). Esta centralización limita la innovación y crea puntos únicos de fallo para infraestructura crítica.

Mientras tanto, grandes cantidades de capacidad de cómputo permanecen ociosas. Los equipos de gaming no se usan durante las horas de trabajo. Los mineros de criptomonedas buscan nuevas fuentes de ingresos a medida que cambian las condiciones económicas de la minería. Los centros de datos mantienen capacidad excedente durante los períodos de baja demanda. The decentralized compute market has grown from $9 billion in 2024 con proyecciones que alcanzan los 100 mil millones de dólares para 2032, lo que señala el reconocimiento del mercado de que los modelos distribuidos pueden capturar esta oferta latente.

La intersección de la tecnología blockchain y la infraestructura física ha madurado a través de las redes de infraestructura física descentralizada, o DePIN. Los protocolos DePIN utilizan incentivos basados en tokens para coordinar el despliegue y la operación de infraestructura del mundo real. Messari identified DePIN's total addressable market at $2.2 trillion, con un potencial de llegar a 3,5 billones de dólares para 2028.

PinFi representa la aplicación de los principios DePIN específicamente a la infraestructura de cómputo. Trata los recursos computacionales como activos tokenizables que generan rendimiento mediante su uso productivo. Este marco transforma el cómputo de un servicio alquilado a proveedores centralizados en una mercancía que se negocia en mercados abiertos y sin permisos.

¿Qué es PinFi y el cómputo tokenizado?

Physical Infrastructure Finance define un modelo en el que los activos computacionales físicos se representan como tokens digitales en blockchains, lo que permite la propiedad, operación y monetización descentralizadas. A diferencia de los protocolos tradicionales de finanzas descentralizadas que tratan únicamente con activos digitales, PinFi crea puentes entre recursos físicos fuera de la cadena y sistemas económicos en cadena.

Academic research defines tokenization como "el proceso de convertir derechos, una unidad de propiedad de un activo, deuda o incluso un activo físico en un token digital en una blockchain". Para los recursos de cómputo, esto significa que GPUs individuales, clústeres de servidores o dispositivos perimetrales pasan a estar representados por tokens que rastrean su capacidad, disponibilidad y uso.

PinFi difiere fundamentalmente de la financiación de infraestructura estándar o de los protocolos DeFi típicos. La financiación de infraestructura tradicional implica inversiones de deuda o capital a largo plazo en grandes proyectos de capital. Los protocolos DeFi se centran principalmente en facilitar el trading, el préstamo o la generación de rendimiento sobre activos cripto nativos. PinFi se sitúa en la intersección, aplicando incentivos criptoeconómicos para coordinar recursos computacionales del mundo real, manteniendo al mismo tiempo la liquidación y la gobernanza en cadena.

Varios protocolos ejemplifican el modelo PinFi. Bittensor operates as a decentralized AI network donde los participantes contribuyen modelos de aprendizaje automático y recursos computacionales a subredes especializadas centradas en tareas específicas. El token TAO incentiva las contribuciones en función del valor informacional que aportan a la inteligencia colectiva de la red. With over 7,000 miners que aportan cómputo, Bittensor crea mercados para inferencia de IA y entrenamiento de modelos.

Render Network aggregates idle GPUs globally para tareas distribuidas de renderizado con GPU. Originalmente centrado en el renderizado 3D para artistas y creadores de contenido, Render se ha expandido a cargas de trabajo de cómputo de IA. Su token RNDR sirve como medio de pago por los trabajos de renderizado y como recompensa para los proveedores de GPUs por la capacidad aportada.

Akash Network operates as a decentralized cloud marketplace que utiliza capacidad no utilizada de centros de datos. A través de un sistema de subasta inversa, los desplegadores de cómputo especifican sus requisitos y los proveedores pujan para satisfacer las solicitudes. El token AKT facilita la gobernanza, el staking y las liquidaciones en toda la red. Akash witnessed notable surge in quarterly active leases después de ampliar su enfoque para incluir GPUs junto con recursos tradicionales de CPU.

io.net has aggregated over 300,000 verified GPUs integrando recursos de centros de datos independientes, mineros de criptomonedas y otras redes DePIN, incluidas Render y Filecoin. La plataforma se centra específicamente en cargas de trabajo de IA y aprendizaje automático, ofreciendo a los desarrolladores la capacidad de desplegar clústeres de GPU en 130 países en cuestión de minutos.

La mecánica del cómputo tokenizado sigue un patrón coherente en estos protocolos. Los proveedores de cómputo registran su hardware en la red y se someten a procesos de verificación para confirmar su capacidad y características. Los contratos inteligentes gestionan la relación entre la oferta y la demanda, asignando trabajos de cómputo a los nodos disponibles según requisitos, precios y restricciones geográficas. Las recompensas en tokens incentivan tanto la provisión de hardware como la prestación de servicios de calidad.

La generación de valor se produce a través del uso real más que por la especulación. Cuando un desarrollador de IA entrena un modelo utilizando recursos GPU distribuidos, el pago fluye hacia los proveedores cuyo hardware realizó el trabajo. La potencia de cómputo se convierte en un activo productivo que genera rendimiento, de forma similar a cómo los validadores de prueba de participación ganan recompensas por asegurar redes. Esto crea una economía sostenible en la que el valor del token se correlaciona con la utilidad de la red.

Arquitectura de infraestructura: nodos, mercados, liquidación

La arquitectura que habilita el cómputo tokenizado requiere coordinación en múltiples capas. En su base se encuentra una red de proveedores de cómputo independientes que despliegan hardware, se registran en los protocolos y ponen su capacidad disponible para alquiler. Estos proveedores van desde particulares con PCs de gaming hasta operadores profesionales de centros de datos y operaciones de minería de criptomonedas que buscan fuentes adicionales de ingresos.

El aprovisionamiento de nodos comienza cuando un proveedor de cómputo conecta su hardware a la red. Protocols like io.net support diverse GPU types, desde tarjetas de consumo NVIDIA RTX 4090 hasta GPUs empresariales H100 y A100. El proveedor instala un software cliente que expone la capacidad a la capa de orquestación de la red, manteniendo al mismo tiempo límites de seguridad que impiden accesos no autorizados.

Los mecanismos de verificación garantizan que la capacidad anunciada coincida con las capacidades reales. Algunos protocolos emplean pruebas criptográficas de cómputo, donde los nodos deben demostrar que realizaron cálculos específicos correctamente. Bittensor utiliza su mecanismo de Consenso Yuma, donde los validadores evalúan la calidad de las salidas de aprendizaje automático de los mineros y asignan puntuaciones que determinan la distribución de recompensas. Los nodos que ofrecen resultados de baja calidad o intentan hacer trampa reciben una compensación reducida o se enfrentan al recorte (slashing) de los tokens en stake.

La evaluación comparativa de latencia ayuda a asignar las cargas de trabajo al hardware apropiado. La inferencia de IA requiere características de rendimiento diferentes a las del entrenamiento de modelos o el renderizado 3D. La ubicación geográfica afecta la latencia para las aplicaciones de computación en el borde, donde el procesamiento debe ocurrir cerca de las fuentes de datos. El mercado de edge computing alcanzó los 23,65 mil millones de dólares en 2024 y se espera que llegue a 327,79 mil millones de dólares para 2033, impulsado por la demanda de procesamiento localizado.

La capa de mercado conecta la demanda de cómputo con la oferta. Cuando los desarrolladores necesitan recursos de GPU, especifican requisitos que incluyen potencia de procesamiento, memoria, duración y precio máximo. Akash emplea un modelo de subasta inversa en el que los desplegadores fijan las condiciones y los proveedores pujan para ganar contratos. Render utiliza algoritmos de precios dinámicos que ajustan las tarifas según la utilización de la red y las condiciones del mercado.

Los algoritmos de enrutamiento de trabajos optimizan la asignación de tareas de cómputo entre los nodos disponibles. Entre los factores considerados se incluyen las especificaciones de hardware, la utilización actual, la proximidad geográfica, el rendimiento histórico y el precio. La capa de orquestación de io.net maneja flujos de trabajo contenerizados y admite orquestación nativa de Ray para cargas de trabajo de aprendizaje automático distribuido.

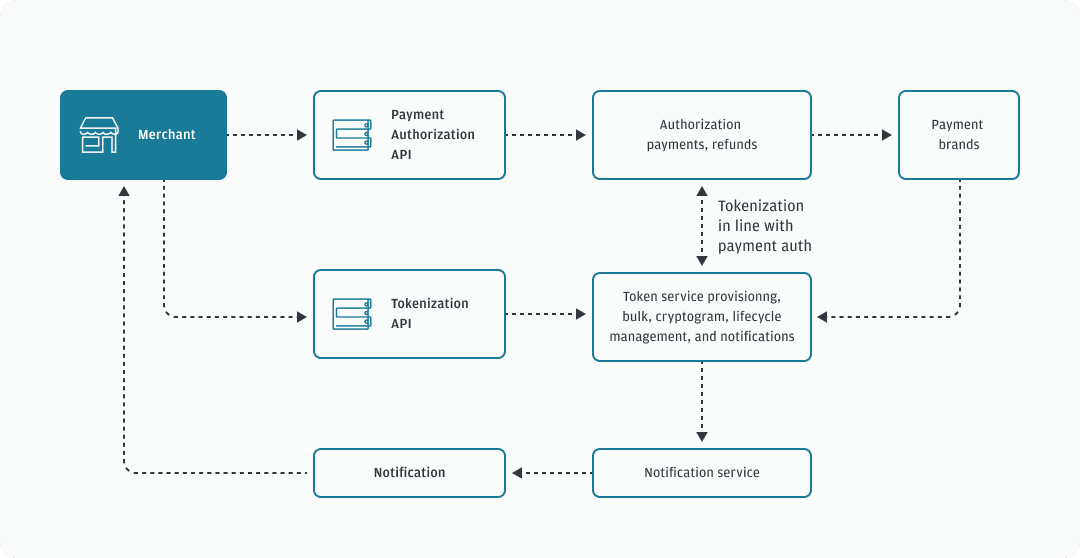

La liquidación se produce on-chain mediante contratos inteligentes que depositan los pagos en custodia y liberan los fondos tras la verificación de la finalización del trabajo. Esta liquidación sin confianza elimina el riesgo de contraparte y permite microtransacciones para trabajos de cómputo de corta duración. Los protocolos construidos sobre blockchains de alto rendimiento como Solana pueden manejar el volumen de transacciones generado por miles de solicitudes de inferencia simultáneas.

Los mecanismos de staking alinean los incentivos entre los participantes. Los proveedores de cómputo suelen hacer stake de tokens para demostrar compromiso y exponer un colateral que puede ser recortado por mal rendimiento. Los validadores en Bittensor hacen stake de tokens TAO para ganar influencia en la calificación de los mineros y obtener una parte de las recompensas de bloque. Los tenedores de tokens pueden delegar su stake a validadores en los que confían, de forma similar a los mecanismos de consenso de prueba de participación.

La gobernanza permite a los tenedores de tokens votar sobre parámetros del protocolo, incluida la distribución de recompensas, las estructuras de tarifas y las actualizaciones de la red. La gobernanza descentralizada garantiza que ninguna autoridad central pueda cambiar unilateralmente las reglas o restringir el acceso, manteniendo la naturaleza sin permisos que diferencia a estas redes de los proveedores de nube tradicionales.

La arquitectura contrasta fuertemente con la computación en la nube centralizada. Los grandes proveedores son dueños de su infraestructura, fijan precios sin competencia de mercado, exigen cuentas y controles de cumplimiento y mantienen el control sobre el acceso y la censura. Los protocolos PinFi distribuyen la propiedad entre miles de operadores independientes, permiten una fijación de precios transparente basada en el mercado, operan sin permisos y resisten la censura mediante la descentralización.

Tokenomics y modelos de incentivos

La economía de tokens proporciona la estructura de incentivos que coordina las redes de cómputo distribuidas. Los tokens nativos cumplen múltiples funciones, incluida la de medio de pago por los servicios, recompensas por la provisión de recursos, derechos de gobernanza y requisitos de staking para la participación en la red.

Los mecanismos de emisión determinan cómo entran los tokens en circulación. Bittensor sigue el modelo de Bitcoin con un suministro máximo de 21 millones de tokens TAO y reducciones periódicas a la mitad que disminuyen la emisión con el tiempo. Actualmente se acuñan 7.200 TAO al día, divididos entre los mineros que aportan recursos computacionales y los validadores que garantizan la calidad de la red. Esto crea una escasez similar a la de Bitcoin, a la vez que dirige la inflación hacia infraestructura productiva.

Otros protocolos emiten tokens en función del uso de la red. Cuando se ejecutan trabajos de cómputo, los tokens recién acuñados fluyen hacia los proveedores en proporción a los recursos que suministraron. Este vínculo directo entre creación de valor y emisión de tokens garantiza que la inflación recompense la productividad real en lugar de la mera tenencia pasiva.

El staking crea skin in the game para los participantes de la red. Los proveedores de cómputo hacen stake de tokens para registrar nodos y demostrar compromiso. El mal rendimiento o los intentos de fraude dan lugar al slashing, mediante el cual los tokens en stake se destruyen o se redistribuyen a las partes afectadas. Esta penalización económica incentiva la prestación de servicios fiables y el comportamiento honesto.

Los validadores hacen stake de cantidades mayores para ganar influencia en la evaluación de calidad y en las decisiones de gobernanza. En el modelo de Bittensor, los validadores evalúan las salidas de los mineros y envían matrices de pesos que indican qué nodos realizaron contribuciones valiosas. El Consenso Yuma agrega estas evaluaciones ponderadas por el stake del validador para determinar la distribución final de recompensas.

La dinámica de oferta y demanda de los tokens de cómputo opera en dos niveles. Del lado de la oferta, la incorporación de más nodos a la red incrementa la capacidad computacional disponible. Las recompensas en tokens deben ser suficientes para compensar los costes de hardware, electricidad y coste de oportunidad frente a usos alternativos del equipo. A medida que sube el precio del token, la provisión de cómputo se vuelve más rentable, atrayendo oferta adicional.

Del lado de la demanda, el precio del token refleja el valor que los usuarios asignan al acceso a la red. A medida que proliferan las aplicaciones de IA y se intensifica la escasez de cómputo, aumenta la disposición a pagar por recursos descentralizados. Se espera que el mercado de hardware de IA crezca de 66.800 millones de dólares en 2025 a 296.300 millones en 2034, creando una demanda sostenida de fuentes alternativas de cómputo.

La apreciación del valor del token beneficia a todos los participantes. Los proveedores de hardware ganan más por la misma cantidad de salida computacional. Los operadores de nodos tempranos se benefician de la apreciación de las recompensas acumuladas. Los desarrolladores se benefician de una alternativa descentralizada a los proveedores centralizados y costosos. Los tenedores de tokens que hacen stake o proporcionan liquidez capturan comisiones derivadas de la actividad de la red.

Los modelos de riesgo abordan posibles modos de fallo. El tiempo de inactividad de los nodos reduce las ganancias, ya que los trabajos se enrutan hacia alternativas disponibles. La concentración geográfica crea problemas de latencia para las aplicaciones en el borde que requieren procesamiento local. Los efectos de red favorecen a los protocolos más grandes con hardware y distribución geográfica más diversos.

La inflación del token debe equilibrar la atracción de nueva oferta con el mantenimiento del valor para los tenedores existentes. La investigación sobre protocolos de infraestructura descentralizada señala que una tokenómica sostenible requiere que el crecimiento de la demanda supere el aumento de la oferta. Los protocolos implementan mecanismos de quema, en los que los tokens utilizados para pagos se eliminan permanentemente de la circulación, creando una presión deflacionaria que compensa la emisión inflacionaria.

Las estructuras de tarifas varían entre redes. Algunas cobran a los usuarios directamente en tokens nativos. Otras aceptan stablecoins o versiones envueltas de las principales criptomonedas, mientras que los tokens del protocolo cumplen principalmente funciones de gobernanza y staking. Los modelos híbridos utilizan tokens para el acceso a la red, mientras que liquidan los pagos de cómputo en activos estables para reducir el riesgo de volatilidad.

El espacio de diseño de los modelos de incentivos sigue evolucionando, a medida que los protocolos experimentan con diferentes enfoques para equilibrar los intereses de las partes interesadas y sostener el crecimiento a largo plazo.

IA, edge y la infraestructura del mundo real

Las redes de cómputo tokenizado habilitan aplicaciones que aprovechan hardware distribuido para cargas de trabajo de IA, procesamiento en el borde y necesidades de infraestructura especializada. La diversidad de casos de uso demuestra cómo los modelos descentralizados pueden abordar cuellos de botella en todo el stack computacional.

El entrenamiento distribuido de modelos de IA representa un caso de uso principal. Entrenar grandes modelos de lenguaje o sistemas de visión por computadora requiere una computación masivamente paralela a través de múltiples GPU. Los enfoques tradicionales concentran este entrenamiento en centros de datos centralizados propiedad de grandes proveedores de nube. Las redes descentralizadas permiten que el entrenamiento ocurra a través de nodos distribuidos geográficamente, cada uno contribuyendo trabajo computacional coordinado mediante orquestación basada en blockchain.

La arquitectura de subredes de Bittensor habilita mercados de IA especializados centrados en tareas concretas como generación de texto, síntesis de imágenes o extracción de datos. Los mineros compiten por ofrecer salidas de alta calidad para los dominios que eligen, mientras que los validadores evalúan el rendimiento y distribuyen las recompensas en consecuencia. Esto crea mercados competitivos donde los mejores modelos y las implementaciones más eficientes emergen de forma natural mediante selección económica.

Las cargas de trabajo de edge computing se benefician particularmente de la infraestructura descentralizada. El mercado global de edge computing se valoró en 23,65 mil millones de dólares en 2024, impulsado por aplicaciones que requieren low latency and local processing. Los dispositivos de IoT que generan datos de sensores de forma continua necesitan análisis inmediato sin los retrasos de ida y vuelta hacia centros de datos lejanos. Los vehículos autónomos requieren toma de decisiones en fracciones de segundo que no puede tolerar la latencia de red.

Las redes de cómputo descentralizado pueden situar la capacidad de procesamiento físicamente cerca de las fuentes de datos. Una fábrica que despliega sensores de IoT industrial puede alquilar nodos perimetrales dentro de la misma ciudad o región en lugar de depender de nubes centralizadas a cientos de millas de distancia. Industrial IoT applications accounted for the largest market share in edge computing in 2024, lo que refleja la naturaleza crítica del procesamiento localizado para la manufactura y la logística.

La renderización de contenido y los flujos de trabajo creativos consumen recursos significativos de GPU. Artistas que renderizan escenas 3D, animadores que producen películas y desarrolladores de videojuegos que compilan recursos requieren procesamiento paralelo intensivo. Render Network specializes in distributed GPU rendering, conectando a creadores con capacidad de GPU ociosa en todo el mundo. Este modelo de mercado reduce los costos de renderizado al tiempo que proporciona flujos de ingresos para los propietarios de GPU durante los períodos de baja demanda.

Las aplicaciones de computación científica e investigación se enfrentan a limitaciones presupuestarias al acceder a recursos en la nube costosos. Las instituciones académicas, investigadores independientes y organizaciones más pequeñas pueden aprovechar redes descentralizadas para ejecutar simulaciones, analizar conjuntos de datos o entrenar modelos especializados. La naturaleza sin permisos implica que investigadores en cualquier geografía puedan acceder a recursos computacionales sin cuentas institucionales en la nube ni verificaciones de crédito.

Las plataformas de videojuegos y metaverso requieren cálculos de renderizado y física para experiencias inmersivas. A medida que los mundos virtuales crecen en complejidad, aumentan las demandas computacionales para mantener entornos persistentes y soportar a miles de usuarios simultáneos. Los nodos de cómputo distribuidos en el borde pueden proporcionar procesamiento local para poblaciones regionales de jugadores, reduciendo la latencia mientras distribuyen los costos de infraestructura entre proveedores incentivados por tokens.

La inferencia de IA a escala requiere acceso continuo a GPU para servir predicciones de modelos entrenados. Un chatbot que atiende millones de consultas, un servicio de generación de imágenes que procesa solicitudes de usuarios o un motor de recomendaciones que analiza el comportamiento del usuario necesitan cómputo siempre disponible. Las redes descentralizadas proporcionan redundancia y distribución geográfica que mejora la fiabilidad en comparación con la dependencia de un solo proveedor.

Las zonas geográficas desatendidas por los principales proveedores de nube presentan oportunidades para los protocolos PinFi. Las regiones con presencia limitada de centros de datos enfrentan mayor latencia y costos al acceder a infraestructura centralizada. Los proveedores de hardware locales en estas áreas pueden ofrecer capacidad de cómputo adaptada a la demanda regional, ganando recompensas en tokens mientras mejoran el acceso local a capacidades de IA.

Los requisitos de soberanía de datos exigen cada vez más que ciertas cargas de trabajo procesen datos dentro de jurisdicciones específicas. Regulations like the EU Data Act require sensitive information to be processed locally, lo que fomenta el despliegue de infraestructura perimetral que cumpla con las normas de residencia. Las redes descentralizadas admiten de forma natural el despliegue de nodos específicos por jurisdicción, manteniendo al mismo tiempo la coordinación global a través de la liquidación basada en blockchain.

Why It Matters: Implications for Crypto & Infrastructure

La aparición de PinFi representa la expansión de las criptomonedas más allá de las aplicaciones puramente financieras hacia la coordinación de infraestructura del mundo real. Este cambio conlleva implicaciones tanto para el ecosistema cripto como para las industrias computacionales en general.

Los protocolos cripto demuestran utilidad más allá de la especulación cuando resuelven problemas de infraestructura tangibles. DePIN y PinFi crean sistemas económicos que coordinan recursos físicos, demostrando que los incentivos basados en blockchain pueden poner en marcha redes del mundo real. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, lo que representa aproximadamente tres veces la capitalización total actual del mercado cripto.

La democratización del acceso al cómputo aborda una asimetría fundamental en el desarrollo de la IA. Actualmente, las capacidades avanzadas de IA permanecen en gran medida concentradas entre compañías tecnológicas bien financiadas que pueden costear enormes clústeres de GPU. Startups, investigadores y desarrolladores en entornos con recursos limitados enfrentan barreras para participar en la innovación en IA. Las redes de cómputo descentralizado reducen estas barreras al proporcionar acceso sin permisos a hardware distribuido a precios determinados por el mercado.

La creación de nuevas clases de activos amplía el panorama de inversión cripto. Los tokens de capacidad de cómputo representan propiedad en infraestructura productiva que genera ingresos mediante el uso en el mundo real. Esto difiere de los activos puramente especulativos o los tokens de gobernanza sin mecanismos claros de captura de valor. Los poseedores de tokens esencialmente poseen participaciones en un proveedor de nube descentralizada, con un valor ligado a la demanda de servicios computacionales.

Los monopolios tradicionales de infraestructura enfrentan una posible disrupción. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control sobre los mercados de cómputo, fijando precios sin competencia directa. Las alternativas descentralizadas introducen dinámicas de mercado en las que miles de proveedores independientes compiten, lo que potencialmente reduce los costos mientras mejora la accesibilidad.

La industria de la IA se beneficia de una menor dependencia de la infraestructura centralizada. Actualmente, el desarrollo de IA se agrupa en torno a los principales proveedores de nube, creando puntos únicos de fallo y riesgos de concentración. Over 50% of generative AI companies report GPU shortages as major obstacles. Las redes distribuidas proporcionan capacidad alternativa que puede absorber el exceso de demanda y ofrecer redundancia frente a disrupciones en la cadena de suministro.

Pueden surgir mejoras en eficiencia energética a partir de una mejor utilización de la capacidad. Rigs de juego inactivos consumen energía en modo de espera sin producir resultados. Operaciones de minería con capacidad excedente buscan flujos de ingresos adicionales. Distributed networks put idle GPUs to productive use, mejorando la eficiencia general de recursos en el ecosistema computacional.

La resistencia a la censura se vuelve relevante para las aplicaciones de IA. Los proveedores de nube centralizada pueden negar servicio a usuarios, aplicaciones o regiones geográficas específicas. Las redes descentralizadas operan sin permisos, permitiendo el desarrollo y despliegue de IA sin requerir la aprobación de guardianes. Esto importa particularmente para aplicaciones controvertidas o usuarios en jurisdicciones restrictivas.

Las arquitecturas de privacidad de datos mejoran mediante el procesamiento local. Edge computing keeps sensitive data near its source en lugar de transmitirla a centros de datos lejanos. Las redes descentralizadas pueden implementar técnicas de preservación de la privacidad como el aprendizaje federado, donde los modelos se entrenan sobre datos distribuidos sin centralizar la información en bruto.

La eficiencia del mercado aumenta gracias al descubrimiento transparente de precios. La tarificación tradicional en la nube sigue siendo opaca, con estructuras de tarifas complejas y contratos empresariales negociados. Los mercados descentralizados establecen precios spot claros para recursos de cómputo, permitiendo a los desarrolladores optimizar costos y a los proveedores maximizar ingresos mediante dinámicas competitivas.

La relevancia a largo plazo proviene de impulsores de demanda sostenidos. Las cargas de trabajo de IA seguirán creciendo a medida que se multipliquen las aplicaciones. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. El cómputo seguirá siendo una restricción fundamental, garantizando una demanda continua de modelos de infraestructura alternativos.

Los efectos de red favorecen a los primeros protocolos que alcancen masa crítica. A medida que más proveedores de hardware se unen, aumenta la diversidad de recursos disponibles. La distribución geográfica mejora, reduciendo la latencia para aplicaciones en el borde. Las redes más grandes atraen a más desarrolladores, creando ciclos virtuosos de crecimiento. Los primeros en moverse en dominios específicos pueden establecer ventajas duraderas.

Challenges & Risks

A pesar de las aplicaciones prometedoras, las redes de cómputo tokenizado enfrentan desafíos técnicos, económicos y regulatorios significativos que podrían limitar el crecimiento o la adopción.

La fiabilidad técnica sigue siendo una preocupación principal. Los proveedores de nube centralizada ofrecen acuerdos de nivel de servicio que garantizan tiempo de actividad y rendimiento. Las redes distribuidas coordinan hardware de operadores independientes con niveles variables de profesionalismo y calidad de infraestructura. Fallos de nodos, cortes de red o ventanas de mantenimiento crean brechas de disponibilidad que deben gestionarse mediante redundancia y algoritmos de enrutamiento.

La verificación del trabajo realmente realizado presenta desafíos continuos. Garantizar que los nodos ejecuten honestamente las computaciones en lugar de devolver resultados falsos requiere sistemas de prueba sofisticados. Cryptographic proofs of compute añaden sobrecarga pero siguen siendo necesarias para prevenir el fraude. Mecanismos de verificación imperfectos permiten posibles ataques en los que nodos maliciosos reclaman recompensas sin proporcionar los servicios prometidos.

Las limitaciones de latencia y ancho de banda afectan a las cargas de trabajo distribuidas. Running computations across geographically dispersed locations can cause delays en comparación con el hardware coubicado en centros de datos únicos. El ancho de banda de red entre nodos limita los tipos de cargas de trabajo adecuadas para el procesamiento distribuido. Los cálculos paralelos estrechamente acoplados que requieren comunicación frecuente entre nodos sufren degradación del rendimiento.

La variabilidad en la calidad del servicio crea incertidumbre para las aplicaciones en producción. A diferencia de los entornos de nube gestionada con rendimiento predecible, los pools de hardware heterogéneos producen resultados inconsistentes. Una corrida de entrenamiento puede ejecutarse en H100 de nivel empresarial o en tarjetas RTX de consumo, según la disponibilidad. Los desarrolladores de aplicaciones deben diseñar teniendo en cuenta esta variabilidad o implementar filtros que restrinjan los trabajos a niveles de hardware específicos.

La sostenibilidad económica requiere equilibrar el crecimiento de la oferta con la expansión de la demanda. Aumentos rápidos en la capacidad de cómputo disponible sin un crecimiento de demanda correspondiente deprimirían los precios de los tokens y reducirían la rentabilidad de los proveedores. Los protocolos deben gestionar cuidadosamente la emisión de tokens para evitar una inflación que supere el crecimiento de la utilidad. Sustainable tokenomics requires demand growth to outpace supply increases.

La compresión del valor del token plantea riesgos para los participantes a largo plazo. A medida que nuevos proveedores se unen a las redes en busca de recompensas, el aumento de la competencia reduce las ganancias por nodo. Los primeros participantes que se benefician de mayores recompensas iniciales pueden ver cómo sus retornos disminuyen con el tiempo. Si la apreciación del token no compensa esta dilución, aumenta la rotación de proveedores y se resiente la estabilidad de la red.

La volatilidad del mercado introduce riesgo financiero para los participantes. Los proveedores ganan recompensas en tokens nativos cuyo valor fluctúa. Un operador de hardware puede comprometer capital para la compra de GPU esperando que los precios de los tokens se mantengan estables, solo para enfrentar pérdidas si los precios disminuyen. Los mecanismos de cobertura y las opciones de pago en stablecoins pueden mitigar la volatilidad, pero añaden complejidad.

La incertidumbre regulatoria en torno a la clasificación de los tokens crea desafíos de cumplimiento. Los reguladores de valores en varias jurisdicciones evalúan si los tokens de cómputo constituyen valores sujetos a requisitos de registro. Un estatus legal ambiguo restringe la participación institucional y crea riesgos de responsabilidad para los desarrolladores de protocolos. Infrastructure tokenization faces regulation uncertainties que han limitado la adopción en comparación con las estructuras de finanzas tradicionales.

Las regulaciones de protección de datos imponen requisitos que las redes distribuidas deben navegar. El procesamiento de datos de ciudadanos europeos exige el cumplimiento del RGPD, incluyendo la minimización de datos y los derechos de eliminación. Las aplicaciones sanitarias deben satisfacer los requisitos de la HIPAA. Las aplicaciones financieras enfrentan obligaciones de lucha contra el blanqueo de capitales. Las redes descentralizadas complican el cumplimiento cuando los datos se mueven a través de múltiples jurisdicciones y operadores independientes.

Las contribuciones de hardware pueden desencadenar un mayor escrutinio regulatorio dependiendo de cómo se estructuren los acuerdos. Algunas jurisdicciones podrían clasificar determinadas relaciones con proveedores como ofertas de valores o productos financieros regulados. La línea entre la provisión de infraestructura y los contratos de inversión sigue siendo poco clara en muchos marcos legales.

La competencia de los proveedores de nube hiperescalados continúa intensificándose. Los grandes proveedores invierten miles de millones en nueva capacidad de centros de datos y aceleradores de IA personalizados. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, en gran medida para infraestructura de IA. Estos incumbentes bien capitalizados pueden reducir precios o agrupar cómputo con otros servicios para mantener su cuota de mercado.

La fragmentación de la red podría limitar la composabilidad. Múltiples protocolos competidores crean ecosistemas en silos donde los recursos de cómputo no pueden transferirse fácilmente entre redes. La falta de estandarización en APIs, mecanismos de verificación o estándares de tokens reduce la eficiencia y aumenta los costos de cambio para los desarrolladores.

El riesgo de ser adoptante temprano afecta a los protocolos sin historiales probados. Las nuevas redes enfrentan problemas de “huevo y gallina” al atraer simultáneamente a proveedores de hardware y compradores de cómputo. Los protocolos pueden no alcanzar la masa crítica necesaria para operaciones sostenibles. Los inversores en tokens enfrentan el riesgo de pérdida total si las redes colapsan o no logran adopción.

Las vulnerabilidades de seguridad en los contratos inteligentes o en las capas de coordinación podrían permitir el robo de fondos o la interrupción de la red. Decentralized networks face security challenges que requieren auditorías cuidadosas de contratos inteligentes y programas de recompensas por bugs. Las explotaciones que drenan tesorerías o permiten ataques de doble pago dañan la confianza y el valor de la red.

The Road Ahead & What to Watch

El seguimiento de métricas y desarrollos clave proporciona información sobre la maduración y la trayectoria de crecimiento de las redes de cómputo tokenizado.

Los indicadores de crecimiento de la red incluyen el número de nodos de cómputo activos, la distribución geográfica, la diversidad de hardware y la capacidad total disponible medida en potencia de cómputo o equivalentes de GPU. La expansión de estas métricas indica una mayor oferta y resiliencia de la red. io.net accumulated over 300,000 verified GPUs al integrar múltiples fuentes, demostrando un potencial de escalado rápido cuando los protocolos coordinan eficazmente recursos dispares.

Las métricas de uso revelan la demanda real de cómputo descentralizado. Los trabajos de cómputo activos, las horas totales de procesamiento entregadas y la combinación de tipos de carga de trabajo muestran si las redes sirven aplicaciones reales más allá de la especulación. Akash witnessed notable surge in quarterly active leases tras ampliar el soporte de GPU, lo que indica apetito del mercado por alternativas descentralizadas a las nubes tradicionales.

La capitalización de mercado de los tokens y las valoraciones totalmente diluidas proporcionan evaluaciones de mercado del valor del protocolo. Comparar las valoraciones con los ingresos reales o el rendimiento de cómputo revela si los tokens incorporan expectativas de crecimiento futuro o reflejan la utilidad actual. Bittensor's TAO token reached $750 during peak hype in March 2024, ilustrando el interés especulativo junto con la adopción genuina.

Las asociaciones con empresas de IA y adoptantes empresariales señalan una validación generalizada. Cuando laboratorios de IA consolidados, desarrolladores de modelos o aplicaciones en producción despliegan cargas de trabajo en redes descentralizadas, se demuestra que la infraestructura distribuida cumple requisitos del mundo real. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, mostrando el compromiso corporativo con arquitecturas distribuidas.

Las actualizaciones de protocolo y adiciones de funcionalidades indican un impulso continuo de desarrollo. La integración de nuevos tipos de GPU, sistemas de orquestación mejorados, mecanismos de verificación reforzados o mejoras de gobernanza muestran una iteración activa hacia una mejor infraestructura. Bittensor's Dynamic TAO upgrade in 2025 desplazó más recompensas hacia las subredes de alto rendimiento, demostrando una tokenómica adaptativa.

Los desarrollos regulatorios configuran el entorno operativo. Una clasificación favorable de los tokens de infraestructura o una orientación clara sobre los requisitos de cumplimiento reducirían la incertidumbre legal y permitirían una participación institucional más amplia. Por el contrario, regulaciones restrictivas podrían limitar el crecimiento en jurisdicciones específicas.

Las dinámicas competitivas entre protocolos determinan la estructura del mercado. El espacio de infraestructura de cómputo puede consolidarse en torno a unas pocas redes dominantes que logren fuertes efectos de red, o permanecer fragmentado con protocolos especializados que sirvan a distintos nichos. Los estándares de interoperabilidad podrían permitir la coordinación entre redes, mejorando la eficiencia general del ecosistema.

Es posible que surjan modelos híbridos que combinen elementos centralizados y descentralizados. Las empresas podrían utilizar nubes tradicionales para capacidad base mientras recurren a redes descentralizadas durante picos de demanda. Este enfoque proporciona la previsibilidad de los servicios gestionados mientras captura ahorros de costos de las alternativas distribuidas durante los períodos de sobrecarga.

Podrían formarse redes de consorcio donde los participantes de la industria operen conjuntamente infraestructura descentralizada. Empresas de IA, proveedores de nube, fabricantes de hardware o instituciones académicas podrían establecer redes compartidas que reduzcan los requisitos de capital individuales al tiempo que mantienen una gobernanza descentralizada. Este modelo podría acelerar la adopción entre organizaciones adversas al riesgo.

La especialización vertical parece probable a medida que los protocolos se optimizan para casos de uso específicos. Algunas redes pueden centrarse exclusivamente en entrenamiento de IA, otras en inferencia, algunas en cómputo perimetral, otras en renderizado o cómputo científico. La infraestructura especializada sirve mejor a requisitos particulares de carga de trabajo en comparación con alternativas de propósito general.

La integración con herramientas y marcos de IA existentes será crucial. Una compatibilidad perfecta con bibliotecas populares de aprendizaje automático, sistemas de orquestación y pipelines de despliegue reduce la fricción para los desarrolladores. io.net supports Ray-native orchestration, reconociendo que los desarrolladores prefieren flujos de trabajo estandarizados frente a implementaciones personalizadas específicas de cada protocolo.

Las consideraciones de sostenibilidad pueden influir cada vez más en el diseño de los protocolos. Mecanismos de consenso energéticamente eficientes, incentivos de energía renovable para operadores de nodos o integración de créditos de carbono podrían diferenciar protocolos atractivos para usuarios conscientes del medio ambiente. A medida que el consumo de energía de la IA recibe mayor escrutinio, las redes descentralizadas podrían posicionar la eficiencia como una ventaja competitiva.

Media coverage y la atención de la comunidad cripto sirven como indicadores adelantados de la conciencia general. El aumento en la discusión sobre protocolos específicos, el interés creciente en búsquedas o el crecimiento de seguidores en redes sociales a menudo preceden a una adopción más amplia y a la apreciación del precio de los tokens. Sin embargo, los ciclos de exageración pueden crear señales engañosas desconectadas del crecimiento fundamental.

Conclusión

La financiación de infraestructura física (Physical Infrastructure Finance) representa la evolución de las criptomonedas hacia la coordinación de recursos computacionales del mundo real. Al tokenizar la capacidad de cómputo, los protocolos PinFi crean mercados donde las GPUs inactivas se convierten en activos productivos que generan rendimiento mediante cargas de trabajo de IA, procesamiento en el borde y necesidades de infraestructura especializada.

La convergencia entre la demanda insaciable de poder de cómputo por parte de la IA y la capacidad de las criptomonedas para coordinar sistemas distribuidos mediante incentivos económicos crea una propuesta de valor convincente. GPU shortages affecting over 50% of generative AI companies demuestran la gravedad de los cuellos de botella de infraestructura. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 señalan el reconocimiento del mercado de que los modelos distribuidos pueden capturar la oferta latente.

Protocolos como Bittensor, Render, Akash e io.net demuestran enfoques variados al mismo desafío fundamental: igualar de forma eficiente la oferta de cómputo con la demanda a través de una coordinación sin permisos basada en blockchain. Cada red experimenta con diferentes tokenomics, mecanismos de verificación y aplicaciones objetivo, contribuyendo a un ecosistema más amplio que explora el espacio de diseño para infraestructura descentralizada.

Las implicaciones se extienden más allá de las criptomonedas hacia la industria de la IA y la infraestructura computacional en general. El acceso democratizado a recursos GPU reduce las barreras para la innovación en IA. La menor dependencia de los oligopolios de nubes centralizadas introduce dinámicas competitivas que pueden mejorar los precios y la accesibilidad. Surgen nuevas clases de activos a medida que los tokens representan propiedad en infraestructura productiva en lugar de pura especulación.

Siguen existiendo desafíos significativos. La fiabilidad técnica, los mecanismos de verificación, la sostenibilidad económica, la incertidumbre regulatoria y la competencia de incumbentes bien capitalizados representan todos ellos riesgos. No todos los protocolos sobrevivirán, y muchos tokens pueden resultar sobrevalorados en relación con su utilidad fundamental. Pero la intuición central que impulsa PinFi parece sólida: existe una enorme capacidad computacional ociosa en todo el mundo, una demanda masiva de infraestructura de IA, y la coordinación basada en blockchain puede ajustar estas curvas desalineadas de oferta y demanda.

A medida que la demanda de IA siga explotando, la capa de infraestructura que alimenta esta tecnología será cada vez más crítica. Que esa infraestructura permanezca concentrada en unos pocos proveedores centralizados o evolucione hacia modelos de propiedad distribuida coordinados mediante incentivos criptoeconómicos puede definir el panorama competitivo del desarrollo de la IA durante la próxima década.

La financiación de infraestructura del futuro puede parecerse menos a la financiación tradicional de proyectos y más a redes tokenizadas de hardware distribuido globalmente, donde cualquiera con una GPU puede convertirse en proveedor de infraestructura y donde el acceso no requiere más permiso que el pago a precios de mercado. Esto representa una reimaginación fundamental de cómo se poseen, operan y monetizan los recursos computacionales: una en la que los protocolos cripto demuestran utilidad más allá de la especulación financiera al resolver problemas tangibles en el mundo físico.