L’industrie de l’intelligence artificielle fait face à un goulet d’étranglement critique au niveau de l’infrastructure. L’entraînement des grands modèles de langage exige des ressources de calcul gigantesques, les appareils en périphérie se multiplient à un rythme exponentiel, et la rareté des GPU est devenue la contrainte déterminante de l’ère de l’IA. Parallèlement, les fournisseurs cloud traditionnels peinent à répondre à la demande explosive tout en maintenant leur emprise monopolistique sur l’accès et la tarification.

Over 50% of generative AI companies report GPU shortages comme principal obstacle à la montée en charge de leurs opérations. AI computing power is expected to increase by roughly 60 times by the end of 2025 par rapport au T1 2023. Cette course aux armements computationnelle a ouvert une brèche permettant aux protocoles crypto de proposer une alternative décentralisée.

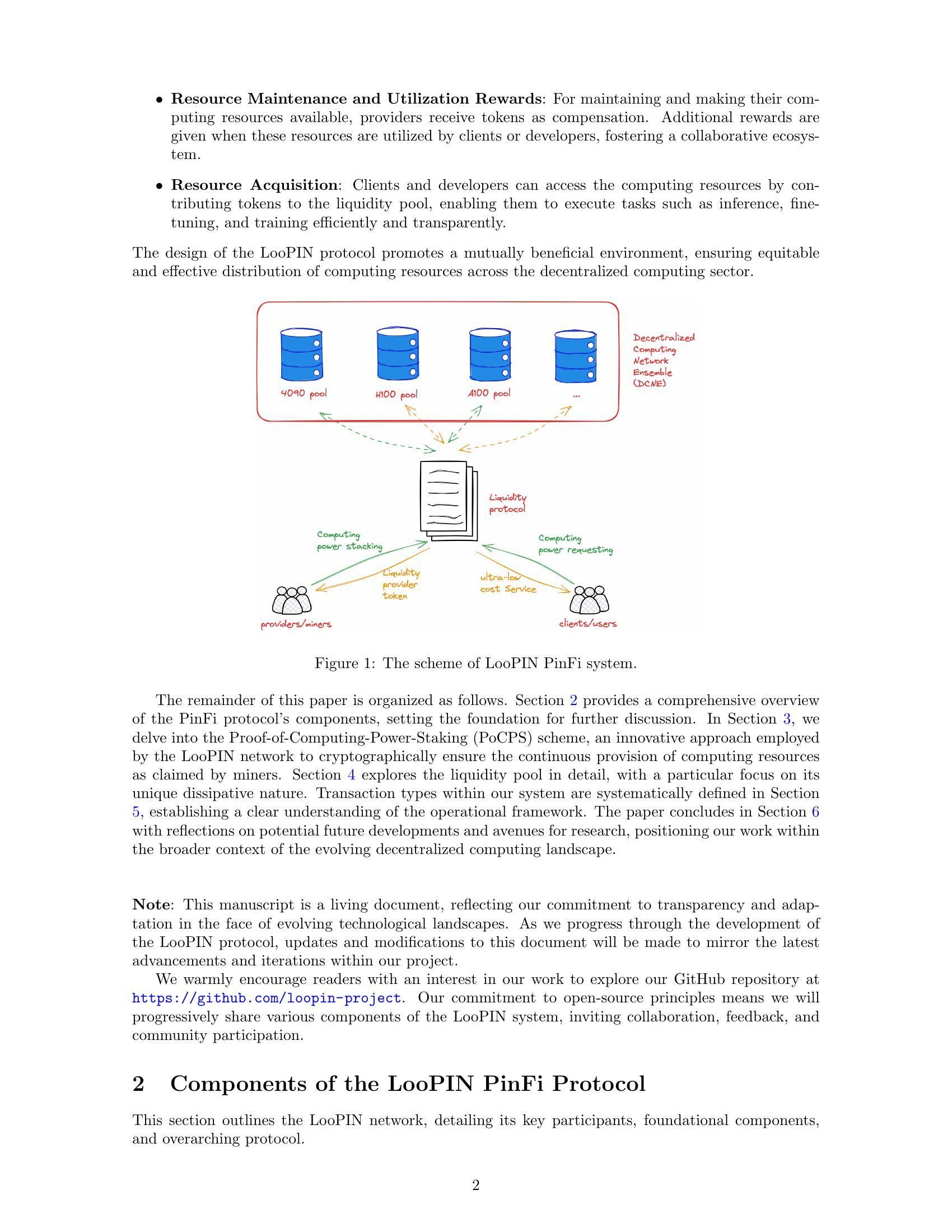

Voici venir la Finance d’Infrastructure Physique, ou PinFi. Ce cadre émergent traite la capacité de calcul comme un actif tokenisé pouvant être échangé, staké et monétisé via des réseaux basés sur la blockchain. Plutôt que de dépendre de centres de données centralisés, les protocoles PinFi agrègent la puissance GPU inutilisée d’opérateurs indépendants, de rigs de gaming, de fermes de minage et d’appareils en périphérie dans des places de marché distribuées accessibles aux développeurs d’IA du monde entier.

Nous allons examiner ci‑dessous comment une puissance de calcul réelle est transformée en infrastructure crypto‑économique : compréhension de la mécanique des réseaux de calcul tokenisé, des modèles économiques qui incitent à la participation, de l’architecture permettant la vérification et le règlement, ainsi que des implications pour les industries de la crypto et de l’IA.

Pourquoi PinFi maintenant ? Les moteurs macro et techniques

Le goulet d’étranglement computationnel auquel fait face l’industrie de l’IA découle de contraintes fondamentales d’offre. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, laissant de nombreux utilisateurs se battre pour l’accès. The global AI chip market reached $123.16 billion in 2024 et devrait atteindre 311,58 milliards de dollars d’ici 2029, ce qui reflète une demande explosive largement supérieure aux capacités de production.

La rareté des GPU se manifeste de multiples façons. Les fournisseurs cloud traditionnels maintiennent des listes d’attente pour les instances GPU haut de gamme. AWS charges $98.32 per hour for an 8-GPU H100 instance, une tarification qui place des capacités d’IA avancées hors de portée de nombreux développeurs et startups. Les prix du matériel restent élevés en raison des contraintes d’offre, avec HBM3 pricing rising 20-30% year-over-year.

La concentration de la puissance de calcul entre les mains de quelques grands fournisseurs cloud crée des frictions supplémentaires. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, mais l’accès reste conditionné par des contrats, des limitations géographiques et des exigences KYC. Cette centralisation limite l’innovation et crée des points de défaillance uniques pour des infrastructures critiques.

Pendant ce temps, d’énormes quantités de capacité de calcul restent inexploitées. Les rigs de gaming sont inutilisés pendant les heures de travail. Les mineurs de crypto recherchent de nouvelles sources de revenus à mesure que l’économie du minage évolue. Les centres de données conservent une capacité excédentaire pendant les périodes creuses. The decentralized compute market has grown from $9 billion in 2024 avec des projections atteignant 100 milliards de dollars d’ici 2032, ce qui signale une reconnaissance du marché que les modèles distribués peuvent capter cette offre latente.

L’intersection de la technologie blockchain et de l’infrastructure physique a mûri avec les réseaux d’infrastructure physique décentralisée, ou DePIN. Les protocoles DePIN utilisent des incitations sous forme de jetons pour coordonner le déploiement et l’exploitation d’infrastructures du monde réel. Messari identified DePIN's total addressable market at $2.2 trillion, avec un potentiel de 3,5 billions de dollars d’ici 2028.

PinFi représente l’application des principes DePIN spécifiquement à l’infrastructure de calcul. Il traite les ressources computationnelles comme des actifs tokenisables générant un rendement via leur usage productif. Ce cadre transforme l’informatique, qui passe d’un service loué auprès de fournisseurs centralisés à une commodité échangée sur des marchés ouverts et sans permission.

Qu’est-ce que PinFi et le calcul tokenisé ?

La Finance d’Infrastructure Physique définit un modèle dans lequel des actifs de calcul physiques sont représentés par des jetons numériques sur des blockchains, permettant une propriété, une exploitation et une monétisation décentralisées. Contrairement aux protocoles de finance décentralisée traditionnels qui traitent d’actifs purement numériques, PinFi crée des ponts entre des ressources physiques off‑chain et des systèmes économiques on‑chain.

Academic research defines tokenization comme « le processus de conversion de droits, d’unités de propriété d’actifs, de dettes ou même d’actifs physiques en jetons numériques sur une blockchain ». Pour les ressources de calcul, cela signifie que des GPU individuels, des grappes de serveurs ou des appareils en périphérie sont représentés par des jetons qui suivent leur capacité, leur disponibilité et leur utilisation.

PinFi diffère fondamentalement de la finance d’infrastructure classique ou des protocoles DeFi typiques. La finance d’infrastructure traditionnelle implique des investissements en dette ou en fonds propres à long terme dans de grands projets capitalistiques. Les protocoles DeFi facilitent principalement l’échange, le prêt ou la génération de rendement sur des actifs natifs de la crypto. PinFi se situe à l’intersection, appliquant des incitations crypto‑économiques pour coordonner des ressources de calcul réelles tout en conservant un règlement et une gouvernance on‑chain.

Plusieurs protocoles illustrent le modèle PinFi. Bittensor operates as a decentralized AI network où les participants contribuent des modèles de machine learning et des ressources de calcul à des sous‑réseaux spécialisés axés sur des tâches spécifiques. Le jeton TAO incite les contributions en fonction de la valeur informationnelle apportée à l’intelligence collective du réseau. With over 7,000 miners apportant du calcul, Bittensor crée des marchés pour l’inférence IA et l’entraînement de modèles.

Render Network aggregates idle GPUs globally pour des tâches de rendu GPU distribuées. Initialement axé sur le rendu 3D pour les artistes et créateurs de contenu, Render s’est étendu aux charges de travail de calcul pour l’IA. Son jeton RNDR sert de moyen de paiement pour les travaux de rendu tout en récompensant les fournisseurs de GPU pour la capacité fournie.

Akash Network operates as a decentralized cloud marketplace qui utilise la capacité inutilisée des centres de données. Grâce à un système d’enchères inversées, les déployeurs de calcul définissent leurs exigences et les fournisseurs enchérissent pour répondre aux demandes. Le jeton AKT facilite la gouvernance, le staking et les règlements sur le réseau. Akash witnessed notable surge in quarterly active leases après avoir élargi son focus pour inclure les GPU en plus des ressources CPU traditionnelles.

io.net has aggregated over 300,000 verified GPUs en intégrant des ressources provenant de centres de données indépendants, de mineurs de crypto et d’autres réseaux DePIN, y compris Render et Filecoin. La plateforme se concentre spécifiquement sur les charges de travail d’IA et de machine learning, offrant aux développeurs la possibilité de déployer des grappes de GPU dans 130 pays en quelques minutes.

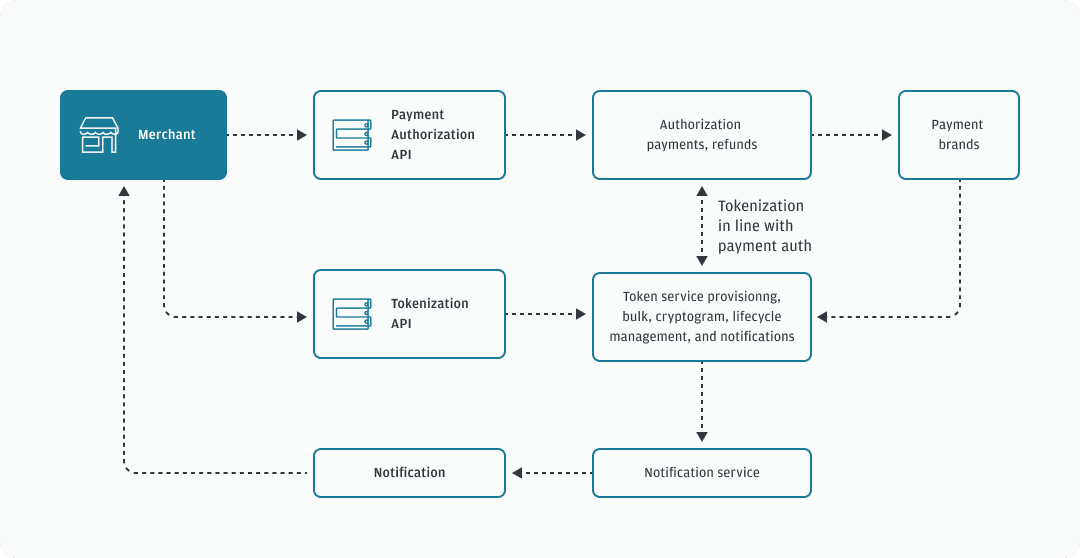

La mécanique du calcul tokenisé suit un schéma cohérent à travers ces protocoles. Les fournisseurs de calcul enregistrent leur matériel auprès du réseau, en passant par des processus de vérification pour confirmer la capacité et les caractéristiques. Des smart contracts gèrent la relation entre l’offre et la demande, en dirigeant les tâches de calcul vers les nœuds disponibles en fonction des exigences, des prix et des contraintes géographiques. Les récompenses en jetons incitent à la fois la fourniture de matériel et la qualité du service rendu.

La création de valeur découle de l’utilisation réelle plutôt que de la spéculation. Lorsqu’un développeur d’IA entraîne un modèle en utilisant des ressources GPU distribuées, le paiement est acheminé vers les fournisseurs dont le matériel a effectué le travail. La puissance de calcul devient un actif productif générant un rendement, de la même manière que les validateurs en preuve d’enjeu gagnent des récompenses pour la sécurisation des réseaux. Cela crée une économie durable où la valeur du jeton est corrélée à l’utilité du réseau.

Architecture d’infrastructure : nœuds, marchés, règlement

L’architecture qui permet le calcul tokenisé nécessite une coordination à travers plusieurs couches. À la base se trouve un réseau de fournisseurs de calcul indépendants qui déploient du matériel, s’enregistrent auprès des protocoles et rendent leur capacité disponible à la location. Ces fournisseurs vont d’individus équipés de PC de gaming à des opérateurs professionnels de centres de données, en passant par des opérations de minage de cryptomonnaies à la recherche de revenus supplémentaires.

Le provisionnement des nœuds commence lorsqu’un fournisseur de calcul connecte son matériel au réseau. Protocols like io.net support diverse GPU types, depuis les NVIDIA RTX 4090 grand public jusqu’aux H100 et A100 pour l’entreprise. Le fournisseur installe un logiciel client qui expose la capacité à la couche d’orchestration du réseau tout en maintenant des frontières de sécurité qui empêchent tout accès non autorisé.

Des mécanismes de vérification garantissent que la capacité annoncée correspond aux capacités réelles. Certains protocoles utilisent des preuves cryptographiques de calcul, où les nœuds doivent démontrer qu’ils ont effectué des calculs spécifiques correctement. Bittensor uses its Yuma Consensus mechanism, où les validateurs évaluent la qualité des résultats d’apprentissage automatique produits par les mineurs et attribuent des scores qui déterminent la distribution des récompenses. Les nœuds fournissant des résultats de faible qualité ou tentant de tricher voient leur rémunération réduite ou subissent une réduction (« slashing ») de leurs jetons mis en jeu.

L’évaluation de la latence permet d’associer les charges de travail au matériel approprié. L’inférence en IA exige des caractéristiques de performance différentes de celles de l’entraînement de modèles ou du rendu 3D. La localisation géographique influe sur la latence pour les applications d’informatique en périphérie, où le traitement doit avoir lieu à proximité des sources de données. The edge computing market reached $23.65 billion in 2024 et devrait atteindre 327,79 milliards de dollars d’ici 2033, porté par la demande de traitement localisé.

La couche de place de marché met en relation la demande et l’offre de calcul. Lorsque les développeurs ont besoin de ressources GPU, ils spécifient des exigences incluant la puissance de calcul, la mémoire, la durée et le prix maximal. Akash employs a reverse auction model dans lequel les déployeurs fixent les conditions et les fournisseurs enchérissent pour remporter les contrats. Render uses dynamic pricing algorithms qui ajustent les tarifs en fonction de l’utilisation du réseau et des conditions de marché.

Les algorithmes de routage des tâches optimisent le placement des travaux de calcul sur les nœuds disponibles. Les facteurs pris en compte incluent les spécifications matérielles, l’utilisation actuelle, la proximité géographique, la performance historique et le prix. io.net's orchestration layer gère des flux de travail conteneurisés et prend en charge l’orchestration native Ray pour les charges d’apprentissage automatique distribuées.

Le règlement s’effectue on-chain via des contrats intelligents qui consignent les paiements en séquestre et libèrent les fonds une fois le travail vérifié comme achevé. Ce règlement sans confiance élimine le risque de contrepartie tout en permettant les microtransactions pour des tâches de calcul de courte durée. Protocols built on high-throughput blockchains like Solana peuvent gérer le volume de transactions généré par des milliers de requêtes d’inférence simultanées.

Les mécanismes de staking alignent les incitations entre les participants. Les fournisseurs de calcul mettent souvent des jetons en jeu pour démontrer leur engagement et exposer un collatéral pouvant être réduit en cas de faible performance. Validators in Bittensor stake TAO tokens pour gagner en influence dans la notation des mineurs et percevoir une partie des récompenses de bloc. Les détenteurs de jetons peuvent déléguer leur mise aux validateurs en qui ils ont confiance, de manière similaire aux mécanismes de consensus par preuve d’enjeu.

La gouvernance permet aux détenteurs de jetons de voter sur les paramètres du protocole, y compris la distribution des récompenses, les structures de frais et les mises à niveau du réseau. Decentralized governance garantit qu’aucune autorité centrale ne peut modifier unilatéralement les règles ou restreindre l’accès, préservant le caractère permissionless qui distingue ces réseaux des fournisseurs cloud traditionnels.

Cette architecture contraste fortement avec l’informatique en nuage centralisée. Les grands fournisseurs possèdent leur infrastructure, fixent les prix sans réelle concurrence de marché, exigent des comptes et des vérifications de conformité, et conservent le contrôle sur l’accès et la censure. Les protocoles PinFi distribuent la propriété entre des milliers d’opérateurs indépendants, permettent une tarification transparente fondée sur le marché, fonctionnent sans permission et résistent à la censure grâce à la décentralisation.

Tokenomics & Incentive Models

L’économie des jetons fournit la structure d’incitation qui coordonne les réseaux de calcul distribués. Les jetons natifs remplissent plusieurs fonctions, notamment le paiement des services, la récompense de la fourniture de ressources, les droits de gouvernance et les exigences de staking pour la participation au réseau.

Les mécanismes d’émission déterminent comment les jetons entrent en circulation. Bittensor follows Bitcoin's model with a capped supply of 21 million TAO tokens et des halvings périodiques qui réduisent l’émission au fil du temps. Currently 7,200 TAO are minted daily, répartis entre les mineurs qui fournissent des ressources de calcul et les validateurs qui garantissent la qualité du réseau. Cela crée une rareté similaire à celle du Bitcoin tout en orientant l’inflation vers une infrastructure productive.

D’autres protocoles émettent des jetons en fonction de l’utilisation du réseau. Lorsque des tâches de calcul sont exécutées, de nouveaux jetons frappés sont distribués aux fournisseurs proportionnellement aux ressources qu’ils ont fournies. Ce lien direct entre la création de valeur et l’émission de jetons garantit que l’inflation récompense la productivité réelle plutôt que la simple détention passive de jetons.

Le staking crée une mise en jeu (« skin in the game ») pour les participants au réseau. Les fournisseurs de calcul mettent des jetons en jeu pour enregistrer des nœuds et démontrer leur engagement. Une mauvaise performance ou une tentative de fraude entraîne un slashing, où les jetons misés sont détruits ou redistribués aux parties lésées. Cette pénalité économique incite à fournir un service fiable et à adopter un comportement honnête.

Les validateurs misent des montants plus importants pour gagner en influence dans l’évaluation de la qualité et les décisions de gouvernance. In Bittensor's model, validators evaluate miners' outputs et soumettent des matrices de poids indiquant quels nœuds ont apporté des contributions de valeur. Le Yuma Consensus agrège ces évaluations pondérées par la mise des validateurs pour déterminer la distribution finale des récompenses.

La dynamique d’offre et de demande pour les jetons de calcul opère à deux niveaux. Du côté de l’offre, l’arrivée de nouveaux nœuds dans le réseau augmente la capacité de calcul disponible. Les récompenses en jetons doivent être suffisantes pour compenser les coûts matériels, l’électricité et les coûts d’opportunité par rapport à d’autres usages possibles de l’équipement. À mesure que le prix du jeton augmente, la fourniture de calcul devient plus rentable, attirant une offre supplémentaire.

Du côté de la demande, le prix du jeton reflète la valeur que les utilisateurs accordent à l’accès au réseau. À mesure que les applications d’IA se multiplient et que la rareté du calcul s’intensifie, la volonté de payer pour des ressources décentralisées augmente. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034, créant une demande soutenue pour des sources de calcul alternatives.

L’appréciation de la valeur du jeton profite à tous les participants. Les fournisseurs de matériel gagnent davantage pour la même production de calcul. Les premiers opérateurs de nœuds bénéficient de l’appréciation des récompenses accumulées. Les développeurs profitent d’une alternative décentralisée aux fournisseurs centralisés onéreux. Les détenteurs de jetons qui les mettent en jeu ou fournissent de la liquidité capturent des frais issus de l’activité du réseau.

Les modèles de risque traitent les modes de défaillance potentiels. Les périodes d’inactivité des nœuds réduisent les gains, car les tâches sont redirigées vers d’autres nœuds disponibles. Une concentration géographique crée des problèmes de latence pour les applications en périphérie nécessitant un traitement local. Les effets de réseau favorisent les protocoles plus vastes, disposant d’un matériel plus diversifié et d’une meilleure distribution géographique.

L’inflation des jetons doit trouver un équilibre entre l’attraction d’une nouvelle offre et le maintien de la valeur pour les détenteurs existants. Research on decentralized infrastructure protocols souligne qu’une tokenomics durable exige que la croissance de la demande dépasse l’augmentation de l’offre. Les protocoles mettent en œuvre des mécanismes de burn, où les jetons utilisés pour les paiements sont définitivement retirés de la circulation, créant une pression déflationniste qui compense l’émission inflationniste.

Les structures de frais varient selon les réseaux. Certains facturent directement les utilisateurs en jetons natifs. D’autres acceptent des stablecoins ou des versions encapsulées des principales cryptomonnaies, les jetons du protocole servant principalement aux fonctions de gouvernance et de staking. Les modèles hybrides utilisent les jetons pour l’accès au réseau tout en réglant les paiements de calcul en actifs stables afin de réduire le risque de volatilité.

L’espace de conception des modèles d’incitation continue d’évoluer, les protocoles expérimentant différentes approches pour équilibrer les intérêts des parties prenantes et soutenir la croissance à long terme.

AI, Edge, and Real-World Infrastructure

Les réseaux de calcul tokenisés permettent des applications exploitant du matériel distribué pour des charges de travail d’IA, le traitement en périphérie et des besoins d’infrastructure spécialisés. La diversité des cas d’usage montre comment les modèles décentralisés peuvent résoudre des goulets d’étranglement à travers toute la pile computationnelle.

L’entraînement distribué de modèles d’IA représente un cas d’usage principal. L’entraînement de grands modèles de langage ou de systèmes de vision par ordinateur nécessite un calcul massivement parallèle sur de multiples GPU. Les approches traditionnelles concentrent cet entraînement dans des centres de données centralisés appartenant aux grands fournisseurs cloud. Les réseaux décentralisés permettent à l’entraînement de se dérouler sur des nœuds géographiquement distribués, chacun contribuant du travail de calcul coordonné via une orchestration fondée sur la blockchain.

Bittensor's subnet architecture permet des marchés d’IA spécialisés centrés sur des tâches spécifiques comme la génération de texte, la synthèse d’images ou le data scraping. Les mineurs rivalisent pour fournir des résultats de haute qualité dans leurs domaines choisis, les validateurs évaluant la performance et distribuant les récompenses en conséquence. Cela crée des marchés compétitifs où les meilleurs modèles et les implémentations les plus efficaces émergent naturellement par sélection économique.

Les charges de travail d’informatique en périphérie bénéficient particulièrement de l’infrastructure décentralisée. The global edge computing market was valued at $23.65 billion in 2024, porté par des applications nécessitant faible latence et traitement local. Les appareils IoT générant des données de capteurs en continu ont besoin d’analyses immédiates, sans délais d’aller-retour vers des centres de données éloignés. Les véhicules autonomes nécessitent une prise de décision en une fraction de seconde, qui ne peut pas tolérer la latence réseau.

Les réseaux de calcul décentralisés peuvent placer la capacité de traitement physiquement au plus près des sources de données. Une usine déployant des capteurs IoT industriels peut louer des nœuds en périphérie (edge) dans la même ville ou région plutôt que de s’appuyer sur des clouds centralisés situés à des centaines de kilomètres. Industrial IoT applications accounted for the largest market share in edge computing in 2024, reflétant l’importance critique du traitement localisé pour la fabrication et la logistique.

Le rendu de contenus et les workflows créatifs consomment des ressources GPU significatives. Les artistes qui rendent des scènes 3D, les animateurs qui produisent des films et les développeurs de jeux qui compilent des assets ont tous besoin d’un traitement parallèle intensif. Render Network specializes in distributed GPU rendering, en connectant les créateurs à une capacité GPU inutilisée dans le monde entier. Ce modèle de place de marché réduit les coûts de rendu tout en offrant des sources de revenus pour les propriétaires de GPU pendant les périodes creuses.

Le calcul scientifique et les applications de recherche sont confrontés à des contraintes budgétaires lorsqu’ils accèdent à des ressources cloud coûteuses. Les institutions académiques, les chercheurs indépendants et les petites organisations peuvent tirer parti des réseaux décentralisés pour exécuter des simulations, analyser des jeux de données ou entraîner des modèles spécialisés. La nature permissionless signifie que des chercheurs dans n’importe quelle région peuvent accéder à des ressources de calcul sans comptes cloud institutionnels ni vérifications de crédit.

Les plateformes de jeux vidéo et de métavers nécessitent des calculs de rendu et de physique pour des expériences immersives. À mesure que les mondes virtuels gagnent en complexité, les besoins de calcul pour maintenir des environnements persistants et supporter des milliers d’utilisateurs simultanés augmentent. Des nœuds de calcul distribués en périphérie peuvent fournir un traitement local pour des populations de joueurs régionales, réduisant la latence tout en répartissant les coûts d’infrastructure entre des fournisseurs incités par des tokens.

L’inférence IA à grande échelle nécessite un accès GPU continu pour servir les prédictions de modèles entraînés. Un chatbot répondant à des millions de requêtes, un service de génération d’images traitant les prompts des utilisateurs ou un moteur de recommandation analysant le comportement des utilisateurs ont tous besoin d’une capacité de calcul toujours disponible. Les réseaux décentralisés offrent une redondance et une distribution géographique qui renforcent la fiabilité par rapport à des dépendances envers un seul fournisseur.

Les zones géographiques sous-desservies par les grands fournisseurs de cloud présentent des opportunités pour les protocoles PinFi. Les régions disposant d’une présence limitée en centres de données subissent une latence et des coûts plus élevés lorsqu’elles accèdent à une infrastructure centralisée. Les fournisseurs de matériel locaux dans ces zones peuvent offrir une capacité de calcul adaptée à la demande régionale, gagnant des récompenses en tokens tout en améliorant l’accès local aux capacités d’IA.

Les exigences en matière de souveraineté des données imposent de plus en plus que certaines charges de travail traitent les données au sein de juridictions spécifiques. Regulations like the EU Data Act require sensitive information to be processed locally, ce qui encourage le déploiement d’une infrastructure edge conforme aux règles de résidence des données. Les réseaux décentralisés prennent naturellement en charge le déploiement de nœuds spécifiques à une juridiction tout en maintenant une coordination globale via le règlement basé sur la blockchain.

Why It Matters: Implications for Crypto & Infrastructure

L’émergence de PinFi représente l’expansion de la crypto au‑delà des applications purement financières vers la coordination d’infrastructures du monde réel. Ce changement a des implications pour l’écosystème crypto comme pour les industries du calcul au sens large.

Les protocoles crypto démontrent une utilité au‑delà de la spéculation lorsqu’ils résolvent des problèmes d’infrastructure tangibles. DePIN et PinFi créent des systèmes économiques qui coordonnent des ressources physiques, prouvant que les incitations basées sur la blockchain peuvent amorcer des réseaux dans le monde réel. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, représentant environ trois fois la capitalisation totale actuelle du marché crypto.

La démocratisation de l’accès au calcul répond à une asymétrie fondamentale dans le développement de l’IA. Aujourd’hui, les capacités d’IA avancées restent largement concentrées parmi des entreprises technologiques bien financées capables d’assumer d’immenses clusters de GPU. Les startups, les chercheurs et les développeurs dans des environnements à ressources limitées se heurtent à des barrières pour participer à l’innovation en IA. Les réseaux de calcul décentralisés abaissent ces barrières en fournissant un accès permissionless à du matériel distribué à des prix déterminés par le marché.

La création de nouvelles classes d’actifs élargit le paysage d’investissement crypto. Les tokens représentant une capacité de calcul incarnent une forme de propriété dans une infrastructure productive qui génère des revenus via une utilisation réelle. Cela diffère d’actifs purement spéculatifs ou de tokens de gouvernance sans mécanismes clairs de captation de valeur. Les détenteurs de tokens possèdent essentiellement des parts d’un fournisseur de cloud décentralisé, avec une valeur liée à la demande en services de calcul.

Les monopoles d’infrastructure traditionnels font face à un risque de perturbation. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control des marchés du calcul, en fixant les prix sans concurrence directe. Les alternatives décentralisées introduisent des dynamiques de marché où des milliers de fournisseurs indépendants se concurrencent, pouvant faire baisser les coûts tout en améliorant l’accessibilité.

L’industrie de l’IA bénéficie d’une dépendance réduite à l’égard d’infrastructures centralisées. Actuellement, le développement de l’IA se concentre autour des grands fournisseurs de cloud, créant des points de défaillance uniques et un risque de concentration. Over 50% of generative AI companies report GPU shortages as major obstacles. Les réseaux distribués offrent une capacité alternative pouvant absorber les pics de demande et fournir une redondance face aux perturbations des chaînes d’approvisionnement.

Des améliorations de l’efficacité énergétique peuvent émerger d’une meilleure utilisation de la capacité. Les PC de jeu laissés inactifs consomment une alimentation de veille sans production utile. Les opérations de minage disposant d’une capacité excédentaire recherchent des sources de revenus supplémentaires. Distributed networks put idle GPUs to productive use, améliorant l’efficacité globale des ressources dans l’écosystème du calcul.

La résistance à la censure devient pertinente pour les applications d’IA. Les fournisseurs de cloud centralisés peuvent refuser le service à certains utilisateurs, applications ou régions entières. Les réseaux décentralisés fonctionnent sans autorisation préalable, permettant le développement et le déploiement d’IA sans approbation de gardiens. Cela est particulièrement important pour des applications controversées ou des utilisateurs dans des juridictions restrictives.

Les architectures de confidentialité des données s’améliorent grâce au traitement local. Edge computing keeps sensitive data near its source plutôt que de les transmettre à des centres de données éloignés. Les réseaux décentralisés peuvent mettre en œuvre des techniques préservant la confidentialité comme le fédéré learning (apprentissage fédéré), où les modèles s’entraînent sur des données distribuées sans centraliser les informations brutes.

L’efficacité du marché augmente grâce à une découverte des prix plus transparente. La tarification cloud traditionnelle reste opaque, avec des structures de frais complexes et des contrats d’entreprise négociés. Les places de marché décentralisées établissent des prix spot clairs pour les ressources de calcul, permettant aux développeurs d’optimiser les coûts et aux fournisseurs de maximiser leurs revenus via des dynamiques compétitives.

La pertinence à long terme découle de moteurs de demande durables. Les charges de travail IA continueront à croître à mesure que les applications se multiplient. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Le calcul restera une contrainte fondamentale, garantissant une demande continue pour des modèles d’infrastructure alternatifs.

Les effets de réseau favorisent les premiers protocoles qui atteignent une masse critique. À mesure que davantage de fournisseurs de matériel rejoignent le réseau, la diversité des ressources disponibles augmente. La distribution géographique s’améliore, réduisant la latence pour les applications edge. Les réseaux plus vastes attirent plus de développeurs, créant des cercles vertueux de croissance. Les premiers entrants dans des domaines spécifiques peuvent établir des avantages durables.

Challenges & Risks

Malgré des applications prometteuses, les réseaux de calcul tokenisé font face à des défis techniques, économiques et réglementaires significatifs susceptibles de freiner leur croissance ou de limiter leur adoption.

La fiabilité technique demeure une préoccupation majeure. Les fournisseurs de cloud centralisés offrent des accords de niveau de service garantissant disponibilité et performance. Les réseaux distribués coordonnent du matériel provenant d’opérateurs indépendants avec des niveaux variables de professionnalisme et de qualité d’infrastructure. Les pannes de nœuds, interruptions réseau ou fenêtres de maintenance créent des lacunes de disponibilité qui doivent être gérées via la redondance et des algorithmes de routage.

La vérification du travail réellement effectué pose des défis persistants. S’assurer que les nœuds exécutent honnêtement les calculs plutôt que de renvoyer de faux résultats nécessite des systèmes de preuve sophistiqués. Cryptographic proofs of compute ajoutent une surcharge mais restent nécessaires pour prévenir la fraude. Des mécanismes de vérification imparfaits rendent possibles des attaques où des nœuds malveillants réclament des récompenses sans fournir les services promis.

Les limitations de latence et de bande passante affectent les charges de travail distribuées. Running computations across geographically dispersed locations can cause delays comparatively to co-located hardware in single data centers. La bande passante réseau entre les nœuds limite les types de charges de travail adaptées au traitement distribué. Les calculs parallèles fortement couplés nécessitant une communication fréquente entre nœuds subissent une dégradation des performances.

La variabilité de la qualité de service crée de l’incertitude pour les applications de production. Contrairement aux environnements cloud managés à la performance prévisible, les pools de matériel hétérogènes produisent des résultats incohérents. Un entraînement peut s’exécuter sur des H100 de qualité entreprise ou sur des cartes RTX grand public selon la disponibilité. Les développeurs d’applications doivent concevoir en tenant compte de cette variabilité ou mettre en place un filtrage qui restreint les tâches à des niveaux de matériel spécifiques.

La viabilité économique exige d’équilibrer la croissance de l’offre avec l’expansion de la demande. Des augmentations rapides de la capacité de calcul disponible sans croissance correspondante de la demande feraient baisser les prix des tokens et réduiraient la rentabilité des fournisseurs. Les protocoles doivent gérer soigneusement l’émission de tokens pour éviter une inflation qui dépasse la croissance de l’utilité. Sustainable tokenomics requires demand growth to outpace supply increases.

La compression de la valeur des tokens présente des risques pour les participants à long terme. À mesure que de nouveaux fournisseurs rejoignent les réseaux pour obtenir des récompenses, l’augmentation de la concurrence fait baisser les gains par nœud. Les premiers participants, qui bénéficient de récompenses initiales plus élevées, peuvent voir leurs rendements diminuer avec le temps. Si l’appréciation du token ne compense pas cette dilution, la rotation des fournisseurs augmente et la stabilité du réseau en pâtit.

La volatilité du marché introduit un risque financier pour les participants. Les fournisseurs perçoivent des récompenses dans les tokens natifs dont la valeur fluctue. Un opérateur matériel peut investir du capital dans l’achat de GPU en s’attendant à ce que les prix des tokens restent stables, pour finalement subir des pertes en cas de baisse des prix. Des mécanismes de couverture et des options de paiement en stablecoins peuvent atténuer la volatilité mais ajoutent de la complexité.

L’incertitude réglementaire autour de la classification des tokens crée des défis de conformité. Les autorités de régulation des valeurs mobilières dans diverses juridictions évaluent si les tokens de calcul constituent des valeurs mobilières soumises à des obligations d’enregistrement. Un statut juridique ambigu limite la participation institutionnelle et crée des risques de responsabilité pour les développeurs de protocoles. Infrastructure tokenization faces regulation uncertainties qui ont freiné l’adoption par rapport aux structures de la finance traditionnelle.

Les réglementations sur la protection des données imposent des exigences que les réseaux distribués doivent gérer. Le traitement des données des citoyens européens nécessite la conformité au RGPD, y compris la minimisation des données et les droits à l’effacement. Les applications de santé doivent satisfaire aux exigences HIPAA. Les applications financières sont confrontées aux obligations de lutte contre le blanchiment d’argent. Les réseaux décentralisés compliquent la conformité lorsque les données circulent entre de multiples juridictions et opérateurs indépendants.

Les contributions en matériel peuvent déclencher un examen réglementaire selon la façon dont les accords sont structurés. Certaines juridictions peuvent classer certaines relations fournisseurs comme des offres de valeurs mobilières ou des produits financiers réglementés. La frontière entre la fourniture d’infrastructure et les contrats d’investissement reste floue dans de nombreux cadres juridiques.

La concurrence des fournisseurs de cloud hyperscale continue de s’intensifier. Les grands fournisseurs investissent des milliards dans de nouvelles capacités de centres de données et des accélérateurs IA personnalisés. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, principalement pour l’infrastructure IA. Ces acteurs bien capitalisés peuvent pratiquer des prix plus bas ou regrouper le calcul avec d’autres services pour maintenir leurs parts de marché.

La fragmentation des réseaux pourrait limiter la composabilité. De multiples protocoles concurrents créent des écosystèmes cloisonnés où les ressources de calcul ne peuvent pas facilement être transférées d’un réseau à l’autre. L’absence de standardisation des API, des mécanismes de vérification ou des standards de tokens réduit l’efficacité et augmente les coûts de changement pour les développeurs.

Le risque d’adoption précoce affecte les protocoles sans antécédents éprouvés. Les nouveaux réseaux font face à un problème de poule et d’œuf pour attirer simultanément les fournisseurs de matériel et les acheteurs de calcul. Les protocoles peuvent ne pas atteindre la masse critique nécessaire à des opérations durables. Les investisseurs en tokens risquent une perte totale si les réseaux s’effondrent ou n’arrivent pas à être adoptés.

Les vulnérabilités de sécurité dans les smart contracts ou les couches de coordination peuvent permettre le vol de fonds ou la perturbation du réseau. Decentralized networks face security challenges qui exigent un audit minutieux des smart contracts et des programmes de bug bounty. Des exploits qui vident les trésoreries ou permettent des attaques de double paiement nuisent à la confiance et à la valeur du réseau.

La route à venir et ce qu’il faut surveiller

Le suivi des indicateurs clés et des évolutions fournit un aperçu de la maturation et de la trajectoire de croissance des réseaux de calcul tokenisés.

Les indicateurs de croissance du réseau incluent le nombre de nœuds de calcul actifs, la distribution géographique, la diversité du matériel et la capacité totale disponible mesurée en puissance de calcul ou en équivalents GPU. L’expansion de ces mesures signale une augmentation de l’offre et une résilience accrue du réseau. io.net accumulated over 300,000 verified GPUs en intégrant de multiples sources, démontrant un potentiel de mise à l’échelle rapide lorsque les protocoles coordonnent efficacement des ressources disparates.

Les métriques d’utilisation révèlent la demande réelle de calcul décentralisé. Les tâches de calcul actives, le nombre total d’heures de traitement fournies et la diversité des types de charges de travail montrent si les réseaux servent de vraies applications au-delà de la spéculation. Akash witnessed notable surge in quarterly active leases après l’extension du support GPU, indiquant l’appétit du marché pour des alternatives décentralisées aux clouds traditionnels.

La capitalisation boursière des tokens et les valorisations entièrement diluées fournissent des évaluations de marché de la valeur du protocole. Comparer ces valorisations aux revenus réels ou au débit de calcul révèle si les tokens intègrent des attentes de croissance future ou reflètent l’utilité actuelle. Bittensor's TAO token reached $750 during peak hype in March 2024, illustrant un intérêt spéculatif aux côtés d’une adoption réelle.

Les partenariats avec des entreprises d’IA et des adopteurs industriels signalent une validation grand public. Lorsque des laboratoires d’IA établis, des développeurs de modèles ou des applications en production déploient des charges de travail sur des réseaux décentralisés, cela démontre que l’infrastructure distribuée répond aux exigences du monde réel. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, montrant l’engagement des entreprises envers les architectures distribuées.

Les mises à niveau de protocoles et les ajouts de fonctionnalités indiquent un élan de développement continu. L’intégration de nouveaux types de GPU, l’amélioration des systèmes d’orchestration, le renforcement des mécanismes de vérification ou les améliorations de la gouvernance montrent une itération active vers une meilleure infrastructure. Bittensor's Dynamic TAO upgrade in 2025 a réorienté davantage de récompenses vers les sous-réseaux les plus performants, démontrant une tokenomique adaptative.

Les évolutions réglementaires façonnent l’environnement opérationnel. Une classification favorable des tokens d’infrastructure ou des lignes directrices claires en matière de conformité réduiraient l’incertitude juridique et permettraient une participation institutionnelle plus large. À l’inverse, des réglementations restrictives pourraient limiter la croissance dans certaines juridictions.

Les dynamiques concurrentielles entre protocoles déterminent la structure du marché. L’espace de l’infrastructure de calcul pourrait se consolider autour de quelques réseaux dominants bénéficiant de forts effets de réseau, ou rester fragmenté avec des protocoles spécialisés servant différents créneaux. Des standards d’interopérabilité pourraient permettre une coordination inter-réseaux, améliorant l’efficacité globale de l’écosystème.

Des modèles hybrides combinant des éléments centralisés et décentralisés pourraient émerger. Les entreprises peuvent utiliser les clouds traditionnels pour la capacité de base tout en basculant vers des réseaux décentralisés lors des pics de demande. Cette approche offre la prédictibilité des services managés tout en capturant les économies de coûts des alternatives distribuées pendant les périodes de surcharge.

Des réseaux de consortium pourraient se former, où des acteurs industriels exploitent conjointement une infrastructure décentralisée. Des entreprises d’IA, des fournisseurs de cloud, des fabricants de matériel ou des institutions académiques pourraient établir des réseaux partagés qui réduisent les besoins en capital individuel tout en maintenant une gouvernance décentralisée. Ce modèle pourrait accélérer l’adoption parmi les organisations averses au risque.

Une spécialisation verticale semble probable à mesure que les protocoles s’optimisent pour des cas d’usage spécifiques. Certains réseaux peuvent se concentrer exclusivement sur l’entraînement de modèles IA, d’autres sur l’inférence, certains sur l’edge computing, d’autres sur le rendu ou le calcul scientifique. Une infrastructure spécialisée sert mieux des exigences de charges de travail particulières que des alternatives généralistes.

L’intégration avec les outils et frameworks IA existants sera cruciale. Une compatibilité transparente avec les bibliothèques de machine learning populaires, les systèmes d’orchestration et les pipelines de déploiement réduit les frictions pour les développeurs. io.net supports Ray-native orchestration, reconnaissant que les développeurs préfèrent des workflows standardisés à des implémentations personnalisées propres à chaque protocole.

Les considérations de durabilité pourraient influencer de plus en plus la conception des protocoles. Des mécanismes de consensus économes en énergie, des incitations aux énergies renouvelables pour les opérateurs de nœuds, ou l’intégration de crédits carbone pourraient différencier les protocoles auprès des utilisateurs soucieux de l’environnement. À mesure que la consommation énergétique de l’IA est scrutée, les réseaux décentralisés pourraient positionner l’efficacité comme un avantage concurrentiel.

Media coverageet l’attention de la communauté crypto servent d’indicateurs avancés de la prise de conscience grand public. L’augmentation des discussions autour de certains protocoles, la hausse de l’intérêt dans les recherches en ligne ou la croissance des audiences sur les réseaux sociaux précèdent souvent une adoption plus large et une appréciation du prix des tokens. Cependant, les cycles de hype peuvent générer des signaux trompeurs, déconnectés de la croissance fondamentale.

Conclusion

Le financement d’infrastructures physiques (Physical Infrastructure Finance) représente l’évolution de la crypto vers la coordination de ressources informatiques réelles. En tokenisant la capacité de calcul, les protocoles PinFi créent des marchés où les GPU inactifs deviennent des actifs productifs générant du rendement via des charges de travail d’IA, du traitement en périphérie (edge) et des besoins d’infrastructures spécialisées.

La convergence entre la demande insatiable de puissance de calcul de l’IA et la capacité de la crypto à coordonner des systèmes distribués via des incitations économiques crée une proposition de valeur convaincante. GPU shortages affecting over 50% of generative AI companies démontrent la gravité des goulets d’étranglement liés à l’infrastructure. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 signalent la reconnaissance par le marché que des modèles distribués peuvent capter une offre latente.

Des protocoles comme Bittensor, Render, Akash et io.net démontrent des approches variées face au même défi fondamental : faire correspondre efficacement l’offre et la demande de calcul via une coordination permissionless basée sur la blockchain. Chaque réseau expérimente différents modèles de tokénomique, mécanismes de vérification et applications cibles, contribuant à un écosystème plus large qui explore l’espace de conception pour une infrastructure décentralisée.

Les implications s’étendent au‑delà de la crypto vers l’industrie de l’IA et l’infrastructure de calcul au sens large. L’accès démocratisé aux ressources GPU abaisse les barrières à l’innovation en IA. La réduction de la dépendance aux oligopoles de cloud centralisés introduit des dynamiques concurrentielles susceptibles d’améliorer les prix et l’accessibilité. De nouvelles classes d’actifs émergent, les tokens représentant une propriété dans une infrastructure productive plutôt qu’une pure spéculation.

Des défis significatifs subsistent. La fiabilité technique, les mécanismes de vérification, la viabilité économique, l’incertitude réglementaire et la concurrence de grands acteurs bien capitalisés constituent autant de risques. Tous les protocoles ne survivront pas, et de nombreux tokens pourraient s’avérer surévalués par rapport à leur utilité fondamentale. Mais l’intuition centrale qui porte le PinFi semble solide : une vaste capacité de calcul demeure inexploitée dans le monde, une demande massive existe pour l’infrastructure d’IA, et la coordination via blockchain peut faire correspondre ces courbes d’offre et de demande désalignées.

À mesure que la demande en IA continue d’exploser, la couche d’infrastructure qui alimente cette technologie deviendra de plus en plus critique. Que cette infrastructure reste concentrée entre les mains de quelques fournisseurs centralisés ou évolue vers des modèles de propriété distribuée coordonnés par des incitations crypto‑économiques pourrait définir le paysage concurrentiel du développement de l’IA pour la prochaine décennie.

Le financement d’infrastructures de demain pourrait ressembler moins au financement de projets traditionnel et davantage à des réseaux tokenisés de matériel distribué à l’échelle mondiale, où toute personne disposant d’un GPU peut devenir fournisseur d’infrastructure et où l’accès ne requiert aucune permission au‑delà d’un paiement au prix du marché. Cela représente une réinvention fondamentale de la manière dont les ressources de calcul sont possédées, exploitées et monétisées — une réinvention dans laquelle les protocoles crypto démontrent une utilité qui dépasse la spéculation financière en résolvant des problèmes tangibles dans le monde physique.