De kunstmatige‑intelligentiebranche kampt met een kritieke infrastructuurknoop. Het trainen van grote taalmodellen vereist enorme rekenkracht, edge‑apparaten nemen exponentieel toe en GPU‑schaarste is de bepalende beperking van het AI‑tijdperk geworden. Ondertussen hebben traditionele cloudproviders moeite om de snel stijgende vraag bij te benen en tegelijk hun monopolistische greep op toegang en prijszetting te behouden.

Over 50% van de generatieve‑AI‑bedrijven meldt GPU‑tekorten als een belangrijke belemmering voor het opschalen van hun activiteiten. Naar verwachting zal de AI‑rekenkracht tegen eind 2025 ongeveer 60 keer groter zijn dan in Q1 2023. Deze wapenwedloop op het gebied van rekenkracht heeft ruimte gecreëerd voor cryptoprotocols om een gedecentraliseerd alternatief voor te stellen.

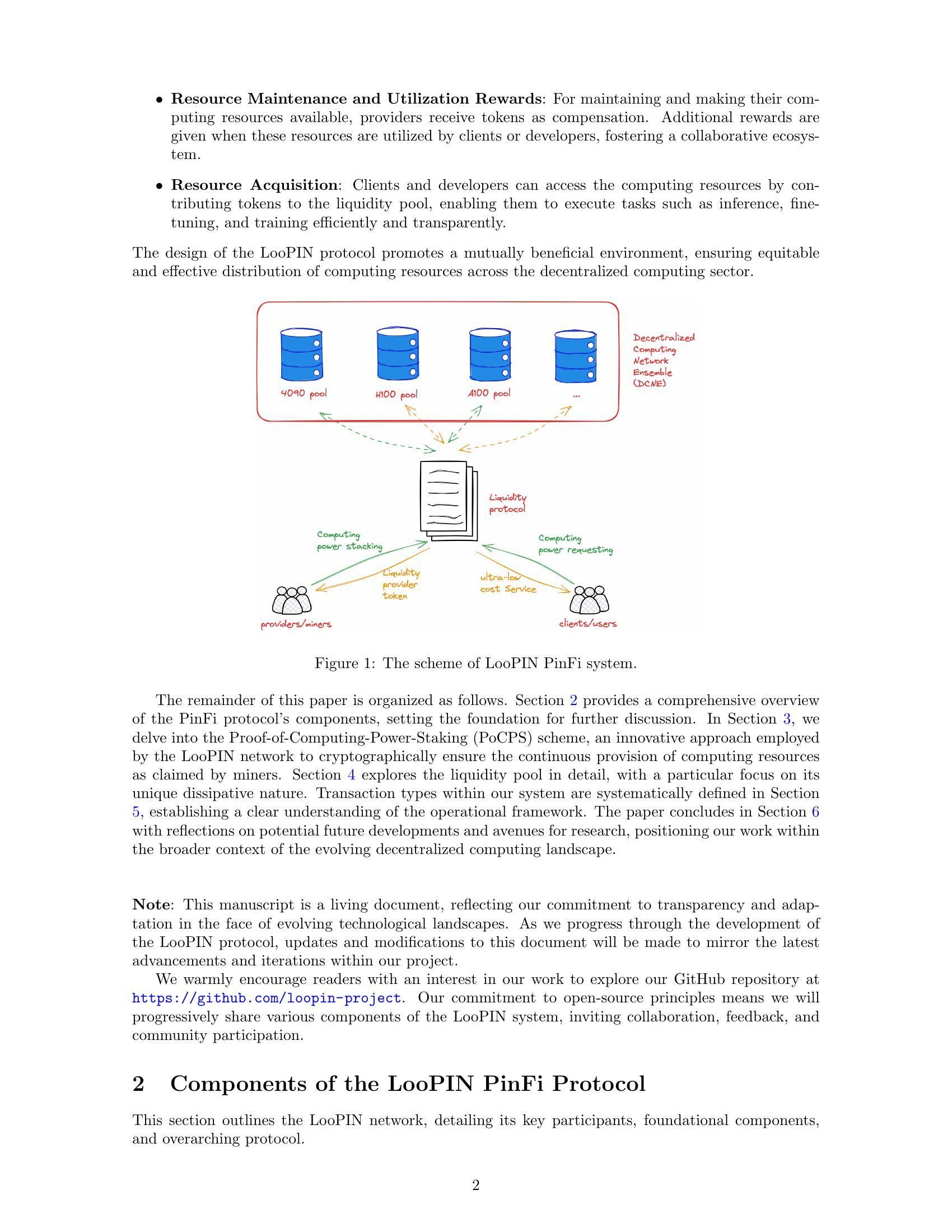

Hier komt Physical Infrastructure Finance, of PinFi, in beeld. Dit opkomende kader behandelt rekencapaciteit als een getokeniseerd activum dat verhandeld, gestaked en gemonetariseerd kan worden via blockchain‑netwerken. In plaats van te vertrouwen op gecentraliseerde datacenters, aggregeren PinFi‑protocollen ongebruikte GPU‑kracht van onafhankelijke operators, gaming‑rigs, miningfarms en edge‑apparaten in gedistribueerde marktplaatsen die wereldwijd toegankelijk zijn voor AI‑ontwikkelaars.

Hieronder verkennen we hoe echte rekenkracht wordt omgevormd tot crypto‑economische infrastructuur: we bekijken de werking van getokeniseerde rekennetwerken, de economische modellen die deelname stimuleren, de architectuur die verificatie en afwikkeling mogelijk maakt, en de implicaties voor zowel de crypto‑ als de AI‑sector.

Waarom PinFi nu? De macro‑ en technische drijfveren

De rekenknoop waar de AI‑sector mee te maken heeft, vloeit voort uit fundamentele aanbodbeperkingen. Nvidia wees in Q1 2025 bijna 60% van zijn chipproductie toe aan zakelijke AI‑klanten, waardoor veel gebruikers moeten vechten voor toegang. De wereldwijde AI‑chipmarkt bereikte in 2024 123,16 miljard dollar en zal naar verwachting oplopen tot 311,58 miljard dollar in 2029, wat de explosieve vraag weerspiegelt die de productiecapaciteit ruimschoots overstijgt.

GPU‑schaarste uit zich op meerdere manieren. Traditionele cloudproviders hanteren wachtlijsten voor premium GPU‑instances. AWS rekent 98,32 dollar per uur voor een H100‑instance met 8 GPU’s, een prijsstelling die geavanceerde AI‑mogelijkheden voor veel ontwikkelaars en startups onbereikbaar maakt. Hardwareprijzen blijven hoog door aanbodbeperkingen, met HBM3‑prijzen die jaar op jaar 20–30% stijgen.

De concentratie van rekenkracht bij een handvol grote cloudproviders zorgt voor extra wrijving. Tegen 2025 zal volgens analisten meer dan 50% van de bedrijfs‑workloads in de cloud draaien, maar de toegang blijft begrensd door contracten, geografische beperkingen en know‑your‑customer‑eisen. Deze centralisatie remt innovatie en creëert single points of failure voor kritieke infrastructuur.

Tegelijkertijd blijft een enorme hoeveelheid rekencapaciteit onbenut. Gaming‑rigs staan stil tijdens kantooruren. Cryptominers zoeken nieuwe inkomstenbronnen nu de mining‑economie verandert. Datacenters houden extra capaciteit aan tijdens daluren. De markt voor gedecentraliseerde rekenkracht groeide van 9 miljard dollar in 2024 tot projecties van 100 miljard dollar in 2032, een signaal dat de markt erkent dat gedistribueerde modellen dit slapende aanbod kunnen ontsluiten.

De kruising van blockchaintechnologie en fysieke infrastructuur is volwassen geworden via gedecentraliseerde fysieke‑infrastructuurnetwerken, of DePIN. DePIN‑protocollen gebruiken tokenprikkels om de uitrol en exploitatie van fysieke infrastructuur te coördineren. Messari schatte de totale adresseerbare markt van DePIN op 2,2 biljoen dollar, met een potentieel van 3,5 biljoen dollar tegen 2028.

PinFi is de toepassing van DePIN‑principes specifiek op rekeninfrastructuur. Het behandelt rekenbronnen als tokeniseerbare activa die rendement genereren via productief gebruik. Dit kader transformeert computing van een dienst die je huurt bij gecentraliseerde aanbieders tot een grondstof die verhandeld wordt op open, permissionless markten.

Wat is PinFi en getokeniseerde rekenkracht?

Physical Infrastructure Finance definieert een model waarbij fysieke rekenassets worden weergegeven als digitale tokens op blockchains, wat gedecentraliseerd eigendom, beheer en monetisatie mogelijk maakt. In tegenstelling tot traditionele decentralized‑finance‑protocollen die uitsluitend met digitale assets werken, slaat PinFi bruggen tussen off‑chain fysieke middelen en on‑chain economische systemen.

Academisch onderzoek definieert tokenisering als “het proces waarbij rechten, een eenheid van eigendom, schuld of zelfs een fysiek activum worden omgezet in een digitale token op een blockchain”. Voor rekenbronnen betekent dit dat afzonderlijke GPU’s, serverclusters of edge‑apparaten worden weergegeven door tokens die hun capaciteit, beschikbaarheid en gebruik bijhouden.

PinFi verschilt fundamenteel van standaard infrastructuurfinanciering of typische DeFi‑protocollen. Traditionele infrastructuurfinanciering omvat langlopende schuld‑ of aandeleninvesteringen in grote kapitaalprojecten. DeFi‑protocollen faciliteren vooral handel, leningen of rendement op crypto‑native assets. PinFi bevindt zich op het snijvlak: het past crypto‑economische prikkels toe om fysieke rekenbronnen te coördineren, terwijl afwikkeling en governance on‑chain blijven.

Verschillende protocollen illustreren het PinFi‑model. Bittensor opereert als een gedecentraliseerd AI‑netwerk waar deelnemers machine‑learningmodellen en rekenkracht bijdragen aan gespecialiseerde subnets die zich op specifieke taken richten. De TAO‑token beloont bijdragen op basis van de informatie‑waarde die zij toevoegen aan de collectieve intelligentie van het netwerk. Met meer dan 7.000 miners die rekenkracht leveren, creëert Bittensor markten voor AI‑inference en modeltraining.

Render Network aggregeert wereldwijd ongebruikte GPU’s voor gedistribueerde GPU‑rendering. Oorspronkelijk gericht op 3D‑rendering voor artiesten en contentmakers, is Render uitgebreid naar AI‑workloads. De RNDR‑token wordt gebruikt als betaling voor rendering‑opdrachten en beloont GPU‑aanbieders voor hun capaciteit.

Akash Network functioneert als een gedecentraliseerde cloudmarktplaats die ongebruikte datacentercapaciteit inzet. Via een omgekeerd veilingsysteem specificeren afnemers hun compute‑vereisten en bieden aanbieders om deze aanvragen te vervullen. De AKT‑token faciliteert governance, staking en afwikkeling binnen het netwerk. Akash zag een opmerkelijke stijging in het aantal actieve leases per kwartaal nadat het zijn focus uitbreidde met GPU’s naast traditionele CPU‑bronnen.

io.net heeft meer dan 300.000 geverifieerde GPU’s geaggregeerd door middelen van onafhankelijke datacenters, cryptominers en andere DePIN‑netwerken zoals Render en Filecoin te integreren. Het platform richt zich specifiek op AI‑ en machine‑learningworkloads en biedt ontwikkelaars de mogelijkheid om binnen enkele minuten GPU‑clusters uit te rollen in 130 landen.

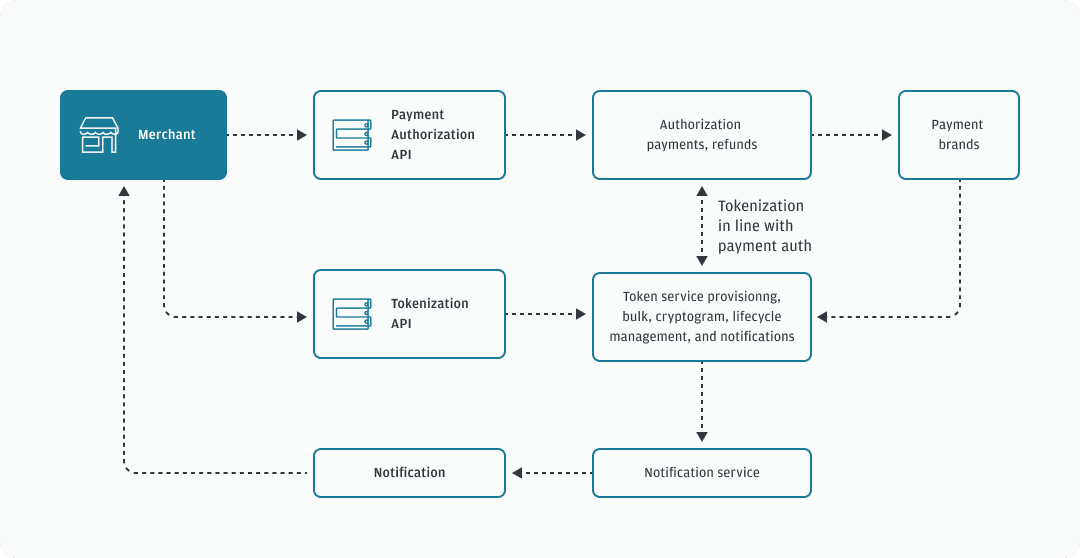

De werking van getokeniseerde rekenkracht volgt een consistent patroon over deze protocollen heen. Compute‑aanbieders registreren hun hardware bij het netwerk en doorlopen verificatieprocessen om capaciteit en mogelijkheden te bevestigen. Smart contracts beheren de relatie tussen vraag en aanbod en routeren taken naar beschikbare nodes op basis van vereisten, prijs en geografische beperkingen. Tokenbeloningen stimuleren zowel het leveren van hardware als het bieden van kwalitatieve dienstverlening.

Waardegeneratie vindt plaats via daadwerkelijk gebruik in plaats van louter speculatie. Wanneer een AI‑ontwikkelaar een model traint met gedistribueerde GPU‑bronnen, stroomt de betaling naar de aanbieders wiens hardware het werk heeft verricht. De rekenkracht wordt zo een productief activum dat rendement oplevert, vergelijkbaar met hoe proof‑of‑stake‑validators beloningen ontvangen voor het beveiligen van netwerken. Dit creëert een duurzaam economisch model waarbij de tokenwaarde correleert met het nut van het netwerk.

Infrastructuurarchitectuur: nodes, marktplaatsen, afwikkeling

De architectuur die getokeniseerde rekenkracht mogelijk maakt, vereist coördinatie over meerdere lagen. Aan de basis bevindt zich een netwerk van onafhankelijke compute‑aanbieders die hardware uitrollen, zich registreren bij protocollen en capaciteit beschikbaar stellen voor verhuur. Deze aanbieders variëren van individuen met game‑pc’s tot professionele datacenteroperators en cryptominingbedrijven die extra inkomsten zoeken.

Het inrichten van nodes begint wanneer een compute‑aanbieder zijn hardware met het netwerk verbindt. Protocollen zoals io.net ondersteunen uiteenlopende GPU‑typen, van consumentenkaarten zoals NVIDIA RTX 4090 tot enterprise‑GPU’s zoals H100’s en A100’s. De aanbieder installeert clientsoftware die de capaciteit blootlegt aan de orkestratielaag van het netwerk, terwijl de beveiligingsgrenzen behouden blijven die ongeautoriseerde toegang voorkomen.

Verificatiemechanismen zorgen ervoor dat de geadverteerde capaciteit overeenkomt met de werkelijke mogelijkheden. Sommige protocollen gebruiken cryptografische proofs of compute, waarbij nodes moeten aantonen dat zij specifieke berekeningen correct hebben uitgevoerd. Bittensor uses its Yuma Consensus mechanism, waarbij validators de kwaliteit van de machinelearning‑outputs van miners beoordelen en scores toekennen die de beloningsverdeling bepalen. Nodes die resultaten van lage kwaliteit leveren of proberen te valsspelen, krijgen minder compensatie of worden geconfronteerd met het slashen van hun gestakete tokens.

Latency‑benchmarking helpt om workloads te koppelen aan geschikte hardware. AI‑inference vereist andere prestatiekenmerken dan modeltraining of 3D‑rendering. De geografische locatie beïnvloedt de latency voor edge‑computingtoepassingen waarbij verwerking dicht bij de databronnen moet plaatsvinden. The edge computing market reached $23.65 billion in 2024 en zal naar verwachting $327,79 miljard bereiken tegen 2033, gedreven door de vraag naar gelokaliseerde verwerking.

De marketplacelaag verbindt compute‑vraag met aanbod. Wanneer ontwikkelaars GPU‑resources nodig hebben, specificeren ze vereisten zoals rekenkracht, geheugen, duur en maximale prijs. Akash employs a reverse auction model waarbij deployers voorwaarden vastleggen en providers bieden om contracten te winnen. Render uses dynamic pricing algorithms die tarieven aanpassen op basis van netwerkbenutting en marktomstandigheden.

Job‑routingalgoritmen optimaliseren de plaatsing van computetaken over beschikbare nodes. Factoren die worden meegewogen zijn onder meer hardwarespecificaties, huidige benutting, geografische nabijheid, historische prestaties en prijs. io.net's orchestration layer verwerkt gecontaineriseerde workflows en ondersteunt Ray‑native orkestratie voor gedistribueerde machinelearning‑workloads.

Afwikkeling vindt on‑chain plaats via smart contracts die betalingen in escrow houden en fondsen vrijgeven na geverifieerde voltooiing van het werk. Deze trustless settlement elimineert tegenpartijrisico en maakt microtransacties mogelijk voor computetaken met korte duur. Protocols built on high-throughput blockchains like Solana kunnen het transactievolume verwerken dat wordt gegenereerd door duizenden gelijktijdige inference‑verzoeken.

Stakingmechanismen stemmen de prikkels van deelnemers op elkaar af. Compute‑providers staken vaak tokens om hun betrokkenheid te tonen en onderpand bloot te stellen dat kan worden geslashed bij slechte prestaties. Validators in Bittensor stake TAO tokens om invloed te krijgen bij het scoren van miners en delen van blockbeloningen te verdienen. Tokenhouders kunnen stake delegeren aan validators die zij vertrouwen, vergelijkbaar met proof‑of‑stake‑consensusmechanismen.

Governance stelt tokenhouders in staat te stemmen over protocolparameters, waaronder beloningsverdeling, vergoedingsstructuren en netwerkupgrades. Decentralized governance zorgt ervoor dat geen enkele centrale autoriteit eenzijdig regels kan wijzigen of toegang kan beperken, waardoor de permissionless‑aard behouden blijft die deze netwerken onderscheidt van traditionele cloudproviders.

De architectuur staat in scherp contrast met gecentraliseerde cloud computing. Grote providers bezitten hun infrastructuur, stellen prijzen vast zonder marktconcurrentie, vereisen accounts en compliance‑controles, en behouden de controle over toegang en censuur. PinFi‑protocollen verdelen eigendom over duizenden onafhankelijke operators, maken transparante marktgebaseerde prijsstelling mogelijk, werken permissionless en weerstaan censuur via decentralisatie.

Tokenomics & Incentive Models

Tokeneconomie biedt de prikkelstructuur die gedistribueerde computenetwerken coördineert. Native tokens vervullen meerdere functies, waaronder betaling voor diensten, beloningen voor het leveren van resources, governance‑rechten en stakingvereisten voor netwerkdeelname.

Uitgiftemechanismen bepalen hoe tokens in omloop komen. Bittensor follows Bitcoin's model with a capped supply of 21 million TAO tokens en periodieke halvings die de uitgifte in de loop van de tijd verminderen. Currently 7,200 TAO are minted daily, verdeeld tussen miners die rekenresources leveren en validators die de netwerkkwaliteit bewaken. Dit creëert een schaarste vergelijkbaar met Bitcoin, terwijl inflatie wordt gericht op productieve infrastructuur.

Andere protocollen geven tokens uit op basis van netwerkgebruik. Wanneer computetaken worden uitgevoerd, vloeien nieuw geslagen tokens naar providers in verhouding tot de resources die zij hebben geleverd. Deze directe koppeling tussen waardecreatie en tokenuitgifte zorgt ervoor dat inflatie daadwerkelijke productiviteit beloont in plaats van passief tokenbezit.

Staking creëert “skin in the game” voor netwerkdeelnemers. Compute‑providers staken tokens om nodes te registreren en hun betrokkenheid aan te tonen. Slechte prestaties of poging tot fraude leiden tot slashing, waarbij gestakete tokens worden vernietigd of herverdeeld naar benadeelde partijen. Deze economische straf stimuleert betrouwbare dienstverlening en eerlijk gedrag.

Validators staken grotere hoeveelheden om invloed te krijgen bij kwaliteitsbeoordeling en governance‑beslissingen. In Bittensor's model, validators evaluate miners' outputs en dienen weight‑matrices in die aangeven welke nodes waardevolle bijdragen hebben geleverd. De Yuma Consensus aggregeert deze beoordelingen, gewogen naar validator‑stake, om de uiteindelijke beloningsverdeling te bepalen.

Het vraag‑en‑aanbodmechanisme voor compute‑tokens werkt op twee niveaus. Aan de aanbodzijde verhogen meer nodes in het netwerk de beschikbare rekencapaciteit. Tokenbeloningen moeten voldoende zijn om hardwarekosten, elektriciteit en opportuniteitskosten ten opzichte van alternatieve inzet van de apparatuur te dekken. Naarmate tokenprijzen stijgen, wordt het leveren van compute winstgevender, waardoor extra aanbod wordt aangetrokken.

Aan de vraagzijde weerspiegelt de tokenprijs de waarde die gebruikers hechten aan netwerktoegang. Naarmate AI‑toepassingen zich vermenigvuldigen en de schaarsheid van compute toeneemt, stijgt de bereidheid om te betalen voor gedecentraliseerde resources. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034, wat een aanhoudende vraag naar alternatieve computebronnen creëert.

Tokenwaardestijging komt alle deelnemers ten goede. Hardwareproviders verdienen meer voor dezelfde rekenoutput. Vroege node‑operators profiteren van de waardestijging van hun verzamelde beloningen. Ontwikkelaars profiteren van een gedecentraliseerd alternatief voor dure gecentraliseerde providers. Tokenhouders die staken of liquiditeit verschaffen, vangen fees op uit netwerkactiviteit.

Risicomodellen richten zich op potentiële faalmodi. Node‑downtime verlaagt inkomsten doordat taken worden gerouteerd naar beschikbare alternatieven. Geografische concentratie veroorzaakt latency‑problemen voor edge‑toepassingen die lokale verwerking vereisen. Netwerkeffecten bevoordelen grotere protocollen met meer diverse hardware en geografische spreiding.

Tokeninflatie moet het aantrekken van nieuw aanbod in balans brengen met het behoud van waarde voor bestaande houders. Research on decentralized infrastructure protocols merkt op dat houdbare tokenomics vereist dat vraaggroei het aanbodtempo overtreft. Protocollen implementeren burn‑mechanismen, waarbij tokens die voor betalingen worden gebruikt permanent uit omloop worden gehaald, wat deflatoire druk creëert die inflatoire uitgifte compenseert.

Vergoedingsstructuren verschillen per netwerk. Sommige rekenen gebruikers rechtstreeks af in native tokens. Andere accepteren stablecoins of wrapped versies van grote cryptovaluta’s, waarbij protocoltokens voornamelijk dienen voor governance en staking. Hybride modellen gebruiken tokens voor netwerktoegang, terwijl compute‑betalingen in stabiele assets worden afgerekend om volatiliteitsrisico te verminderen.

De ontwerpruimte voor incentivemodellen blijft zich ontwikkelen naarmate protocollen experimenteren met verschillende benaderingen om belangen van stakeholders in balans te brengen en duurzame langetermijngroei te ondersteunen.

AI, Edge, and Real-World Infrastructure

Getokeniseerde computenetwerken maken toepassingen mogelijk die gebruikmaken van gedistribueerde hardware voor AI‑workloads, edge‑verwerking en gespecialiseerde infrastructuurbehoeften. De diversiteit aan use‑cases laat zien hoe gedecentraliseerde modellen knelpunten in de hele computationele stack kunnen aanpakken.

Gedistribueerde AI‑modeltraining vormt een primaire use‑case. Het trainen van grote taalmodellen of computervisionsystemen vereist massale parallelle berekening over meerdere GPU’s. Traditionele benaderingen concentreren deze training in gecentraliseerde datacenters die eigendom zijn van grote cloudproviders. Gedecentraliseerde netwerken maken het mogelijk om training uit te voeren over geografisch verspreide nodes, die elk rekenwerk leveren dat wordt gecoördineerd via blockchain‑gebaseerde orkestratie.

Bittensor's subnet architecture maakt gespecialiseerde AI‑markten mogelijk die zich richten op specifieke taken zoals tekstgeneratie, beeldsynthese of datascraping. Miners strijden om hoogwaardige outputs te leveren binnen hun gekozen domeinen, terwijl validators prestaties beoordelen en beloningen dienovereenkomstig verdelen. Dit creëert competitieve markten waarin de beste modellen en meest efficiënte implementaties zich op natuurlijke wijze door economische selectie manifesteren.

Edge‑computingworkloads profiteren in het bijzonder van gedecentraliseerde infrastructuur. The global edge computing market was valued at $23.65 billion in 2024, gedreven door toepassingen die low latency en lokale verwerking. IoT-apparaten die continue sensorgegevens genereren, hebben onmiddellijke analyse nodig zonder rondereisvertragingen naar verre datacenters. Autonome voertuigen vereisen beslissingen in splitseconden die geen netwerkvertraging dulden.

Gedecentraliseerde rekennetwerken kunnen reken capaciteit fysiek dicht bij de databronnen plaatsen. Een fabriek die industriële IoT-sensoren inzet, kan edge-nodes huren binnen dezelfde stad of regio in plaats van te vertrouwen op gecentraliseerde clouds honderden mijlen verderop. Industrial IoT applications accounted for the largest market share in edge computing in 2024, wat de kritieke rol van lokale verwerking voor productie en logistiek weerspiegelt.

Content rendering en creatieve workflows verbruiken aanzienlijke GPU-resources. Artiesten die 3D-scènes renderen, animatoren die films produceren en game-ontwikkelaars die assets compileren, hebben allemaal intensieve parallelle verwerking nodig. Render Network specializes in distributed GPU rendering, en verbindt makers met ongebruikte GPU-capaciteit wereldwijd. Dit marktplaatsmodel verlaagt de renderkosten en biedt tegelijkertijd inkomstenstromen voor GPU-eigenaren tijdens daluren.

Wetenschappelijke computing en onderzoekstoepassingen worden geconfronteerd met budgetbeperkingen bij het gebruik van dure cloudresources. Academische instellingen, onafhankelijke onderzoekers en kleinere organisaties kunnen gedecentraliseerde netwerken benutten om simulaties uit te voeren, datasets te analyseren of gespecialiseerde modellen te trainen. De permissionless aard betekent dat onderzoekers in elke regio toegang kunnen krijgen tot rekenresources zonder institutionele cloudaccounts of kredietcontroles.

Gaming- en metaverse-platforms vereisen rendering- en fysicaberekeningen voor meeslepende ervaringen. Naarmate virtuele werelden complexer worden, nemen de rekenvereisten voor het onderhouden van persistente omgevingen en het ondersteunen van duizenden gelijktijdige gebruikers toe. Edge-gedistribueerde rekennodes kunnen lokale verwerking leveren voor regionale spelerspopulaties, waardoor latency wordt verminderd en de infrastructuurkosten worden verdeeld over token-gestimuleerde aanbieders.

AI-inferentie op schaal vereist continue GPU-toegang voor het leveren van voorspellingen uit getrainde modellen. Een chatbot die miljoenen queries bedient, een afbeeldingsgeneratieservice die gebruikersprompts verwerkt of een aanbevelingsengine die gebruikersgedrag analyseert, hebben allemaal altijd-beschikbare compute nodig. Gedecentraliseerde netwerken bieden redundantie en geografische spreiding die de betrouwbaarheid verbetert ten opzichte van afhankelijkheid van één aanbieder.

Geografische zones die onderbediend zijn door grote cloudproviders bieden kansen voor PinFi-protocollen. Regio’s met beperkte datacenteraanwezigheid worden geconfronteerd met hogere latency en kosten bij toegang tot gecentraliseerde infrastructuur. Lokale hardwareaanbieders in deze gebieden kunnen reken capaciteit aanbieden die is afgestemd op regionale vraag, tokenbeloningen verdienen en tegelijkertijd de lokale toegang tot AI-mogelijkheden verbeteren.

Vereisten rond datasoevereiniteit schrijven in toenemende mate voor dat bepaalde workloads gegevens binnen specifieke jurisdicties verwerken. Regulations like the EU Data Act require sensitive information to be processed locally, wat stimuleert dat edge-infrastructuur wordt ingezet die voldoet aan regels rond dataresidentie. Gedecentraliseerde netwerken ondersteunen van nature node-implementatie per jurisdictie, terwijl ze wereldwijde coördinatie behouden via blockchain-gebaseerde afwikkeling.

Waarom Het Belangrijk Is: Gevolgen voor Crypto & Infrastructuur

De opkomst van PinFi vertegenwoordigt de uitbreiding van crypto voorbij puur financiële toepassingen naar de coördinatie van fysieke infrastructuur in de echte wereld. Deze verschuiving heeft gevolgen voor zowel het crypto-ecosysteem als de bredere rekenindustrieën.

Cryptoprotocollen tonen nut voorbij speculatie wanneer ze tastbare infrastructuurproblemen oplossen. DePIN en PinFi creëren economische systemen die fysieke resources coördineren en bewijzen dat blockchain-gebaseerde prikkels echte netwerken kunnen bootstrappen. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, wat neerkomt op ongeveer drie keer de totale cryptomarktkapitalisatie van vandaag.

Democratisering van toegang tot compute pakt een fundamentele asymmetrie in AI-ontwikkeling aan. Momenteel blijven geavanceerde AI-capaciteiten grotendeels geconcentreerd bij goed gefinancierde technologiebedrijven die zich enorme GPU-clusters kunnen veroorloven. Startups, onderzoekers en ontwikkelaars in omgevingen met beperkte middelen ondervinden barrières om deel te nemen aan AI-innovatie. Gedecentraliseerde rekennetwerken verlagen deze drempels door permissionless toegang te bieden tot gedistribueerde hardware tegen marktgestuurde prijzen.

De creatie van nieuwe activaklassen breidt het crypto-investeringslandschap uit. Tokens die reken capaciteit vertegenwoordigen, vormen eigendom in productieve infrastructuur die inkomsten genereert via gebruik in de echte wereld. Dit verschilt van puur speculatieve assets of governance-tokens zonder duidelijke mechanismen voor waardeacquisitie. Tokenhouders bezitten in feite aandelen van een gedecentraliseerde cloudprovider, waarbij de waarde is gekoppeld aan de vraag naar rekenservices.

Traditionele infrastructuurmonopolies worden mogelijk ontwricht. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control over rekenmarkten en bepalen prijzen zonder directe concurrentie. Gedecentraliseerde alternatieven introduceren marktdynamiek waarbij duizenden onafhankelijke aanbieders concurreren, wat de kosten mogelijk drukt en de toegankelijkheid verbetert.

De AI-industrie profiteert van verminderde afhankelijkheid van gecentraliseerde infrastructuur. Momenteel concentreert AI-ontwikkeling zich rond grote cloudproviders, wat single points of failure en concentratierisico creëert. Over 50% of generative AI companies report GPU shortages as major obstacles. Gedistribueerde netwerken bieden alternatieve capaciteit die vraagpieken kan opvangen en redundantie kan bieden tegen verstoringen in de toeleveringsketen.

Verbeteringen in energie-efficiëntie kunnen voortkomen uit betere capaciteitsbenutting. Gamingrigs die stilzitten, verbruiken standby-vermogen zonder productieve output. Miningoperaties met overcapaciteit zoeken extra inkomstenstromen. Distributed networks put idle GPUs to productive use, wat de algehele resource-efficiëntie in het computationele ecosysteem verbetert.

Censuurbestendigheid wordt relevant voor AI-toepassingen. Gecentraliseerde cloudproviders kunnen service weigeren aan specifieke gebruikers, applicaties of hele geografische regio’s. Gedecentraliseerde netwerken werken permissionless en maken AI-ontwikkeling en -implementatie mogelijk zonder goedkeuring van poortwachters. Dit is met name belangrijk voor controversiële toepassingen of gebruikers in restrictieve jurisdicties.

Dataprivacy-architecturen verbeteren door lokale verwerking. Edge computing keeps sensitive data near its source in plaats van het te verzenden naar verre datacenters. Gedecentraliseerde netwerken kunnen privacybeschermende technieken implementeren, zoals federated learning, waarbij modellen trainen op gedistribueerde data zonder ruwe informatie te centraliseren.

Marktefficiëntie neemt toe door transparante prijsvorming. Traditionele cloudprijzen blijven ondoorzichtig, met complexe kostenstructuren en onderhandelde enterprisecontracten. Gedecentraliseerde marktplaatsen stellen duidelijke spotprijzen vast voor rekenresources, waardoor ontwikkelaars kosten kunnen optimaliseren en aanbieders inkomsten kunnen maximaliseren via competitieve dynamiek.

Langetermijnrelevantie vloeit voort uit aanhoudende vraagdrijvers. AI-workloads zullen blijven groeien naarmate toepassingen zich vermenigvuldigen. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Compute zal een fundamentele beperkende factor blijven, wat voortdurende vraag naar alternatieve infrastructuurmodellen verzekert.

Netwerkeffecten bevoordelen vroege protocollen die kritieke massa bereiken. Naarmate meer hardwareaanbieders toetreden, neemt de diversiteit van beschikbare resources toe. Geografische spreiding verbetert, waardoor de latency voor edge-toepassingen afneemt. Grotere netwerken trekken meer ontwikkelaars aan, wat virtuous cycles van groei creëert. First-movers in specifieke domeinen kunnen duurzame voordelen opbouwen.

Uitdagingen & Risico’s

Ondanks veelbelovende toepassingen worden getokeniseerde rekennetwerken geconfronteerd met aanzienlijke technische, economische en regelgevende uitdagingen die groei kunnen beperken of adoptie kunnen remmen.

Technische betrouwbaarheid blijft een primaire zorg. Gecentraliseerde cloudproviders bieden service level agreements die uptime en performance garanderen. Gedistribueerde netwerken coördineren hardware van onafhankelijke operators met uiteenlopende niveaus van professionaliteit en infrastructuurkwaliteit. Node-uitval, netwerkstoringen of onderhoudsvensters creëren beschikbaarheidsgaten die moeten worden beheerd met redundantie en routeringsalgoritmen.

Verificatie van het daadwerkelijk geleverde werk vormt een voortdurende uitdaging. Zorgen dat nodes berekeningen eerlijk uitvoeren in plaats van valse resultaten terug te sturen, vereist geavanceerde bewijssystemen. Cryptographic proofs of compute voegen overhead toe, maar blijven noodzakelijk om fraude te voorkomen. Onvolmaakte verificatiemechanismen maken potentiële aanvallen mogelijk waarbij kwaadwillende nodes beloningen claimen zonder de beloofde diensten te leveren.

Latency- en bandbreedtebeperkingen beïnvloeden gedistribueerde workloads. [Running computations across geographically dispersed locations can cause vertragingen vergeleken met co-geplaatste hardware in één enkel datacenter. De netwerkbandbreedte tussen nodes beperkt de soorten workloads die geschikt zijn voor gedistribueerde verwerking. Strak gekoppelde parallelle berekeningen die frequente communicatie tussen nodes vereisen, ondervinden prestatieverlies.

Variabiliteit in kwaliteit van dienstverlening creëert onzekerheid voor productieapplicaties. In tegenstelling tot beheerde cloudomgevingen met voorspelbare prestaties, zorgen heterogene hardwarepools voor inconsistente resultaten. Een trainingsrun kan worden uitgevoerd op enterprise-grade H100’s of consumentgerichte RTX-kaarten, afhankelijk van beschikbaarheid. Applicatieontwikkelaars moeten op deze variabiliteit ontwerpen of filtering implementeren die jobs beperkt tot specifieke hardwarelagen.

Economische duurzaamheid vereist het in balans brengen van groeisnelheid van het aanbod met de uitbreiding van de vraag. Een snelle toename van beschikbare rekencapaciteit zonder overeenkomstige vraaggroei zou tokenprijzen drukken en de winstgevendheid van aanbieders verminderen. Protocollen moeten de tokenuitgifte zorgvuldig beheren om inflatie te voorkomen die de groei in nut overstijgt. Duurzame tokenomics vereist dat de vraaggroei de toename van het aanbod overtreft.

Compressie van tokenwaarde vormt risico’s voor langetermijndeelnemers. Naarmate nieuwe providers zich bij netwerken aansluiten om beloningen te verdienen, drijft de toegenomen concurrentie de verdiensten per node omlaag. Vroege deelnemers die profiteren van hogere initiële beloningen kunnen hun rendement in de loop van de tijd zien afnemen. Als tokenappreciatie deze verwatering niet compenseert, neemt het verloop onder providers toe en lijdt de netwerkstabiliteit daaronder.

Marktvolatiliteit introduceert financieel risico voor deelnemers. Providers verdienen beloningen in native tokens waarvan de waarde fluctueert. Een hardware-operator kan kapitaal investeren in GPU-aankopen in de verwachting dat tokenprijzen stabiel blijven, om vervolgens verliezen te lijden als prijzen dalen. Hedgingmechanismen en stablecoin-betalingsopties kunnen volatiliteit beperken maar voegen complexiteit toe.

Regulatoire onzekerheid rond tokenclassificaties creëert nalevingsuitdagingen. Effectentoezichthouders in verschillende rechtsgebieden beoordelen of compute-tokens kwalificeren als effecten die aan registratievereisten onderworpen zijn. Een ambigue juridische status beperkt institutionele deelname en creëert aansprakelijkheidsrisico’s voor protocolontwikkelaars. Tokenisering van infrastructuur wordt geconfronteerd met onduidelijkheden in de regelgeving die de adoptie hebben beperkt in vergelijking met traditionele financiële structuren.

Regels voor gegevensbescherming leggen vereisten op waaraan gedistribueerde netwerken moeten voldoen. Het verwerken van gegevens van Europese burgers vereist AVG-naleving, waaronder dataminimalisatie en rechten op verwijdering. Toepassingen in de gezondheidszorg moeten voldoen aan HIPAA-vereisten. Financiële toepassingen hebben te maken met verplichtingen rond het voorkomen van witwassen van geld. Gedecentraliseerde netwerken bemoeilijken naleving wanneer gegevens zich verplaatsen over meerdere rechtsgebieden en onafhankelijke operators.

Hardwarebijdragen kunnen regulatoire aandacht trekken, afhankelijk van hoe regelingen zijn gestructureerd. Rechtsgebieden kunnen bepaalde providerrelaties classificeren als effectenuitgiften of gereguleerde financiële producten. De grens tussen infrastructuurvoorziening en investeringscontracten blijft in veel juridische kaders onduidelijk.

Concurrentie van hyperscale cloudproviders blijft intensiveren. Grote providers investeren miljarden in nieuwe datacentercapaciteit en op maat gemaakte AI-accelerators. AWS, Microsoft en Google gaven in 2024 36% meer uit aan kapitaaluitgaven, grotendeels voor AI-infrastructuur. Deze goed gekapitaliseerde incumbents kunnen prijzen onderbieden of compute bundelen met andere diensten om marktaandeel te behouden.

Netwerkfragmentatie kan de composabiliteit beperken. Meerdere concurrerende protocollen creëren gesiloode ecosystemen waarin rekenmiddelen niet eenvoudig tussen netwerken kunnen worden overgedragen. Gebrek aan standaardisatie in API’s, verificatiemechanismen of tokenstandaarden verlaagt de efficiëntie en verhoogt de overstapkosten voor ontwikkelaars.

Risico voor early adopters treft protocollen zonder bewezen trackrecord. Nieuwe netwerken kampen met kip-en-ei-problemen bij het gelijktijdig aantrekken van zowel hardwareproviders als compute-afnemers. Protocollen kunnen er niet in slagen de kritieke massa te bereiken die nodig is voor duurzame operaties. Tokeninvesteerders lopen het risico op volledig verlies als netwerken instorten of geen adoptie weten te realiseren.

Beveiligingskwetsbaarheden in smart contracts of coördinatielagen kunnen diefstal van fondsen of verstoring van het netwerk mogelijk maken. Gedecentraliseerde netwerken worden geconfronteerd met beveiligingsuitdagingen die zorgvuldige smart contract-audits en bug bounty-programma’s vereisen. Exploits die schatkisten leegtrekken of dubbele betalingen mogelijk maken, schaden het vertrouwen en de netwerkwaarde.

De weg vooruit & wat in de gaten te houden

Het volgen van kernstatistieken en ontwikkelingen biedt inzicht in de volwassenwording en groeitrajecten van getokeniseerde computenetwerken.

Indicatoren voor netwerkgroei omvatten het aantal actieve computenodes, geografische spreiding, hardwarediversiteit en de totale beschikbare capaciteit gemeten in rekenkracht of GPU-equivalenten. Groei in deze statistieken duidt op toenemend aanbod en netwerkresistentie. io.net verzamelde meer dan 300.000 geverifieerde GPU’s door meerdere bronnen te integreren, wat het snelle schaalpotentieel aantoont wanneer protocollen uiteenlopende middelen effectief coördineren.

Gebruiksstatistieken tonen de daadwerkelijke vraag naar gedecentraliseerde compute. Actieve computejobs, totaal geleverde verwerkingsuren en de mix van workloadtypen laten zien of netwerken echte toepassingen bedienen buiten speculatie. Akash zag een opvallende stijging in het aantal per kwartaal actieve leases na uitbreiding van GPU-ondersteuning, wat wijst op marktinteresse in gedecentraliseerde alternatieven voor traditionele clouds.

Token-marktkapitalisatie en volledig verwaterde waarderingen bieden marktinschattingen van protocolwaarde. Het vergelijken van waarderingen met daadwerkelijke omzet of computecapaciteit onthult of tokens toekomstige groeiverwachtingen inprijzen of de huidige utiliteit weerspiegelen. Bittensors TAO-token bereikte $750 tijdens de piekhype in maart 2024, wat speculatieve interesse illustreert naast daadwerkelijke adoptie.

Partnerschappen met AI-bedrijven en zakelijke gebruikers vormen signalen van mainstream-validatie. Wanneer gevestigde AI-labs, modelontwikkelaars of productieapplicaties workloads op gedecentraliseerde netwerken uitrollen, toont dat aan dat gedistribueerde infrastructuur voldoet aan vereisten in de echte wereld. Toyota en NTT kondigden een investering van $3,3 miljard aan in een Mobility AI-platform met edge computing, wat de bedrijfsmatige toewijding aan gedistribueerde architecturen laat zien.

Protocolupgrades en nieuwe functies wijzen op aanhoudend ontwikkelmomentum. Integratie van nieuwe GPU-typen, verbeterde orkestratiesystemen, geavanceerde verificatiemechanismen of governance-verbeteringen tonen actieve iteratie richting betere infrastructuur. Bittensors Dynamic TAO-upgrade in 2025 verschoof meer beloningen naar hoog presterende subnetten, wat adaptieve tokenomics demonstreert.

Regulatoire ontwikkelingen bepalen de operationele omgeving. Een gunstige classificatie van infrastructuurtokens of duidelijke richtlijnen rond nalevingsvereisten zouden juridische onzekerheid verminderen en bredere institutionele deelname mogelijk maken. Omgekeerd kunnen restrictieve regels de groei in specifieke rechtsgebieden beperken.

Concurrentiedynamiek tussen protocollen bepaalt de marktstructuur. De markt voor compute-infrastructuur kan consolideren rond enkele dominante netwerken met sterke netwerkeffecten, of gefragmenteerd blijven met gespecialiseerde protocollen die verschillende niches bedienen. Interoperabiliteitsstandaarden kunnen coördinatie tussen netwerken mogelijk maken, wat de algehele efficiëntie van het ecosysteem verbetert.

Hybride modellen die gecentraliseerde en gedecentraliseerde elementen combineren kunnen ontstaan. Ondernemingen kunnen traditionele clouds gebruiken voor basiscapaciteit en uitwijken naar gedecentraliseerde netwerken tijdens piekvraag. Deze aanpak biedt de voorspelbaarheid van beheerde diensten terwijl kostenbesparingen van gedistribueerde alternatieven tijdens piekperioden worden benut.

Consortiumnetwerken zouden kunnen ontstaan waarbij marktpartijen gezamenlijk gedecentraliseerde infrastructuur exploiteren. AI-bedrijven, cloudproviders, hardwarefabrikanten of academische instellingen zouden gedeelde netwerken kunnen opzetten die de individuele kapitaalvereisten verlagen terwijl gedecentraliseerd bestuur behouden blijft. Dit model zou de adoptie onder risicomijdende organisaties kunnen versnellen.

Verticale specialisatie lijkt waarschijnlijk naarmate protocollen optimaliseren voor specifieke use cases. Sommige netwerken richten zich mogelijk uitsluitend op AI-training, andere op inferentie, sommige op edge computing, weer andere op rendering of wetenschappelijke berekeningen. Gespecialiseerde infrastructuur bedient bepaalde workloadvereisten beter dan generieke alternatieven.

Integratie met bestaande AI-tools en -frameworks zal cruciaal blijken. Naadloze compatibiliteit met populaire machinelearningbibliotheken, orkestratiesystemen en uitrolpijplijnen vermindert frictie voor ontwikkelaars. io.net ondersteunt Ray-native orkestratie, in het besef dat ontwikkelaars gestandaardiseerde workflows verkiezen boven protocoolspecifieke maatwerkimplementaties.

Duurzaamheidsoverwegingen kunnen in toenemende mate het protocolontwerp beïnvloeden. Energie-efficiënte consensusmechanismen, prikkels voor node-operators om hernieuwbare energie te gebruiken of integratie van koolstofkredieten kunnen protocollen onderscheiden die aantrekkelijk zijn voor milieubewuste gebruikers. Nu het energieverbruik van AI steeds meer onder de loep ligt, zouden gedecentraliseerde netwerken efficiëntie kunnen positioneren als concurrentievoordeel.

Mediaberichtgevingen de aandacht van de cryptogemeenschap fungeren als leidende indicatoren van mainstream bewustzijn. Toegenomen discussie over specifieke protocollen, stijgende zoekinteresse of een groeiend socialmedia‑volgersaantal gaat vaak vooraf aan bredere adoptie en koersstijging van tokens. Hypecycli kunnen echter misleidende signalen creëren die losstaan van fundamentele groei.

Conclusie

Physical Infrastructure Finance vertegenwoordigt de evolutie van crypto naar de coördinatie van reële, fysieke computationele middelen. Door rekenkracht te tokeniseren creëren PinFi‑protocollen markten waarin ongebruikte GPU’s productieve activa worden die rendement genereren via AI‑workloads, edge‑processing en gespecialiseerde infrastructuurbehoeften.

De convergentie van de onverzadigbare vraag van AI naar rekenkracht met crypto’s vermogen om gedistribueerde systemen te coördineren via economische prikkels creëert een overtuigend waardevoorstel. GPU‑tekorten die meer dan 50% van de generatieve AI‑bedrijven treffen tonen de ernst van de infrastructuurknelpunten aan. Gedistribueerde rekenmarkten die groeien van 9 miljard dollar in 2024 naar een geprojecteerde 100 miljard dollar in 2032 signaleren markterkenning dat gedistribueerde modellen latente capaciteit kunnen ontsluiten.

Protocollen zoals Bittensor, Render, Akash en io.net tonen uiteenlopende benaderingen van dezelfde fundamentele uitdaging: het efficiënt op elkaar afstemmen van vraag en aanbod van rekenkracht via permissionless, blockchain‑gebaseerde coördinatie. Elk netwerk experimenteert met andere tokenomics, verificatiemechanismen en doeltoepassingen, en draagt zo bij aan een bredere ecosysteem‑ontwikkeling die de ontwerp‑ruimte voor gedecentraliseerde infrastructuur verkent.

De implicaties reiken verder dan crypto, tot in de AI‑industrie en de computationele infrastructuur in bredere zin. Gedemocratiseerde toegang tot GPU‑bronnen verlaagt de drempels voor AI‑innovatie. Minder afhankelijkheid van gecentraliseerde cloudoligopolies introduceert concurrentiedynamieken die prijzen en toegankelijkheid kunnen verbeteren. Nieuwe activaklassen ontstaan wanneer tokens eigendom in productieve infrastructuur vertegenwoordigen in plaats van louter speculatie.

Er blijven aanzienlijke uitdagingen. Technische betrouwbaarheid, verificatiemechanismen, economische duurzaamheid, regelgevende onzekerheid en concurrentie van goed gekapitaliseerde incumbents vormen allemaal risico’s. Niet elk protocol zal overleven en veel tokens kunnen overgewaardeerd blijken ten opzichte van hun fundamentele nut. Maar de kerninzicht dat PinFi drijft lijkt solide: er staat wereldwijd enorme rekenkracht ongebruikt stil, er bestaat massale vraag naar AI‑infrastructuur, en blockchain‑gebaseerde coördinatie kan deze scheve vraag‑ en aanbodcurves met elkaar in balans brengen.

Naarmate de vraag naar AI blijft exploderen, wordt de infrastructuurlaag die deze technologie aandrijft steeds crucialer. Of die infrastructuur geconcentreerd blijft bij een paar gecentraliseerde aanbieders, of evolueert naar modellen van gedistribueerd eigenaarschap die worden gecoördineerd via cryptoeconomische prikkels, kan het concurrentielandschap van AI‑ontwikkeling voor het komende decennium bepalen.

De infrastructuurfinanciering van de toekomst zal er mogelijk minder uitzien als traditionele projectfinanciering en meer als getokeniseerde netwerken van wereldwijd verspreide hardware, waar iedereen met een GPU infrastructuurprovider kan worden en waar toegang geen andere toestemming vereist dan betaling tegen marktprijs. Dit vertegenwoordigt een fundamentele heruitvinding van hoe computationele middelen worden beheerd, geëxploiteerd en gemonetariseerd—een model waarin cryptoprotocols nut tonen voorbij financiële speculatie door tastbare problemen in de fysieke wereld op te lossen.