Branża sztucznej inteligencji mierzy się z krytycznym wąskim gardłem infrastrukturalnym. Trenowanie dużych modeli językowych wymaga ogromnych zasobów obliczeniowych, urządzenia brzegowe mnożą się w tempie wykładniczym, a niedobór GPU stał się definiującym ograniczeniem ery AI. Tymczasem tradycyjni dostawcy chmury zmagają się z zaspokojeniem rosnącego popytu, jednocześnie zachowując monopolistyczną kontrolę nad dostępem i cenami.

Over 50% of generative AI companies report GPU shortages jako główną przeszkodę w skalowaniu działalności. AI computing power is expected to increase by roughly 60 times by the end of 2025 w porównaniu z I kw. 2023 r. Ten wyścig zbrojeń w zakresie mocy obliczeniowej stworzył przestrzeń dla protokołów krypto, by zaproponować zdecentralizowaną alternatywę.

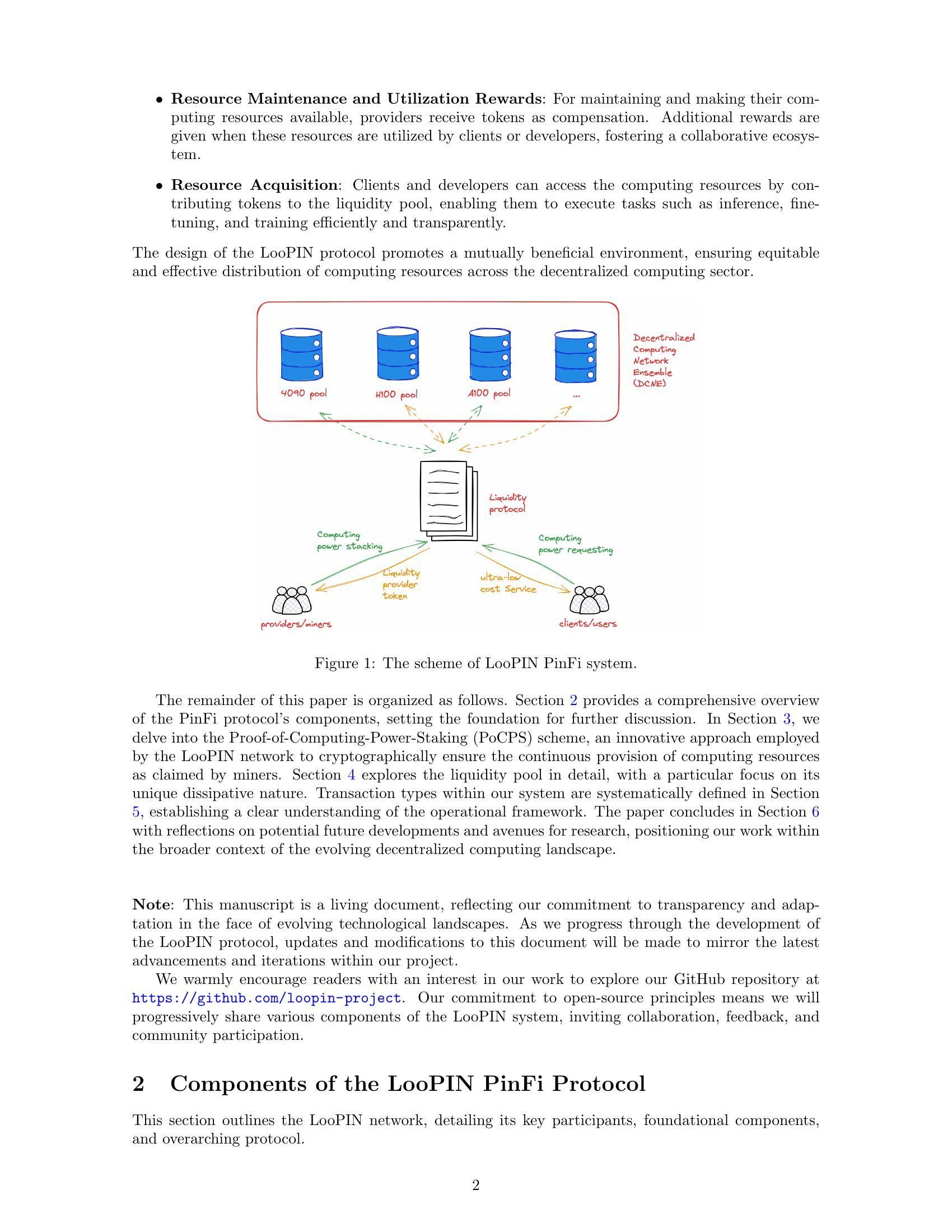

Na scenę wkracza Physical Infrastructure Finance, czyli PinFi. To wyłaniające się podejście traktuje moc obliczeniową jako tokenizowane aktywo, które można wymieniać, stakować i monetyzować w sieciach opartych na blockchainie. Zamiast polegać na scentralizowanych centrach danych, protokoły PinFi agregują nieużywaną moc GPU od niezależnych operatorów, zestawów gamingowych, farm górniczych i urządzeń brzegowych w rozproszone rynki dostępne dla deweloperów AI na całym świecie.

Poniżej omawiamy, w jaki sposób realna moc obliczeniowa przekształcana jest w infrastrukturę krypto‑ekonomiczną: mechanikę sieci tokenizowanej mocy, modele ekonomiczne zachęcające do udziału, architekturę umożliwiającą weryfikację i rozliczenia oraz konsekwencje dla branż krypto i AI.

Dlaczego PinFi teraz? Czynniki makro i techniczne

Wąskie gardło mocy obliczeniowej w branży AI wynika z fundamentalnych ograniczeń podaży. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, pozostawiając wielu użytkowników w desperackich poszukiwaniach dostępu. The global AI chip market reached $123.16 billion in 2024 i ma według prognoz osiągnąć 311,58 mld USD do 2029 r., co odzwierciedla wybuchowy popyt znacznie wyprzedzający moce produkcyjne.

Niedobór GPU przejawia się na wiele sposobów. Tradycyjni dostawcy chmury utrzymują listy oczekujących na premiumowe instancje GPU. AWS charges $98.32 per hour for an 8-GPU H100 instance, co cenowo wyklucza zaawansowane możliwości AI dla wielu deweloperów i startupów. Ceny sprzętu pozostają wysokie z powodu ograniczeń podaży, a HBM3 pricing rising 20-30% year-over-year.

Koncentracja mocy obliczeniowej w rękach kilku dużych dostawców chmury tworzy dodatkowe tarcia. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, jednak dostęp wciąż jest ograniczany przez kontrakty, uwarunkowania geograficzne i wymagania KYC. Ta centralizacja tłumi innowacje i tworzy pojedyncze punkty awarii dla kluczowej infrastruktury.

Jednocześnie ogromne ilości mocy obliczeniowej pozostają bezczynne. Zestawy gamingowe stoją nieużywane w godzinach pracy. Górnicy kryptowalut szukają nowych źródeł przychodu wraz ze zmianą ekonomiki miningu. Centra danych utrzymują nadwyżkę mocy w okresach poza szczytem. The decentralized compute market has grown from $9 billion in 2024 z prognozami sięgającymi 100 mld USD do 2032 r., co sygnalizuje rynkowe uznanie, że modele rozproszone mogą zagospodarować tę utajoną podaż.

Przecięcie technologii blockchain z infrastrukturą fizyczną dojrzało dzięki zdecentralizowanym sieciom infrastruktury fizycznej, czyli DePIN. Protokoły DePIN wykorzystują zachęty tokenowe do koordynowania wdrażania i działania infrastruktury w świecie rzeczywistym. Messari identified DePIN's total addressable market at $2.2 trillion, z potencjałem wzrostu do 3,5 bln USD do 2028 r.

PinFi jest zastosowaniem zasad DePIN konkretnie do infrastruktury obliczeniowej. Traktuje zasoby obliczeniowe jako tokenizowalne aktywa generujące dochód dzięki produktywnemu wykorzystaniu. To podejście przekształca moc obliczeniową z usługi wynajmowanej od scentralizowanych dostawców w towar handlowany na otwartych, pozbawionych zezwoleń rynkach.

Czym jest PinFi i tokenizowana moc obliczeniowa?

Physical Infrastructure Finance definiuje model, w którym fizyczne zasoby obliczeniowe są reprezentowane jako cyfrowe tokeny na blockchainach, co umożliwia zdecentralizowaną własność, operowanie i monetyzację. W przeciwieństwie do tradycyjnych protokołów zdecentralizowanych finansów operujących wyłącznie na aktywach cyfrowych, PinFi tworzy mosty między pozasieciowymi zasobami fizycznymi a on‑chainowymi systemami ekonomicznymi.

Academic research defines tokenization jako „proces przekształcania praw, jednostki własności aktywów, długu lub nawet fizycznego aktywa w cyfrowy token na blockchainie”. W przypadku zasobów obliczeniowych oznacza to, że poszczególne GPU, klastry serwerów czy urządzenia brzegowe są reprezentowane przez tokeny śledzące ich moc, dostępność i wykorzystanie.

PinFi w sposób zasadniczy różni się od standardowego finansowania infrastruktury czy typowych protokołów DeFi. Tradycyjne finansowanie infrastruktury obejmuje długoterminowe inwestycje dłużne lub kapitałowe w duże projekty kapitałowe. Protokoły DeFi głównie ułatwiają handel, udzielanie pożyczek lub generowanie zysków na aktywach natywnych dla krypto. PinFi znajduje się na przecięciu, stosując bodźce krypto‑ekonomiczne do koordynowania rzeczywistych zasobów obliczeniowych przy zachowaniu on‑chainowych rozliczeń i zarządzania.

Kilka protokołów ilustruje model PinFi. Bittensor operates as a decentralized AI network, w której uczestnicy dostarczają modele uczenia maszynowego i zasoby obliczeniowe do wyspecjalizowanych subnetów skoncentrowanych na określonych zadaniach. Token TAO zachęca do wkładu na podstawie wartości informacyjnej przekazywanej zbiorowej inteligencji sieci. With over 7,000 miners dostarczających moc, Bittensor tworzy rynki dla wnioskowania AI i trenowania modeli.

Render Network aggregates idle GPUs globally na potrzeby rozproszonych zadań renderingu GPU. Początkowo skoncentrowana na renderingu 3D dla artystów i twórców treści, Render rozszerzył działalność na obciążenia obliczeniowe AI. Jego token RNDR służy jako płatność za zlecenia renderingu, jednocześnie nagradzając dostawców GPU za udostępnioną moc.

Akash Network operates as a decentralized cloud marketplace, który wykorzystuje nieużywaną moc centrów danych. Dzięki systemowi odwrotnych aukcji deweloperzy mocy obliczeniowej określają swoje wymagania, a dostawcy licytują, by je spełnić. Token AKT ułatwia zarządzanie, staking i rozliczenia w sieci. Akash witnessed notable surge in quarterly active leases po rozszerzeniu działalności o GPU obok tradycyjnych zasobów CPU.

io.net has aggregated over 300,000 verified GPUs, integrując zasoby od niezależnych centrów danych, górników krypto oraz innych sieci DePIN, w tym Render i Filecoin. Platforma koncentruje się specjalnie na obciążeniach AI i uczenia maszynowego, oferując deweloperom możliwość wdrażania klastrów GPU w 130 krajach w ciągu kilku minut.

Mechanika tokenizowanej mocy obliczeniowej jest spójna w tych protokołach. Dostawcy mocy rejestrują swój sprzęt w sieci, przechodząc procesy weryfikacyjne potwierdzające moc i możliwości. Smart kontrakty zarządzają relacją między podażą a popytem, kierując zadania obliczeniowe do dostępnych węzłów na podstawie wymagań, cen i ograniczeń geograficznych. Nagrody tokenowe zachęcają zarówno do udostępniania sprzętu, jak i świadczenia usług wysokiej jakości.

Tworzenie wartości następuje poprzez realne wykorzystanie, a nie spekulację. Gdy deweloper AI trenuje model, używając rozproszonych zasobów GPU, płatność trafia do dostawców, których sprzęt wykonał pracę. Moc obliczeniowa staje się aktywem produktywnym generującym dochód, podobnie jak walidatorzy proof‑of‑stake zarabiają za zabezpieczanie sieci. Tworzy to zrównoważoną ekonomię, w której wartość tokena koreluje z użytecznością sieci.

Architektura infrastruktury: węzły, rynki, rozliczenia

Architektura umożliwiająca tokenizowaną moc obliczeniową wymaga koordynacji na wielu warstwach. U podstaw leży sieć niezależnych dostawców mocy, którzy wdrażają sprzęt, rejestrują się w protokołach i udostępniają moc do wynajęcia. Dostawcy ci obejmują zarówno osoby prywatne z komputerami gamingowymi, jak i profesjonalne centra danych czy operacje wydobywcze kryptowalut poszukujące dodatkowych źródeł przychodu.

Udostępnianie węzła zaczyna się, gdy dostawca mocy łączy sprzęt z siecią. Protocols like io.net support diverse GPU types, od konsumenckich NVIDIA RTX 4090 po serwerowe H100 i A100. Dostawca instaluje oprogramowanie klienckie, które wystawia moc na warstwę orkiestracji sieci, jednocześnie utrzymując granice bezpieczeństwa zapobiegające nieautoryzowanemu dostępowi.

Mechanizmy weryfikacji zapewniają, że deklarowana moc odpowiada rzeczywistym możliwościom. Niektóre protokoły stosują kryptograficzne dowody obliczeń, w których węzły muszą wykazać, że poprawnie wykonały określone obliczenia. Bittensor używa swojego mechanizmu Yuma Consensus, w którym walidatorzy oceniają jakość wyników uczenia maszynowego dostarczanych przez górników i przyznają im oceny determinujące podział nagród. Węzły dostarczające wyniki niskiej jakości lub próbujące oszukiwać otrzymują niższe wynagrodzenie lub podlegają slashingowi zdeponowanych tokenów.

Benchmarking opóźnień pomaga dopasować obciążenia do odpowiedniego sprzętu. Infernencja AI wymaga innych charakterystyk wydajnościowych niż trenowanie modeli czy renderowanie 3D. Lokalizacja geograficzna wpływa na opóźnienia w zastosowaniach edge computing, gdzie przetwarzanie musi odbywać się blisko źródeł danych. the edge computing market reached $23.65 billion in 2024 and is expected to hit $327.79 billion by 2033, driven by demand for localized processing.

Warstwa marketplace łączy popyt na moc obliczeniową z jej podażą. Gdy deweloperzy potrzebują zasobów GPU, określają wymagania, w tym moc obliczeniową, pamięć, czas trwania oraz maksymalną cenę. Akash employs a reverse auction model, where deployers set terms and providers bid to win contracts. Render uses dynamic pricing algorithms that adjust rates based on network utilization and market conditions.

Algorytmy routingu zadań optymalizują rozmieszczenie zadań obliczeniowych pomiędzy dostępne węzły. Brane są pod uwagę takie czynniki jak specyfikacje sprzętowe, bieżące wykorzystanie, bliskość geograficzna, historyczna wydajność oraz cena. io.net's orchestration layer handles containerized workflows and supports Ray-native orchestration for distributed machine learning workloads.

Rozliczenia odbywają się on-chain poprzez smart kontrakty, które deponują płatności w escrow i uwalniają środki po zweryfikowanym ukończeniu pracy. Tego typu beztrustowe rozliczanie eliminuje ryzyko kontrahenta, umożliwiając jednocześnie mikrotransakcje za krótkotrwałe zadania obliczeniowe. Protocols built on high-throughput blockchains like Solana can handle the transaction volume generated by thousands of simultaneous inference requests.

Mechanizmy stakingu wyrównują bodźce pomiędzy uczestnikami. Dostawcy mocy obliczeniowej często stakują tokeny, aby wykazać zaangażowanie i wystawić zabezpieczenie, które może zostać poddane slashingowi w przypadku słabej wydajności. Validators in Bittensor stake TAO tokens to gain influence in scoring miners and earn portions of block rewards. Posiadacze tokenów mogą delegować stake do zaufanych walidatorów, podobnie jak w mechanizmach konsensusu proof-of-stake.

Zarządzanie (governance) pozwala posiadaczom tokenów głosować nad parametrami protokołu, w tym podziałem nagród, strukturą opłat i aktualizacjami sieci. Decentralized governance ensures that no central authority can unilaterally change rules or restrict access, maintaining the permissionless nature that differentiates these networks from traditional cloud providers.

Ta architektura wyraźnie kontrastuje ze scentralizowanym cloud computingiem. Główni dostawcy posiadają własną infrastrukturę, ustalają ceny bez realnej konkurencji rynkowej, wymagają zakładania kont i spełniania wymogów compliance oraz utrzymują kontrolę nad dostępem i cenzurą. Protokoły PinFi rozpraszają własność pomiędzy tysiące niezależnych operatorów, umożliwiają przejrzyste, rynkowe kształtowanie cen, działają w sposób permissionless i opierają się cenzurze dzięki decentralizacji.

Tokenomics & Incentive Models

Ekonomia tokena zapewnia strukturę bodźców koordynującą rozproszone sieci obliczeniowe. Nattywne tokeny pełnią wiele funkcji, w tym płatności za usługi, nagrody za udostępnianie zasobów, prawa governance oraz wymagania stakingowe dla uczestników sieci.

Mechanizmy emisji określają, w jaki sposób tokeny trafiają do obiegu. Bittensor follows Bitcoin's model with a capped supply of 21 million TAO tokens and periodic halvings that reduce issuance over time. Currently 7,200 TAO are minted daily, split between miners who contribute computational resources and validators who ensure network quality. Tworzy to niedobór podobny do Bitcoina, jednocześnie kierując inflację w stronę produktywnej infrastruktury.

Inne protokoły emitują tokeny w oparciu o wykorzystanie sieci. Gdy zadania obliczeniowe są wykonywane, nowo wybite tokeny trafiają do dostawców proporcjonalnie do zasobów, które udostępnili. To bezpośrednie powiązanie pomiędzy tworzeniem wartości a emisją tokenów zapewnia, że inflacja nagradza realną produktywność, a nie pasywne trzymanie tokenów.

Staking tworzy „skin in the game” dla uczestników sieci. Dostawcy mocy obliczeniowej stakują tokeny, aby zarejestrować węzły i wykazać zaangażowanie. Słaba wydajność lub próby oszustwa skutkują slashingiem, w ramach którego stakowane tokeny są niszczone lub redystrybuowane do poszkodowanych stron. Ta kara ekonomiczna zachęca do niezawodnego świadczenia usług i uczciwego zachowania.

Walidatorzy stakują większe kwoty, aby zyskać wpływ na ocenę jakości oraz decyzje governance. In Bittensor's model, validators evaluate miners' outputs and submit weight matrices indicating which nodes provided valuable contributions. Yuma Consensus agreguje te oceny, ważone stakowanymi kwotami walidatorów, aby określić ostateczny podział nagród.

Dynamika podaży i popytu na tokeny obliczeniowe działa na dwóch poziomach. Po stronie podaży, większa liczba węzłów dołączających do sieci zwiększa dostępną moc obliczeniową. Nagrody w tokenach muszą być wystarczające, by zrekompensować koszty sprzętu, energii elektrycznej oraz koszty alternatywne względem innych zastosowań tego sprzętu. Wraz ze wzrostem cen tokena udostępnianie mocy obliczeniowej staje się bardziej opłacalne, przyciągając dodatkową podaż.

Po stronie popytu cena tokena odzwierciedla wartość, jaką użytkownicy przypisują dostępowi do sieci. W miarę proliferacji aplikacji AI i narastania niedoboru mocy obliczeniowej rośnie skłonność do płacenia za zdecentralizowane zasoby. the AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034, creating sustained demand for alternative compute sources.

Aprecjacja wartości tokena przynosi korzyści wszystkim uczestnikom. Dostawcy sprzętu zarabiają więcej za tę samą moc obliczeniową. Wcześni operatorzy węzłów zyskują na wzroście wartości zgromadzonych nagród. Deweloperzy korzystają z zdecentralizowanej alternatywy wobec drogich, scentralizowanych dostawców. Posiadacze tokenów, którzy stakują lub dostarczają płynność, przechwytują opłaty generowane przez aktywność sieci.

Modele ryzyka adresują potencjalne tryby zawodności. Przestoje węzłów zmniejszają ich zarobki, ponieważ zadania są kierowane do dostępnych alternatyw. Koncentracja geograficzna tworzy problemy z opóźnieniami dla aplikacji edge wymagających lokalnego przetwarzania. Efekty sieciowe sprzyjają większym protokołom z bardziej zróżnicowanym sprzętem i rozmieszczeniem geograficznym.

Inflacja tokena musi równoważyć przyciąganie nowej podaży z utrzymaniem wartości dla istniejących posiadaczy. Research on decentralized infrastructure protocols notes that sustainable tokenomics requires demand growth to outpace supply increases. Protokoły wdrażają mechanizmy spalania, w ramach których tokeny użyte do płatności są trwale usuwane z obiegu, tworząc presję deflacyjną równoważącą inflacyjną emisję.

Struktury opłat różnią się pomiędzy sieciami. Niektóre pobierają opłaty od użytkowników bezpośrednio w natywnych tokenach. Inne akceptują stablecoiny lub owrapowane wersje głównych kryptowalut, przy czym tokeny protokołu służą głównie do governance i stakingu. Modele hybrydowe używają tokenów jako klucza dostępu do sieci, jednocześnie rozliczając płatności za moc obliczeniową w stabilnych aktywach, aby ograniczyć ryzyko zmienności.

Przestrzeń projektowa dla modeli bodźców stale się rozwija, ponieważ protokoły eksperymentują z różnymi podejściami do równoważenia interesów interesariuszy i utrzymania długoterminowego wzrostu.

AI, Edge, and Real-World Infrastructure

Tokenizowane sieci obliczeniowe umożliwiają aplikacje wykorzystujące rozproszony sprzęt do zadań AI, przetwarzania na brzegu sieci oraz wyspecjalizowanych potrzeb infrastrukturalnych. Różnorodność przypadków użycia pokazuje, jak zdecentralizowane modele mogą rozwiązywać wąskie gardła w całym stosie obliczeniowym.

Rozproszone trenowanie modeli AI stanowi główny przypadek użycia. Trenowanie dużych modeli językowych czy systemów rozpoznawania obrazu wymaga masywnej równoległej mocy obliczeniowej na wielu GPU. Tradycyjne podejścia koncentrują to trenowanie w scentralizowanych centrach danych należących do dużych dostawców chmury. Zdecentralizowane sieci pozwalają na trenowanie w rozproszonych geograficznie węzłach, z których każdy wnosi swoją moc obliczeniową koordynowaną przez orkiestrację opartą na blockchainie.

Bittensor's subnet architecture enables specialized AI markets focused on specific tasks like text generation, image synthesis or data scraping. Górnicy konkurują, dostarczając wysokiej jakości wyniki w wybranych przez siebie domenach, a walidatorzy oceniają wydajność i odpowiednio rozdzielają nagrody. Tworzy to konkurencyjne rynki, na których najlepsze modele i najbardziej efektywne implementacje naturalnie wyłaniają się poprzez selekcję ekonomiczną.

Obciążenia edge computing w szczególny sposób korzystają ze zdecentralizowanej infrastruktury. The global edge computing market was valued at $23.65 billion in 2024, driven by applications requiringlow latency and local processing. Urządzenia IoT generujące ciągłe strumienie danych z czujników wymagają natychmiastowej analizy bez opóźnień związanych z przesyłaniem danych do odległych centrów danych. Pojazdy autonomiczne wymagają podejmowania decyzji w ułamkach sekund, co nie toleruje opóźnień sieciowych.

Zdecentralizowane sieci obliczeniowe mogą umieszczać moc obliczeniową fizycznie blisko źródeł danych. Fabryka wdrażająca przemysłowe czujniki IoT może wynajmować węzły brzegowe w tym samym mieście lub regionie zamiast polegać na scentralizowanych chmurach oddalonych o setki mil. Industrial IoT applications accounted for the largest market share in edge computing in 2024, odzwierciedlając kluczowe znaczenie lokalnego przetwarzania dla produkcji i logistyki.

Renderowanie treści i kreatywne procesy robocze zużywają znaczące zasoby GPU. Artyści renderujący sceny 3D, animatorzy tworzący filmy oraz deweloperzy gier kompilujący zasoby wszyscy wymagają intensywnego przetwarzania równoległego. Render Network specializes in distributed GPU rendering, łącząc twórców z nieużywaną mocą GPU na całym świecie. Taki model rynku obniża koszty renderowania, a jednocześnie zapewnia właścicielom GPU strumienie przychodów w okresach mniejszego obciążenia.

Obliczenia naukowe i zastosowania badawcze napotykają ograniczenia budżetowe przy dostępie do drogich zasobów chmurowych. Instytucje akademickie, niezależni badacze i mniejsze organizacje mogą wykorzystywać zdecentralizowane sieci do uruchamiania symulacji, analizowania zbiorów danych lub trenowania wyspecjalizowanych modeli. Ich bezzezwoleniowy charakter oznacza, że badacze w dowolnym regionie geograficznym mogą uzyskać dostęp do zasobów obliczeniowych bez instytucjonalnych kont chmurowych czy sprawdzania zdolności kredytowej.

Platformy gamingowe i metawersowe wymagają renderowania i obliczeń fizyki na potrzeby immersyjnych doświadczeń. W miarę jak wirtualne światy stają się coraz bardziej złożone, rosną wymagania obliczeniowe związane z utrzymaniem trwałych środowisk i obsługą tysięcy jednoczesnych użytkowników. Rozproszone węzły obliczeniowe na krawędzi sieci mogą zapewniać lokalne przetwarzanie dla regionalnych populacji graczy, redukując opóźnienia i rozkładając koszty infrastruktury na dostawców zachęcanych tokenami.

Wnioskowanie AI na dużą skalę wymaga ciągłego dostępu do GPU, aby obsługiwać predykcje trenowanych modeli. Chatbot obsługujący miliony zapytań, usługa generowania obrazów przetwarzająca prompty użytkowników czy silnik rekomendacji analizujący zachowania użytkowników – wszystkie one potrzebują stale dostępnej mocy obliczeniowej. Zdecentralizowane sieci zapewniają redundancję i geograficzne rozproszenie, które zwiększają niezawodność w porównaniu z zależnością od pojedynczego dostawcy.

Strefy geograficzne niedostatecznie obsługiwane przez głównych dostawców chmury stanowią szansę dla protokołów PinFi. Regiony z ograniczoną obecnością centrów danych doświadczają wyższych opóźnień i kosztów przy korzystaniu ze scentralizowanej infrastruktury. Lokalni dostawcy sprzętu w tych obszarach mogą oferować moc obliczeniową dostosowaną do regionalnego popytu, zarabiając tokeny i jednocześnie poprawiając lokalny dostęp do możliwości AI.

Wymogi dotyczące suwerenności danych coraz częściej nakazują, aby określone obciążenia przetwarzały dane w obrębie konkretnych jurysdykcji. Regulations like the EU Data Act require sensitive information to be processed locally, co zachęca do wdrażania infrastruktury brzegowej zgodnej z zasadami lokalizacji danych. Zdecentralizowane sieci naturalnie wspierają wdrażanie węzłów specyficznych dla danej jurysdykcji, jednocześnie utrzymując globalną koordynację dzięki rozliczeniom opartym na blockchainie.

Why It Matters: Implications for Crypto & Infrastructure

Pojawienie się PinFi oznacza rozszerzenie zastosowań krypto poza czysto finansowe obszary w kierunku koordynowania infrastruktury świata rzeczywistego. Ta zmiana niesie konsekwencje zarówno dla ekosystemu krypto, jak i dla szerszego sektora obliczeniowego.

Protokoły kryptowalutowe pokazują użyteczność wykraczającą poza spekulację, gdy rozwiązują namacalne problemy infrastrukturalne. DePIN i PinFi tworzą systemy ekonomiczne koordynujące zasoby fizyczne, dowodząc, że zachęty oparte na blockchainie mogą uruchamiać sieci w świecie rzeczywistym. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, co stanowi około trzykrotność obecnej całkowitej kapitalizacji rynkowej kryptowalut.

Demokratyzacja dostępu do mocy obliczeniowej rozwiązuje fundamentalną asymetrię w rozwoju AI. Obecnie zaawansowane możliwości AI są w dużej mierze skoncentrowane w dobrze finansowanych firmach technologicznych, które mogą sobie pozwolić na ogromne klastry GPU. Startupy, badacze i deweloperzy w środowiskach o ograniczonych zasobach napotykają bariery w udziale w innowacjach AI. Zdecentralizowane sieci obliczeniowe obniżają te bariery, zapewniając bezzezwoleniowy dostęp do rozproszonego sprzętu po cenach kształtowanych rynkowo.

Tworzenie nowych klas aktywów poszerza krajobraz inwestycyjny krypto. Tokeny reprezentujące moc obliczeniową odzwierciedlają własność produktywnej infrastruktury generującej przychody dzięki rzeczywistemu wykorzystaniu. Różni się to od czysto spekulacyjnych aktywów czy tokenów zarządzania bez jasnych mechanizmów przechwytywania wartości. Posiadacze tokenów w praktyce posiadają udziały w zdecentralizowanym dostawcy chmury, którego wartość jest powiązana z popytem na usługi obliczeniowe.

Tradycyjne monopole infrastrukturalne stają w obliczu potencjalnego zakłócenia. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control nad rynkami mocy obliczeniowej, ustalając ceny bez bezpośredniej konkurencji. Zdecentralizowane alternatywy wprowadzają dynamikę rynkową, w której tysiące niezależnych dostawców konkuruje, potencjalnie obniżając koszty i poprawiając dostępność.

Branża AI korzysta na zmniejszonej zależności od scentralizowanej infrastruktury. Obecnie rozwój AI skupia się wokół głównych dostawców chmury, tworząc pojedyncze punkty awarii i ryzyko koncentracji. Over 50% of generative AI companies report GPU shortages as major obstacles. Rozproszone sieci zapewniają alternatywną pojemność, która może przejmować nadwyżkowy popyt i oferować redundancję wobec zakłóceń w łańcuchach dostaw.

Usprawnienia efektywności energetycznej mogą wynikać z lepszego wykorzystania dostępnych zasobów. Zestawy gamingowe pozostające bezczynne zużywają energię w trybie czuwania bez produktywnego rezultatu. Kopalnie kryptowalut z nadmierną mocą szukają dodatkowych źródeł przychodu. Distributed networks put idle GPUs to productive use, poprawiając ogólną efektywność wykorzystania zasobów w ekosystemie obliczeniowym.

Odporność na cenzurę nabiera znaczenia w zastosowaniach AI. Scentralizowani dostawcy chmury mogą odmówić usług konkretnym użytkownikom, aplikacjom lub całym regionom geograficznym. Zdecentralizowane sieci działają bez zezwoleń, umożliwiając rozwój i wdrażanie AI bez konieczności uzyskiwania zgody „strażników bram”. Ma to szczególne znaczenie dla kontrowersyjnych zastosowań lub użytkowników w restrykcyjnych jurysdykcjach.

Architektury prywatności danych ulegają poprawie dzięki lokalnemu przetwarzaniu. Edge computing keeps sensitive data near its source zamiast przesyłać je do odległych centrów danych. Zdecentralizowane sieci mogą wdrażać techniki zachowania prywatności, takie jak uczenie federacyjne, w którym modele trenują na rozproszonych danych bez centralizowania surowych informacji.

Efektywność rynku rośnie dzięki przejrzystemu odkrywaniu cen. Tradycyjne cenniki chmurowe pozostają nieprzejrzyste, złożone z wielu opłat i negocjowanych kontraktów korporacyjnych. Zdecentralizowane rynki ustanawiają jasne ceny spotowe dla zasobów obliczeniowych, umożliwiając deweloperom optymalizację kosztów, a dostawcom maksymalizację przychodów poprzez konkurencję.

Długoterminowa istotność wynika z trwałych czynników napędzających popyt. Obciążenia AI będą nadal rosnąć wraz z proliferacją aplikacji. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Moc obliczeniowa pozostanie podstawowym ograniczeniem, zapewniając utrzymujący się popyt na alternatywne modele infrastruktury.

Efekty sieciowe sprzyjają protokołom, które jako pierwsze osiągną masę krytyczną. Wraz z dołączaniem kolejnych dostawców sprzętu rośnie różnorodność dostępnych zasobów. Dystrybucja geograficzna poprawia się, redukując opóźnienia dla aplikacji brzegowych. Większe sieci przyciągają więcej deweloperów, tworząc pozytywne sprzężenia zwrotne wzrostu. Pionierzy w określonych domenach mogą zyskać trwałą przewagę.

Challenges & Risks

Pomimo obiecujących zastosowań, tokenizowane sieci obliczeniowe stoją przed istotnymi wyzwaniami technicznymi, ekonomicznymi i regulacyjnymi, które mogą ograniczyć ich wzrost lub adopcję.

Niezawodność techniczna pozostaje główną kwestią. Scentralizowani dostawcy chmury oferują umowy SLA gwarantujące dostępność i wydajność. Rozproszone sieci koordynują sprzęt niezależnych operatorów o zróżnicowanym poziomie profesjonalizmu i jakości infrastruktury. Awarie węzłów, przerwy w sieci czy okna konserwacyjne tworzą luki w dostępności, które muszą być zarządzane poprzez redundancję i algorytmy trasowania.

Weryfikacja faktycznie wykonanej pracy stanowi trwałe wyzwanie. Zapewnienie, że węzły uczciwie wykonują obliczenia zamiast zwracać fałszywe wyniki, wymaga zaawansowanych systemów dowodów. Cryptographic proofs of compute dodają narzut, ale pozostają niezbędne, aby zapobiegać oszustwom. Niedoskonałe mechanizmy weryfikacji umożliwiają potencjalne ataki, w których złośliwe węzły roszczą sobie nagrody bez świadczenia obiecanych usług.

Ograniczenia opóźnień i przepustowości wpływają na rozproszone obciążenia. Running computations across geographically dispersed locations can causeopóźnienia w porównaniu ze sprzętem współlokowanym w pojedynczych centrach danych. Przepustowość sieci pomiędzy węzłami ogranicza typy zadań odpowiednich do rozproszonego przetwarzania. Ściśle sprzężone obliczenia równoległe wymagające częstej komunikacji między węzłami napotykają na degradację wydajności.

Zmienna jakość usług tworzy niepewność dla aplikacji produkcyjnych. W przeciwieństwie do zarządzanych środowisk chmurowych o przewidywalnej wydajności, heterogeniczne pule sprzętowe generują niekonsekwentne rezultaty. Pojedyncze uruchomienie treningu może zostać wykonane na korporacyjnych H100 lub konsumenckich kartach RTX, w zależności od dostępności. Deweloperzy aplikacji muszą projektować z uwzględnieniem tej zmienności lub wdrożyć filtrowanie ograniczające zadania do określonych poziomów sprzętu.

Długoterminowa opłacalność ekonomiczna wymaga zrównoważenia wzrostu podaży z ekspansją popytu. Gwałtowne zwiększanie dostępnej mocy obliczeniowej bez odpowiadającego mu wzrostu popytu obniży ceny tokenów i zredukuje rentowność dostawców. Protokoły muszą ostrożnie zarządzać emisją tokenów, aby uniknąć inflacji przewyższającej wzrost użyteczności. Sustainable tokenomics requires demand growth to outpace supply increases.

Kompresja wartości tokenów stwarza ryzyko dla długoterminowych uczestników. W miarę dołączania nowych dostawców poszukujących nagród, rosnąca konkurencja obniża zyski przypadające na pojedynczy węzeł. Wcześni uczestnicy, korzystający z wyższych początkowych nagród, mogą z czasem obserwować spadek zwrotów. Jeśli aprecjacja tokena nie zrekompensuje tego rozwodnienia, rotacja dostawców wzrośnie, a stabilność sieci ucierpi.

Zmienność rynkowa wprowadza dla uczestników ryzyko finansowe. Dostawcy zarabiają nagrody w natywnych tokenach, których wartość podlega wahaniom. Operator sprzętu może zainwestować kapitał w zakup GPU, zakładając stabilność cen tokenów, by następnie ponieść straty w razie ich spadku. Mechanizmy hedgingowe i opcje płatności w stablecoinach mogą łagodzić zmienność, ale dodają złożoności.

Niepewność regulacyjna dotycząca klasyfikacji tokenów tworzy wyzwania w zakresie zgodności. Organy nadzoru papierów wartościowych w różnych jurysdykcjach oceniają, czy tokeny mocy obliczeniowej stanowią papiery wartościowe podlegające obowiązkowi rejestracji. Niejasny status prawny ogranicza udział instytucji i tworzy ryzyko odpowiedzialności dla twórców protokołów. Infrastructure tokenization faces regulation uncertainties, które ograniczyły adopcję w porównaniu z tradycyjnymi strukturami finansowymi.

Regulacje dotyczące ochrony danych nakładają wymagania, przez które muszą nawigować sieci rozproszone. Przetwarzanie danych obywateli UE wymaga zgodności z RODO, w tym minimalizacji danych i prawa do ich usunięcia. Zastosowania medyczne muszą spełniać wymagania HIPAA. Zastosowania finansowe napotykają na obowiązki związane z przeciwdziałaniem praniu pieniędzy. Sieci zdecentralizowane komplikują zapewnienie zgodności, gdy dane przemieszczają się pomiędzy wieloma jurysdykcjami i niezależnymi operatorami.

Wkłady sprzętowe mogą wywołać wzmożoną kontrolę regulacyjną, w zależności od sposobu strukturyzacji porozumień. Jurysdykcje mogą klasyfikować niektóre relacje z dostawcami jako oferty papierów wartościowych lub regulowane produkty finansowe. Granica między świadczeniem infrastruktury a kontraktami inwestycyjnymi pozostaje niejasna w wielu ramach prawnych.

Konkurencja ze strony hiperskalowych dostawców chmury wciąż się nasila. Główni dostawcy inwestują miliardy w nową pojemność centrów danych i niestandardowe akceleratory AI. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, w dużej mierze na infrastrukturę AI. Dobrze dokapitalizowani dotychczasowi gracze mogą zaniżać ceny lub łączyć moc obliczeniową z innymi usługami, aby utrzymać udział w rynku.

Fragmentacja sieci może ograniczyć kompozytowalność. Wiele konkurujących protokołów tworzy odizolowane ekosystemy, w których zasoby obliczeniowe nie mogą być łatwo przenoszone pomiędzy sieciami. Brak standaryzacji w zakresie API, mechanizmów weryfikacji czy standardów tokenów obniża efektywność i podnosi koszty zmiany dla deweloperów.

Ryzyko wczesnego adoptera dotyka protokoły bez ugruntowanych historii sukcesów. Nowe sieci mierzą się z problemem „kury i jajka”, próbując jednocześnie przyciągnąć zarówno dostawców sprzętu, jak i nabywców mocy obliczeniowej. Protokoły mogą nie osiągnąć masy krytycznej potrzebnej do trwałego funkcjonowania. Inwestorzy tokenów ponoszą ryzyko całkowitej utraty, jeśli sieci się załamią lub nie zdobędą adopcji.

Luki bezpieczeństwa w smart kontraktach lub warstwach koordynacji mogą umożliwić kradzież środków lub zakłócenie działania sieci. Decentralized networks face security challenges, wymagające starannych audytów smart kontraktów i programów bug bounty. Wykorzystanie luk, które opróżniają skarbce lub umożliwiają podwójne płatności, niszczy zaufanie i wartość sieci.

The Road Ahead & What to Watch

Śledzenie kluczowych metryk i wydarzeń dostarcza wglądu w dojrzewanie i trajektorię wzrostu sieci tokenizowanej mocy obliczeniowej.

Wskaźniki wzrostu sieci obejmują liczbę aktywnych węzłów obliczeniowych, rozmieszczenie geograficzne, różnorodność sprzętu oraz całkowitą dostępną pojemność mierzoną mocą obliczeniową lub ekwiwalentami GPU. Rozszerzanie się tych metryk sygnalizuje rosnącą podaż i odporność sieci. io.net accumulated over 300,000 verified GPUs poprzez integrację wielu źródeł, demonstrując potencjał szybkiej skalowalności, gdy protokoły skutecznie koordynują rozproszone zasoby.

Metryki użycia ujawniają rzeczywisty popyt na zdecentralizowaną moc obliczeniową. Aktywne zadania obliczeniowe, łączna liczba dostarczonych godzin przetwarzania oraz struktura typów obciążeń pokazują, czy sieci obsługują realne zastosowania wykraczające poza spekulację. Akash witnessed notable surge in quarterly active leases po rozszerzeniu wsparcia dla GPU, wskazując na apetyt rynku na zdecentralizowane alternatywy wobec tradycyjnych chmur.

Kapitalizacja rynkowa tokenów i w pełni rozwodnione wyceny dostarczają rynkowej oceny wartości protokołów. Porównanie wycen z faktycznymi przychodami lub przepustowością obliczeniową ujawnia, czy tokeny wyceniają przyszłe oczekiwania wzrostu, czy odzwierciedlają obecną użyteczność. Bittensor's TAO token reached $750 during peak hype in March 2024, ilustrując zainteresowanie spekulacyjne obok rzeczywistej adopcji.

Partnerstwa z firmami AI i użytkownikami korporacyjnymi sygnalizują akceptację głównego nurtu. Gdy uznane laboratoria AI, twórcy modeli lub aplikacje produkcyjne uruchamiają obciążenia na zdecentralizowanych sieciach, pokazuje to, że rozproszona infrastruktura spełnia wymagania rzeczywistych zastosowań. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, pokazując korporacyjne zaangażowanie w architektury rozproszone.

Aktualizacje protokołów i dodawanie funkcji wskazują na utrzymane tempo rozwoju. Integracja nowych typów GPU, ulepszone systemy orkiestracji, usprawnione mechanizmy weryfikacji lub ulepszenia ładu pokazują aktywną iterację w kierunku lepszej infrastruktury. Bittensor's Dynamic TAO upgrade in 2025 przesunęła więcej nagród w stronę najlepiej działających subnetów, demonstrując adaptacyjne tokenomiki.

Rozwój regulacyjny kształtuje środowisko operacyjne. Korzystna klasyfikacja tokenów infrastrukturalnych lub jasne wytyczne dotyczące wymogów zgodności zmniejszyłyby niepewność prawną i umożliwiły szerszy udział instytucjonalny. Odwrotnie, restrykcyjne regulacje mogą ograniczyć wzrost w określonych jurysdykcjach.

Dynamika konkurencyjna pomiędzy protokołami określi strukturę rynku. Obszar infrastruktury obliczeniowej może skonsolidować się wokół kilku dominujących sieci osiągających silne efekty sieciowe lub pozostać rozdrobniony, z wyspecjalizowanymi protokołami obsługującymi różne nisze. Standardy interoperacyjności mogłyby umożliwić koordynację między sieciami, poprawiając ogólną efektywność ekosystemu.

Mogą wyłonić się modele hybrydowe łączące elementy scentralizowane i zdecentralizowane. Przedsiębiorstwa mogą używać tradycyjnych chmur do podstawowej pojemności, podczas gdy w okresach szczytowego zapotrzebowania „wybuchowo” korzystać ze zdecentralizowanych sieci. Takie podejście zapewnia przewidywalność zarządzanych usług, jednocześnie przechwytując oszczędności kosztowe z rozproszonych alternatyw w okresach przeciążenia.

Mogą powstawać sieci konsorcyjne, w których uczestnicy branży wspólnie obsługują zdecentralizowaną infrastrukturę. Firmy AI, dostawcy chmury, producenci sprzętu lub instytucje akademickie mogliby ustanowić wspólne sieci, które redukują indywidualne wymagania kapitałowe przy jednoczesnym utrzymaniu zdecentralizowanego zarządzania. Ten model mógłby przyspieszyć adopcję wśród organizacji niechętnych ryzyku.

Pionowa specjalizacja wydaje się prawdopodobna, gdy protokoły optymalizują się pod kątem konkretnych przypadków użycia. Niektóre sieci mogą koncentrować się wyłącznie na trenowaniu modeli AI, inne na inferencji, część na edge computingu, a inne na renderingu lub obliczeniach naukowych. Wyspecjalizowana infrastruktura lepiej obsługuje specyficzne wymagania obciążeń niż alternatywy ogólnego przeznaczenia.

Integracja z istniejącymi narzędziami i frameworkami AI okaże się kluczowa. Bezproblemowa kompatybilność z popularnymi bibliotekami uczenia maszynowego, systemami orkiestracji i potokami wdrożeniowymi zmniejsza tarcia dla deweloperów. io.net supports Ray-native orchestration, uznając, że deweloperzy preferują znormalizowane przepływy pracy zamiast wdrożeń specyficznych dla protokołu.

Względy dotyczące zrównoważonego rozwoju mogą coraz silniej wpływać na projekt protokołów. Energooszczędne mechanizmy konsensusu, zachęty do korzystania z energii odnawialnej dla operatorów węzłów czy integracja kredytów węglowych mogą wyróżniać protokoły atrakcyjne dla użytkowników świadomych ekologicznie. W miarę jak zużycie energii przez AI podlega rosnącej kontroli, sieci zdecentralizowane mogą pozycjonować efektywność jako przewagę konkurencyjną.

Media coverageand crypto community attention serve as leading indicators of mainstream awareness. Increased discussion of specific protocols, rising search interest, or growing social media following often precedes broader adoption and token price appreciation. However, hype cycles can create misleading signals disconnected from fundamental growth.

Conclusion

Physical Infrastructure Finance reprezentuje ewolucję krypto w kierunku koordynacji rzeczywistych zasobów obliczeniowych. Poprzez tokenizację mocy obliczeniowej protokoły PinFi tworzą rynki, na których bezczynne GPU stają się produktywnymi aktywami generującymi dochód dzięki zadaniom AI, przetwarzaniu brzegowemu i wyspecjalizowanym potrzebom infrastrukturalnym.

Zbieżność nienasyconego popytu AI na moc obliczeniową z możliwością krypto do koordynowania rozproszonych systemów za pomocą bodźców ekonomicznych tworzy przekonującą propozycję wartości. GPU shortages affecting over 50% of generative AI companies pokazują skalę wąskich gardeł infrastrukturalnych. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 sygnalizują rynkowe uznanie, że rozproszone modele mogą zagospodarować utajoną podaż.

Protokoły takie jak Bittensor, Render, Akash i io.net demonstrują różne podejścia do tego samego fundamentalnego wyzwania: efektywnego dopasowywania podaży mocy obliczeniowej do popytu poprzez bezzezwoleniową koordynację opartą na blockchainie. Każda sieć eksperymentuje z inną tokenomiką, mechanizmami weryfikacji i docelowymi zastosowaniami, przyczyniając się do szerszego ekosystemu eksplorującego przestrzeń projektową zdecentralizowanej infrastruktury.

Konsekwencje wykraczają poza krypto w stronę branży AI i infrastruktury obliczeniowej w szerszym ujęciu. Udemokratyzowany dostęp do zasobów GPU obniża bariery dla innowacji w AI. Zmniejszona zależność od scentralizowanych oligopoli chmurowych wprowadza dynamikę konkurencyjną, która może poprawić ceny i dostępność. Pojawiają się nowe klasy aktywów, ponieważ tokeny reprezentują własność w produktywnej infrastrukturze, a nie czystą spekulację.

Pozostają istotne wyzwania. Niezawodność techniczna, mechanizmy weryfikacji, zrównoważenie ekonomiczne, niepewność regulacyjna oraz konkurencja ze strony dobrze dokapitalizowanych podmiotów dominujących stanowią istotne ryzyka. Nie każdy protokół przetrwa, a wiele tokenów może okazać się przewartościowanych względem ich fundamentalnej użyteczności. Jednak kluczowy wgląd napędzający PinFi wydaje się trafny: ogromna moc obliczeniowa na całym świecie pozostaje bezczynna, istnieje masywny popyt na infrastrukturę AI, a koordynacja oparta na blockchainie może dopasować te niedopasowane krzywe podaży i popytu.

W miarę jak popyt na AI nadal eksploduje, warstwa infrastruktury zasilająca tę technologię będzie coraz bardziej krytyczna. To, czy ta infrastruktura pozostanie skoncentrowana w rękach kilku scentralizowanych dostawców, czy też ewoluuje w stronę rozproszonych modeli własności koordynowanych poprzez bodźce kryptoekonomiczne, może zdefiniować konkurencyjny krajobraz rozwoju AI na następną dekadę.

Finansowanie infrastruktury przyszłości może wyglądać mniej jak tradycyjne finansowanie projektów, a bardziej jak tokenizowane sieci globalnie rozproszonego sprzętu, gdzie każdy posiadacz GPU może stać się dostawcą infrastruktury, a dostęp nie wymaga żadnych zezwoleń poza płatnością po cenie rynkowej. Oznacza to fundamentalne przeobrażenie sposobu, w jaki zasoby obliczeniowe są posiadane, obsługiwane i monetyzowane — takie, w którym protokoły krypto wykazują użyteczność wykraczającą poza spekulację finansową, rozwiązując namacalne problemy w fizycznym świecie.