A indústria de inteligência artificial enfrenta um gargalo crítico de infraestrutura. Treinar grandes modelos de linguagem exige recursos computacionais massivos, dispositivos de borda se multiplicam em ritmo exponencial e a escassez de GPUs tornou‑se a principal restrição da era da IA. Enquanto isso, provedores de nuvem tradicionais lutam para atender à demanda crescente e, ao mesmo tempo, manter seu controle monopólico sobre acesso e precificação.

Over 50% of generative AI companies report GPU shortages como um grande obstáculo para escalar suas operações. AI computing power is expected to increase by roughly 60 times by the end of 2025 em comparação com o primeiro trimestre de 2023. Essa corrida armamentista computacional abriu espaço para que protocolos cripto proponham uma alternativa descentralizada.

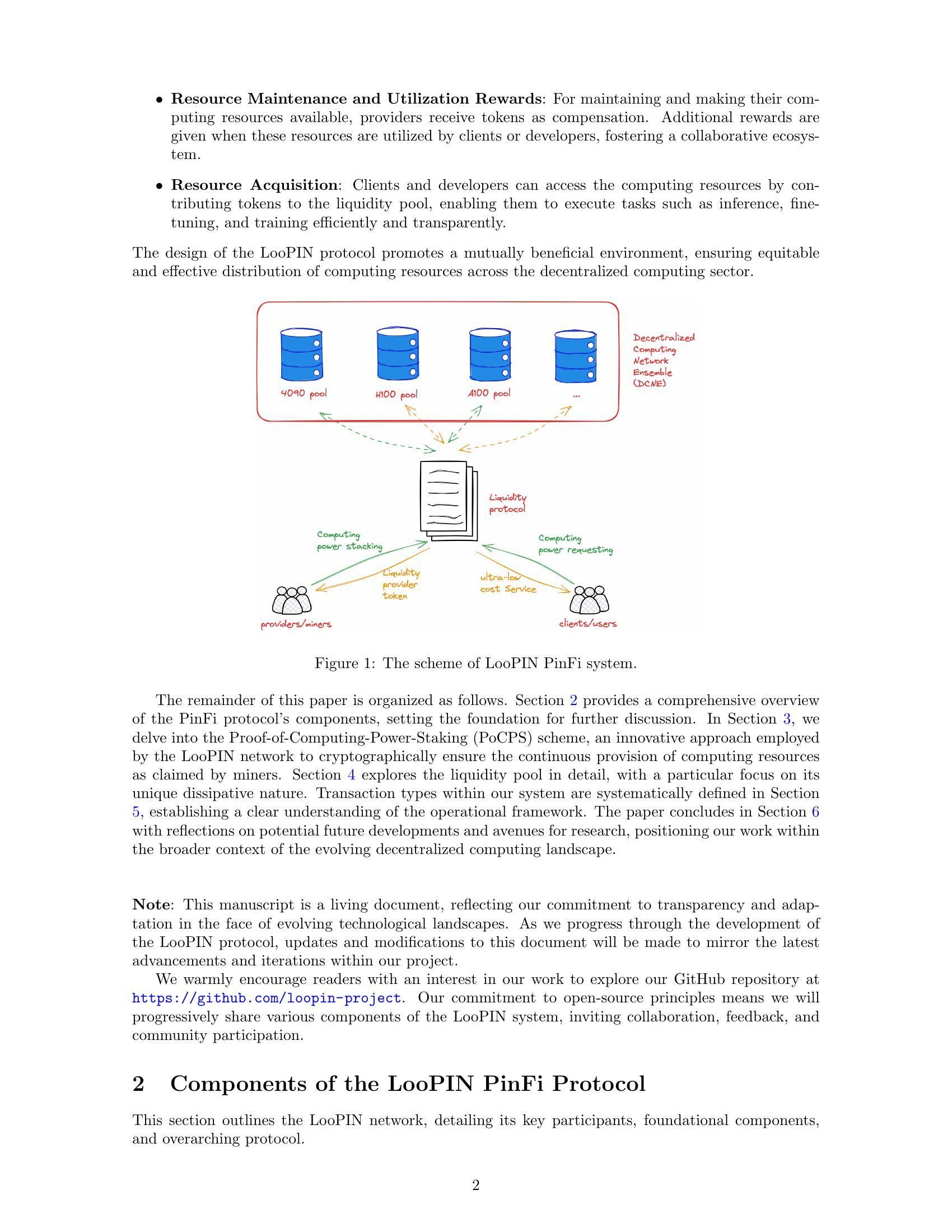

Entra em cena o Physical Infrastructure Finance, ou PinFi. Esse framework emergente trata a capacidade de computação como um ativo tokenizado que pode ser negociado, colocado em stake e monetizado por meio de redes baseadas em blockchain. Em vez de depender de data centers centralizados, protocolos PinFi agregam poder de GPU ocioso de operadores independentes, rigs de jogos, fazendas de mineração e dispositivos de borda em marketplaces distribuídos acessíveis a desenvolvedores de IA no mundo inteiro.

A seguir, exploramos como poder computacional real está sendo transformado em infraestrutura cripto‑econômica, entendendo a mecânica das redes de computação tokenizada, os modelos econômicos que incentivam a participação, a arquitetura que possibilita verificação e liquidação, e as implicações tanto para a indústria cripto quanto para a de IA.

Por que PinFi Agora? Vetores Macroeconômicos e Técnicos

O gargalo de computação que confronta a indústria de IA decorre de restrições fundamentais de oferta. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, deixando muitos usuários em disputa por acesso. The global AI chip market reached $123.16 billion in 2024 e projeta‑se que chegue a US$ 311,58 bilhões até 2029, refletindo uma demanda explosiva que supera em muito a capacidade de fabricação.

A escassez de GPUs se manifesta de várias formas. Provedores de nuvem tradicionais mantêm listas de espera para instâncias premium de GPU. AWS charges $98.32 per hour for an 8-GPU H100 instance, uma precificação que torna capacidades avançadas de IA inacessíveis para muitos desenvolvedores e startups. Os preços de hardware permanecem elevados devido às restrições de oferta, com HBM3 pricing rising 20-30% year-over-year.

A concentração de poder computacional em poucas grandes empresas de nuvem cria fricções adicionais. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, mas o acesso continua limitado por contratos, restrições geográficas e exigências de know‑your‑customer. Essa centralização limita a inovação e cria pontos únicos de falha para infraestrutura crítica.

Enquanto isso, vastas quantidades de capacidade computacional permanecem ociosas. Rigs de jogos ficam sem uso durante o horário de trabalho. Mineradores de cripto buscam novas fontes de receita à medida que a economia de mineração muda. Data centers mantêm capacidade excedente em períodos de baixa demanda. The decentralized compute market has grown from $9 billion in 2024 com projeções de atingir US$ 100 bilhões até 2032, sinalizando o reconhecimento de mercado de que modelos distribuídos podem capturar essa oferta latente.

A interseção entre tecnologia blockchain e infraestrutura física amadureceu por meio das redes descentralizadas de infraestrutura física, ou DePIN. Protocolos DePIN usam incentivos em tokens para coordenar a implantação e operação de infraestrutura do mundo real. Messari identified DePIN's total addressable market at $2.2 trillion, com potencial para chegar a US$ 3,5 trilhões até 2028.

PinFi representa a aplicação dos princípios DePIN especificamente à infraestrutura de computação. Ela trata recursos computacionais como ativos tokenizáveis que geram rendimento por meio de uso produtivo. Esse framework transforma computação de um serviço alugado de provedores centralizados em uma commodity negociada em mercados abertos e permissionless.

O que é PinFi e Computação Tokenizada?

Physical Infrastructure Finance define um modelo em que ativos computacionais físicos são representados como tokens digitais em blockchains, permitindo propriedade, operação e monetização descentralizadas. Diferente de protocolos tradicionais de finanças descentralizadas, que lidam apenas com ativos digitais, PinFi cria pontes entre recursos físicos off‑chain e sistemas econômicos on‑chain.

Academic research defines tokenization como “o processo de converter direitos, uma unidade de propriedade de ativo, dívida ou mesmo um ativo físico em um token digital em uma blockchain”. Para recursos de computação, isso significa que GPUs individuais, clusters de servidores ou dispositivos de borda passam a ser representados por tokens que rastreiam sua capacidade, disponibilidade e uso.

PinFi difere fundamentalmente de finanças tradicionais de infraestrutura ou de protocolos DeFi típicos. Financiamento tradicional de infraestrutura envolve investimentos de dívida ou capital de longo prazo em grandes projetos de capital. Protocolos DeFi focam principalmente em negociação, empréstimos ou geração de rendimento sobre ativos cripto‑nativos. PinFi se situa na interseção, aplicando incentivos cripto‑econômicos para coordenar recursos computacionais do mundo real, mantendo liquidação e governança on‑chain.

Vários protocolos exemplificam o modelo PinFi. Bittensor operates as a decentralized AI network em que participantes contribuem com modelos de machine learning e recursos computacionais para sub‑redes especializadas focadas em tarefas específicas. O token TAO incentiva contribuições com base no valor informacional fornecido à inteligência coletiva da rede. With over 7,000 miners contribuindo computação, o Bittensor cria mercados para inferência de IA e treinamento de modelos.

Render Network aggregates idle GPUs globally para tarefas de renderização GPU distribuída. Originalmente focada em renderização 3D para artistas e criadores de conteúdo, a Render se expandiu para workloads de computação de IA. Seu token RNDR serve como pagamento por jobs de renderização, ao mesmo tempo em que recompensa provedores de GPU pela capacidade fornecida.

Akash Network operates as a decentralized cloud marketplace que utiliza capacidade ociosa de data centers. Por meio de um sistema de leilão reverso, quem demanda computação especifica seus requisitos e provedores fazem lances para atender aos pedidos. O token AKT facilita governança, staking e liquidações em toda a rede. Akash witnessed notable surge in quarterly active leases depois de ampliar seu foco para incluir GPUs além dos recursos tradicionais de CPU.

io.net has aggregated over 300,000 verified GPUs integrando recursos de data centers independentes, mineradores de cripto e outras redes DePIN, incluindo Render e Filecoin. A plataforma foca especificamente em workloads de IA e machine learning, oferecendo a desenvolvedores a capacidade de implantar clusters de GPU em 130 países em questão de minutos.

A mecânica da computação tokenizada segue um padrão consistente entre esses protocolos. Provedores de computação registram seu hardware na rede, passando por processos de verificação para confirmar capacidade e características. Smart contracts gerenciam a relação entre oferta e demanda, roteando jobs de computação para nós disponíveis com base em requisitos, preços e restrições geográficas. Recompensas em tokens incentivam tanto a provisão de hardware quanto a entrega de serviço de qualidade.

A geração de valor ocorre por meio de uso real, e não de mera especulação. Quando um desenvolvedor de IA treina um modelo usando recursos distribuídos de GPU, o pagamento flui para os provedores cujo hardware executou o trabalho. O poder computacional torna‑se um ativo produtivo que gera rendimento, de forma semelhante a como validadores de proof‑of‑stake ganham recompensas por securitizar redes. Isso cria uma economia sustentável em que o valor do token se correlaciona com a utilidade da rede.

Arquitetura de Infraestrutura: Nós, Marketplaces, Liquidação

A arquitetura que viabiliza computação tokenizada exige coordenação em múltiplas camadas. Na base está uma rede de provedores de computação independentes que implantam hardware, se registram em protocolos e disponibilizam capacidade para aluguel. Esses provedores vão de indivíduos com PCs gamer a operadores profissionais de data center e operações de mineração de criptomoedas em busca de receitas adicionais.

O provisionamento de nós começa quando um provedor de computação conecta o hardware à rede. Protocols like io.net support diverse GPU types, desde GPUs de consumo NVIDIA RTX 4090 até modelos corporativos H100 e A100. O provedor instala um software cliente que expõe a capacidade para a camada de orquestração da rede, mantendo ao mesmo tempo fronteiras de segurança que impedem acessos não autorizados.

Mecanismos de verificação garantem que a capacidade anunciada corresponda às capacidades reais. Alguns protocolos empregam provas criptográficas de computação, em que nodes must demonstrate they performed specific calculations correctly. Bittensor uses its Yuma Consensus mechanism, where validators evaluate the quality of miners' machine learning outputs and assign scores that determine reward distribution. Nodes providing low-quality results or attempting to cheat receive reduced compensation or face slashing of staked tokens.

A avaliação de latência ajuda a alinhar workloads ao hardware apropriado. A inferência de IA requer características de desempenho diferentes do treinamento de modelos ou da renderização 3D. A localização geográfica afeta a latência para aplicações de edge computing em que o processamento precisa ocorrer próximo às fontes de dados. The edge computing market reached $23.65 billion in 2024 and is expected to hit $327.79 billion by 2033, driven by demand for localized processing.

A camada de marketplace conecta a demanda por computação com a oferta. Quando desenvolvedores precisam de recursos de GPU, eles especificam requisitos incluindo poder de processamento, memória, duração e preço máximo. Akash employs a reverse auction model where deployers set terms and providers bid to win contracts. Render uses dynamic pricing algorithms that adjust rates based on network utilization and market conditions.

Algoritmos de roteamento de jobs otimizam a alocação de tarefas de computação entre os nós disponíveis. Os fatores considerados incluem especificações de hardware, utilização atual, proximidade geográfica, desempenho histórico e preço. io.net's orchestration layer handles containerized workflows and supports Ray-native orchestration for distributed machine learning workloads.

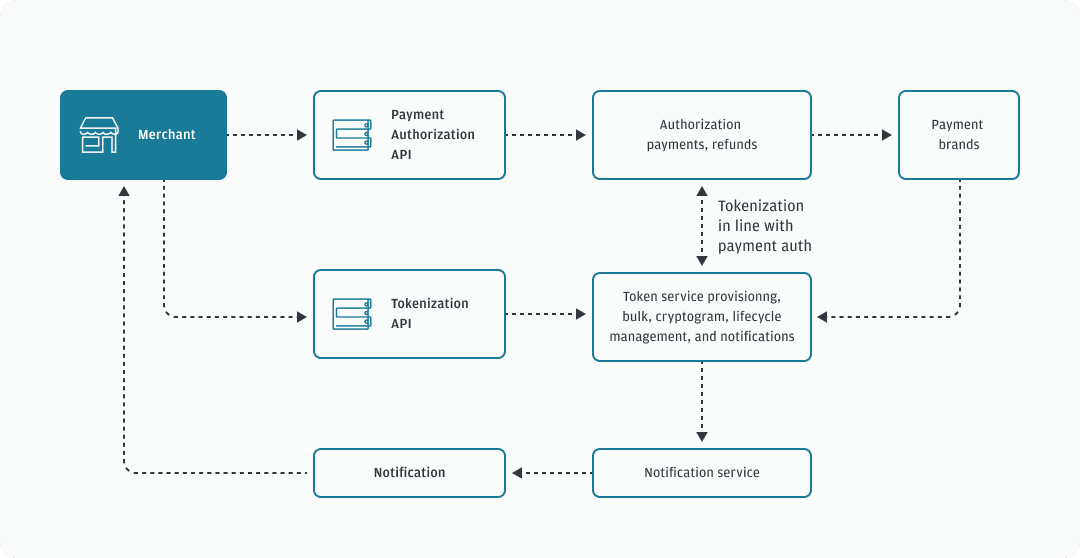

A liquidação ocorre on-chain por meio de contratos inteligentes que mantêm pagamentos em custódia e liberam fundos após a conclusão verificada do trabalho. Essa liquidação trustless elimina o risco de contraparte enquanto viabiliza microtransações para jobs de computação de curta duração. Protocols built on high-throughput blockchains like Solana can handle the transaction volume generated by thousands of simultaneous inference requests.

Mecanismos de staking alinham incentivos entre os participantes. Provedores de computação frequentemente fazem stake de tokens para demonstrar comprometimento e expor colateral que pode ser reduzido em caso de mau desempenho. Validators in Bittensor stake TAO tokens to gain influence in scoring miners and earn portions of block rewards. Token holders can delegate stake to validators they trust, similar to proof-of-stake consensus mechanisms.

A governança permite que detentores de tokens votem em parâmetros do protocolo, incluindo distribuição de recompensas, estruturas de taxas e upgrades de rede. Decentralized governance ensures that no central authority can unilaterally change rules or restrict access, maintaining the permissionless nature that differentiates these networks from traditional cloud providers.

A arquitetura contrasta fortemente com a computação em nuvem centralizada. Grandes provedores são donos de sua infraestrutura, definem preços sem concorrência de mercado, exigem contas e verificações de conformidade e mantêm controle sobre acesso e censura. Protocolos PinFi distribuem a propriedade por milhares de operadores independentes, permitem precificação transparente baseada em mercado, operam sem permissão e resistem à censura por meio da descentralização.

Tokenomics & Incentive Models

A economia de tokens fornece a estrutura de incentivos que coordena redes de computação distribuída. Tokens nativos cumprem múltiplas funções, incluindo pagamento por serviços, recompensas pela provisão de recursos, direitos de governança e requisitos de staking para participação na rede.

Mecanismos de emissão determinam como os tokens entram em circulação. Bittensor follows Bitcoin's model with a capped supply of 21 million TAO tokens and periodic halvings that reduce issuance over time. Currently 7,200 TAO are minted daily, split between miners who contribute computational resources and validators who ensure network quality. This creates scarcity similar to Bitcoin while directing inflation toward productive infrastructure.

Outros protocolos emitem tokens com base no uso da rede. Quando jobs de computação são executados, tokens recém-emitidos fluem para os provedores proporcionalmente aos recursos que forneceram. Essa ligação direta entre criação de valor e emissão de tokens garante que a inflação recompense produtividade real em vez de simples posse passiva de tokens.

O staking cria “skin in the game” para os participantes da rede. Provedores de computação fazem stake de tokens para registrar nós e demonstrar comprometimento. Mau desempenho ou tentativas de fraude resultam em slashing, em que tokens em stake são destruídos ou redistribuídos às partes afetadas. Essa penalidade econômica incentiva a entrega confiável de serviços e o comportamento honesto.

Validadores fazem stake de quantias maiores para ganhar influência na avaliação de qualidade e nas decisões de governança. In Bittensor's model, validators evaluate miners' outputs and submit weight matrices indicating which nodes provided valuable contributions. The Yuma Consensus aggregates these assessments weighted by validator stake to determine final reward distribution.

A dinâmica de oferta e demanda para tokens de computação opera em dois níveis. Do lado da oferta, mais nós entrando na rede aumentam a capacidade computacional disponível. As recompensas em tokens precisam ser suficientes para compensar custos de hardware, eletricidade e custo de oportunidade em relação a usos alternativos do equipamento. À medida que o preço do token sobe, prover computação se torna mais lucrativo, atraindo oferta adicional.

Do lado da demanda, o preço do token reflete o valor que os usuários atribuem ao acesso à rede. À medida que aplicações de IA proliferam e a escassez de computação se intensifica, aumenta a disposição a pagar por recursos descentralizados. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034, creating sustained demand for alternative compute sources.

A apreciação do valor do token beneficia todos os participantes. Provedores de hardware ganham mais pela mesma saída computacional. Operadores de nós iniciais se beneficiam da valorização das recompensas acumuladas. Desenvolvedores se beneficiam de uma alternativa descentralizada a provedores centralizados caros. Detentores de tokens que fazem stake ou fornecem liquidez capturam taxas da atividade na rede.

Modelos de risco abordam modos potenciais de falha. Tempo de inatividade de nós reduz ganhos à medida que jobs são roteados para alternativas disponíveis. Concentração geográfica cria problemas de latência para aplicações de edge que exigem processamento local. Efeitos de rede favorecem protocolos maiores, com hardware mais diverso e distribuição geográfica mais ampla.

A inflação de tokens precisa equilibrar a atração de nova oferta com a manutenção de valor para detentores existentes. Research on decentralized infrastructure protocols notes that sustainable tokenomics requires demand growth to outpace supply increases. Protocols implement burning mechanisms, where tokens used for payments are permanently removed from circulation, creating deflationary pressure that offsets inflationary issuance.

Estruturas de taxas variam entre redes. Algumas cobram usuários diretamente em tokens nativos. Outras aceitam stablecoins ou versões wrapped de grandes criptomoedas, com os tokens do protocolo servindo principalmente para governança e staking. Modelos híbridos usam tokens para acesso à rede enquanto liquidam pagamentos de computação em ativos estáveis para reduzir o risco de volatilidade.

O espaço de design para modelos de incentivos continua evoluindo à medida que protocolos experimentam diferentes abordagens para equilibrar interesses das partes e sustentar crescimento de longo prazo.

AI, Edge, and Real-World Infrastructure

Redes de computação tokenizadas viabilizam aplicações que aproveitam hardware distribuído para workloads de IA, processamento em edge e necessidades de infraestrutura especializada. A diversidade de casos de uso demonstra como modelos descentralizados podem resolver gargalos ao longo de toda a pilha computacional.

O treinamento distribuído de modelos de IA representa um caso de uso primário. Treinar grandes modelos de linguagem ou sistemas de visão computacional requer computação paralela massiva em múltiplas GPUs. Abordagens tradicionais concentram esse treinamento em data centers centralizados pertencentes a grandes provedores de nuvem. Redes descentralizadas permitem que o treinamento ocorra em nós distribuídos geograficamente, cada um contribuindo trabalho computacional coordenado por meio de orquestração baseada em blockchain.

Bittensor's subnet architecture enables specialized AI markets focused on specific tasks like text generation, image synthesis or data scraping. Miners compete to provide high-quality outputs for their chosen domains, with validators assessing performance and distributing rewards accordingly. This creates competitive markets where the best models and most efficient implementations naturally emerge through economic selection.

Workloads de edge computing se beneficiam particularmente da infraestrutura descentralizada. The global edge computing market was valued at $23.65 billion in 2024, driven by applications requiringlow latency and local processing. Dispositivos de IoT que geram dados de sensores de forma contínua precisam de análise imediata, sem atrasos de ida e volta para data centers distantes. Veículos autônomos exigem tomada de decisão em frações de segundo, algo que não tolera latência de rede.

Redes de computação descentralizadas podem colocar capacidade de processamento fisicamente próxima das fontes de dados. Uma fábrica que implanta sensores de IoT industrial pode alugar nós de borda na mesma cidade ou região, em vez de depender de nuvens centralizadas a centenas de quilômetros de distância. Industrial IoT applications accounted for the largest market share in edge computing in 2024, refletindo a natureza crítica do processamento local para manufatura e logística.

Renderização de conteúdo e fluxos de trabalho criativos consomem recursos significativos de GPU. Artistas renderizando cenas 3D, animadores produzindo filmes e desenvolvedores de jogos compilando assets precisam de processamento paralelo intensivo. Render Network specializes in distributed GPU rendering, conectando criadores a capacidade ociosa de GPU em todo o mundo. Esse modelo de marketplace reduz os custos de renderização enquanto fornece fluxos de receita para donos de GPUs durante períodos de baixa demanda.

Computação científica e aplicações de pesquisa enfrentam restrições orçamentárias ao acessar recursos de nuvem caros. Instituições acadêmicas, pesquisadores independentes e organizações menores podem aproveitar redes descentralizadas para rodar simulações, analisar conjuntos de dados ou treinar modelos especializados. A natureza permissionless significa que pesquisadores em qualquer região podem acessar recursos computacionais sem contas institucionais em nuvem ou análises de crédito.

Plataformas de games e metaverso exigem cálculos de renderização e física para experiências imersivas. À medida que mundos virtuais crescem em complexidade, aumentam as demandas computacionais para manter ambientes persistentes e suportar milhares de usuários simultâneos. Nós de computação distribuídos na borda podem fornecer processamento local para populações de jogadores regionais, reduzindo a latência enquanto distribuem os custos de infraestrutura entre provedores incentivados por tokens.

Inferência de IA em escala requer acesso contínuo a GPUs para servir previsões a partir de modelos treinados. Um chatbot atendendo milhões de consultas, um serviço de geração de imagens processando prompts de usuários ou um motor de recomendação analisando comportamento de uso precisam de computação sempre disponível. Redes descentralizadas fornecem redundância e distribuição geográfica que aumentam a confiabilidade em comparação com dependência de um único provedor.

Zonas geográficas pouco atendidas por grandes provedores de nuvem apresentam oportunidades para protocolos PinFi. Regiões com presença limitada de data centers enfrentam maior latência e custos ao acessar infraestrutura centralizada. Provedores locais de hardware nessas áreas podem oferecer capacidade de computação adaptada à demanda regional, ganhando recompensas em tokens enquanto melhoram o acesso local a capacidades de IA.

Requisitos de soberania de dados cada vez mais exigem que certas cargas de trabalho processem dados dentro de jurisdições específicas. Regulations like the EU Data Act require sensitive information to be processed locally, incentivando a implantação de infraestrutura de borda que cumpra regras de residência. Redes descentralizadas naturalmente suportam implantação de nós específica por jurisdição, mantendo coordenação global via liquidação baseada em blockchain.

Why It Matters: Implications for Crypto & Infrastructure

O surgimento de PinFi representa a expansão do cripto além de aplicações puramente financeiras, rumo à coordenação de infraestrutura do mundo real. Essa mudança traz implicações tanto para o ecossistema cripto quanto para as indústrias computacionais em geral.

Protocolos cripto demonstram utilidade além da especulação quando resolvem problemas tangíveis de infraestrutura. DePIN e PinFi criam sistemas econômicos que coordenam recursos físicos, provando que incentivos baseados em blockchain podem bootstrappar redes do mundo real. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, representando aproximadamente três vezes a capitalização total de mercado de cripto hoje.

A democratização do acesso à computação aborda uma assimetria fundamental no desenvolvimento de IA. Atualmente, capacidades avançadas de IA permanecem em grande parte concentradas em empresas de tecnologia bem financiadas que podem arcar com enormes clusters de GPU. Startups, pesquisadores e desenvolvedores em ambientes com recursos limitados enfrentam barreiras para participar da inovação em IA. Redes de computação descentralizadas reduzem essas barreiras ao fornecer acesso permissionless a hardware distribuído a preços determinados pelo mercado.

A criação de novas classes de ativos expande o panorama de investimento em cripto. Tokens de capacidade de computação representam propriedade em infraestrutura produtiva que gera receita por meio de uso no mundo real. Isso difere de ativos puramente especulativos ou tokens de governança sem mecanismos claros de captura de valor. Detentores de tokens essencialmente possuem fatias de um provedor de nuvem descentralizado, com valor atrelado à demanda por serviços computacionais.

Monopólios de infraestrutura tradicional enfrentam potencial disrupção. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control sobre mercados de computação, definindo preços sem competição direta. Alternativas descentralizadas introduzem dinâmicas de mercado em que milhares de provedores independentes competem, potencialmente reduzindo custos e melhorando a acessibilidade.

A indústria de IA se beneficia da redução da dependência de infraestrutura centralizada. Atualmente, o desenvolvimento de IA se concentra em grandes provedores de nuvem, criando pontos únicos de falha e risco de concentração. Over 50% of generative AI companies report GPU shortages as major obstacles. Redes distribuídas fornecem capacidade alternativa que pode absorver excesso de demanda e oferecer redundância contra interrupções na cadeia de suprimentos.

Melhorias em eficiência energética podem surgir de melhor utilização da capacidade. Rigs de jogos ociosos consomem energia em modo de espera sem produção efetiva. Operações de mineração com capacidade excedente buscam fontes adicionais de receita. Distributed networks put idle GPUs to productive use, melhorando a eficiência geral de recursos no ecossistema computacional.

Resistência à censura torna-se relevante para aplicações de IA. Provedores de nuvem centralizados podem negar serviço a usuários, aplicações específicas ou regiões inteiras. Redes descentralizadas operam de forma permissionless, permitindo desenvolvimento e implantação de IA sem necessidade de aprovação de gatekeepers. Isso é especialmente importante para aplicações controversas ou usuários em jurisdições restritivas.

Arquiteturas de privacidade de dados melhoram por meio de processamento local. Edge computing keeps sensitive data near its source em vez de transmitir para data centers distantes. Redes descentralizadas podem implementar técnicas de preservação de privacidade como federated learning, em que modelos treinam em dados distribuídos sem centralizar informações brutas.

A eficiência de mercado aumenta por meio de descoberta de preços transparente. A precificação de nuvem tradicional permanece opaca, com estruturas de taxas complexas e contratos corporativos negociados. Marketplaces descentralizados estabelecem preços spot claros para recursos de computação, permitindo aos desenvolvedores otimizar custos e aos provedores maximizar receita via dinâmicas competitivas.

A relevância de longo prazo decorre de vetores de demanda sustentados. Cargas de trabalho de IA continuarão crescendo à medida que aplicações se proliferam. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Computação permanecerá um gargalo fundamental, garantindo demanda contínua por modelos alternativos de infraestrutura.

Efeitos de rede favorecem protocolos iniciais que atingem massa crítica. À medida que mais provedores de hardware se juntam, a diversidade de recursos disponíveis aumenta. A distribuição geográfica melhora, reduzindo latência para aplicações de borda. Redes maiores atraem mais desenvolvedores, criando ciclos virtuosos de crescimento. Pioneiros em domínios específicos podem estabelecer vantagens duradouras.

Challenges & Risks

Apesar de aplicações promissoras, redes de computação tokenizada enfrentam desafios técnicos, econômicos e regulatórios significativos que podem limitar o crescimento ou a adoção.

Confiabilidade técnica permanece uma preocupação primária. Provedores de nuvem centralizados oferecem acordos de nível de serviço garantindo disponibilidade e desempenho. Redes distribuídas coordenam hardware de operadores independentes com níveis variados de profissionalismo e qualidade de infraestrutura. Falhas de nós, interrupções de rede ou janelas de manutenção criam lacunas de disponibilidade que devem ser geridas por meio de redundância e algoritmos de roteamento.

A verificação do trabalho efetivamente realizado apresenta desafios contínuos. Garantir que nós executem honestamente as computações em vez de retornar resultados falsos requer sistemas sofisticados de prova. Cryptographic proofs of compute adicionam overhead, mas continuam necessários para prevenir fraude. Mecanismos de verificação imperfeitos permitem ataques potenciais em que nós maliciosos reivindicam recompensas sem fornecer os serviços prometidos.

Limitações de latência e largura de banda afetam cargas de trabalho distribuídas. Running computations across geographically dispersed locations can cause atrasos em comparação com hardware co-localizado em data centers únicos. A largura de banda de rede entre nós limita os tipos de cargas de trabalho adequadas para processamento distribuído. Computações paralelas fortemente acopladas que exigem comunicação frequente entre nós sofrem degradação de desempenho.

A variabilidade na qualidade de serviço cria incerteza para aplicações em produção. Ao contrário de ambientes de nuvem gerenciada com desempenho previsível, pools de hardware heterogêneo produzem resultados inconsistentes. Um treinamento pode ser executado em H100s de nível empresarial ou em placas RTX de consumidor, dependendo da disponibilidade. Desenvolvedores de aplicações precisam projetar para essa variabilidade ou implementar filtros que restrinjam jobs a camadas específicas de hardware.

A sustentabilidade econômica exige equilibrar o crescimento da oferta com a expansão da demanda. Aumentos rápidos na capacidade de computação disponível sem crescimento correspondente da demanda deprimiriam os preços dos tokens e reduziriam a lucratividade dos provedores. Os protocolos devem gerir cuidadosamente a emissão de tokens para evitar inflação que ultrapasse o crescimento da utilidade. Sustainable tokenomics requires demand growth to outpace supply increases.

A compressão do valor do token representa riscos para participantes de longo prazo. À medida que novos provedores ingressam nas redes em busca de recompensas, o aumento da concorrência reduz os ganhos por nó. Participantes iniciais que se beneficiaram de recompensas mais altas podem ver seus retornos diminuírem com o tempo. Se a valorização do token não compensar essa diluição, a rotatividade de provedores aumenta e a estabilidade da rede sofre.

A volatilidade de mercado introduz risco financeiro para os participantes. Provedores recebem recompensas em tokens nativos cujo valor flutua. Um operador de hardware pode investir capital em GPUs esperando que os preços dos tokens permaneçam estáveis, apenas para enfrentar perdas se os preços caírem. Mecanismos de hedge e opções de pagamento em stablecoins podem mitigar a volatilidade, mas adicionam complexidade.

A incerteza regulatória em torno da classificação de tokens cria desafios de conformidade. Reguladores de valores mobiliários em várias jurisdições avaliam se tokens de computação constituem valores mobiliários sujeitos a requisitos de registro. Um status jurídico ambíguo restringe a participação institucional e cria riscos de responsabilidade para desenvolvedores de protocolos. Infrastructure tokenization faces regulation uncertainties que limitaram a adoção em comparação com estruturas tradicionais de finanças.

Regulamentações de proteção de dados impõem requisitos que redes distribuídas precisam navegar. Processar dados de cidadãos europeus exige conformidade com o GDPR, incluindo minimização de dados e direitos de exclusão. Aplicações de saúde devem satisfazer requisitos da HIPAA. Aplicações financeiras enfrentam obrigações de combate à lavagem de dinheiro. Redes descentralizadas complicam a conformidade quando os dados se movem entre múltiplas jurisdições e operadores independentes.

Contribuições de hardware podem desencadear escrutínio regulatório dependendo de como os acordos são estruturados. Jurisdições podem classificar determinados relacionamentos com provedores como ofertas de valores mobiliários ou produtos financeiros regulados. A linha entre provisão de infraestrutura e contratos de investimento permanece pouco clara em muitos arcabouços legais.

A concorrência de provedores de nuvem hiperescaláveis continua a se intensificar. Grandes provedores investem bilhões em nova capacidade de data centers e aceleradores de IA personalizados. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, em grande parte para infraestrutura de IA. Esses incumbentes bem capitalizados podem reduzir preços ou agrupar computação com outros serviços para manter participação de mercado.

A fragmentação da rede pode limitar a composabilidade. Múltiplos protocolos concorrentes criam ecossistemas isolados nos quais recursos de computação não podem ser facilmente transferidos entre redes. A falta de padronização em APIs, mecanismos de verificação ou padrões de tokens reduz a eficiência e aumenta os custos de mudança para desenvolvedores.

O risco de adotante inicial afeta protocolos sem histórico comprovado. Novas redes enfrentam um problema de “ovo e galinha” para atrair simultaneamente provedores de hardware e compradores de computação. Protocolos podem falhar em atingir a massa crítica necessária para operações sustentáveis. Investidores em tokens enfrentam risco de perda total se as redes colapsarem ou não conseguirem adoção.

Vulnerabilidades de segurança em smart contracts ou camadas de coordenação podem permitir roubo de fundos ou interrupção da rede. Decentralized networks face security challenges que exigem auditorias cuidadosas de smart contracts e programas de recompensa por bugs. Explorações que drenam tesourarias ou permitem ataques de pagamento duplo prejudicam a confiança e o valor da rede.

The Road Ahead & What to Watch

Acompanhar métricas e desenvolvimentos-chave fornece insights sobre a maturação e a trajetória de crescimento das redes de computação tokenizada.

Indicadores de crescimento da rede incluem o número de nós de computação ativos, distribuição geográfica, diversidade de hardware e capacidade total disponível medida em poder de computação ou equivalentes de GPU. A expansão nessas métricas sinaliza aumento da oferta e resiliência da rede. io.net accumulated over 300,000 verified GPUs ao integrar múltiplas fontes, demonstrando potencial de escalabilidade rápida quando protocolos coordenam efetivamente recursos díspares.

Métricas de uso revelam a demanda real por computação descentralizada. Jobs de computação ativos, total de horas de processamento entregues e o mix de tipos de cargas de trabalho mostram se as redes atendem a aplicações reais além da especulação. Akash witnessed notable surge in quarterly active leases após expandir o suporte a GPUs, indicando apetite de mercado por alternativas descentralizadas às nuvens tradicionais.

A capitalização de mercado dos tokens e as valorizações totalmente diluídas fornecem avaliações de mercado do valor do protocolo. Comparar valorizações com receita real ou throughput de computação revela se os tokens precificam expectativas de crescimento futuro ou refletem a utilidade atual. Bittensor's TAO token reached $750 during peak hype in March 2024, ilustrando interesse especulativo junto à adoção genuína.

Parcerias com empresas de IA e adotantes corporativos sinalizam validação mainstream. Quando laboratórios de IA estabelecidos, desenvolvedores de modelos ou aplicações em produção implantam cargas de trabalho em redes descentralizadas, isso demonstra que a infraestrutura distribuída atende a requisitos do mundo real. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, mostrando compromisso corporativo com arquiteturas distribuídas.

Atualizações de protocolo e adição de funcionalidades indicam momentum contínuo de desenvolvimento. Integração de novos tipos de GPU, sistemas de orquestração aprimorados, mecanismos de verificação melhorados ou melhorias de governança mostram iteração ativa em direção a uma infraestrutura melhor. Bittensor's Dynamic TAO upgrade in 2025 deslocou mais recompensas para sub-redes de alto desempenho, demonstrando tokenomics adaptativa.

Desenvolvimentos regulatórios moldam o ambiente operacional. Uma classificação favorável de tokens de infraestrutura ou orientações claras sobre requisitos de conformidade reduziriam a incerteza jurídica e permitiriam maior participação institucional. Por outro lado, regulações restritivas podem limitar o crescimento em jurisdições específicas.

Dinâmicas competitivas entre protocolos determinam a estrutura de mercado. O espaço de infraestrutura de computação pode se consolidar em torno de algumas redes dominantes que alcançam fortes efeitos de rede, ou permanecer fragmentado com protocolos especializados atendendo a diferentes nichos. Padrões de interoperabilidade podem viabilizar coordenação entre redes, melhorando a eficiência geral do ecossistema.

Modelos híbridos combinando elementos centralizados e descentralizados podem emergir. Empresas podem usar nuvens tradicionais para capacidade básica enquanto recorrem a redes descentralizadas durante picos de demanda. Essa abordagem oferece previsibilidade de serviços gerenciados enquanto captura economias de custo de alternativas distribuídas durante períodos de overflow.

Redes consorciadas podem se formar quando participantes da indústria operam conjuntamente infraestrutura descentralizada. Empresas de IA, provedores de nuvem, fabricantes de hardware ou instituições acadêmicas podem estabelecer redes compartilhadas que reduzem requisitos de capital individuais ao mesmo tempo em que mantêm governança descentralizada. Esse modelo pode acelerar a adoção entre organizações avessas a risco.

A especialização vertical parece provável à medida que protocolos se otimizam para casos de uso específicos. Algumas redes podem focar exclusivamente em treinamento de IA, outras em inferência, algumas em computação de borda, outras em rendering ou computação científica. Infraestrutura especializada atende melhor a requisitos particulares de cargas de trabalho em comparação com alternativas de propósito geral.

A integração com ferramentas e frameworks de IA existentes será crucial. Compatibilidade perfeita com bibliotecas populares de machine learning, sistemas de orquestração e pipelines de deployment reduz fricção para desenvolvedores. io.net supports Ray-native orchestration, reconhecendo que desenvolvedores preferem fluxos de trabalho padronizados a implementações personalizadas específicas de protocolo.

Considerações de sustentabilidade podem influenciar cada vez mais o design de protocolos. Mecanismos de consenso energeticamente eficientes, incentivos ao uso de energia renovável para operadores de nós ou integração de créditos de carbono podem diferenciar protocolos que atraem usuários ambientalmente conscientes. À medida que o consumo de energia da IA recebe maior escrutínio, redes descentralizadas podem posicionar a eficiência como uma vantagem competitiva.

Media coveragee a atenção da comunidade cripto servem como indicadores antecedentes da conscientização mainstream. O aumento nas discussões sobre protocolos específicos, o crescimento no interesse em buscas ou o aumento de seguidores em redes sociais frequentemente precedem uma adoção mais ampla e a valorização dos tokens. No entanto, ciclos de hype podem criar sinais enganosos, desconectados do crescimento fundamental.

Conclusão

O Financiamento de Infraestrutura Física (Physical Infrastructure Finance) representa a evolução das criptomoedas na coordenação de recursos computacionais do mundo real. Ao tokenizar a capacidade de computação, os protocolos PinFi criam mercados em que GPUs ociosas se tornam ativos produtivos, gerando rendimento por meio de cargas de trabalho de IA, processamento de borda e necessidades de infraestrutura especializada.

A convergência entre a demanda insaciável da IA por poder de computação e a capacidade das criptomoedas de coordenar sistemas distribuídos por meio de incentivos econômicos cria uma proposta de valor convincente. GPU shortages affecting over 50% of generative AI companies demonstram a gravidade dos gargalos de infraestrutura. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 sinalizam o reconhecimento, pelo mercado, de que modelos distribuídos podem capturar oferta latente.

Protocolos como Bittensor, Render, Akash e io.net demonstram abordagens variadas para o mesmo desafio fundamental: corresponder, de forma eficiente, a oferta de computação à demanda por meio de coordenação permissionless baseada em blockchain. Cada rede experimenta diferentes tokenômicas, mecanismos de verificação e aplicações-alvo, contribuindo para um ecossistema mais amplo que explora o espaço de design para infraestrutura descentralizada.

As implicações se estendem para além das criptomoedas, alcançando a indústria de IA e a infraestrutura computacional de maneira mais ampla. O acesso democratizado a recursos de GPU reduz as barreiras para inovação em IA. A menor dependência de oligopólios de nuvem centralizados introduz dinâmicas competitivas que podem melhorar preços e acessibilidade. Novas classes de ativos emergem à medida que tokens passam a representar propriedade em infraestrutura produtiva, em vez de pura especulação.

Desafios significativos permanecem. Confiabilidade técnica, mecanismos de verificação, sustentabilidade econômica, incerteza regulatória e competição com incumbentes bem capitalizados representam riscos. Nem todo protocolo irá sobreviver, e muitos tokens podem se mostrar supervalorizados em relação à utilidade fundamental. Mas o insight central que impulsiona o PinFi parece sólido: existe uma imensa capacidade computacional ociosa no mundo, uma enorme demanda por infraestrutura de IA, e a coordenação via blockchain pode casar essas curvas desalinhadas de oferta e demanda.

À medida que a demanda por IA continua explodindo, a camada de infraestrutura que alimenta essa tecnologia se tornará cada vez mais crítica. Se essa infraestrutura permanecer concentrada em poucos provedores centralizados ou evoluir para modelos de propriedade distribuída, coordenados por incentivos criptoeconômicos, pode definir o cenário competitivo do desenvolvimento de IA na próxima década.

O financiamento de infraestrutura do futuro pode se parecer menos com o project finance tradicional e mais com redes tokenizadas de hardware distribuído globalmente, em que qualquer pessoa com uma GPU pode se tornar provedora de infraestrutura e em que o acesso não exige nenhuma permissão além do pagamento a preço de mercado. Isso representa uma reimaginação fundamental de como recursos computacionais são possuídos, operados e monetizados — um modelo em que protocolos cripto demonstram utilidade além da especulação financeira ao solucionar problemas concretos no mundo físico.