Індустрія штучного інтелекту стикається з критичним інфраструктурним вузьким місцем. Навчання великих мовних моделей потребує колосальних обчислювальних ресурсів, крайові пристрої множаться експоненційними темпами, а дефіцит GPU став визначальною обмежувальною умовою епохи AI. Тим часом традиційні постачальники хмарних послуг насилу встигають за зростаючим попитом, зберігаючи монополістичний контроль над доступом і ціноутворенням.

Over 50% of generative AI companies report GPU shortages як головну перешкоду для масштабування. AI computing power is expected to increase by roughly 60 times by the end of 2025 порівняно з I кварталом 2023 року. Ця «обчислювальна гонка озброєнь» відкрила можливість для криптопротоколів запропонувати децентралізовану альтернативу.

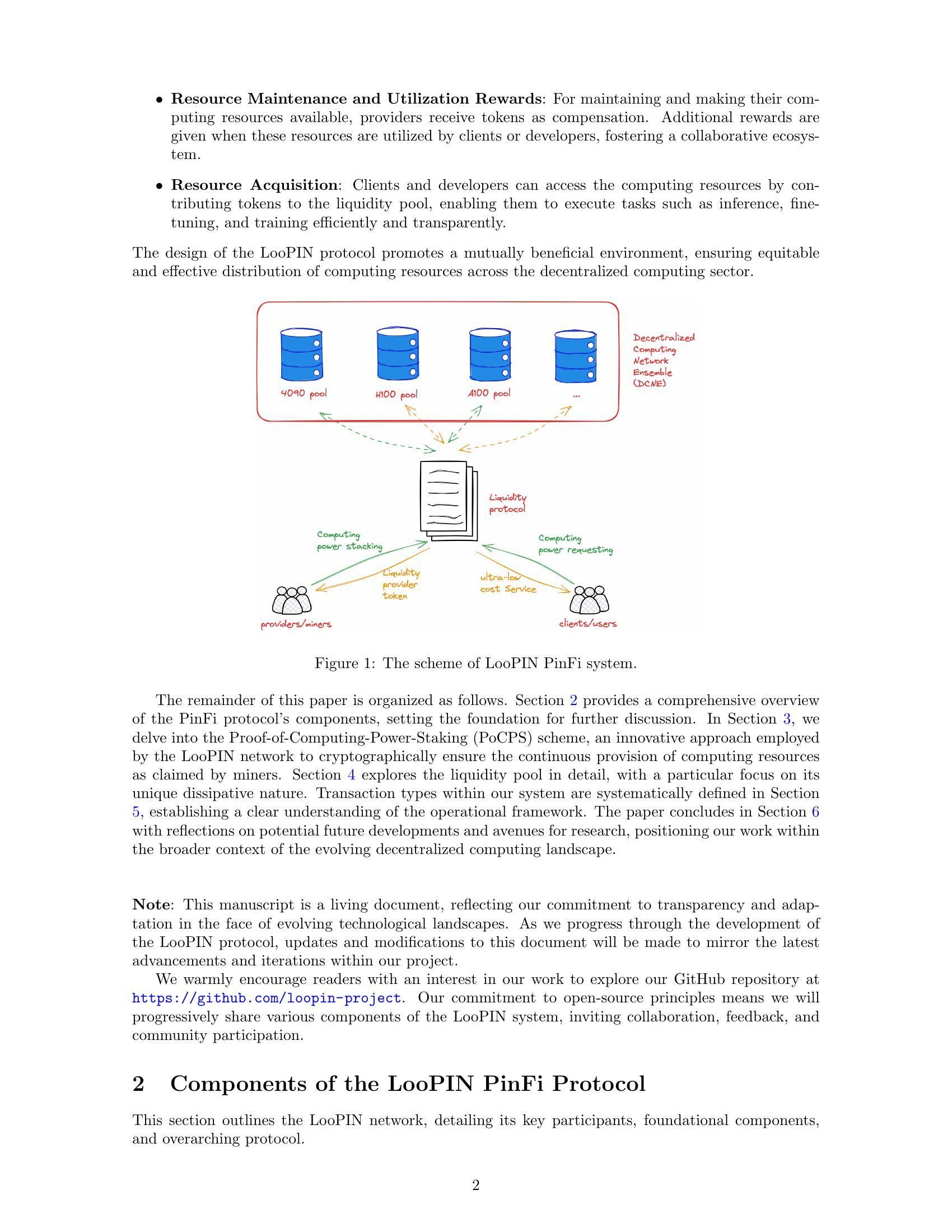

На сцену виходить Physical Infrastructure Finance, або PinFi. Ця нова концепція розглядає обчислювальні потужності як токенізований актив, яким можна торгувати, стейкати й монетизувати в блокчейн-мережах. Замість централізованих дата-центрів протоколи PinFi агрегують невикористану GPU-потужність незалежних операторів, ігрових рігів, майнінгових ферм та крайових пристроїв у розподілені маркетплейси, доступні розробникам AI по всьому світу.

Нижче ми розглянемо, як реальні обчислювальні потужності перетворюються на криптоекономічну інфраструктуру, розберемо механіку токенізованих обчислювальних мереж, економічні моделі стимулювання учасників, архітектуру верифікації та розрахунків і наслідки як для криптоіндустрії, так і для галузі AI.

Чому PinFi саме зараз? Макро- та технічні драйвери

Обчислювальне «горлечко пляшки», з яким стикається AI-індустрія, походить із фундаментальних обмежень пропозиції. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, залишивши багатьох користувачів у боротьбі за доступ. The global AI chip market reached $123.16 billion in 2024 і, за прогнозами, сягне $311.58 млрд до 2029 року, що відображає вибуховий попит, який значно випереджає виробничі потужності.

Дефіцит GPU проявляється в різних формах. Традиційні хмарні провайдери тримають черги очікування на преміальні GPU-інстанси. AWS charges $98.32 per hour for an 8-GPU H100 instance, що робить передові можливості AI недосяжними для багатьох розробників і стартапів. Ціни на обладнання залишаються високими через обмеження пропозиції, HBM3 pricing rising 20-30% year-over-year.

Концентрація обчислювальної потужності в руках кількох великих хмарних провайдерів створює додаткове тертя. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, однак доступ і далі обмежується контрактами, географічними рамками та вимогами KYC. Така централізація стримує інновації та створює «єдині точки відмови» для критичної інфраструктури.

Тим часом величезні обсяги обчислювальних потужностей простоюють. Ігрові ріги не використовуються в робочий час. Криптомайнери шукають нові джерела доходу на тлі зміни економіки майнінгу. Дата-центри мають надлишкову потужність у непікові години. The decentralized compute market has grown from $9 billion in 2024 і, за прогнозами, сягне $100 млрд до 2032 року, що свідчить про визнання ринком того, що розподілені моделі можуть залучити цей латентний ресурс.

Перетин блокчейн-технологій і фізичної інфраструктури дозрів у вигляді децентралізованих мереж фізичної інфраструктури (DePIN). Протоколи DePIN використовують токен-інсентиви, щоб координувати розгортання й експлуатацію реальної інфраструктури. Messari identified DePIN's total addressable market at $2.2 trillion, потенційно до $3.5 трлн до 2028 року.

PinFi є застосуванням принципів DePIN саме до обчислювальної інфраструктури. Воно розглядає обчислювальні ресурси як токенізовані активи, що генерують дохід завдяки продуктивному використанню. Така модель перетворює обчислення з послуги, орендованої у централізованих провайдерів, на товар, яким торгують на відкритих, бездозвільних ринках.

Що таке PinFi та токенізовані обчислення?

Physical Infrastructure Finance визначає модель, у якій фізичні обчислювальні активи подаються у вигляді цифрових токенів у блокчейнах, що дає змогу децентралізованої власності, експлуатації та монетизації. На відміну від традиційних протоколів децентралізованих фінансів, які працюють лише з цифровими активами, PinFi створює мости між офчейн-фізичними ресурсами та ончейн-економікою.

Academic research defines tokenization як «процес конвертації прав, одиниці володіння активом, боргу чи навіть фізичного активу в цифровий токен у блокчейні». Для обчислювальних ресурсів це означає, що окремі GPU, серверні кластери чи крайові пристрої представляються токенами, які відображають їхню потужність, доступність і використання.

PinFi принципово відрізняється від стандартного фінансування інфраструктури чи звичних DeFi-протоколів. Традиційне інфраструктурне фінансування передбачає довгострокові боргові або пайові інвестиції у великі капіталомісткі проєкти. DeFi-протоколи переважно забезпечують торгівлю, кредитування або отримання дохідності на крипто-нейтинг активи. PinFi перебуває на перетині цих підходів, застосовуючи криптоекономічні стимули для координації реальних обчислювальних ресурсів при збереженні ончейн-розрахунків і управління.

Кілька протоколів ілюструють модель PinFi. Bittensor operates as a decentralized AI network, де учасники вносять машинні моделі та обчислювальні ресурси до спеціалізованих сабнетів, зосереджених на конкретних завданнях. Токен TAO стимулює внесок залежно від інформаційної цінності, яку учасник надає колективному інтелекту мережі. With over 7,000 miners, що надають обчислення, Bittensor формує ринки для AI-інференсу та навчання моделей.

Render Network aggregates idle GPUs globally для розподілених завдань GPU-рендерингу. Спочатку орієнтований на 3D-рендеринг для артистів і контент-кріейторів, Render розширився до AI-навантажень. Токен RNDR виступає платіжним засобом за рендер-завдання та винагородою для постачальників GPU за надану потужність.

Akash Network operates as a decentralized cloud marketplace, що використовує невикористані потужності дата-центрів. Через систему зворотних аукціонів деплойєри обчислень задають вимоги, а провайдери змагаються, подаючи ставки. Токен AKT забезпечує управління, стейкінг і розрахунки в мережі. Akash witnessed notable surge in quarterly active leases після того, як мережа додала GPU поряд із традиційними CPU-ресурсами.

io.net has aggregated over 300,000 verified GPUs, інтегруючи ресурси незалежних дата-центрів, криптомайнерів та інших DePIN-мереж, включно з Render і Filecoin. Платформа зосереджена саме на AI й ML-навантаженнях, дозволяючи розробникам розгортати GPU-кластери у 130 країнах за лічені хвилини.

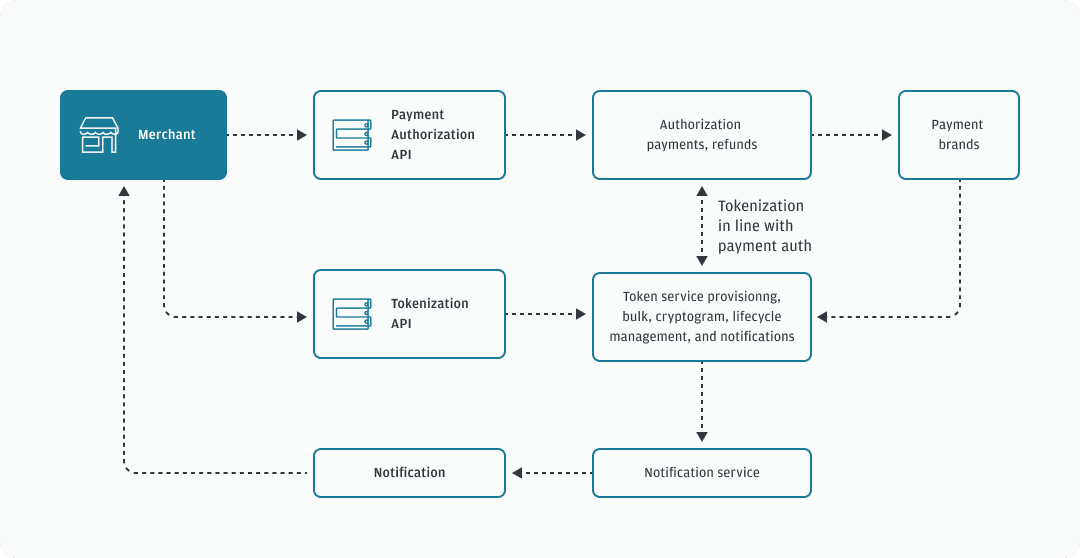

Механіка токенізованих обчислень має спільний шаблон у цих протоколах. Постачальники обчислень реєструють своє обладнання в мережі, проходячи верифікацію потужності та можливостей. Смарт-контракти керують співвідношенням попиту та пропозиції, маршрутизуючи завдання до доступних вузлів залежно від вимог, ціни та географічних обмежень. Токен-нагороди стимулюють як надання «заліза», так і якісне надання послуг.

Вартість створюється реальним використанням, а не спекуляцією. Коли розробник AI навчає модель, використовуючи розподілені GPU-ресурси, платежі спрямовуються провайдерам, чиє обладнання виконало роботу. Обчислювальна потужність стає продуктивним активом, що генерує дохід, подібно до того, як валідатори proof-of-stake отримують винагороди за безпеку мереж. Це формує стійку економіку, де вартість токена корелює з корисністю мережі.

Архітектура інфраструктури: вузли, маркетплейси, розрахунки

Архітектура токенізованих обчислень потребує координації кількох шарів. У її основі — мережа незалежних постачальників, які розгортають обладнання, реєструються в протоколах і надають потужності в оренду. Це можуть бути як власники ігрових ПК, так і професійні оператори дата-центрів та криптомайнінгові ферми, що шукають додаткові джерела доходу.

Надання вузла починається, коли постачальник під’єднує обладнання до мережі. Protocols like io.net support diverse GPU types — від споживчих NVIDIA RTX 4090 до серверних H100 та A100. Провайдер установлює клієнтське ПЗ, яке відкриває потужності для оркестраційного шару мережі, зберігаючи при цьому периметри безпеки й запобігаючи несанкціонованому доступу.

Механізми верифікації гарантують, що заявлена потужність відповідає фактичним можливостям. Деякі протоколи застосовують криптографічні докази обчислень, де вузли мають продемонструвати, що вони коректно виконали конкретні обчислення. Bittensor використовує свій механізм Yuma Consensus, де валідатори оцінюють якість результатів машинного навчання від майнерів і призначають бали, які визначають розподіл винагород. Вузли, що надають неякісні результати або намагаються шахраювати, отримують зменшену компенсацію або піддаються скороченню застейканих токенів (slashing).

Тестування затримки (latency benchmarking) допомагає зіставити робочі навантаження з відповідним обладнанням. Інференс ШІ потребує інших характеристик продуктивності, ніж навчання моделей або 3D‑рендеринг. Географічне розташування впливає на затримку для застосунків периферійних обчислень (edge computing), де обробка має відбуватися поруч із джерелами даних. Ринок edge‑обчислень досяг $23,65 млрд у 2024 році і, за прогнозами, сягне $327,79 млрд до 2033 року, що зумовлено попитом на локалізовану обробку.

Рівень маркетплейсу з’єднує попит на обчислення з їхньою пропозицією. Коли розробникам потрібні GPU‑ресурси, вони задають вимоги, включно з обчислювальною потужністю, обсягом пам’яті, тривалістю та максимальною ціною. Akash застосовує модель зворотного аукціону, де деплойери задають умови, а провайдери змагаються заявками за контракти. Render використовує алгоритми динамічного ціноутворення, які коригують тарифи залежно від завантаження мережі та ринкових умов.

Алгоритми маршрутизації задач оптимізують розміщення обчислювальних завдань по доступних вузлах. Враховуються характеристики обладнання, поточне завантаження, географічна близькість, історична продуктивність і ціна. Оркестраційний рівень io.net обробляє контейнеризовані робочі процеси й підтримує Ray‑native оркестрацію для розподілених робочих навантажень машинного навчання.

Розрахунки відбуваються ончейн через смарт‑контракти, які ескроять платежі та вивільняють кошти після підтвердженої завершеності роботи. Такі бездовірчі (trustless) розрахунки усувають ризик контрагента й водночас уможливлюють мікротранзакції для короткотривалих обчислювальних задач. Протоколи, побудовані на високопродуктивних блокчейнах на кшталт Solana, здатні обробити обсяг транзакцій, що генерується тисячами одночасних запитів на інференс.

Механізми стейкінгу узгоджують стимули між учасниками. Провайдери обчислень часто стейкають токени, щоб продемонструвати залученість і надати заставу, яка може бути скорочена (slashed) за низьку продуктивність. Валідатори в Bittensor стейкають токени TAO, щоб отримати вплив на оцінювання майнерів і заробляти частину блокових винагород. Власники токенів можуть делегувати стейк валідаторам, яким вони довіряють, подібно до механізмів консенсусу proof‑of‑stake.

Механізми управління (governance) дозволяють власникам токенів голосувати за параметри протоколу, включно з розподілом винагород, структурою комісій і оновленнями мережі. Децентралізоване управління гарантує, що жоден центральний орган не зможе одноосібно змінити правила чи обмежити доступ, зберігаючи permissionless‑характер, який відрізняє ці мережі від традиційних хмарних провайдерів.

Ця архітектура різко контрастує з централізованими хмарними обчисленнями. Великі провайдери володіють власною інфраструктурою, встановлюють ціни без ринкової конкуренції, вимагають облікові записи й проходження комплаєнс‑перевірок, а також зберігають контроль над доступом і цензурою. Протоколи PinFi розподіляють право власності між тисячами незалежних операторів, забезпечують прозоре ринкове ціноутворення, працюють без дозволів (permissionlessly) і протидіють цензурі завдяки децентралізації.

Tokenomics & Моделі стимулів

Токен‑економіка формує структуру стимулів, яка координує розподілені обчислювальні мережі. Рідні токени виконують кілька функцій: платіж за послуги, винагороди за надання ресурсів, права управління та стейкінгові вимоги для участі в мережі.

Механізми емісії визначають, як токени потрапляють в обіг. Bittensor наслідує модель Bitcoin з обмеженою пропозицією у 21 мільйон токенів TAO і періодичними халвінгами, що зменшують емісію з часом. Наразі щодня карбується 7 200 TAO, які діляться між майнерами, що надають обчислювальні ресурси, і валідаторами, які забезпечують якість мережі. Це створює дефіцит, подібний до Bitcoin, водночас спрямовуючи інфляцію на продуктивну інфраструктуру.

Інші протоколи випускають токени залежно від використання мережі. Коли виконуються обчислювальні задачі, новостворені токени надходять провайдерам пропорційно до наданих ними ресурсів. Такий прямий зв’язок між створенням цінності та емісією токенів гарантує, що інфляція винагороджує реальну продуктивність, а не пасивне утримання токенів.

Стейкінг створює «ставку в грі» (skin in the game) для учасників мережі. Провайдери обчислень стейкають токени, щоб зареєструвати вузли й продемонструвати відданість. Низька продуктивність або спроби шахрайства призводять до слешингу, коли застейкані токени знищуються або перерозподіляються між постраждалими сторонами. Це економічне покарання стимулює надійне надання послуг і чесну поведінку.

Валідатори стейкають більші суми, щоб отримати вплив на оцінювання якості та ухвалення рішень з управління. У моделі Bittensor валідатори оцінюють результати майнерів і подають матриці ваг, які вказують, які вузли зробили цінний внесок. Yuma Consensus агрегує ці оцінки з урахуванням стейку валідаторів, щоб визначити остаточний розподіл винагород.

Динаміка попиту й пропозиції для обчислювальних токенів працює на двох рівнях. З боку пропозиції, приєднання більшої кількості вузлів збільшує доступну обчислювальну потужність. Токен‑винагороди мають бути достатніми, щоб компенсувати вартість обладнання, електроенергії та альтернативні витрати від інших способів використання цього обладнання. У міру зростання ціни токена надання обчислень стає більш прибутковим, залучаючи додаткову пропозицію.

З боку попиту ціна токена відображає цінність, яку користувачі надають доступу до мережі. У міру поширення застосунків ШІ та посилення дефіциту обчислень готовність платити за децентралізовані ресурси зростає. Очікується, що ринок апаратного забезпечення для ШІ виросте з $66,8 млрд у 2025 році до $296,3 млрд до 2034 року, створюючи стійкий попит на альтернативні джерела обчислень.

Зростання вартості токена приносить вигоду всім учасникам. Постачальники обладнання заробляють більше за той самий обсяг обчислень. Ранні оператори вузлів виграють від подорожчання накопичених винагород. Розробники отримують децентралізовану альтернативу дорогим централізованим провайдерам. Власники токенів, які стейкають або надають ліквідність, отримують комісії від активності мережі.

Моделі ризику враховують потенційні режими відмов. Простої вузлів знижують їхній дохід, оскільки задачі маршрутизуються до доступних альтернатив. Географічна концентрація спричиняє проблеми із затримкою для edge‑застосунків, яким потрібна локальна обробка. Мережеві ефекти сприяють більшим протоколам із більш різноманітним апаратним забезпеченням і географічним розподілом.

Інфляція токенів має збалансувати залучення нової пропозиції з підтриманням вартості для наявних власників. Дослідження децентралізованих інфраструктурних протоколів зазначають, що стійка токен‑економіка вимагає, аби зростання попиту випереджало збільшення пропозиції. Протоколи впроваджують механізми спалювання, коли токени, використані для платежів, назавжди вилучаються з обігу, створюючи дефляційний тиск, який компенсує інфляційну емісію.

Структури комісій відрізняються між мережами. Деякі стягують плату з користувачів безпосередньо в рідних токенах. Інші приймають стейблкоїни або обгорнуті версії основних криптовалют, тоді як токени протоколу переважно виконують функції управління й стейкінгу. Гібридні моделі використовують токени для доступу до мережі, а розрахунки за обчислення здійснюють у стабільних активах, щоб зменшити ризик волатильності.

Простір дизайну моделей стимулів продовжує розвиватися, оскільки протоколи експериментують з різними підходами до балансування інтересів стейкхолдерів і підтримання довгострокового зростання.

ШІ, Edge та реальна інфраструктура

Токенізовані обчислювальні мережі уможливлюють застосунки, що використовують розподілене обладнання для навантажень ШІ, edge‑обробки та спеціалізованих інфраструктурних потреб. Різноманіття кейсів демонструє, як децентралізовані моделі можуть усувати вузькі місця на всіх рівнях обчислювального стеку.

Розподілене навчання моделей ШІ є одним з основних сценаріїв. Навчання великих мовних моделей або систем комп’ютерного зору потребує масивних паралельних обчислень на численних GPU. Традиційні підходи концентрують це навчання в централізованих дата‑центрах, що належать великим хмарним провайдерам. Децентралізовані мережі дозволяють проводити навчання на географічно розподілених вузлах, кожен з яких робить обчислювальний внесок, координований через блокчейн‑оркестрацію.

Архітектура сабнетів Bittensor дає змогу створювати спеціалізовані AI‑ринкі, зосереджені на конкретних задачах, як‑от генерування тексту, синтез зображень чи збір даних (data scraping). Майнери змагаються за надання високоякісних результатів у вибраних ними доменах, а валідатори оцінюють продуктивність і відповідно розподіляють винагороди. Це створює конкурентні ринки, де найкращі моделі та найефективніші реалізації природним чином виринають унаслідок економічного відбору.

Edge‑навантаження особливо сильно виграють від децентралізованої інфраструктури. Світовий ринок edge‑обчислень був оцінений у $23,65 млрд у 2024 році, що зумовлено застосунками, яким потрібнанизьку затримку та локальну обробку. Пристрої IoT, що генерують безперервні дані датчиків, потребують негайного аналізу без затримок на зворотний шлях до віддалених дата-центрів. Автономні транспортні засоби вимагають прийняття рішень за частки секунди, що не може миритися з мережевою затримкою.

Децентралізовані обчислювальні мережі можуть розміщувати обчислювальні потужності фізично близько до джерел даних. Фабрика, що розгортає промислові IoT-датчики, може орендувати edge-вузли в межах того ж самого міста або регіону, а не покладатися на централізовані хмари за сотні миль. Industrial IoT applications accounted for the largest market share in edge computing in 2024, відображаючи критичну важливість локалізованої обробки для виробництва та логістики.

Візуалізація контенту та творчі робочі процеси споживають значні ресурси GPU. Художники, які рендерять 3D-сцени, аніматори, що створюють фільми, та гейм-розробники, які компілюють асети, усі потребують інтенсивної паралельної обробки. Render Network specializes in distributed GPU rendering, з’єднуючи креаторів із простоюючими GPU по всьому світу. Така модель маркетплейсу знижує витрати на рендеринг, водночас забезпечуючи джерела доходу для власників GPU у періоди низького навантаження.

Наукові обчислення та дослідницькі застосунки стикаються з бюджетними обмеженнями при доступі до дорогих хмарних ресурсів. Академічні установи, незалежні дослідники та невеликі організації можуть використовувати децентралізовані мережі для запуску симуляцій, аналізу наборів даних або навчання спеціалізованих моделей. Бездозвільна (permissionless) природа означає, що дослідники в будь-якій географії можуть отримати доступ до обчислювальних ресурсів без інституційних хмарних акаунтів чи перевірок кредитоспроможності.

Геймінг і платформи метавсесвіту потребують рендерингу та фізичних розрахунків для створення занурювального досвіду. У міру зростання складності віртуальних світів зростають і обчислювальні вимоги для підтримки постійних середовищ та обслуговування тисяч одночасних користувачів. Розподілені по периметру (edge) обчислювальні вузли можуть забезпечувати локальну обробку для регіональних груп гравців, зменшуючи затримку та розподіляючи інфраструктурні витрати між провайдерами, стимульованими токенами.

AI‑інференс у масштабі вимагає безперервного доступу до GPU для обробки запитів до навчених моделей. Чат-бот, що обробляє мільйони запитів, сервіс генерації зображень, який опрацьовує користувацькі промпти, або рекомендательний рушій, що аналізує поведінку користувачів, усі потребують постійно доступних обчислювальних ресурсів. Децентралізовані мережі забезпечують надлишковість і географічний розподіл, що підвищує надійність порівняно із залежністю від одного провайдера.

Географічні зони, які недостатньо обслуговуються великими хмарними провайдерами, створюють можливості для протоколів PinFi. Регіони з обмеженою присутністю дата-центрів стикаються з вищою затримкою та витратами при доступі до централізованої інфраструктури. Місцеві постачальники «заліза» в цих областях можуть пропонувати обчислювальні потужності, зорієнтовані на регіональний попит, заробляючи токени та покращуючи локальний доступ до AI‑можливостей.

Вимоги до суверенітету даних дедалі частіше вимагають, щоб певні робочі навантаження оброблялися в межах конкретних юрисдикцій. Regulations like the EU Data Act require sensitive information to be processed locally, стимулюючи розгортання edge‑інфраструктури, що відповідає правилам розміщення даних. Децентралізовані мережі природно підтримують розгортання вузлів у певних юрисдикціях, одночасно зберігаючи глобальну координацію через блокчейн-розрахунки.

Чому це важливо: наслідки для крипто та інфраструктури

Поява PinFi означає розширення крипто за межі суто фінансових застосунків до координації реальної інфраструктури. Це зрушення має наслідки як для криптоекосистеми, так і для ширших галузей обчислень.

Крипто-протоколи демонструють корисність поза спекуляцією, коли вони розв’язують реальні інфраструктурні проблеми. DePIN і PinFi створюють економічні системи, які координують фізичні ресурси, доводячи, що блокчейн-стимули можуть бустапити (bootstrap) мережі в реальному світі. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, що приблизно втричі перевищує сьогоднішню загальну ринкову капіталізацію крипто.

Демократизація доступу до обчислень вирішує фундаментальну асиметрію в розвитку AI. Наразі передові AI‑можливості переважно зосереджені в добре профінансованих технологічних компаніях, які можуть дозволити собі масивні GPU‑кластери. Стартапи, дослідники та розробники в умовах обмежених ресурсів стикаються з бар’єрами для участі в AI‑інноваціях. Децентралізовані обчислювальні мережі знижують ці бар’єри, пропонуючи бездозвільний доступ до розподіленого «заліза» за ринковими цінами.

Створення нових класів активів розширює інвестиційний ландшафт у крипто. Токени обчислювальної потужності представляють собою частку у продуктивній інфраструктурі, яка генерує дохід через реальне використання. Це відрізняється від суто спекулятивних активів або токенів управління без чітких механізмів захоплення вартості. Власники токенів по суті володіють часткою децентралізованого хмарного провайдера, а вартість прив’язана до попиту на обчислювальні послуги.

Традиційні інфраструктурні монополії можуть зіткнутися з потенційним витісненням. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control над ринками обчислень, встановлюючи ціни без прямої конкуренції. Децентралізовані альтернативи вводять ринкову динаміку, де тисячі незалежних провайдерів конкурують між собою, потенційно знижуючи витрати та покращуючи доступність.

AI‑індустрія виграє від зменшення залежності від централізованої інфраструктури. Наразі розвиток AI зосереджений навколо великих хмарних провайдерів, створюючи єдині точки відмови та ризик концентрації. Over 50% of generative AI companies report GPU shortages as major obstacles. Розподілені мережі забезпечують альтернативні потужності, які можуть поглинати надлишковий попит і надавати надлишковість проти збоїв у ланцюгах постачання.

Покращення енергоефективності може виникнути завдяки кращому використанню потужностей. Ігрові риги, що простоюють, споживають енергію в режимі очікування без продуктивного виходу. Майнингові операції з надлишковою потужністю шукають додаткові джерела доходу. Distributed networks put idle GPUs to productive use, підвищуючи загальну ефективність використання ресурсів в обчислювальній екосистемі.

Спроможність протистояти цензурі стає актуальною для AI‑застосунків. Централізовані хмарні провайдери можуть відмовити в обслуговуванні конкретним користувачам, застосункам або цілим географічним регіонам. Децентралізовані мережі працюють бездозвільно, дозволяючи розробку та розгортання AI без необхідності отримувати схвалення від «воротарів». Це особливо важливо для контроверсійних застосунків або користувачів у репресивних юрисдикціях.

Архітектури конфіденційності даних покращуються завдяки локальній обробці. Edge computing keeps sensitive data near its source замість надсилання до віддалених дата-центрів. Децентралізовані мережі можуть впроваджувати методи збереження приватності, як-от федеративне навчання, де моделі навчаються на розподілених даних без централізації сирої інформації.

Ринкова ефективність зростає завдяки прозорому виявленню цін. Традиційне хмарне ціноутворення залишається непрозорим, із складними структурами комісій і узгодженими корпоративними контрактами. Децентралізовані маркетплейси встановлюють чіткі спотові ціни на обчислювальні ресурси, дозволяючи розробникам оптимізувати витрати, а провайдерам — максимізувати дохід через конкурентну динаміку.

Довгострокова релевантність випливає зі стійких драйверів попиту. Обчислювальні навантаження AI продовжать зростати в міру поширення застосунків. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Обчислювальні потужності й надалі залишатимуться фундаментальним обмеженням, забезпечуючи тривалий попит на альтернативні моделі інфраструктури.

Мережеві ефекти сприяють раннім протоколам, що досягли критичної маси. У міру приєднання більшої кількості провайдерів заліза зростає різноманіття доступних ресурсів. Поліпшується географічний розподіл, зменшуючи затримку для edge‑застосунків. Більші мережі приваблюють більше розробників, створюючи доброчинні цикли зростання. Перші гравці в конкретних доменах можуть здобути тривалі переваги.

Виклики та ризики

Незважаючи на перспективні застосування, токенізовані обчислювальні мережі стикаються з істотними технічними, економічними та регуляторними викликами, що можуть стримувати зростання або обмежувати впровадження.

Технічна надійність залишається основною проблемою. Централізовані хмарні провайдери пропонують угоди про рівень обслуговування (SLA), що гарантують аптайм і продуктивність. Розподілені мережі координують «залізо» від незалежних операторів з різним рівнем професіоналізму та якості інфраструктури. Збої вузлів, відключення мережі або вікна техобслуговування створюють прогалини в доступності, які потрібно компенсувати за допомогою надлишковості та алгоритмів маршрутизації.

Перевірка фактично виконаної роботи становить постійний виклик. Гарантувати, що вузли сумлінно виконують обчислення, а не повертають хибні результати, вимагає складних систем доказів. Cryptographic proofs of compute додають накладні витрати, але залишаються необхідними для запобігання шахрайству. Недосконалі механізми верифікації відкривають можливості атак, за яких зловмисні вузли заявляють винагороди, не надаючи обіцяних послуг.

Обмеження затримки та пропускної здатності впливають на розподілені робочі навантаження. [Running computations across geographically dispersed locations can cause затримки] порівняно зі спільно розміщеним апаратним забезпеченням в окремих дата-центрах. Пропускна здатність мережі між вузлами обмежує типи робочих навантажень, придатних для розподіленої обробки. Тісно пов’язані паралельні обчислення, що вимагають частих міжвузлових комунікацій, стикаються зі зниженням продуктивності.

Варіативність якості обслуговування створює невизначеність для промислових застосунків. На відміну від керованих хмарних середовищ із передбачуваною продуктивністю, гетерогенні пули обладнання дають непослідовні результати. Навчальний запуск може виконуватися на корпоративних H100 або на споживчих RTX-картах залежно від доступності. Розробники застосунків мають проектувати з урахуванням цієї варіативності або впроваджувати фільтрацію, що обмежує завдання певними класами обладнання.

Економічна стійкість вимагає балансування зростання пропозиції зі зростанням попиту. Стрімке збільшення доступної обчислювальної потужності без відповідного зростання попиту призведе до падіння цін токенів і зменшення прибутковості провайдерів. Протоколи мають обережно керувати емісією токенів, щоб уникнути інфляції, яка випереджає зростання корисності. Sustainable tokenomics requires demand growth to outpace supply increases.

Стиснення вартості токенів створює ризики для довгострокових учасників. Коли нові провайдери приєднуються до мереж у пошуках винагород, посилена конкуренція знижує заробіток на вузол. Ранні учасники, які виграли від вищих початкових винагород, можуть побачити, як їхня дохідність з часом зменшується. Якщо зростання ціни токена не компенсує це розмивання, зростає відтік провайдерів і страждає стабільність мережі.

Ринкова волатильність створює фінансовий ризик для учасників. Провайдери отримують винагороди в нативних токенах, вартість яких коливається. Оператор обладнання може інвестувати капітал у закупівлю GPU, очікуючи стабільних цін токенів, але зіткнутися зі збитками в разі падіння цін. Механізми хеджування та варіанти виплат у стейблкоїнах можуть пом’якшити волатильність, але додають складності.

Регуляторна невизначеність щодо класифікації токенів створює комплаєнс-виклики. Регулятори ринку цінних паперів у різних юрисдикціях оцінюють, чи є обчислювальні токени цінними паперами, що підлягають реєстрації. Неоднозначний юридичний статус обмежує інституційну участь і створює ризики відповідальності для розробників протоколів. Infrastructure tokenization faces regulation uncertainties, які обмежили впровадження порівняно з традиційними фінансовими структурами.

Норми захисту даних накладають вимоги, які мають враховувати розподілені мережі. Обробка даних громадян ЄС вимагає відповідності GDPR, включно з мінімізацією даних і правом на видалення. Медичні застосунки мають відповідати вимогам HIPAA. Фінансові застосунки стикаються з вимогами протидії відмиванню грошей. Децентралізовані мережі ускладнюють дотримання норм, коли дані переміщуються між кількома юрисдикціями та незалежними операторами.

Надання апаратних ресурсів може привернути увагу регуляторів залежно від структурування таких домовленостей. Юрисдикції можуть класифікувати певні відносини з провайдерами як пропозиції цінних паперів або регульовані фінансові продукти. Межа між наданням інфраструктури та інвестиційними контрактами залишається нечіткою в багатьох правових системах.

Конкуренція з боку гіпермасштабованих хмарних провайдерів продовжує посилюватися. Великі провайдери інвестують мільярди в нові дата-центри та спеціалізовані AI-прискорювачі. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, значною мірою на AI-інфраструктуру. Ці добре капіталізовані гравці можуть демпінгувати ціни або поєднувати обчислення з іншими сервісами, щоб утримувати частку ринку.

Фрагментація мережі може обмежити композабельність. Кілька конкуруючих протоколів створюють ізольовані екосистеми, де обчислювальні ресурси важко переносити між мережами. Відсутність стандартизації API, механізмів верифікації чи стандартів токенів знижує ефективність і підвищує витрати на зміну платформи для розробників.

Ризик для ранніх користувачів впливає на протоколи без перевіреного трек-рекорду. Нові мережі стикаються з «куркою та яйцем» у одночасному залученні як провайдерів обладнання, так і покупців обчислень. Протоколи можуть не досягти критичної маси, необхідної для стійких операцій. Інвестори в токени ризикують повною втратою, якщо мережі згорнуться або не здобудуть прийняття.

Уразливості безпеки в смартконтрактах або координаційних шарах можуть призвести до крадіжки коштів або порушення роботи мережі. Decentralized networks face security challenges, що вимагають ретельного аудиту смартконтрактів і баунті-програм. Експлойти, які вичищають казну чи дозволяють атаки подвійних платежів, підривають довіру та вартість мережі.

The Road Ahead & What to Watch

Відстеження ключових метрик і подій дає уявлення про зрілість і траєкторію зростання токенізованих обчислювальних мереж.

Показники зростання мережі включають кількість активних обчислювальних вузлів, географічний розподіл, різноманітність обладнання та загальну доступну потужність, виміряну в обчислювальних одиницях або еквівалентах GPU. Збільшення цих метрик сигналізує про зростання пропозиції та стійкість мережі. io.net accumulated over 300,000 verified GPUs шляхом інтеграції кількох джерел, демонструючи потенціал швидкого масштабування, коли протоколи ефективно координують різнорідні ресурси.

Показники використання відображають фактичний попит на децентралізовані обчислення. Активні обчислювальні завдання, загальна кількість відпрацьованих годин і структура типів навантажень показують, чи обслуговують мережі реальні застосунки поза спекуляцією. Akash witnessed notable surge in quarterly active leases після розширення підтримки GPU, що свідчить про попит ринку на децентралізовані альтернативи традиційним хмарам.

Ринкова капіталізація токенів і повністю розбавлена оцінка відображають ринкове бачення вартості протоколу. Порівняння оцінок із фактичним доходом або обсягом обчислень показує, чи враховують токени очікуване майбутнє зростання або відбивають поточну корисність. Bittensor's TAO token reached $750 during peak hype in March 2024, ілюструючи спекулятивний інтерес поряд із реальною adopцією.

Партнерства з AI-компаніями та корпоративними користувачами сигналізують про мейнстримну валідацію. Коли усталені AI-лабораторії, розробники моделей або промислові застосунки розгортають навантаження на децентралізованих мережах, це демонструє, що розподілена інфраструктура відповідає реальним вимогам. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, що показує корпоративну відданість розподіленим архітектурам.

Оновлення протоколів і додавання функцій свідчать про сталий темп розробки. Інтеграція нових типів GPU, поліпшені системи оркестрації, вдосконалені механізми верифікації чи поліпшення управління демонструють активну еволюцію до кращої інфраструктури. Bittensor's Dynamic TAO upgrade in 2025 змістив більшу частину винагород до високопродуктивних підмереж, демонструючи адаптивну токеноміку.

Регуляторні події формують операційне середовище. Сприятлива класифікація інфраструктурних токенів або чіткі вказівки щодо вимог до відповідності зменшать юридичну невизначеність і дадуть змогу ширшій інституційній участі. Навпаки, обмежувальні правила можуть стримувати зростання в окремих юрисдикціях.

Конкурентна динаміка між протоколами визначатиме структуру ринку. Простір обчислювальної інфраструктури може консолідуватися навколо кількох домінантних мереж із сильними мережевими ефектами або залишитися фрагментованим зі спеціалізованими протоколами для різних ніш. Стандарти інтероперабельності можуть забезпечити міжмережеву координацію, підвищуючи загальну ефективність екосистеми.

Можуть з’явитися гібридні моделі, що поєднують централізовані та децентралізовані елементи. Підприємства можуть використовувати традиційні хмари для базової потужності, а під час пікового попиту переходити до децентралізованих мереж. Такий підхід забезпечує передбачуваність керованих сервісів, водночас даючи змогу отримати вигоди від нижчих витрат розподілених альтернатив під час пікових навантажень.

Можуть формуватися консорціумні мережі, де учасники галузі спільно керують децентралізованою інфраструктурою. AI-компанії, хмарні провайдери, виробники обладнання чи наукові установи можуть створювати спільні мережі, що знижують індивідуальні капітальні витрати та зберігають децентралізоване управління. Така модель може прискорити впровадження серед організацій, що не люблять ризик.

Вертикальна спеціалізація видається ймовірною, оскільки протоколи оптимізуються під конкретні кейси. Одні мережі можуть зосередитися виключно на навчанні AI, інші — на інференсі, окремі — на edge-computing, ще інші — на рендерингу чи наукових обчисленнях. Спеціалізована інфраструктура краще обслуговує конкретні вимоги робочих навантажень порівняно з універсальними альтернативами.

Критичною стане інтеграція з наявними AI-інструментами та фреймворками. Безшовна сумісність із популярними бібліотеками машинного навчання, системами оркестрації та конвеєрами розгортання зменшує бар’єри для розробників. io.net supports Ray-native orchestration, визнаючи, що розробники віддають перевагу стандартизованим робочим процесам над специфічними для протоколу кастомними реалізаціями.

Міркування сталого розвитку можуть дедалі більше впливати на дизайн протоколів. Енергоефективні механізми консенсусу, стимули для використання відновлюваної енергії операторами вузлів або інтеграція вуглецевих кредитів можуть вирізняти протоколи, привабливі для екологічно свідомих користувачів. Оскільки енергоспоживання AI привертає увагу, децентралізовані мережі можуть позиціонувати ефективність як конкурентну перевагу.

Media coverageand crypto community attention serve as leading indicators of mainstream awareness. Increased discussion of specific protocols, rising search interest, or growing social media following often precedes broader adoption and token price appreciation. However, hype cycles can create misleading signals disconnected from fundamental growth.

Висновок

Physical Infrastructure Finance представляє еволюцію криптовалют у напрямку координації реальних обчислювальних ресурсів. Токенізуючи обчислювальну потужність, протоколи PinFi створюють ринки, де простоюючі GPU перетворюються на продуктивні активи, що генерують дохід через AI-навантаження, edge-обробку та спеціалізовані інфраструктурні потреби.

Зближення ненаситного попиту AI на обчислювальну потужність із здатністю крипто координувати розподілені системи через економічні стимули створює переконливу ціннісну пропозицію. GPU shortages affecting over 50% of generative AI companies demonstrate the severity of infrastructure bottlenecks. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 signal market recognition that distributed models can capture latent supply.

Такі протоколи, як Bittensor, Render, Akash та io.net, демонструють різні підходи до однієї фундаментальної задачі: ефективно зіставляти пропозицію обчислювальних ресурсів із попитом через бездозвільну координацію на основі блокчейну. Кожна мережа експериментує з різними токеноміками, механізмами верифікації та цільовими застосунками, роблячи внесок у ширшу екосистему, що досліджує простір дизайну для децентралізованої інфраструктури.

Наслідки виходять за межі крипто та поширюються на індустрію AI і обчислювальну інфраструктуру загалом. Демократизований доступ до GPU-ресурсів знижує бар’єри для AI-інновацій. Зменшення залежності від централізованих хмарних олігополій вводить конкурентну динаміку, що може покращити ціноутворення та доступність. З’являються нові класи активів, оскільки токени починають представляти права власності на продуктивну інфраструктуру, а не лише об’єкти спекуляції.

Залишається чимало серйозних викликів. Технічна надійність, механізми верифікації, економічна стійкість, регуляторна невизначеність і конкуренція з боку добре капіталізованих гравців створюють ризики. Виживуть не всі протоколи, і багато токенів можуть виявитися переоціненими відносно їхньої фундаментальної корисності. Але базове усвідомлення, що лежить в основі PinFi, видається обґрунтованим: по всьому світу простоюють величезні обчислювальні потужності, існує масивний попит на AI-інфраструктуру, а блокчейн-координація здатна поєднати ці невідповідні криві попиту й пропозиції.

У міру того як попит з боку AI продовжує вибухово зростати, інфраструктурний рівень, що живить цю технологію, ставатиме дедалі критичнішим. Від того, чи залишиться ця інфраструктура зосередженою у кількох централізованих провайдерів, чи еволюціонує у бік моделей розподіленої власності, скоординованих через криптоекономічні стимули, може залежати конкурентний ландшафт розвитку AI на наступне десятиліття.

Інфраструктурне фінансування майбутнього може бути менш схожим на традиційне проектне фінансування й більше — на токенізовані мережі глобально розподіленого обладнання, де кожен, хто має GPU, може стати інфраструктурним провайдером, а доступ не вимагатиме жодних дозволів, окрім ринкової оплати. Це означає фундаментальне переосмислення того, як обчислювальні ресурси перебувають у власності, експлуатуються й монетизуються — модель, у якій криптопротоколи демонструють корисність поза межами фінансової спекуляції, розв’язуючи відчутні проблеми у фізичному світі.