L’industria dell’intelligenza artificiale affronta un grave collo di bottiglia infrastrutturale. L’addestramento dei grandi modelli linguistici richiede enormi risorse computazionali, i dispositivi edge si moltiplicano a ritmi esponenziali e la scarsità di GPU è diventata il vincolo determinante dell’era dell’IA. Nel frattempo, i tradizionali provider cloud faticano a soddisfare la domanda in forte crescita mantenendo al contempo il loro controllo monopolistico su accesso e prezzi.

Over 50% of generative AI companies report GPU shortages come un ostacolo principale alla scalabilità delle loro operazioni. AI computing power is expected to increase by roughly 60 times by the end of 2025 rispetto al Q1 2023. Questa corsa agli armamenti computazionali ha creato uno spazio per i protocolli crypto, che propongono un’alternativa decentralizzata.

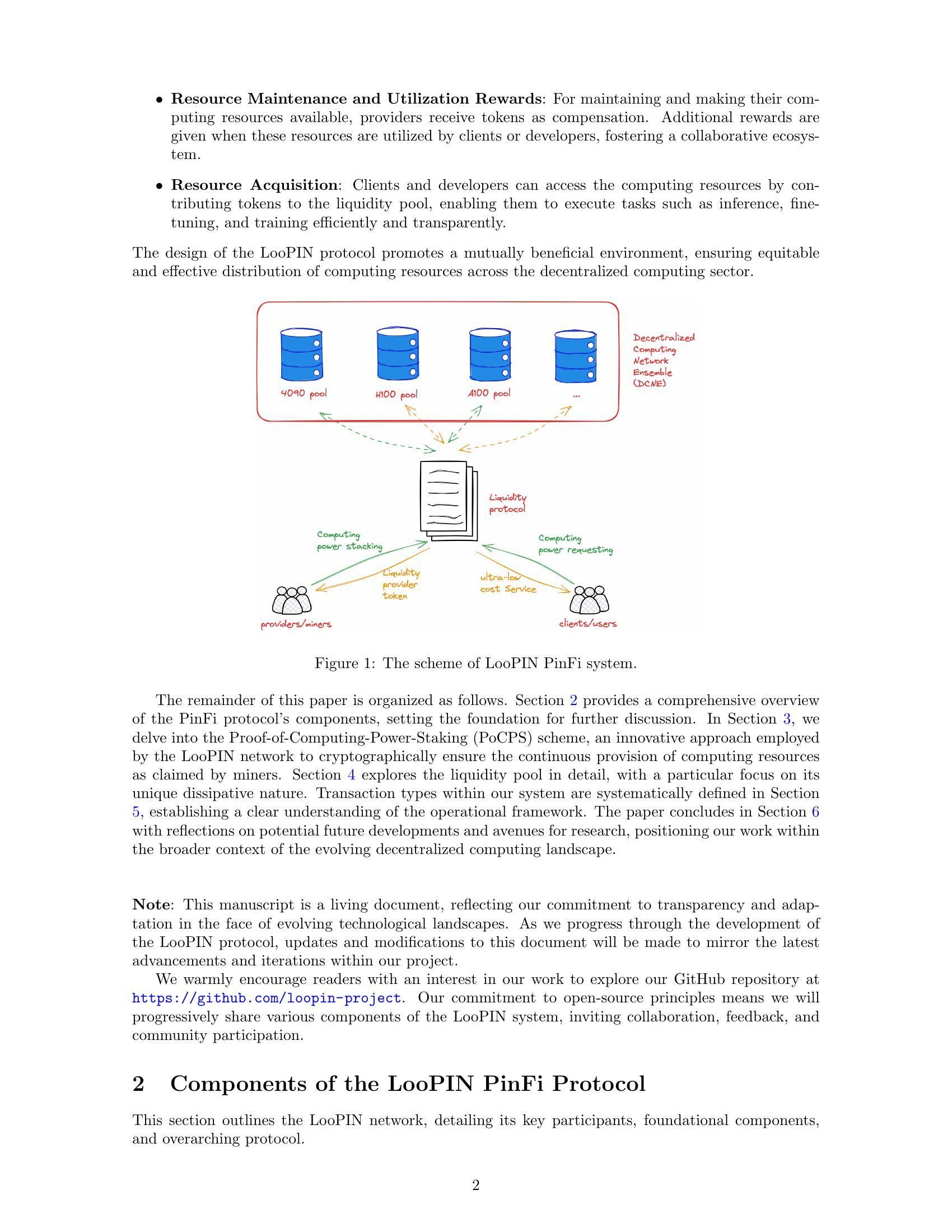

Entra in gioco la Physical Infrastructure Finance, o PinFi. Questo framework emergente tratta la capacità di calcolo come un asset tokenizzato che può essere scambiato, messo in staking e monetizzato attraverso reti basate su blockchain. Invece di fare affidamento su data center centralizzati, i protocolli PinFi aggregano la potenza GPU inutilizzata di operatori indipendenti, gaming rig, mining farm e dispositivi edge in marketplace distribuiti accessibili agli sviluppatori di IA in tutto il mondo.

Di seguito analizziamo come la potenza di calcolo reale viene trasformata in infrastruttura cripto‑economica, comprendendo i meccanismi delle reti di calcolo tokenizzate, i modelli economici che incentivano la partecipazione, l’architettura che abilita verifica e regolamento, e le implicazioni sia per il settore crypto che per quello dell’IA.

Perché PinFi adesso? I driver macro e tecnici

Il collo di bottiglia computazionale che l’industria dell’IA sta affrontando deriva da vincoli fondamentali dell’offerta. Nvidia allocated nearly 60% of its chip production to enterprise AI clients in Q1 2025, lasciando molti utenti a contendersi l’accesso. The global AI chip market reached $123.16 billion in 2024 e dovrebbe raggiungere i 311,58 miliardi di dollari entro il 2029, riflettendo una domanda esplosiva che supera di gran lunga la capacità produttiva.

La scarsità di GPU si manifesta in molteplici modi. I tradizionali provider cloud mantengono liste di attesa per le istanze GPU premium. AWS charges $98.32 per hour for an 8-GPU H100 instance, un prezzo che rende le capacità avanzate di IA inaccessibili per molti sviluppatori e startup. I prezzi dell’hardware restano elevati a causa dei vincoli di offerta, con HBM3 pricing rising 20-30% year-over-year.

La concentrazione della potenza di calcolo in poche grandi aziende cloud crea ulteriori attriti. By 2025, analysts say over 50% of enterprise workloads will run in the cloud, ma l’accesso resta vincolato da contratti, limitazioni geografiche e requisiti KYC. Questa centralizzazione limita l’innovazione e crea punti singoli di failure per infrastrutture critiche.

Nel frattempo, enormi quantità di capacità di calcolo restano inattive. I gaming rig non vengono usati durante le ore di lavoro. I miner crypto cercano nuove fonti di ricavo mentre l’economia del mining cambia. I data center mantengono capacità in eccesso nei periodi di bassa domanda. The decentralized compute market has grown from $9 billion in 2024 con proiezioni che raggiungono i 100 miliardi di dollari entro il 2032, segnalando il riconoscimento di mercato che i modelli distribuiti possono catturare questa offerta latente.

L’intersezione tra tecnologia blockchain e infrastruttura fisica è maturata attraverso le decentralized physical infrastructure networks, o DePIN. I protocolli DePIN utilizzano incentivi in token per coordinare la distribuzione e l’operatività di infrastrutture nel mondo reale. Messari identified DePIN's total addressable market at $2.2 trillion, con il potenziale di raggiungere 3,5 trilioni di dollari entro il 2028.

PinFi rappresenta l’applicazione dei principi DePIN specificamente all’infrastruttura di calcolo. Considera le risorse computazionali come asset tokenizzabili che generano rendimento attraverso l’uso produttivo. Questo framework trasforma il calcolo da servizio affittato da provider centralizzati a merce scambiata in mercati aperti e permissionless.

Che cos’è PinFi e il calcolo tokenizzato?

La Physical Infrastructure Finance definisce un modello in cui asset computazionali fisici sono rappresentati come token digitali su blockchain, abilitando proprietà, operatività e monetizzazione decentralizzate. A differenza dei protocolli di finanza decentralizzata tradizionali, che trattano asset puramente digitali, PinFi crea ponti tra risorse fisiche off‑chain e sistemi economici on‑chain.

Academic research defines tokenization come «il processo di conversione di diritti, di un’unità di proprietà di un asset, di debito o persino di un asset fisico in un token digitale su una blockchain». Per le risorse di calcolo, ciò significa che singole GPU, cluster di server o dispositivi edge vengono rappresentati da token che tracciano la loro capacità, disponibilità e utilizzo.

PinFi differisce in modo fondamentale dalla finanza infrastrutturale standard o dai tipici protocolli DeFi. La finanza infrastrutturale tradizionale coinvolge investimenti di debito o equity a lungo termine in grandi progetti di capitale. I protocolli DeFi facilitano principalmente trading, prestiti o generazione di rendimento su asset crypto‑nativi. PinFi si colloca all’intersezione, applicando incentivi cripto‑economici per coordinare risorse computazionali nel mondo reale mantenendo al contempo regolamento e governance on‑chain.

Diversi protocolli esemplificano il modello PinFi. Bittensor operates as a decentralized AI network in cui i partecipanti contribuiscono con modelli di machine learning e risorse computazionali a subnet specializzate su compiti specifici. Il token TAO incentiva i contributi in base al valore informativo fornito all’intelligenza collettiva della rete. With over 7,000 miners che contribuiscono calcolo, Bittensor crea mercati per l’inferenza e l’addestramento di modelli di IA.

Render Network aggregates idle GPUs globally per attività di rendering GPU distribuito. Inizialmente focalizzato sul rendering 3D per artisti e creator, Render si è espanso verso i carichi di lavoro di calcolo per l’IA. Il token RNDR funge da mezzo di pagamento per i job di rendering, mentre ricompensa i provider GPU per la capacità fornita.

Akash Network operates as a decentralized cloud marketplace che utilizza la capacità inutilizzata dei data center. Attraverso un sistema di reverse auction, i deployer di calcolo specificano i requisiti e i provider fanno offerte per soddisfare le richieste. Il token AKT facilita governance, staking e regolamenti all’interno della rete. Akash witnessed notable surge in quarterly active leases dopo aver ampliato il proprio focus includendo le GPU accanto alle risorse CPU tradizionali.

io.net has aggregated over 300,000 verified GPUs integrando risorse da data center indipendenti, miner crypto e altre reti DePIN, tra cui Render e Filecoin. La piattaforma è focalizzata specificamente sui carichi di lavoro di IA e machine learning, offrendo agli sviluppatori la possibilità di distribuire cluster GPU in 130 paesi in pochi minuti.

I meccanismi del calcolo tokenizzato seguono uno schema coerente tra questi protocolli. I provider di calcolo registrano il loro hardware sulla rete, sottoponendosi a processi di verifica per confermare capacità e caratteristiche. Gli smart contract gestiscono la relazione tra domanda e offerta, instradando i job di calcolo ai nodi disponibili in base a requisiti, prezzi e vincoli geografici. I token incentivano sia la fornitura di hardware sia l’erogazione di un servizio di qualità.

La generazione di valore avviene attraverso l’uso reale piuttosto che la speculazione. Quando uno sviluppatore di IA addestra un modello utilizzando risorse GPU distribuite, il pagamento fluisce verso i provider il cui hardware ha eseguito il lavoro. La potenza computazionale diventa un asset produttivo che genera rendimento, in modo simile ai validatori proof‑of‑stake che guadagnano ricompense per la sicurezza delle reti. Si creano così economie sostenibili in cui il valore del token è correlato all’utilità della rete.

Architettura dell’infrastruttura: nodi, marketplace, regolamento

L’architettura che abilita il calcolo tokenizzato richiede coordinamento su più livelli. Alla base vi è una rete di provider di calcolo indipendenti che distribuiscono hardware, si registrano presso i protocolli e rendono disponibile la capacità in affitto. Questi provider vanno dai singoli utenti con PC da gaming agli operatori di data center professionali, fino alle operazioni di mining di criptovalute in cerca di ulteriori flussi di reddito.

Il provisioning dei nodi inizia quando un provider di calcolo collega l’hardware alla rete. Protocols like io.net support diverse GPU types, dalle NVIDIA RTX 4090 consumer‑grade alle H100 e A100 enterprise. Il provider installa un client software che espone la capacità allo strato di orchestrazione della rete, mantenendo al contempo confini di sicurezza che impediscono accessi non autorizzati.

I meccanismi di verifica assicurano che la capacità dichiarata corrisponda alle capacità effettive. Alcuni protocolli impiegano prove crittografiche di calcolo, in cui i nodi devono dimostrare di aver eseguito correttamente specifici calcoli. Bittensor utilizza il suo meccanismo di consenso Yuma, in cui i validatori valutano la qualità degli output di machine learning prodotti dai miner e assegnano punteggi che determinano la distribuzione delle ricompense. I nodi che forniscono risultati di bassa qualità o tentano di barare ricevono una compensazione ridotta o subiscono lo slashing dei token messi in staking.

Il benchmarking della latenza aiuta ad abbinare i carichi di lavoro all’hardware appropriato. L’inferenza AI richiede caratteristiche di prestazione diverse rispetto all’addestramento dei modelli o al rendering 3D. La posizione geografica influisce sulla latenza per le applicazioni di edge computing, in cui l’elaborazione deve avvenire vicino alle fonti di dati. Il mercato dell’edge computing ha raggiunto i 23,65 miliardi di dollari nel 2024 e si prevede che raggiungerà i 327,79 miliardi di dollari entro il 2033, trainato dalla domanda di elaborazione localizzata.

Il livello di marketplace collega la domanda di calcolo con l’offerta. Quando gli sviluppatori hanno bisogno di risorse GPU, specificano i requisiti tra cui potenza di elaborazione, memoria, durata e prezzo massimo. Akash impiega un modello di asta inversa in cui i deployer fissano i termini e i provider fanno offerte per aggiudicarsi i contratti. Render utilizza algoritmi di pricing dinamico che adeguano le tariffe in base all’utilizzo della rete e alle condizioni di mercato.

Gli algoritmi di instradamento dei job ottimizzano il posizionamento dei task di calcolo sui nodi disponibili. I fattori considerati includono le specifiche hardware, l’utilizzo corrente, la prossimità geografica, le prestazioni storiche e il prezzo. Il livello di orchestrazione di io.net gestisce workflow containerizzati e supporta l’orchestrazione nativa Ray per carichi di lavoro di machine learning distribuito.

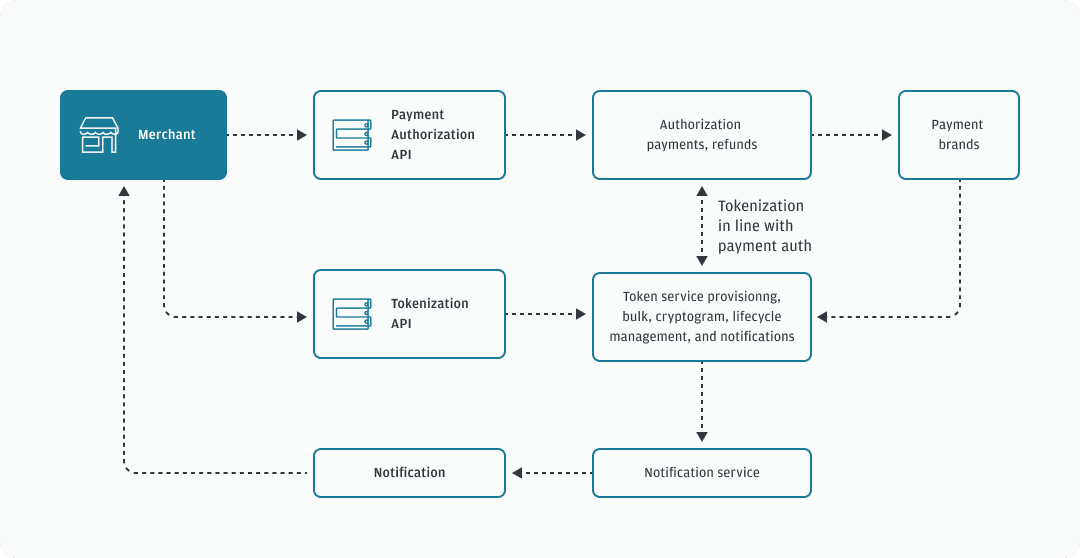

Il settlement avviene on-chain tramite smart contract che bloccano i pagamenti in escrow e rilasciano i fondi al completamento verificato del lavoro. Questo settlement trustless elimina il rischio di controparte e abilita microtransazioni per job di calcolo di breve durata. I protocolli costruiti su blockchain ad alto throughput come Solana possono gestire il volume di transazioni generato da migliaia di richieste di inferenza simultanee.

I meccanismi di staking allineano gli incentivi tra i partecipanti. I provider di calcolo spesso mettono in staking token per dimostrare impegno ed esporre una garanzia che può essere soggetta a slashing in caso di prestazioni scadenti. I validatori in Bittensor mettono in staking token TAO per ottenere influenza nella valutazione dei miner e guadagnare una parte delle ricompense di blocco. I detentori di token possono delegare lo stake ai validatori di cui si fidano, in modo simile ai meccanismi di consenso proof-of-stake.

La governance consente ai detentori di token di votare sui parametri del protocollo, inclusa la distribuzione delle ricompense, le strutture delle commissioni e gli aggiornamenti della rete. La governance decentralizzata garantisce che nessuna autorità centrale possa modificare unilateralmente le regole o limitare l’accesso, mantenendo la natura permissionless che differenzia queste reti dai tradizionali provider cloud.

L’architettura si contrappone nettamente al cloud computing centralizzato. I principali provider possiedono la loro infrastruttura, fissano i prezzi senza reale concorrenza di mercato, richiedono account e verifiche di conformità e mantengono il controllo su accesso e censura. I protocolli PinFi distribuiscono la proprietà tra migliaia di operatori indipendenti, abilitano un pricing trasparente basato sul mercato, operano in modo permissionless e resistono alla censura attraverso la decentralizzazione.

Tokenomics & Incentive Models

L’economia dei token fornisce la struttura di incentivi che coordina le reti di calcolo distribuite. I token nativi svolgono funzioni multiple, tra cui il pagamento dei servizi, le ricompense per la fornitura di risorse, i diritti di governance e i requisiti di staking per la partecipazione alla rete.

I meccanismi di emissione determinano come i token entrano in circolazione. Bittensor segue il modello di Bitcoin con una fornitura massima di 21 milioni di token TAO e halving periodici che riducono l’emissione nel tempo. Attualmente vengono coniati 7.200 TAO al giorno, suddivisi tra i miner che contribuiscono risorse computazionali e i validatori che assicurano la qualità della rete. Questo crea una scarsità simile a Bitcoin, indirizzando al contempo l’inflazione verso infrastrutture produttive.

Altri protocolli emettono token in base all’utilizzo della rete. Quando i job di calcolo vengono eseguiti, i token di nuova emissione fluiscono verso i provider in proporzione alle risorse fornite. Questo collegamento diretto tra creazione di valore ed emissione di token garantisce che l’inflazione ricompensi la produttività effettiva piuttosto che la detenzione passiva dei token.

Lo staking crea skin in the game per i partecipanti alla rete. I provider di calcolo mettono in staking token per registrare i nodi e dimostrare il loro impegno. Prestazioni scadenti o tentativi di frode portano allo slashing, in cui i token in staking vengono distrutti o redistribuiti alle parti danneggiate. Questa penalità economica incentiva un’erogazione affidabile del servizio e comportamenti onesti.

I validatori mettono in staking importi maggiori per ottenere influenza nella valutazione della qualità e nelle decisioni di governance. Nel modello di Bittensor, i validatori valutano gli output dei miner e inviano matrici di pesi che indicano quali nodi hanno fornito contributi di valore. Lo Yuma Consensus aggrega queste valutazioni, ponderandole in base allo stake dei validatori per determinare la distribuzione finale delle ricompense.

Le dinamiche di domanda e offerta per i token di calcolo operano su due livelli. Dal lato dell’offerta, un maggior numero di nodi che si uniscono alla rete aumenta la capacità computazionale disponibile. Le ricompense in token devono essere sufficienti a compensare i costi dell’hardware, dell’elettricità e i costi opportunità rispetto ad usi alternativi dell’attrezzatura. Man mano che il prezzo del token cresce, fornire capacità di calcolo diventa più profittevole, attirando ulteriore offerta.

Dal lato della domanda, il prezzo del token riflette il valore che gli utenti attribuiscono all’accesso alla rete. Con la proliferazione delle applicazioni AI e l’intensificarsi della scarsità di calcolo, aumenta la disponibilità a pagare per risorse decentralizzate. Il mercato dell’hardware AI dovrebbe crescere da 66,8 miliardi di dollari nel 2025 a 296,3 miliardi di dollari entro il 2034, creando una domanda sostenuta per fonti di calcolo alternative.

L’apprezzamento del valore del token avvantaggia tutti i partecipanti. I provider di hardware guadagnano di più per lo stesso output computazionale. I primi operatori di nodi beneficiano dell’apprezzamento delle ricompense accumulate. Gli sviluppatori beneficiano di un’alternativa decentralizzata ai costosi provider centralizzati. I detentori di token che fanno staking o forniscono liquidità catturano commissioni dall’attività della rete.

I modelli di rischio affrontano potenziali modalità di fallimento. Il downtime dei nodi riduce i guadagni poiché i job vengono instradati verso alternative disponibili. La concentrazione geografica crea problemi di latenza per le applicazioni edge che richiedono elaborazione locale. Gli effetti di rete favoriscono i protocolli più grandi con hardware e distribuzione geografica più diversificati.

L’inflazione del token deve bilanciare l’attrazione di nuova offerta con il mantenimento del valore per i detentori esistenti. La ricerca sui protocolli di infrastruttura decentralizzata rileva che una tokenomics sostenibile richiede che la crescita della domanda superi l’aumento dell’offerta. I protocolli implementano meccanismi di burning, in cui i token utilizzati per i pagamenti vengono rimossi permanentemente dalla circolazione, creando una pressione deflazionistica che compensa l’emissione inflazionistica.

Le strutture delle commissioni variano tra le reti. Alcune addebitano agli utenti direttamente in token nativi. Altre accettano stablecoin o versioni wrapped delle principali criptovalute, con i token del protocollo che servono principalmente per governance e staking. I modelli ibridi utilizzano i token per l’accesso alla rete, regolando invece i pagamenti di calcolo in asset stabili per ridurre il rischio di volatilità.

Lo spazio di progettazione dei modelli di incentivi continua a evolversi mentre i protocolli sperimentano diversi approcci per bilanciare gli interessi degli stakeholder e sostenere la crescita a lungo termine.

AI, Edge e Infrastrutture nel Mondo Reale

Le reti di calcolo tokenizzate abilitano applicazioni che sfruttano hardware distribuito per carichi di lavoro AI, elaborazione edge e esigenze di infrastrutture specializzate. La diversità dei casi d’uso dimostra come i modelli decentralizzati possano affrontare i colli di bottiglia lungo l’intero stack computazionale.

L’addestramento distribuito di modelli AI rappresenta un caso d’uso primario. L’addestramento di large language model o sistemi di computer vision richiede una massiccia computazione parallela su più GPU. Gli approcci tradizionali concentrano questo addestramento in data center centralizzati di proprietà dei principali provider cloud. Le reti decentralizzate consentono di svolgere l’addestramento su nodi geograficamente distribuiti, ognuno dei quali contribuisce lavoro computazionale coordinato tramite orchestrazione basata su blockchain.

L’architettura di subnet di Bittensor abilita mercati AI specializzati focalizzati su compiti specifici come generazione di testo, sintesi di immagini o data scraping. I miner competono per fornire output di alta qualità nei domini prescelti, con i validatori che ne valutano le prestazioni e distribuiscono le ricompense di conseguenza. Questo crea mercati competitivi in cui i modelli migliori e le implementazioni più efficienti emergono naturalmente attraverso la selezione economica.

I carichi di lavoro di edge computing traggono particolare beneficio dall’infrastruttura decentralizzata. Il mercato globale dell’edge computing è stato valutato 23,65 miliardi di dollari nel 2024, trainato da applicazioni che richiedono bassa latenza ed elaborazione locale. I dispositivi IoT che generano dati di sensori continui necessitano di un’analisi immediata senza i ritardi di andata e ritorno verso data center lontani. I veicoli autonomi richiedono decisioni in frazioni di secondo che non possono tollerare la latenza di rete.

Le reti di calcolo decentralizzate possono collocare la capacità di elaborazione fisicamente vicino alle fonti di dati. Una fabbrica che implementa sensori IoT industriali può noleggiare nodi edge nella stessa città o regione invece di affidarsi a cloud centralizzati situati a centinaia di miglia di distanza. Industrial IoT applications accounted for the largest market share in edge computing in 2024, riflettendo la natura critica dell’elaborazione localizzata per la manifattura e la logistica.

Il rendering dei contenuti e i flussi di lavoro creativi consumano risorse GPU significative. Artisti che eseguono il rendering di scene 3D, animatori che producono film e sviluppatori di videogiochi che compilano asset richiedono tutti un’elaborazione parallela intensiva. Render Network specializes in distributed GPU rendering, collegando i creatori con capacità GPU inattiva in tutto il mondo. Questo modello di marketplace riduce i costi di rendering fornendo al contempo flussi di entrate per i proprietari di GPU durante i periodi di bassa attività.

Le applicazioni di calcolo scientifico e di ricerca affrontano vincoli di budget nell’accesso a costose risorse cloud. Istituzioni accademiche, ricercatori indipendenti e organizzazioni più piccole possono sfruttare le reti decentralizzate per eseguire simulazioni, analizzare dataset o addestrare modelli specializzati. La natura permissionless implica che i ricercatori in qualsiasi area geografica possano accedere a risorse computazionali senza account cloud istituzionali o verifiche del credito.

Le piattaforme di gaming e metaverso richiedono calcoli di rendering e fisica per esperienze immersive. Man mano che i mondi virtuali crescono in complessità, aumentano le richieste computazionali per mantenere ambienti persistenti e supportare migliaia di utenti simultanei. I nodi di calcolo distribuiti all’edge possono fornire elaborazione locale per popolazioni di giocatori regionali, riducendo la latenza e distribuendo i costi infrastrutturali tra provider incentivati tramite token.

L’inferenza AI su larga scala richiede accesso continuo alle GPU per servire previsioni da modelli addestrati. Un chatbot che gestisce milioni di richieste, un servizio di generazione di immagini che elabora prompt degli utenti o un motore di raccomandazione che analizza il comportamento degli utenti necessitano tutti di compute sempre disponibile. Le reti decentralizzate forniscono ridondanza e distribuzione geografica che migliora l’affidabilità rispetto alla dipendenza da un singolo provider.

Le aree geografiche poco servite dai principali provider cloud rappresentano opportunità per i protocolli PinFi. Le regioni con una presenza limitata di data center affrontano una latenza più elevata e costi maggiori quando accedono a un’infrastruttura centralizzata. I provider hardware locali in queste aree possono offrire capacità di calcolo adattata alla domanda regionale, guadagnando ricompense in token e migliorando l’accesso locale alle capacità di AI.

I requisiti di sovranità dei dati impongono sempre più spesso che determinati carichi di lavoro elaborino i dati all’interno di specifiche giurisdizioni. Regulations like the EU Data Act require sensitive information to be processed locally, incoraggiando il deployment di infrastrutture edge che rispettino le norme di residenza dei dati. Le reti decentralizzate supportano naturalmente il deployment di nodi specifici per giurisdizione pur mantenendo il coordinamento globale tramite il settlement basato su blockchain.

Why It Matters: Implications for Crypto & Infrastructure

L’emergere di PinFi rappresenta l’espansione delle crypto oltre le applicazioni puramente finanziarie verso il coordinamento di infrastrutture del mondo reale. Questo cambiamento comporta implicazioni sia per l’ecosistema crypto sia per le industrie computazionali più ampie.

I protocolli crypto dimostrano utilità oltre la speculazione quando risolvono problemi infrastrutturali tangibili. DePIN e PinFi creano sistemi economici che coordinano risorse fisiche, dimostrando che gli incentivi basati su blockchain possono avviare reti nel mondo reale. The DePIN sector's total addressable market is currently around $2.2 trillion and could reach $3.5 trillion by 2028, rappresentando circa tre volte l’attuale capitalizzazione totale di mercato delle crypto.

La democratizzazione dell’accesso al compute affronta un’asimmetria fondamentale nello sviluppo dell’AI. Attualmente, le capacità AI avanzate rimangono ampiamente concentrate tra aziende tecnologiche ben finanziate che possono permettersi cluster GPU massicci. Startup, ricercatori e sviluppatori in ambienti con risorse limitate incontrano barriere nella partecipazione all’innovazione AI. Le reti di calcolo decentralizzate abbassano queste barriere fornendo accesso permissionless a hardware distribuito a prezzi determinati dal mercato.

La creazione di nuove classi di asset espande il panorama degli investimenti crypto. I token legati alla capacità di calcolo rappresentano proprietà in infrastrutture produttive che generano ricavi tramite l’utilizzo nel mondo reale. Questo differisce dagli asset puramente speculativi o dai token di governance senza chiari meccanismi di cattura del valore. I detentori di token possiedono essenzialmente quote di un provider cloud decentralizzato, con valore legato alla domanda di servizi computazionali.

I monopoli infrastrutturali tradizionali affrontano una potenziale disruption. Centralized cloud providers including AWS, Microsoft Azure and Google Cloud maintain oligopolistic control sui mercati del compute, fissando i prezzi senza una concorrenza diretta. Le alternative decentralizzate introducono dinamiche di mercato in cui migliaia di provider indipendenti competono, potenzialmente riducendo i costi e migliorando l’accessibilità.

L’industria dell’AI beneficia di una dipendenza ridotta dall’infrastruttura centralizzata. Attualmente, lo sviluppo AI si concentra intorno ai principali provider cloud, creando punti singoli di fallimento e rischi di concentrazione. Over 50% of generative AI companies report GPU shortages as major obstacles. Le reti distribuite forniscono capacità alternativa che può assorbire l’eccesso di domanda e offrire ridondanza contro le interruzioni della catena di approvvigionamento.

Miglioramenti nell’efficienza energetica possono emergere da un migliore utilizzo della capacità. I PC da gaming inattivi consumano energia in standby senza output produttivo. Le operazioni di mining con capacità in eccesso cercano flussi di entrate aggiuntivi. Distributed networks put idle GPUs to productive use, migliorando l’efficienza complessiva delle risorse nell’ecosistema computazionale.

La resistenza alla censura diventa rilevante per le applicazioni AI. I provider cloud centralizzati possono negare il servizio a specifici utenti, applicazioni o intere regioni geografiche. Le reti decentralizzate operano in modo permissionless, abilitando lo sviluppo e il deployment di AI senza richiedere l’approvazione di gatekeeper. Questo è particolarmente importante per applicazioni controverse o utenti in giurisdizioni restrittive.

Le architetture di privacy dei dati migliorano attraverso l’elaborazione locale. Edge computing keeps sensitive data near its source invece di trasmetterli a data center lontani. Le reti decentralizzate possono implementare tecniche di tutela della privacy come il federated learning, in cui i modelli si addestrano su dati distribuiti senza centralizzare le informazioni grezze.

L’efficienza del mercato aumenta grazie a una scoperta dei prezzi trasparente. I prezzi del cloud tradizionale rimangono opachi, con strutture tariffarie complesse e contratti enterprise negoziati. I marketplace decentralizzati stabiliscono prezzi spot chiari per le risorse di calcolo, consentendo agli sviluppatori di ottimizzare i costi e ai provider di massimizzare i ricavi attraverso dinamiche competitive.

La rilevanza a lungo termine deriva da driver di domanda sostenuti. I carichi di lavoro AI continueranno a crescere man mano che le applicazioni si moltiplicano. The AI hardware market is expected to grow from $66.8 billion in 2025 to $296.3 billion by 2034. Il compute rimarrà un vincolo fondamentale, garantendo una domanda continua per modelli infrastrutturali alternativi.

Gli effetti di rete favoriscono i primi protocolli che raggiungono la massa critica. Man mano che più provider hardware si uniscono, aumenta la diversità delle risorse disponibili. La distribuzione geografica migliora, riducendo la latenza per le applicazioni edge. Reti più grandi attraggono più sviluppatori, creando cicli virtuosi di crescita. I first mover in domini specifici possono stabilire vantaggi duraturi.

Challenges & Risks

Nonostante le applicazioni promettenti, le reti di compute tokenizzato affrontano significative sfide tecniche, economiche e regolatorie che potrebbero limitarne la crescita o l’adozione.

L’affidabilità tecnica rimane una preoccupazione primaria. I provider cloud centralizzati offrono service level agreement che garantiscono uptime e prestazioni. Le reti distribuite coordinano hardware di operatori indipendenti con livelli variabili di professionalità e qualità dell’infrastruttura. Guasti dei nodi, interruzioni di rete o finestre di manutenzione creano lacune di disponibilità che devono essere gestite tramite ridondanza e algoritmi di instradamento.

La verifica del lavoro effettivamente svolto presenta sfide continue. Garantire che i nodi eseguano onestamente le computazioni invece di restituire risultati falsi richiede sistemi di prova sofisticati. Cryptographic proofs of compute aggiungono overhead ma restano necessari per prevenire le frodi. Meccanismi di verifica imperfetti consentono potenziali attacchi in cui nodi malevoli rivendicano ricompense senza fornire i servizi promessi.

Le limitazioni di latenza e banda influenzano i carichi di lavoro distribuiti. Running computations across geographically dispersed locations can cause delays rispetto all’hardware co-localizzato in singoli data center. La larghezza di banda di rete tra i nodi limita i tipi di carichi di lavoro adatti all’elaborazione distribuita. Le computazioni parallele fortemente accoppiate, che richiedono frequenti comunicazioni tra nodi, subiscono un degrado delle prestazioni.

La variabilità della qualità del servizio crea incertezza per le applicazioni in produzione. A differenza degli ambienti cloud gestiti con prestazioni prevedibili, pool di hardware eterogenei producono risultati incoerenti. Un job di training potrebbe essere eseguito su H100 di classe enterprise o su schede RTX consumer a seconda della disponibilità. Gli sviluppatori di applicazioni devono progettare tenendo conto di questa variabilità oppure implementare filtri che limitino i job a specifici livelli di hardware.

La sostenibilità economica richiede un equilibrio tra crescita dell’offerta ed espansione della domanda. Aumenti rapidi della capacità di calcolo disponibile senza una corrispondente crescita della domanda deprimerebbero i prezzi dei token e ridurrebbero la redditività dei provider. I protocolli devono gestire con attenzione l’emissione di token per evitare un’inflazione che superi la crescita dell’utilità. Sustainable tokenomics requires demand growth to outpace supply increases.

La compressione del valore dei token comporta rischi per i partecipanti di lungo periodo. Quando nuovi provider si uniscono alle reti alla ricerca di ricompense, l’aumento della concorrenza riduce i guadagni per nodo. I primi partecipanti che hanno beneficiato di ricompense iniziali più alte possono vedere i loro rendimenti diminuire nel tempo. Se l’apprezzamento del token non riesce a compensare questa diluizione, aumenta l’abbandono da parte dei provider e la stabilità della rete ne risente.

La volatilità del mercato introduce rischio finanziario per i partecipanti. I provider guadagnano ricompense in token nativi il cui valore fluttua. Un operatore hardware può investire capitale nell’acquisto di GPU aspettandosi che i prezzi dei token restino stabili, per poi subire perdite se i prezzi scendono. Meccanismi di copertura e opzioni di pagamento in stablecoin possono mitigare la volatilità, ma aggiungono complessità.

L’incertezza normativa sulla classificazione dei token crea sfide di conformità. Le autorità di vigilanza sui titoli in varie giurisdizioni valutano se i token di calcolo costituiscano titoli soggetti a obblighi di registrazione. Uno status legale ambiguo limita la partecipazione istituzionale e crea rischi di responsabilità per gli sviluppatori dei protocolli. Infrastructure tokenization faces regulation uncertainties che ne hanno limitato l’adozione rispetto alle strutture della finanza tradizionale.

I regolamenti sulla protezione dei dati impongono requisiti che le reti distribuite devono saper gestire. L’elaborazione dei dati dei cittadini europei richiede la conformità al GDPR, incluso il principio di minimizzazione dei dati e i diritti di cancellazione. Le applicazioni sanitarie devono soddisfare i requisiti HIPAA. Le applicazioni finanziarie devono rispettare gli obblighi antiriciclaggio. Le reti decentralizzate complicano la conformità quando i dati si spostano tra più giurisdizioni e operatori indipendenti.

I contributi hardware possono innescare controlli normativi a seconda di come sono strutturati gli accordi. Alcune giurisdizioni potrebbero classificare determinati rapporti con i provider come offerte di titoli o prodotti finanziari regolamentati. Il confine tra fornitura di infrastruttura e contratti di investimento rimane poco chiaro in molti quadri giuridici.

La concorrenza da parte dei cloud provider iperscalari continua a intensificarsi. I grandi provider investono miliardi in nuova capacità di data center e in acceleratori AI personalizzati. AWS, Microsoft, and Google spent 36% more on capital expenditures in 2024, in gran parte per infrastrutture AI. Questi incumbent ben capitalizzati possono praticare prezzi più bassi o offrire il compute in bundle con altri servizi per mantenere la quota di mercato.

La frammentazione della rete potrebbe limitare la composabilità. Molteplici protocolli concorrenti creano ecosistemi isolati in cui le risorse di calcolo non possono essere facilmente trasferite tra reti. La mancanza di standardizzazione in API, meccanismi di verifica o standard di token riduce l’efficienza e aumenta i costi di switching per gli sviluppatori.

Il rischio da early adopter incide sui protocolli senza track record consolidati. Le nuove reti affrontano problemi di tipo “chicken-and-egg” nel riuscire ad attirare contemporaneamente sia i provider hardware sia i compratori di compute. I protocolli potrebbero non raggiungere la massa critica necessaria per operazioni sostenibili. Gli investitori nei token affrontano un rischio di perdita totale se le reti collassano o non riescono a ottenere adozione.

Le vulnerabilità di sicurezza negli smart contract o nei livelli di coordinamento potrebbero consentire il furto di fondi o la disgregazione della rete. Decentralized networks face security challenges che richiedono un attento auditing degli smart contract e programmi di bug bounty. Exploit che prosciugano i treasury o consentono attacchi di doppio pagamento minano la fiducia e il valore della rete.

The Road Ahead & What to Watch

Monitorare metriche e sviluppi chiave fornisce indicazioni sulla maturazione e sulla traiettoria di crescita delle reti di calcolo tokenizzate.

Gli indicatori di crescita della rete includono il numero di nodi di calcolo attivi, la distribuzione geografica, la diversità dell’hardware e la capacità totale disponibile misurata in potenza di calcolo o equivalenti GPU. L’espansione di queste metriche segnala un aumento dell’offerta e della resilienza della rete. io.net accumulated over 300,000 verified GPUs integrando fonti multiple, dimostrando un potenziale di scaling rapido quando i protocolli coordinano efficacemente risorse eterogenee.

Le metriche d’uso rivelano la domanda effettiva di calcolo decentralizzato. Job di calcolo attivi, ore totali di elaborazione erogate e la composizione dei tipi di carichi di lavoro mostrano se le reti servono applicazioni reali oltre la speculazione. Akash witnessed notable surge in quarterly active leases dopo aver ampliato il supporto GPU, indicando un appetito di mercato per alternative decentralizzate ai cloud tradizionali.

La capitalizzazione di mercato dei token e le valutazioni fully diluted forniscono valutazioni di mercato del valore dei protocolli. Confrontare le valutazioni con i ricavi effettivi o il throughput di calcolo rivela se i token incorporano aspettative di crescita futura o riflettono l’utilità corrente. Bittensor's TAO token reached $750 during peak hype in March 2024, illustrando l’interesse speculativo accanto a un’adozione genuina.

Le partnership con aziende AI e adopter enterprise segnalano una validazione mainstream. Quando laboratori AI affermati, sviluppatori di modelli o applicazioni in produzione eseguono carichi di lavoro su reti decentralizzate, ciò dimostra che l’infrastruttura distribuita soddisfa requisiti reali. Toyota and NTT announced a $3.3 billion investment in a Mobility AI Platform using edge computing, mostrando l’impegno aziendale verso architetture distribuite.

Gli upgrade di protocollo e le nuove funzionalità indicano un continuo slancio di sviluppo. L’integrazione di nuovi tipi di GPU, sistemi di orchestrazione migliorati, meccanismi di verifica avanzati o miglioramenti della governance mostrano un’iterazione attiva verso un’infrastruttura migliore. Bittensor's Dynamic TAO upgrade in 2025 ha spostato più ricompense verso i subnet ad alte prestazioni, dimostrando una tokenomics adattiva.

Gli sviluppi normativi plasmano l’ambiente operativo. Una classificazione favorevole dei token infrastrutturali o linee guida chiare sui requisiti di conformità ridurrebbero l’incertezza legale e consentirebbero una partecipazione istituzionale più ampia. Al contrario, regolamenti restrittivi potrebbero limitare la crescita in specifiche giurisdizioni.

Le dinamiche competitive tra protocolli determinano la struttura del mercato. Lo spazio delle infrastrutture di calcolo potrebbe consolidarsi attorno a poche reti dominanti che ottengono forti effetti di rete, oppure restare frammentato con protocolli specializzati che servono nicchie differenti. Standard di interoperabilità potrebbero consentire il coordinamento tra reti, migliorando l’efficienza complessiva dell’ecosistema.

Potrebbero emergere modelli ibridi che combinano elementi centralizzati e decentralizzati. Le imprese potrebbero utilizzare i cloud tradizionali per la capacità di base e fare “burst” verso reti decentralizzate durante i picchi di domanda. Questo approccio fornisce la prevedibilità dei servizi gestiti, catturando al contempo i risparmi di costo offerti dalle alternative distribuite nei periodi di overflow.

Potrebbero formarsi reti consortili in cui i partecipanti del settore gestiscono congiuntamente infrastrutture decentralizzate. Aziende AI, cloud provider, produttori di hardware o istituzioni accademiche potrebbero istituire reti condivise che riducono i requisiti di capitale individuale mantenendo una governance decentralizzata. Questo modello potrebbe accelerare l’adozione tra le organizzazioni più avverse al rischio.

La specializzazione verticale appare probabile man mano che i protocolli si ottimizzano per casi d’uso specifici. Alcune reti potrebbero concentrarsi esclusivamente sul training AI, altre sull’inferenza, alcune sull’edge computing, altre sul rendering o sul calcolo scientifico. Infrastrutture specializzate servono meglio particolari requisiti di carico di lavoro rispetto alle alternative generaliste.

L’integrazione con gli strumenti e i framework AI esistenti sarà determinante. Una compatibilità fluida con le principali librerie di machine learning, i sistemi di orchestrazione e le pipeline di deployment riduce gli attriti per gli sviluppatori. io.net supports Ray-native orchestration, riconoscendo che gli sviluppatori preferiscono workflow standardizzati rispetto a implementazioni personalizzate specifiche di protocollo.

Le considerazioni sulla sostenibilità potrebbero influenzare sempre di più la progettazione dei protocolli. Meccanismi di consenso a basso consumo, incentivi all’uso di energia rinnovabile per gli operatori di nodi o l’integrazione di crediti di carbonio potrebbero differenziare i protocolli che puntano a utenti attenti all’ambiente. Man mano che il consumo energetico dell’AI attira maggiore attenzione, le reti decentralizzate potrebbero posizionare l’efficienza come vantaggio competitivo.

Media coverage e l’attenzione della comunità cripto fungono da indicatori anticipatori della consapevolezza mainstream. Un aumento delle discussioni su specifici protocolli, un interesse di ricerca in crescita o un seguito crescente sui social media spesso precedono un’adozione più ampia e un apprezzamento del prezzo dei token. Tuttavia, i cicli di hype possono generare segnali fuorvianti, scollegati dalla crescita dei fondamentali.

Conclusion

La Physical Infrastructure Finance rappresenta l’evoluzione del cripto verso il coordinamento di risorse computazionali nel mondo reale. Tokenizzando la capacità di calcolo, i protocolli PinFi creano mercati in cui le GPU inattive diventano asset produttivi che generano rendimento tramite carichi di lavoro di IA, elaborazione edge ed esigenze di infrastruttura specializzata.

La convergenza tra l’insaziabile domanda di potenza di calcolo dell’IA e la capacità del cripto di coordinare sistemi distribuiti tramite incentivi economici crea una proposta di valore convincente. GPU shortages affecting over 50% of generative AI companies dimostrano la gravità dei colli di bottiglia infrastrutturali. Decentralized compute markets growing from $9 billion in 2024 to a projected $100 billion by 2032 segnalano il riconoscimento da parte del mercato che i modelli distribuiti possono catturare l’offerta latente.

Protocolli come Bittensor, Render, Akash e io.net dimostrano approcci diversi alla stessa sfida fondamentale: abbinare in modo efficiente l’offerta di calcolo con la domanda tramite un coordinamento permissionless basato su blockchain. Ogni rete sperimenta differenti tokenomics, meccanismi di verifica e applicazioni target, contribuendo a un ecosistema più ampio che esplora lo spazio di progettazione per un’infrastruttura decentralizzata.

Le implicazioni vanno oltre il cripto, toccando l’industria dell’IA e l’infrastruttura computazionale in senso più ampio. L’accesso democratizzato alle risorse GPU abbassa le barriere all’innovazione nell’IA. La ridotta dipendenza dagli oligopoli del cloud centralizzato introduce dinamiche competitive che possono migliorare prezzi e accessibilità. Emergono nuove classi di asset, poiché i token rappresentano la proprietà di un’infrastruttura produttiva piuttosto che pura speculazione.

Permangono sfide significative. Affidabilità tecnica, meccanismi di verifica, sostenibilità economica, incertezza regolatoria e concorrenza da parte di incumbents ben capitalizzati rappresentano tutti dei rischi. Non tutti i protocolli sopravvivranno e molti token potrebbero rivelarsi sopravvalutati rispetto all’utilità fondamentale. Ma l’intuizione di base che guida la PinFi sembra solida: una vasta capacità computazionale rimane inattiva in tutto il mondo, esiste una domanda enorme per infrastrutture di IA e il coordinamento basato su blockchain può far coincidere queste curve di offerta e domanda disallineate.

Man mano che la domanda di IA continua a esplodere, il livello infrastrutturale che alimenta questa tecnologia diventerà sempre più critico. Il fatto che tale infrastruttura rimanga concentrata in poche entità centralizzate o evolva verso modelli di proprietà distribuita coordinati tramite incentivi cripto-economici potrebbe definire il panorama competitivo dello sviluppo dell’IA per il prossimo decennio.

La finanza infrastrutturale del futuro potrebbe assomigliare meno alla tradizionale project finance e più a reti tokenizzate di hardware distribuito globalmente, in cui chiunque possieda una GPU può diventare fornitore di infrastruttura e in cui l’accesso non richiede altra autorizzazione se non il pagamento al prezzo di mercato. Ciò rappresenta una reimmaginazione fondamentale di come le risorse computazionali vengono possedute, gestite e monetizzate — in cui i protocolli cripto dimostrano utilità al di là della speculazione finanziaria, risolvendo problemi tangibili nel mondo fisico.