Каждую секунду через блокчейн-сети проходят сотни тысяч транзакций. Трейдеры совершают обмены на децентрализованных биржах, пользователи минтят NFT, валидаторы обеспечивают защиту сетей с доказательством доли, а смарт-контракты автоматически выполняются без посредников. Обещание Web3 просто: децентрализованные системы, которые работают непрерывно, прозрачно и без единичных точек отказа.

Но за этим видением автономного кода скрывается поразительно сложный инфрастуктурный слой, который многие пользователи никогда не видят. Каждая транзакция, затрагивающая блокчейн, требует инфраструктуры для функционирования. Кто-то управляет узлами, которые проверяют транзакции, поддерживает RPC-эндпоинты, позволяющие приложениям читать и записывать блокчейн-данные, и управляет индексаторами, которые делают информацию в цепочке запросимой.

Когда протокол DeFi обрабатывает миллиарды в суточном объеме или рынок NFT сталкивается с пиковыми нагрузками во время крупных дропов, профессиональные команды DevOps обеспечивают, чтобы инфраструктура оставалась чуткой, безопасной и доступной.

В криптовалютах ставки на надежность инфраструктуры исключительно высоки. Ошибка валидатора может привести к уменьшению депозитов ставок. Перегруженный RPC-эндпоинт может помешать пользователям выполнять торговые операции, чувствительные ко времени, что приведет к ликвидациям на миллионы. Неверно настроенный индексатор может выдавать устаревшие данные, нарушающие логику приложения. В отличие от традиционных веб-приложений, где простои означают разочарованных пользователей, сбои в инфраструктуре криптовалют могут означать прямые финансовые потери для пользователей и протоколов.

По мере того, как экосистемы Web3 становятся зрелыми и обрабатывают все более серьезную финансовую деятельность, дисциплина DevOps в криптовалютах эволюционировала от хобби-операторов узлов до сложных инфраструктурных команд, управляющих мультицепочечными операциями с надежностью уровня предприятия. Эта эволюция отражает более широкую профессионализацию криптоиндустрии, где протоколы, управляющие миллиардами в общей заблокированной стоимости, требуют операций с инфраструктурой, которые соответствуют или превосходят стандарты традиционных финансовых технологий.

Эта статья рассматривает, как на практике работает crypto DevOps. Она исследует системы, которые профессиональные команды строят и поддерживают, инструменты, на которые они полагаются, уникальные проблемы децентрализованной инфраструктуры и операционные практики, которые позволяют Web3 работать плавно круглосуточно. Понимание этого скрытого слоя показывает, как децентрализация встречается с операционной реальностью и почему инфраструктурная экспертиза стала стратегической возможностью в блокчейн-пространстве.

Что такое Crypto DevOps?

Чтобы понять crypto DevOps, полезно начать с традиционного DevOps. В традиционной разработке программного обеспечения DevOps возникла, как дисциплина, направленная на сокращение разрыва между разработкой программного обеспечения и ИТ-операциями. Специалисты DevOps автоматизируют развертывание, управляют инфраструктурой как кодом, внедряют конвейеры непрерывной интеграции и доставки, и обеспечивают надежность систем.

Цель - сократить трения между написанием кода и надежным запуском его в продакшн, сохраняя при этом быстрые итерационные циклы. Традиционные команды DevOps работают с знакомыми компонентами: веб-серверами, базами данных, очередями сообщений, балансировщиками нагрузки и системами мониторинга.

Они разворачивают приложения на облачных платформах, динамически масштабируют ресурсы в зависимости от трафика и реагируют на инциденты, когда работа сервисов ухудшается. Инструменты инфраструктуры как код, такие как Terraform, позволяют определять целые среды программно, делая инфраструктуру воспроизводимой и контролируемой версиями.

Crypto DevOps расширяет эти принципы на мир децентрализованных сетей, но с существенными различиями, обусловленными архитектурой блокчейна. Вместо развертывания централизованных приложений, контролируемых одной командой, команды crypto DevOps управляют инфраструктурой, которая участвует в одноранговых сетях, где правила консенсуса определяют поведение. Вот перевод:

Системы оповещения обеспечивают видимость состояния инфраструктуры. Prometheus стал фактическим стандартом для сбора метрик в криптовалютных операциях, извлекая данные из инструментированных узлов и сохраняя временные ряды данных. Grafana преобразует эти метрики в визуальные панели, показывающие частоту запросов, задержки, проценты ошибок и использование ресурсов.

OpenTelemetry все чаще используется для распределенного трассирования, позволяя командам отслеживать потоки индивидуальных транзакций через сложные инфраструктурные стеки. Инструменты агрегации логов, такие как Loki или стек ELK, собирают и индексируют логи всех компонентов для устранения неполадок и анализа.

Рассмотрим практический пример: приложение DeFi, работающее на Ethereum, может полагаться на управляемый сервис RPC Infura для регулярных запросов о ценах токенов и балансах пользователей. То же самое приложение может запускать собственный валидатор на Polygon для участия в консенсусе этой сети и получения вознаграждений за стекинг.

Для сложных аналитических запросов приложение может размещать специальный индексатор Graph, отслеживающий события ликвидности и сделки. За кулисами все эти компоненты контролируются через панели Grafana, показывающие задержки RPC, эксплуатационную готовность валидатора, отставание индексатора от концевого блока цепи и пороги оповещения, настроенные для уведомления дежурных инженеров при возникновении проблем.

Эта архитектура представляет собой лишь базис. Более сложные установки включают использование нескольких резервных узлов для каждой цепи, резервных провайдеров RPC, автоматизированные механизмы переключения и комплексные планы восстановления после катастроф. Сложность масштабируется с увеличением числа поддерживаемых цепей, требования к времени безотказной работы и уровню сложности предлагаемых услуг.

Провайдеры управляемой инфраструктуры против самодостаточных установок

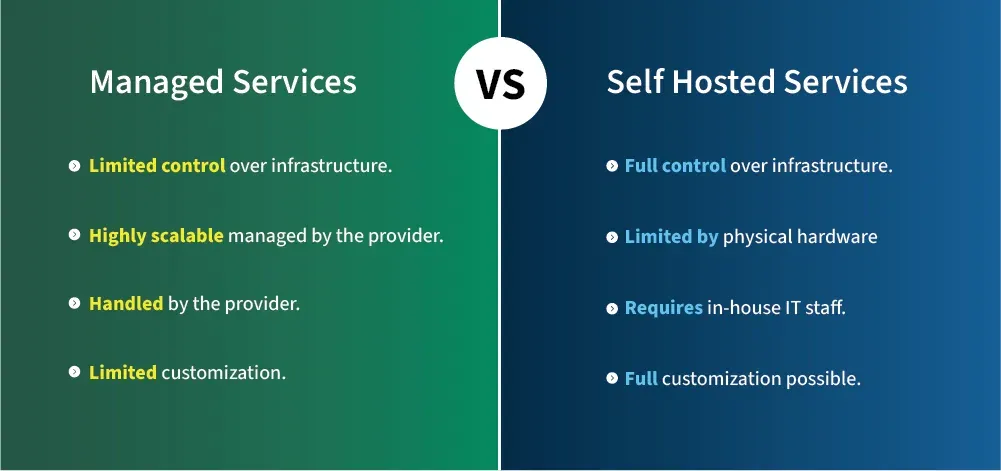

Команды в сфере криптовалют сталкиваются с фундаментальным операционным выбором: полагаться на управляемых провайдеров инфраструктуры или строить и поддерживать собственные системы. Этот выбор связан с значительными компромиссами в плане стоимости, контроля, надежности и стратегической позиции.

Управляемые провайдеры RPC появились, чтобы решить проблему сложности инфраструктуры для разработчиков приложений. Сервисы, такие как Infura, Alchemy, QuickNode, Chainstack, и Blockdaemon, предлагают мгновенный доступ к узлам блокчейна в нескольких сетях без операционных затрат. Разработчики регистрируются, получают API-ключи и могут сразу начать запросы через предоставленные конечные точки. Эти провайдеры занимаются техническим обслуживанием узлов, масштабированием, обновлениями и мониторингом.

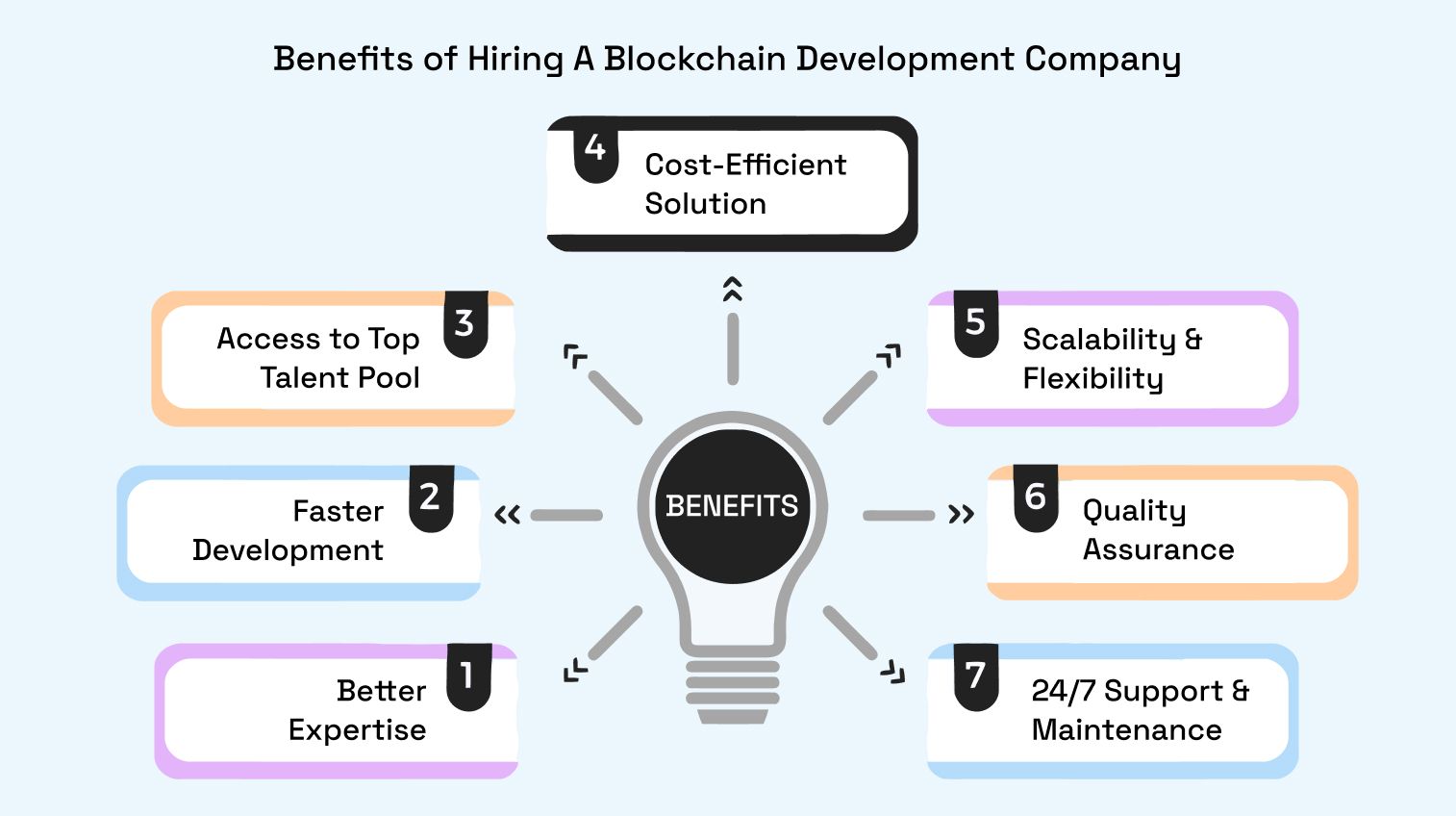

Преимущества управляемых сервисов значительны. Быстрое масштабирование позволяет приложениям справляться с всплесками трафика без необходимости подготовки инфраструктуры. Поддержка нескольких цепей означает, что разработчики получают доступ к десяткам сетей через одного провайдера, а не управляют узлами для каждой отдельной цепи. Поддержка на уровне предприятия предоставляет экспертную помощь в случае возникновения проблем.

Обычно управляемые провайдеры предлагают более высокие гарантии SLA, чем команды могли бы достичь самостоятельно без значительных инвестиций. Для стартапов и малых команд управляемые сервисы устраняют необходимость в найме специализированного персонала DevOps и значительно сокращают время до выхода на рынок.

Однако управляемая инфраструктура вводит зависимости, которые беспокоят серьезные протоколы. Риск централизации является самой значительной проблемой. Когда многие приложения полагаются на небольшое число провайдеров, эти провайдеры становятся потенциальными точками отказа или цензуры. Если Infura испытывает сбои, значительные части экосистемы Ethereum могут стать недоступными одновременно.

Это произошло в ноябре 2020 года, когда сбой в работе Infura не позволил пользователям получить доступ к MetaMask и многим приложениям DeFi. Инцидент подчеркнул, как децентрализованные приложения остаются зависимыми от централизованной инфраструктуры.

Зависимость от поставщика создает дополнительные риски. Приложения, которые сильно зависят от специфических функций API или оптимизаций провайдера, сталкиваются с значительными затратами на переход. Изменения ценовой политики, ухудшение качества услуг или банкротство провайдера могут вынудить к совершению вынужденных миграций. Важность конфиденциальности для приложений, работающих с чувствительными данными, касается того, что управляемые провайдеры могут потенциально отслеживать все запросы RPC, включая адреса пользователей и шаблоны транзакций.

Самоуправляемая инфраструктура предоставляет максимальный контроль и лучше соответствует принципам децентрализации Web3. Управление внутренними кластерами узлов, созданием специализированных API и мониторинговых стеков позволяет командам оптимизировать производительность для специфических случаев использования, реализовывать индивидуальные стратегии кэширования и поддерживать полную конфиденциальность данных.

Требования к соблюдению нормативных требований для регулируемых организаций часто требуют наличия на месте с документами для защиты конфиденциальных данных. Самоуправляемые установки позволяют выбирать специализированное аппаратное обеспечение, оптимизировать для специфических цепей и избегать совместного использования ресурсов с другими арендаторами.

Затраты на самоуправление значительны. Инфраструктура требует значительных капиталовложений в оборудование или облачные ресурсы. Накладные расходы на обслуживание включают управление обновлениями операционной системы, обновления клиентских программ блокчейна, патчи безопасности и планирование емкости. Управление узлами блокчейна 24/7 требует либо дежурных смен, либо оплаты инженерного персонала с круглосуточной доступностью. Достижение высокой доступности, сравнимой с управляемыми провайдерами, требует использования избыточной инфраструктуры в нескольких географических регионах.

Реальные подходы часто сочетают оба модели стратегически. Uniswap, одна из крупнейших децентрализованных бирж, использует нескольких провайдеров RPC, чтобы избежать единственных точек отказа. Интерфейс Uniswap может автоматически переключаться между провайдерами, если один из них становится недоступным или медленным.

Coinbase, действуя в огромном масштабе с строгими требованиями к соблюдению нормативных требований, построила обширную внутреннюю инфраструктуру через Coinbase Cloud, в то же время сотрудничая с внешними провайдерами для определённых цепей или для обеспечения резервирования. Ethereum Foundation поддерживает общественные конечные точки RPC для тестовых сетей, обеспечивая доступ разработчиков к этим сетям даже без платных услуг.

Зрелость протокола значительно влияет на решения. Проекты на ранних стадиях обычно начинают с управляемых провайдеров, чтобы быстро подтвердить продуктовое соответствие рынку без отвлечения на инфраструктуру. По мере роста протоколов и увеличения ставок они постепенно развивают внутренние возможности, начиная с критических компонентов, таких как валидаторы для цепей, где они совершили значительные капиталовложения. Зрелые протоколы часто реализуют гибридные установки, размещая основные инфраструктуры для контроля, оставаясь при этом в отношениях с управляемыми сервисами в качестве резервных или для менее критичных цепей.

Экономика решений сильно зависит от масштаба. Для приложений, обслуживающих тысячи запросов в месяц, управляемые провайдеры предлагают куда более выгодную экономику, чем фиксированные затраты на управление узлами. При миллионах запросов ежемесячно собственно управляемая инфраструктура часто становится более экономически выгодной, несмотря на более высокую операционную сложность. Помимо чисто экономических соображений, стратегические соображения, касающиеся децентрализации, конфиденциальности данных и платформенных рисков, определяют решения об инфраструктуре для протоколов, управляющих значительной стоимостью.

Время безотказной работы, надежность и соглашения об уровне обслуживания

В традиционных веб-приложениях время простоя неудобно. Пользователи ждут немного и повторяют попытку. В криптовалютной инфраструктуре время простоя может быть катастрофическим. Трейдеры, которые не могут получить доступ к биржам во время волатильных рынков, несут убытки. Пользователи DeFi, находящиеся в процессе ликвидационных событий, не могут добавить залог, если их кошельки не могут подключиться к протоколу. Валидаторы, отключенные в течение их назначенных промежутков, теряют вознаграждения и сталкиваются со штрафными санкциями. Финансовый характер блокчейн-приложений повышает надежность инфраструктуры от операционной проблемы до экзистенциального требования.

Соглашения об уровне обслуживания (SLA) количественно определяют ожидания в плане надежности. Уровень SLA в 99,9 % времени безотказной работы, часто называемый "тремя девятками", позволяет примерно 43 минуты простоя в месяц. Многие потребительские услуги функционируют на этом уровне приемлемо. Криптовалютная инфраструктура для предприятий нацелена на 99,99 %, или "четыре девятки", допускающие только около четырех минут простоя в месяц.

Самая критическая инфраструктура, такая как основные биржевые системы или крупные операционные валидационные системы, стремится к 99,999 %, позволяя всего лишь 26 секунд простоя в месяц. Каждая дополнительная девятка надежности становится экспоненциально дороже для достижения.

Профессиональные команды DevOps в области криптовалют достигают высокой доступности за счет резервирования на каждом уровне инфраструктуры. Развертывание в нескольких регионах распределяет инфраструктуру по географически удалённым местам. Облачные провайдеры предлагают регионы, охватывающие континенты, позволяя приложениям переживать полные сбои центров обработки данных.

Некоторые команды разворачивают в нескольких облачных провайдерах, смешивая AWS, Google Cloud и DigitalOcean, чтобы избежать риска одного провайдера. Другие совмещают облачные инстансы с физическими серверами в помещения для совместного размещения для оптимизации затрат и независимости от провайдера.

Системы переключения автоматически обнаруживают сбои и перенаправляют трафик к здоровым компонентам. Балансировщики нагрузки постоянно проверяют работоспособность узлов RPC, удаляя неотзывчивые инстансы из ротации. Резервные узлы остаются синхронизированными и готовы принять основную роль при необходимости. Некоторым сложным установкам удается использовать автоматизированные инструменты развертывания, чтобы в течение нескольких минут развернуть резервную инфраструктуру в случае сбоев, используя инфраструктуру как код для воспроизводимого восстановления систем.

Стратегии балансировки нагрузки выходят за пределы простого распределения запросов по кругу. Географическая маршрутизация отправляет пользователей к ближайшей региональной инфраструктуре, минимизируя задержки и обеспечивая резервное копирование в случае сбоя регионов. Взвешенная маршрутизация может постепенно смещать трафик при развертывании или тестировании новой инфраструктуры. Некоторые команды внедряют предохранители, которые обнаруживают снижение качества узлов через увеличенную частоту ошибок или задержки и временно удаляют их из ротации автоматически.

Специфические для цепей проблемы осложняют достижение консистентного времени безотказной работы. Solana столкнулась с несколькими серьезными сбоями в 2022 и 2023 годах, когда вся сеть остановилась, требуя координации валидаторов для перезапуска. Никакое количество инфраструктурыИзбыточность помогает, когда основная блокчейн-сеть перестает производить блоки.

Архитектура подсетей Avalanche создает преимущества для масштабирования, но требует от инфраструктурных команд запуска узлов для нескольких подсетей, что умножает операционную сложность. Переход Ethereum на proof-of-stake (доказательство доли) ввел новые соображения относительно эффективности валидаторов и избегания условий «наказаний».

Волатильность цен на газ в Ethereum создает еще одну операционную задачу. Во время перегрузки сети, затраты на транзакции непредсказуемо возрастают. Инфраструктура, обрабатывающая множество транзакций, должна внедрять сложные стратегии управления газом, включая динамические алгоритмы цен на газ, логику повторных попыток транзакций и иногда субсидирование пользовательских транзакций в экстремальных условиях.

Неправильное управление газом может привести к сбою транзакций или их бесконечному статусу ожидания, эффективно создавая простой приложений, даже если инфраструктура работает корректно.

Операции валидаторов сталкиваются с уникальными требованиями к времени безотказной работы. Валидаторы proof-of-stake должны оставаться онлайн и быть отзывчивыми, чтобы не пропустить назначенные им обязанности по аттестации и предложениям. Пропуск аттестаций снижает вознаграждения валидатора, тогда как длительное время простоя может привести к «наказанию», сжигая часть стейковой капитала.

Профессиональные ставки достигаются через чрезвычайно высокое время безотказной работы благодаря выделенному оборудованию, редундантным сетям, автоматическому переключению между основными и резервными валидаторами и сложному мониторингу, сигнализирующему о пропусках аттестаций за считанные секунды.

Пересечение риска протокола блокчейна и надежности инфраструктуры создает интересную динамику. Команды должны балансировать максимизацию времени безотказной работы своей инфраструктуры с участием в иногда ненадежных сетях.

Когда Solana остановилась, профессиональные инфраструктурные команды документировали инциденты, координировали перезапуски валидаторов и открыто сообщали клиентам о обстоятельствах, выходящих за пределы их контроля. Эти инциденты подчеркивают, что крипто DevOps выходит за рамки обслуживания серверов до активного участия в реакциях на инциденты на уровне протокола в публичных сетях.

Посещаемость и мониторинг

Профессиональные криптоинфраструктурные команды работают по основному принципу: невозможно управлять тем, что нельзя измерить. Всеобъемлющая посещаемость разделяет надежные операции от тех, которые постоянно гасят пожары. В системах, где проблемы часто каскадируют быстро, а финансовые ставки высоки, ранее обнаружение проблем и их точная диагностика становятся критически важными.

Наблюдаемость в инфраструктуре Web3 охватывает три столпа: метрики, логи и трассировки. Метрики предоставляют количественные измерения состояния системы и поведения с течением времени. Использование CPU, потребление памяти, дисковая I/O, пропускная способность сети — все это указывает на здоровье ресурсов. Метрики, специфичные для криптографических нужд, включают количество узлов-пиров, что указывает на здоровую сетевую подключенность; задержку синхронизации, показывающую, насколько узел отстал от конца цепочки; скорости запросов к RPC и задержки, показывающие загрузку приложения и отзывчивость; и скорости производства блоков для валидаторов.

Prometheus стал стандартной системой сбора метрик в крипто DevOps. Клиенты блокчейнов все чаще имеют конечные точки, совместимые с Prometheus, которые сборщики запрашивают периодически. Команды определяют правила записи для предагрегации общих запросов и правила оповещений, которые оценивают пороги метрик непрерывно. Prometheus хранит временные ряды данных эффективно, позволяя выполнить исторический анализ и выявление трендов.

Grafana преобразует сырые метрики в визуальные панели, доступные как техническим, так и нетехническим заинтересованным сторонам. Хорошо спроектированные панели показывают здоровье инфраструктуры с первого взгляда через цветокодированные панели, графики трендов и четкие индикаторы предупреждений.

Команды обычно поддерживают несколько уровней панелей: обзоры на высоком уровне для руководителей, показывающие обобщенное время безотказной работы и коэффициенты успеха запросов, операционные панели для команд DevOps, показывающие подробное использование ресурсов и показатели производительности, и специализированные панели для конкретных цепочек или компонентов, показывающие метрики, специфичные для протоколов.

Логи фиксируют подробную информацию о событиях, объясняющую, что делают системы и почему возникают проблемы. Логи приложений фиксируют значительные события, такие как обработка транзакций, запросы API и ошибки. Системные логи документируют события операционной системы и инфраструктуры.

Узлы блокчейна создают логи о соединениях с пирами, получении блоков, участии в консенсусе и ошибках валидации. Во время инцидентов логи предоставляют подробный контекст, необходимый для понимания коренных причин сбоев.

Системы агрегации логов собирают логи из распределенной инфраструктуры в централизованные запросные хранилища. Loki, часто используемый вместе с Grafana, предоставляет легковесную агрегацию логов с мощными возможностями запроса. Elasticsearch, Logstash и Kibana (ELK) предоставляют больше функций, но требуют больше ресурсов.

Структурированные логи, где приложения создают логи в формате JSON с согласованными полями, существенно улучшают возможность поиска логов и позволяют автоматический анализ.

Распределенная трассировка отслеживает индивидуальные запросы через сложные стеки инфраструктуры. В криптографических операциях одна пользовательская транзакция может касаться балансировщика нагрузки, маршрутизироваться к узлу RPC, запускать выполнение смарт-контракта, генерировать события, захваченные индексатором, и обновлять кеши.

Трассировка инструментарий каждого компонента для записи времени и контекста, позволяя командам визуализировать полные потоки запросов. OpenTelemetry появился как стандартный фреймворк трассировки, с увеличенной поддержкой по всей блокчейн-инфраструктуре.

Профессиональные команды мониторят как метрики инфраструктуры, так и показатели состояния протоколов. Метрики инфраструктуры выявляют ограничения ресурсов, сетевые проблемы и программные сбои.

Метрики протоколов выявляют проблемы, специфичные для цепочки, такие как коэффициенты участия валидаторов, размер мемпула и проблемы с консенсусом. Некоторые проблемы в основном проявляются в метриках протокола, в то время как инфраструктура выглядит здоровой, например, когда узел теряет связь с пирами из-за сетевого разделения, но продолжает работать нормально.

Оповещения преобразуют метрики в действенные уведомления. Команды определяют правила оповещений на основе порогов метрик, таких как задержка RPC выше 500 миллисекунд, количество узлов-пиров ниже 10 или задержка синхронизации индексатора более 100 блоков.

Уровни серьезности оповещений отличают проблемы, требующие немедленного внимания, от тех, которые могут подождать до рабочего времени. Интеграция с платформами управления инцидентами, такими как PagerDuty или Opsgenie, гарантирует, что нужные люди уведомлены через соответствующие каналы на основе серьезности и расписания дежурств.

Страницы статуса обеспечивают прозрачность о состоянии инфраструктуры для пользователей и партнеров. Инструменты, такие как UptimeRobot, Statuspage или BetterStack, мониторят доступность сервисов и отображают публичные панели, показывающие текущее состояние и историческое время безотказной работы. Крупные провайдеры поддерживают детализированные страницы статуса на уровне компонентов, позволяя пользователям видеть, какие конкретные цепочки или функции испытывают проблемы.

Примеры рабочих процессов мониторинга иллюстрируют посещаемость в действии. Когда задержка RPC увеличивается, оповещения срабатывают незамедлительно. Дежурные инженеры открывают панели, показывающие метрики узлов RPC, и быстро идентифицируют один узел, обрабатывающий гораздо больше запросов, чем другие, из-за ошибочной конфигурации балансировщика нагрузки. Они перераспределяют трафик и проверяют, чтобы задержка вернулась в норму. Логи подтверждают, что проблема началась после недавнего развертывания, что вызывает откат этого изменения. Трассировки показывают, какие конечные точки испытывали самую высокую задержку, направляя усилия по оптимизации.

Еще один распространенный сценарий включает обнаружение задержки синхронизации. Индексатор отстает от конца цепочки после периода высокого объема транзакций. Оповещения срабатывают, когда задержка превышает пороги. Инженеры, исследуя логи, обнаруживают, что база данных индексатора работает медленно из-за отсутствия индексов на недавно добавленных таблицах. Они добавляют подходящие индексы, и синхронизация догоняет. Анализ после инцидента приводит к автоматическому тестированию производительности индексатора перед развертываниями, чтобы предотвратить повторение.

Реакция на инциденты и управление кризисами

Несмотря на тщательное планирование и надежную инфраструктуру, инциденты происходят. Сетевые проблемы, ошибки программного обеспечения, аппаратные сбои и проблемы на уровне протоколов в конечном итоге влияют даже на самые лучшие системы. То, как команды реагируют на инциденты, отличает зрелые операции от начинающих. В криптографии, где инциденты могут быстро развиться в перебои для пользователей или финансовые потери, быстрая и систематическая реакция на инциденты крайне важна.

Профессиональные команды крипто DevOps поддерживают круглосуточные дежурные смены. В любой момент выделенные инженеры доступны, чтобы отреагировать на производственные оповещения в течение нескольких минут. Обязанности дежурства ротируются среди квалифицированных членов команды, как правило, меняются еженедельно, чтобы предотвратить выгорание. Команды должны быть укомплектованы штатно по всем часовым поясам, чтобы избежать чрезмерной нагрузки на отдельных инженеров. Для критической инфраструктуры команды часто поддерживают основное и вторичное дежурство, обеспечивая резервное покрытие, если основной ответственный недоступен.

Автоматизированные системы оповещений формируют основу для обнаружения инцидентов. Вместо того чтобы люди постоянно смотрели на панели, системы мониторинга постоянно оценивают условия и обращаются к инженерам, когда превышены пороги. Интеграция с платформами, такими как PagerDuty или Opsgenie, обрабатывает маршрутизацию оповещений, политики эскалации и отслеживание подтверждений. Хорошо настроенные оповещения балансируют чувствительность, быстро выявляя реальные проблемы, с учетом специфичности, чтобы избежать усталости от частых ложных положительных срабатываний, которые учат инженеров игнорировать уведомления.

Когда инциденты происходят, структурированные процессы реакции направляют действия. Инженеры, получающие оповещения, подтверждают их немедленно, сигнализируя о сознании и предотвращая эскалацию. Они быстро оценивают серьезность, используя предопределенные критерии. Инциденты уровня серьезности 1 включают сбои, влияющие на пользователя, или потерю данных, требующие немедленной реагирования всей команды. Инциденты уровня 2 влияют на функциональность, значительно снизившуюся, но не полностью. Content: недоступно. Инциденты с низкой серьезностью могут подождать до рабочих часов.

Коммуникация при инцидентах крайне важна. Команды создают специальные каналы коммуникации, часто это каналы в Slack или специализированные платформы для управления инцидентами, где происходит координация реагирующих. Регулярные обновления статуса для заинтересованных сторон предотвращают дублирование расследований и поддерживают руководство в курсе. Для инцидентов, влияющих на пользователей, обновления в статусных страницах и социальных сетях помогают установить ожидания и поддерживать доверие.

Типичные сбои в криптоинфраструктуре включают десинхронизацию узлов, когда клиенты блокчейн выходят из общего согласия с сетью из-за ошибок программного обеспечения, разделений сети или истощения ресурсов. Восстановление часто требует перезапуска узлов, возможно, с повторной синхронизацией из снимков. Перегрузка RPC происходит, когда объем запросов превышает емкость инфраструктуры, вызывая тайм-ауты и ошибки. Нематериализованные меры снижения включают ограничение скорости, активацию дополнительной емкости или переключение на резервных провайдеров.

Крушение индексаторов может происходить из-за ошибок программного обеспечения при обработке неожиданных транзакционных паттернов или проблем с емкостью базы данных. Быстрые решения могут включать перезапуск с увеличенными ресурсами, в то время как постоянные решения требуют исправлений кода или оптимизации схемы. Несоответствия событий смарт-контрактов возникают, когда индексаторы ожидают специфических форматов событий, а контракты их распространяют иначе, вызывая ошибки обработки. Решение требует либо обновления логики индексатора, либо понимания причин неожиданного поведения контрактов.

Отключения сети Solana в 2022 году дают поучительные примеры реагирования на инциденты большего масштаба в криптовалюте. Когда сеть остановилась из-за истощения ресурсов в результате активности ботов, операторы валидаторов по всему миру координировались через каналы Discord и Telegram для диагностики проблем, разработки исправлений и организации перезапуска сети. Команды инфраструктуры одновременно общались с пользователями о ситуации, документировали временные рамки и обновляли статусные страницы. Инциденты подчеркнули уникальные вызовы децентрализованного реагирования на инциденты, где ни одна из сторон не контролирует инфраструктуру.

События перегрузки Ethereum RPC иллюстрируют разные вызовы. Во время значительной рыночной волатильности или популярных запусков NFT объемы запросов RPC резко возрастают. Провайдеры сталкиваются с трудными решениями по ограничению скорости, что защищает инфраструктуру, но расстраивает пользователей, в сравнении с приемом деградированной производительности или отключений. Продвинутые провайдеры внедряют многоуровневые уровни обслуживания, отдавая приоритет платным клиентам, в то время как более агрессивно ограничивают бесплатные уровни.

Анализ корневой причины и культура постмортемов являются признаками зрелых операций. После разрешения инцидентов команды проводят необвинительные постмортемы, анализируя, что произошло, почему это произошло и как предотвратить повторение. Документы постмортема включают детализированные временные рамки инцидента, сопутствующие факторы, оценку воздействия и конкретные действия с назначенными владельцами и сроками. Необвинительный аспект важен: постмортемы сосредотачиваются на системных проблемах и улучшении процессов, а не на индивидуальной вине, поощряя честный анализ и обучение.

Действия, вытекающие из постмортемов, продвигают непрерывное улучшение. Если инцидент произошел из-за отсутствия мониторинга, команды добавляют соответствующие метрики и оповещения. Если недостаточная документация замедлила реакцию, они улучшают рабочие руководства. Если единичный пункт отказа вызвал остановку, они проектируют избыточность. Отслеживание и выполнение действий из постмортемов предотвращает повторяющиеся инциденты и укрепляет организационные знания.

Стратегии масштабирования для инфраструктуры Web3

Масштабирование блокчейн-инфраструктуры принципиально отличается от масштабирования традиционных веб-приложений, требуя специализированных стратегий, которые учитывают уникальные ограничения децентрализованных систем. В то время как приложения Web2 часто могут масштабироваться горизонтально, добавляя идентичные серверы за балансировщиками нагрузки, блокчейн-инфраструктура включает компоненты, которые не могут быть просто реплицированы для увеличения емкости.

Критическое ограничение заключается в том, что сами блокчейны не могут горизонтально масштабироваться для увеличения пропускной способности консенсуса. Добавление большего количества узлов валидаторов в сеть с доказательством доли не увеличивает емкость обработки транзакций; это просто распределяет валидацию между большим числом участников. Пропускная способность сети определяется параметрами протокола, такими как размер блока, время блока и ограничения газа, а не тем, сколько инфраструктурных операторов задействовано. Это фундаментальное ограничение формирует все подходы к масштабированию.

Горизонтальное масштабирование помогает в разделе чтения. Запуск нескольких узлов RPC за балансировщиками нагрузки позволяет инфраструктуре обслуживать большее количество одновременных запросов о состоянии блокчейна. Каждый узел хранит полную копию цепочки и может самостоятельно отвечать на запросы. Профессиональные настройки включают десятки или сотни узлов RPC для обработки высокого объема запросов. Географическое распределение размещает узлы ближе к пользователям по всему миру, снижая задержки за счет уменьшения сетевых расстояний.

Балансировка нагрузки между узлами RPC требует интеллектуальных алгоритмов, которые превышают простое распределение по кругу. Стратегии наименьшего подключения направляют запросы к узлам, обрабатывающим наименьшее количество активных подключений, динамически балансируя нагрузку. Взвешенные алгоритмы учитывают узлы с разной емкостью, отправляя пропорционально больше трафика на мощные серверы. Проверка работоспособности постоянно тестирует отзывчивость узлов, удаляя узлы с ухудшенной работой из ротации до того, как они вызовут видимые пользователям ошибки.

Кэширование значительно снижает нагрузку на бэкенд для повторяющихся запросов. Многие запросы блокчейна запрашивают данные, которые редко изменяются, такие как метаданные токенов, исторические детали транзакций или код смарт-контрактов. Кэширование этих ответов в Redis, Memcached или в местах расположения CDN-краев позволяет обслуживать повторные запросы, не обращаясь к узлам блокчейна. Стратегии инвалидации кэша различаются в зависимости от типа данных: полностью неизменяемые исторические данные могут кэшироваться бесконечно, в то время как текущее состояние требует коротких значений времени жизни или явной инвалидации при появлении новых блоков.

Сети доставки контента расширяют кэширование глобально. Для статического контента, как метаданные токенов или изображения NFT, CDN кэшируют копии в краевых местах по всему миру, обслуживая пользователей из ближайшего географического места. Некоторые продвинутые настройки кэшируют даже динамические запросы блокчейн на краевых местах с очень короткими значениями TTL, резко улучшая время отклика для часто доступных данных.

Индексаторы требуют других подходов к масштабированию, так как они должны обрабатывать каждый блок и транзакцию. Шардированные архитектуры индексирования распределяют данные блокчейна по нескольким экземплярам индексаторов, каждый из которых обрабатывает подмножество контрактов или типов транзакций.

Этот параллелизм увеличивает емкость обработки, но требует координации для поддержания согласованности. Потоковые архитектуры данных, такие как Apache Kafka, позволяют индексаторам использовать события блокчейна через паттерны публикации-подписки, позволяя нескольким потребителям обрабатывать данные независимо на разных скоростях.

Интеграция с решениями на слое 2 и суммами предлагает альтернативные подходы к масштабированию. Оптимистические и zkRollups объединяют транзакции вне цепи, публикуя сжатые данные в слой 1 для безопасности. Поддержка инфраструктурой слоев 2 требует запуска узлов Rollup и секвенсоров, добавляя сложность, но обеспечивая гораздо более высокую пропускную способность транзакций. Запрос состояния Rollup требует специализированной инфраструктуры, которая понимает архитектуру Rollup и может предоставлять согласованные представления о состоянии между слоями 1 и 2.

Архивные узлы в сравнении с подрезанными узлами представляют собой другой компромисс для масштабирования. Полные архивные узлы хранят каждое историческое состояние, позволяя запросы о любом прошлом состоянии блокчейна, но требуя огромного хранилища (несколько терабайт для Ethereum). Подрезанные узлы отбрасывают старое состояние, сохраняя только недавнюю историю и текущее состояние, значительно снижая потребности в хранилище, но ограничивая возможности исторических запросов. Команды выбирают в зависимости от своих потребностей: приложениям, требующим исторического анализа, нужны архивные узлы, в то время как те, кто запрашивает только текущее состояние, могут использовать подрезанные узлы более экономно.

Специализированная инфраструктура для конкретных случаев использования позволяет применять фокусированные оптимизации. Вместо запуска универсальных узлов, обрабатывающих все виды запросов, некоторые команды развертывают узлы, оптимизированные под конкретные паттерны. Узлы с дополнительной оперативной памятью могут кэшировать большее состояние для более быстрых запросов. Узлы с быстрыми SSD приоритетны для времени на чтение. Узлы с высокоскоростными сетевыми соединениями эффективно обрабатывают потоки подписок на события в режиме реального времени. Эта специализация позволяет экономически эффективно соответствовать различным требованиям к производительности.

Платформы с услугой Rollups добавляют дополнительные измерения масштабирования. Услуги, такие как Caldera, Conduit и Altlayer, позволяют командам развертывать приложений-специфические Rollups с настройками параметров. Эти специальные цепи предоставляют выделенную пропускную способность для конкретных приложений, сохраняя безопасность через урегулирование на установленных цепях Layer 1. Команды инфраструктуры должны управлять секвенсорами, доказателями и мостами, но получают контроль над своей пропускной способностью и экономикой газа.

Модульные архитектуры блокчейнов, такие как Celestia, Eigenlayer и аналогичные платформы, разделяют слои консенсуса, доступности данных и выполнения. Эта компонация позволяет командам инфраструктуры смешивать и сочетать компоненты, потенциально масштабируя разные аспекты независимо. Rollup может использовать Ethereum для урегулирования, Celestia для доступности данных и свою собственную среду выполнения, требуя инфраструктуру, охватывающую несколько различных систем.

Дорожная карта масштабирования в будущем включает все более и более сложные архитектурные паттерны. Генерация доказательств с нулевым знанием для Rollups с проверками требует специализированного оборудования, часто используются GPU или специальные ASIC, добавляя совершенно новые категории инфраструктуры. Параллельные среды выполнения обещают повышение пропускной способности за счет лучшего использования современных многопроцессорных архитектур, но требуют обновлений инфраструктуры для поддержки этих моделей выполнения.

Контроль затрат и оптимизация

Запуск блокчейн-инфраструктуры дорогостоящ, включая затраты на вычислительные ресурсы, хранилище, пропускную способность и Пропустите перевод для ссылок в формате markdown.

Содержание: персонал. Профессиональные команды балансируют надежность и производительность с экономическими ограничениями через тщательное управление затратами и стратегии оптимизации.

Драйверы стоимости инфраструктуры варьируются в зависимости от типа компонента. Затраты на хостинг узлов включают вычислительные экземпляры или физические серверы, которые должны оставаться онлайн непрерывно. Полные узлы Ethereum требуют мощных машин с быстрыми процессорами, 16ГБ+ ОЗУ и высокоскоростного хранилища. Операции валидаторов требуют еще большей надежности, часто оправдывающей выделенное оборудование. Стоимость облачных экземпляров накапливается непрерывно; даже скромные узлы стоят сотни долларов в месяц за экземпляр, умножаясь с ростом числа блокчейнов и избыточных развертываний.

Пропускная способность представляет собой значительную стоимость, особенно для популярных RPC-краевых точек. Каждый запрос к блокчейну потребляет пропускную способность, и высоконагруженные приложения могут передавать терабайты ежемесячно. Узлы архивов, обслуживающие исторические данные, передают особенно большие объемы. Облачные провайдеры взимают плату отдельно за исходящую полосу пропускания, иногда по удивительно высоким ставкам. Некоторые команды переезжают к провайдерам с более выгодным ценообразованием на полосу пропускания или используют физическое размещение с фиксированными тарифами.

Затраты на хранилище постоянно растут, поскольку блокчейны накапливают историю. Цепочка Ethereum превышает 1ТБ для полных архивных узлов и продолжает расти. NVMe SSD высокой производительности, необходимые для удовлетворительной производительности узлов, стоят значительно больше, чем традиционные жесткие диски. Команды предусматривают емкость хранилища с учетом прогнозов роста, избегая дорогих аварийных расширений, когда диски заполняются.

Доступ к данным через управляемых провайдеров RPC следует иной экономике. Провайдеры обычно взимают плату за каждую API-запрос или через месячные подписки с включенными квотами запросов. Цены значительно варьируются между провайдерами и масштабируются с объемом запросов. Приложения с миллионами ежемесячных запросов могут столкнуться с потенциально значительными счетами. Некоторые провайдеры предлагают скидки на объем или специальные корпоративные соглашения для крупных клиентов.

Стратегии оптимизации начинаются с правильного размера инфраструктуры. Многие команды чрезмерно предусматривают ресурсы, запуская узлы с избыточной емкостью, которая остается неиспользуемой большую часть времени. Тщательный мониторинг показывает фактическое использование ресурсов, позволяя уменьшить размер до подходящих экземпляров. Облачные среды облегчают это через изменение типов экземпляров, хотя команды должны сбалансировать экономию с рисками надежности от работы ближе к пределам емкости.

Эластичное масштабирование использует возможности автоматического масштабирования облачных провайдеров для увеличения емкости в пиковые периоды трафика и сокращения в тихие периоды. Это хорошо работает для горизонтально масштабируемых компонентов, таких как RPC-узлы, где можно запустить дополнительные экземпляры в течение нескольких минут, когда повышаются ставки запросов, и завершить, когда нагрузка уменьшается. Эластичное масштабирование снижает затраты, избегая непрерывной работы емкости, необходимой только временно.

Экземпляры Spot и прерываемые виртуальные машины предлагают существенно сниженные затраты на вычисления в обмен на принятие, что облачные провайдеры могут запрашивать экземпляры в кратчайшие сроки. Для задач с отказоустойчивостью, таких как избыточные RPC-узлы, экземпляры Spot сокращают затраты на 60-80 процентов. Инфраструктура должна плавно обрабатывать завершение экземпляров, автоматически заменяя потерянные экземпляры из пулов и обеспечивая достаточную избыточную емкость, так что потеря отдельных экземпляров не влияет на доступность.

Узлы с обрезкой меняют возможность исторических запросов на сниженные требования к хранилищу. Большинство приложений нуждаются только в текущем состоянии блокчейна, а не в полной истории. Узлы с обрезкой участвуют в консенсусе и могут обслуживать запросы на текущее состояние, потребляя лишь часть хранилища по сравнению с архивными узлами. Команды содержат несколько архивных узлов для конкретных исторических запросов, работая в основном с обрезными узлами.

Выбор между архивными и неархивными узлами зависит от требований приложения. Архивные узлы необходимы для приложений, запрашивающих историческое состояние, таких как платформы аналитики или обозреватели блоков. Большинство DeFi и NFT-приложений нуждаются только в текущем состоянии, делая дорогие архивные узлы ненужными. Гибридный подход поддерживает один архивный узел на цепь для редких исторических запросов, используя при этом обрезные узлы для рутинных операций.

Кэширование и оптимизация запросов существенно снижают избыточную нагрузку на узлы. Приложения часто неоднократно запрашивают одни и те же данные, такие как цены токенов, имена ENS или состояние популярных смарт-контрактов. Внедрение кэширования на уровне приложения с надлежащими политиками отмены предотвращает повторные запросы узлов для неизменных данных. Некоторые команды анализируют шаблоны запросов, чтобы выявить возможности оптимизации, добавляя специализированные кэши или предварительно подсчитанные результаты для общих типов запросов.

Зарезервированные экземпляры для предсказуемой основной емкости предоставляют значительные облачные экономии по сравнению с оплатой по требованию. Большинство инфраструктур блокчейнов требует непрерывной работы, делая зарезервированные экземпляры с обязательствами на один или три года привлекательными. Команды резервируют емкость для основных нужд, используя экземпляры по требованию или spot для пиковых нагрузок, оптимизируя затраты по всему парку.

Стратегии мультиоблачных и физических решений снижают зависимость от вендоров и оптимизируют затраты. Развертывание в AWS, Google Cloud и DigitalOcean позволяет выбирать наиболее экономичного провайдера для каждой рабочей нагрузки. Физические серверы в колокационных центрах предлагают лучшую экономику в масштабе с предсказуемыми ежемесячными затратами, хотя и требуют большего операционного опыта. Гибридный подход сохраняет присутствие в облаке для гибкости, переходя стабильные нагрузки на собственное оборудование.

Постоянное мониторинг и анализ затрат важны для оптимизации. Облачные провайдеры предоставляют инструменты управления затратами, показывающие модели расходов по типу ресурсов. Команды устанавливают бюджеты, настраивают оповещения о расходах и регулярно проверяют затраты, чтобы выявить неожиданные увеличения или возможности для优化изации. Маркировка ресурсов по проекту, команде или цели позволяет понять, какие приложения создают затраты и где стоит сосредоточить усилия по оптимизации.

Ценовые модели поставщиков сильно различаются и требуют внимательного сравнения. Alchemy предлагает тарифные планы с оплатой по мере использования и по подписке с разными ограничениями. QuickNode ценообразует по кредитам за запросы. Chainstack предоставляет выделенные узлы по подписке. Понимание этих моделей и мониторинг использования позволяет выбрать наиболее экономичного поставщика для конкретных нужд. Некоторые приложения используют разных провайдеров для разных цепей на основе относительных цен.

Решение строить или покупать связано с сравнением полной стоимости владения. Управляемые услуги предсказуемо стоят, но накапливаются непрерывно. Самостоятельная инфраструктура имеет более высокие начальные затраты и текущие расходы на персонал, но потенциально более низкие удельные затраты в масштабе. Точка безубыточности зависит от объемов запросов, поддерживаемых цепей и возможностей команды. Многие протоколы начинают с управляемых услуг и переходят на собственную инфраструктуру, когда масштабы оправдывают инвестиции.

Операции на нескольких цепях и проблемы интероперабельности

Современные крипто-приложения все чаще работают на нескольких блокчейнах, обслуживая пользователей на Ethereum, Polygon, Arbitrum, Avalanche, Solana и множестве других цепей. Множество цепей усложняют инфраструктуру, требуя от команд управления гетерогенными системами с различными архитектурами, инструментами и характеристиками операций.

Цепи, совместимые с EVM, включая Ethereum, Polygon, BNB Smart Chain, Avalanche C-Chain и Layer 2 такие как Arbitrum и Optimism, имеют схожие требования к инфраструктуре. Эти цепи работают с совместимым программным обеспечением узлов, таким как Geth или его форки, предоставляют JSON-RPC API с согласованными методами и используют те же инструменты для операций. DevOps команды могут часто повторно использовать шаблоны развертывания, конфигурации мониторинга и операционные рабочие книги между EVM цепями с незначительными корректировками для параметров, специфичных для цепей.

Тем не менее, даже у EVM цепей имеются значительные отличия, требующие конкретных операционных знаний. Высокая пропускная способность транзакций Polygon требует узлов с большей пропускной способностью ввода-вывода, чем у Ethereum. Arbitrum и Optimism роллапс-пакеты вводят дополнительные компоненты типа систем секвенсоров и систем доказательства мошенничества, которые команды инфраструктуры должны понимать и эксплуатировать. Архитектура подсетей Avalanche потенциально требует одновременного запуска узлов для нескольких подсетей. Динамика цен на газ существенно различается между цепями, требуя цепе-специфических стратегий управления транзакциями.

Не-EVM цепи представляют совершенно другие операционные парадигмы. Solana использует свой собственный клиент-валидатор, написанный на Rust, требующий других спецификаций оборудования, подходов к мониторингу и операционных процедур, чем Ethereum. Узлы Solana нуждаются в мощных процессорах и быстрой сети из-за высокой нагрузочной способности и интенсивности протокола слухов. Модель работы отличается принципиально: состояние Solana растет медленнее, чем у Ethereum, но требует других стратегий резервного копирования и создания снимков.

Aptos и Sui представляют другую архитектурную семью с языком программирования Move и различными механизмами консенсуса. Эти цепи требуют изучения совершенно новых процедур работы узлов, шаблонов развертывания и подходов к устранению неполадок. Move-цепи могут потребовать понимания новых форматов транзакций, моделей состояния и семантики выполнения по сравнению с опытом EVM.

Цепи Cosmos, использующие консенсусный движок Tendermint, вводят еще одну операционную модель. Каждая цепочка Cosmos потенциально использует различную логику приложения, построенную на базе SDK Cosmos, при этом общие свойства уровня консенсуса сохраняются. Команды инфраструктуры, эксплуатирующие несколько цепочек Cosmos, должны управлять многочисленными независимыми сетями, используя при этом общие операционные знания о Tendermint.

Фрагментация инструментов между цепями создает существенные операционные проблемы. Мониторинг узлов Ethereum использует хорошо установленные инструменты, такие как экспортеры Prometheus, встроенные в основные клиенты. Мониторинг Solana требует различных экспортеров, предоставляющих метрики, специфичные для цепи. Каждая экосистема блокчейнов разрабатывает свои собственные инструменты мониторинга, регистрации...

Standards and Debugging Utilities

Команды, работающие с несколькими цепями, либо принимают фрагментацию инструментов, используя разные стеки мониторинга для каждой цепи, либо вкладываются в создание унифицированных платформ наблюдаемости, абстрагирующих различия цепей.

Индексирующая инфраструктура сталкивается с аналогичной разнородностью. Протокол The Graph, доминирующий в индексировании Ethereum, расширяет поддержку для других цепей EVM и некоторых цепей без EVM, но покрытие остается неполным. Solana использует различные решения для индексирования, такие как Pyth или пользовательские индексаторы. Создание консистентных возможностей индексирования по всем цепям часто требует управления несколькими различными платформами индексирования и, возможно, создания пользовательских слоев интеграции.

Сложность оповещений растет мультипликативно с увеличением количества цепей. Каждая цепь требует мониторинга статуса синхронизации, подключения к коллегам и метрик производительности. Операции валидатора на нескольких цепях требуют отслеживания различных ставок ставок, ставок вознаграждений и условий среза. RPC-инфраструктура обслуживает различные конечные точки для каждой цепи с потенциально разными характеристиками производительности. Агрегирование оповещений межу цепями, обеспечивая при этом достаточную детализацию для быстрого устранения неполадок, создает проблемы для систем управления инцидентами.

Дизайн многоверижного дашборда требует баланса между полной видимостью и перегрузкой информацией. Высокоуровневые дашборды отображают общее состояние здоровья всех цепей, с возможностью углубления в детали для каждой отдельной цепи. Цветовое кодирование и четкая маркировка помогают операторам быстро определить, в какой цепи возникли проблемы. Некоторые команды организуют мониторинг по сервисам, а не по цепям, создавая дашборды для инфраструктуры RPC, операций валидаторов и индексирующей инфраструктуры, которые включают метрики для всех соответствующих цепей.

Управление развертыванием и конфигурацией становится сложным с увеличением числа цепей. Инструменты инфраструктуры как код, такие как Terraform, помогают управлять сложностью, определяя инфраструктуру программно. Команды создают переиспользуемые модули для общих шаблонов, таких как "развернуть узел RPC" или "настроить мониторинг", которые работают в разных цепях с подходящими параметрами. Системы управления конфигурацией, такие как Ansible или SaltStack, поддерживают консистентность между экземплярами и цепями.

Комплектация штата для многоверижных операций требует баланса между специализацией и эффективностью. Некоторые команды назначают специалистов для каждой цепи, которые развивают глубокую экспертизу в конкретных экосистемах. Другие обучают операторов по всем цепям, принимая более поверхностные знания о каждой цепи в обмен на операционную гибкость. Зрелые команды зачастую смешивают подходы: общие операторы занимаются рутинными задачами по всем цепям, тогда как специалисты помогают с комплексными вопросами и руководят по своим цепям.

Кросс-цепная коммуникационная инфраструктура вводит дополнительные операционные уровни. Операции мостов требуют управления валидаторами или ретрансляторами, которые одновременно мониторят несколько цепей, обнаруживают события на исходных цепях и инициируют действия на целевых цепях. Инфраструктура мостов должна справляться с конкурирующими многоверижными операциями, обеспечивая безопасность от атак ретрансляции или цензуры. Некоторые сложные протоколы управляют своими собственными мостами, добавляя значительную сложность в объем инфраструктуры.

Разнородность многоверижных операций создает естественное давление в сторону модульных архитектур и слоев абстракции. Некоторые команды строят внутренние платформы, абстрагирующие цепеспецифические различия через унифицированные API. Другие принимают участие в развитии многоверижных стандартов и инструментов, стремясь предоставить консистентные операционные интерфейсы по всем цепям. По мере того, как индустрия созревает, улучшение инструментов и стандартизации может уменьшить сложность многоверижных операций, но текущая реальность требует, чтобы команды справлялись со значительной разнородностью.

Безопасность, Соответствие и Управление Ключами

Операции крипто-инфраструктуры включают в себя значительные соображения по безопасности, выходящие за рамки типичных практик DevOps. Финансовая природа блокчейн-систем, постоянство транзакций и требования к управлению криптографическими ключами требуют повышенной дисциплины безопасности во всех операциях инфраструктуры.

Защита ключей API и учетных данных является основополагающей практикой безопасности. Конечные точки RPC, ключи доступа к облачным провайдерам, учетные данные сервисов мониторинга и токены доступа к инфраструктуре требуют осторожного управления. Экспозиция производственных ключей API может позволить несанкционированный доступ к инфраструктуре или конфиденциальным данным. Команды используют системы управления секретами, такие как HashiCorp Vault, AWS Secrets Manager или секреты Kubernetes, чтобы хранить учетные данные зашифрованными и управляемыми доступом. Политики автоматической ротации периодически возобновляют учетные данные, ограничивая окна экспозиции в случае нарушения.

Безопасность узлов начинается с защиты на уровне сети. Узлы блокчейна должны быть доступными для коллег, но не открытыми для произвольного доступа из интернета. Фаерволы ограничивают входящие соединения только до необходимых портов, обычно это протоколы взаимного обмена сообщениями и администраторский доступ SSH. Конечные точки RPC, обслуживающие приложения, выходят в интернет, но реализуют ограничение скорости, чтобы предотвратить атаки отказа в обслуживании. Некоторые команды разворачивают узлы за VPN или в частных сетях, размещая их через тщательно настроенные балансировщики нагрузки с защитой от DDoS.

Защита от DDoS атак критически важна для публично доступной инфраструктуры. Распределенные атаки отказа в обслуживании перегружают инфраструктуру трафиком, стремясь переполнить возможности и вызвать сбои. Облачные сервисы смягчения последствий DDoS, такие как Cloudflare, фильтруют вредоносный трафик перед тем, как он достигает инфраструктуры. Ограничение скорости на нескольких уровнях сдерживает частоту запросов на один IP-адрес или ключ API. Некоторая инфраструктура внедряет ограничение скорости на основе доказательства работы или доли, где запрашивающие должны продемонстрировать вычислительную работу или положить токены на кон, чтобы предотвратить спам.

Шифрование TLS защищает данные при передаче. Все конечные точки RPC должны использовать HTTPS с действительными TLS-сертификатами, а не незашифрованный HTTP. Это предотвращает подслушивание обращений к блокчейну, которые могут раскрыть торговые стратегии или поведение пользователей. Подключения WebSocket для подписок в реальном времени также требуют защиты TLS. Инструменты управления сертификатами, такие как Let's Encrypt, автоматизируют выдачу и обновление сертификатов, устраняя оправдания для незашифрованных коммуникаций.

Управление доступом следует принципу наименьших привилегий. Инженеры получают только те минимальные разрешения, которые необходимы для их ролей. Доступ к производственной инфраструктуре ограничивается старшими операторами с документированной необходимостью. Требования к многофакторной аутентификации защищают от кражи учетных данных. Ведения аудита записывает весь доступ к инфраструктуре и изменения, позволяя проводить судебный анализ, если возникают вопросы безопасности.

Операции валидаторов вводят специфические вызовы управления ключами. Ключи подписи валидаторов должны оставаться защищенными, так как компрометация позволяет злоумышленникам предлагать неблагонадежные блоки или подписывать противоречащие друг другу аттестации, что приводит к срезу. Профессиональные операции валидаторов используют аппаратные модули безопасности (HSM) или удаленную подпись, которая хранит ключи подписи в защищенных средах отдельно от процессов валидатора. Эта архитектура означает, что даже если узлы валидатора будут скомпрометированы, ключи подписи остаются защищенными.

Горячие кошельки, управляющие операционными фондами, требуют тщательного проектирования безопасности. Инфраструктура часто управляет кошельками, финансирующими газ для транзакций или управляющими операциями протоколов. Хотя хранение ключей в сети позволяет автоматизировать операции, это увеличивает риск кражи. Команды балансируют удобство автоматизации и безопасность через многоуровневую архитектуру кошельков: малые горячие кошельки для рутинных операций, теплые кошельки, требующие утверждения для больших переводов, и холодное хранилище для резервов.

Резервное копирование и процедуры восстановления после сбоев должны защищать от случайной утраты и злонамеренной кражи данных. Зашифрованные резервные копии, хранящиеся в географически разнообразных местах, защищают критические данные, включая базы данных узлов, файлы конфигурации и надежно хранящиеся учетные данные. Процедуры восстановления тестируются регулярно, чтобы убедиться, что они действительно работают, когда это необходимо. Некоторые операции валидаторов поддерживают полную резервную инфраструктуру, которая может быстро перейти к выполнению производственных функций, если основная инфраструктура выходит из строя катастрофически.

Безопасность цепочки поставок становится все более важной после громких компромиссов. Команды тщательно проверяют программные зависимости, предпочитая хорошо поддерживаемые проекты с открытым кодом и прозрачными процессами разработки. Инструменты сканирования зависимостей выявляют известные уязвимости в пакетах. Некоторые команды, акцентирующие внимание на безопасности, проводят аудит критических зависимостей или поддерживают форки с более строгими требованиями безопасности. Сканирование образов контейнеров проверяет наличие уязвимостей в артефактах развертывания инфраструктуры.

Требования к соответствию значительно влияют на операции инфраструктуры для регулируемых субъектов или тех, кто обслуживает институциональных клиентов. Сертификация по SOC 2 Type II демонстрирует операционные контроли по безопасности, доступности, целостности обработки, конфиденциальности и защите. Сертификация ISO 27001 показывает всеобъемлющие системы управления информационной безопасностью. Эти рамки требуют документированной политики, регулярных аудитов и непрерывного мониторинга – накладные расходы, которые команды инфраструктуры должны планировать и поддерживать.

Реакция на инциденты безопасности отличается от операционных инцидентов. Безопасные инциденты требуют сохранения улик для судебного анализа, возможности уведомления затронутых пользователей или регуляторов и координации с юридическими командами. Плейбуки реакций на сценарии безопасности руководят командами через эти особые соображения, при этом все же быстро восстанавливая обслуживание.

Тестирование на проникновение и аудиты безопасности периодически проверяют безопасность инфраструктуры. Внешние специалисты пытаются скомпрометировать системы, выявляя уязвимости до того, как их используют злоумышленники. Эти оценки информируют дорожные карты по улучшению безопасности и подтверждают эффективность контролей. Для критической инфраструктуры регулярный аудит становится частью непрерывной проверки безопасности.

Конвергенция финансовых технологий и операций с инфраструктурой означает, что команды DevOps в криптовалютах должны думать как операторы финансовых систем относительно...безопасность и соответствие. По мере расширения нормативных рамок и увеличения институционального принятия возможности обеспечения безопасности инфраструктуры и соответствия становятся конкурентными отличиями наравне с чисто техническими возможностями.

Будущее Crypto DevOps

Ландшафт криптоинфраструктуры продолжает стремительно эволюционировать, с новыми тенденциями, которые изменяют, как команды управляют системами блокчейна. Понимание этих направлений помогает инфраструктурным командам подготовиться к будущим требованиям и возможностям.

Децентрализованные сети RPC представляют собой значительную эволюцию от нынешних централизованных моделей провайдеров. Проекты, такие как Pocket Network, Ankr и DRPC, стремятся децентрализовать саму инфраструктуру, распределяя узлы RPC по независимым операторам по всему миру. Приложения запрашивают эти сети через слой шлюза, который маршрутизирует запросы к узлам, проверяет ответы и обрабатывает платежи.

Видение заключается в устранении точек отказа и цензуры при сохранении производительности и надежности за счет экономических стимулов. Инфраструктурные команды могут перейти от управления внутренними узлами RPC к участию в качестве операторов узлов в этих сетях, что фундаментально изменяет модели операций.

Мониторинг с поддержкой ИИ и предсказательное обслуживание начинают трансформировать операции. Обученные на исторических данных модели машинного обучения могут обнаруживать аномальные шаблоны, указывающие на развивающиеся проблемы до их возникновения. Предсказательное планирование емкости использует прогнозы трафика для масштабирования инфраструктуры проактивно, а не реактивно. Некоторые экспериментальные системы автоматически диагностируют проблемы и предлагают пути их устранения, что потенциально автоматизирует рутинные реакции на инциденты. По мере того, как эти технологии созревают, они обещают снизить операционное бремя при улучшении надежности.

Kubernetes становится все более центральным в работе блокчейн-инфраструктуры. Хотя узлы блокчейна являются сохраняющими состояние и не естест...

Заключение: Тихий костяк Web3

За каждой торговлей DeFi, чеканкой NFT и голосованием по управлению на цепочке стоит сложный инфраструктурный слой, который видят немногие пользователи, но от которого зависят все. Crypto DevOps представляет собой практический мост между децентрализованным обещанием блокчейна и операционной реальностью. Профессиональные команды, управляющие узлами, конечными точками RPC, индексаторами и системами мониторинга, обеспечивают, что приложения Web3 остаются отзывчивыми, надежными и безопасными круглосуточно.

Этот сектор сильно изменился с первых дней блокчейна, когда энтузиасты запускали узлы на домашних компьютерах, а протоколы допускали частые простои. Сегодняшние операции по криптоинфраструктуре соперничают с традиционными финансовыми технологиями по степени сложности, с мониторингом уровня предприятия, всеобъемлющим восстановлением после сбоев и строгими практиками безопасности. Команды балансируют конкурирующие требования к децентрализации, надежности, экономической эффективности и масштабируемости при управлении гетерогенными системами через многочисленные блокчейны.

Однако остаются значительные вызовы. Централизация инфраструктуры вокруг крупных провайдеров RPC создает неудобные зависимости для предположительно децентрализованных приложений. Многоцепочечные операции усложняют ситуацию без соответствующего улучшения зрелости инструментов. Быстрая эволюция технологий блокчейна означает, что операционные практики часто отстают от возможностей протокола. Угрозы безопасности постоянно развиваются, так как финансовые ставки в криптовалютах привлекают сложных атакующих.

Смотря вперед, crypto DevOps находится на критической отметке. Децентрализованные инфраструктурные сети обещают выровнять инфраструктуру с философскими основами Web3, сохраняя при этом надежность уровня профессионалов. Операции с поддержкой ИИ могут снизить операционное бремя и улучшить время безотказной работы. Нормативные рамки, вероятно, обяжут усиленные возможности безопасности и соответствия. Модульные архитектуры блокчейн вводят новые операционные слои, требующие новых навыков.

Посреди этих изменений сохраняется одна постоянность: криптоинфраструктура требует внимательной работы опытных команд. Невидимая работа специалистов DevOps гарантирует, что блокчейны продолжают работать, приложения остаются отзывчивыми, и пользователи могут доверять инфраструктуре, лежащей в основе их транзакций. По мере того, как криптовалюты становятся все более серьёзной финансовой деятельностью и интегрируются более глубоко в традиционные системы, инфраструктурное совершенство становится не только технической необходимостью, но и стратегическим императивом.

Это поле привлекает практиков, сочетающих традиционные операционные навыки с искренним интересом к децентрализованным системам. Они должны понимать...На русском языке:

не только серверы и сети, но и механизмы консенсуса, криптография, а также экономические стимулы, которые обеспечивают безопасность блокчейнов. Это уникальная дисциплина на стыке системной инженерии, распределенных вычислений и практической реализации децентрализации.

Crypto DevOps останется важным по мере роста Web3. Независимо от того, достигнут ли блокчейны массового принятия или останутся нишевыми, системам требуется профессиональная эксплуатация. Протоколы, управляющие миллиардами в стоимости, обрабатывающие миллионы ежедневных транзакций и поддерживающие тысячи приложений, зависят от инфраструктурных команд, работающих за кулисами.

Этот скрытый слой - ни блестящий, ни часто обсуждаемый - представляет собой тихий костяк, делающий Web3 функциональным. Понимание его работы раскрывает часто недооцененную инженерную и эксплуатационную дисциплину, которая превращает теоретическую децентрализацию блокчейнов в практические системы, которые действительно работают.