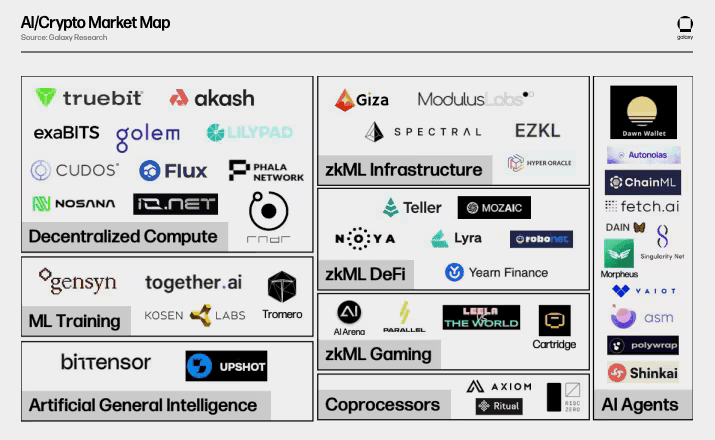

Eine neue Kategorie von Kryptowährungen erregt die Aufmerksamkeit des Marktes: KI-Nutzungstoken, die versprechen, die digitale Wirtschaft mit realer Recheninfrastruktur zu verbinden. Während künstliche Intelligenz Industrien von der Inhaltserstellung bis zur Wirkstoffforschung umgestaltet, vollzieht sich eine parallele Entwicklung in den Kryptomärkten, wo Token nicht mehr nur spekulative Vermögenswerte sind, sondern funktionale Werkzeuge, die dezentrale Netzwerke antreiben.

Drei Projekte stehen an der Spitze dieses Wandels: Bittensor (TAO), Fetch.ai (FET), und Render Token (RNDR).

Bittensor betreibt ein dezentrales maschinelles Lernnetzwerk, bei dem Teilnehmer gemeinsam KI-Modelle trainieren und Belohnungen verdienen. Fetch.ai setzt autonome Wirtschaftsagenten ein, die Aufgaben über Lieferketten, Energiemärkte und dezentrale Finanzen hinweg ausführen. Render Network verwandelt ungenutzte GPU-Leistung in einen Peer-to-Peer-Marktplatz für 3D-Rendering, visuelle Effekte und KI-Inferenz.

Diese Token stehen für mehr als inkrementelle Innovation. Sie signalisieren einen potenziellen architektonischen Wandel in der Krypto von "digitalen Gold"-Narrativen, die sich auf Knappheit und Wertspeicher-Eigenschaften konzentrieren, hin zu nutzergesteuerten Ökosystemen, in denen Token tatsächliche Rechenarbeit erleichtern. Während Bitcoin und Ethereum sich durch monetäre und Plattform-Narrative etablierten, schlagen KI-Nutzungstoken eine andere Wertthese vor: Token als Zugangsschlüssel zu dezentraler Infrastruktur, Zahlungsschienen für Maschinen-zu-Maschinen-Wirtschaften und Belohnungsmechanismen für Computerressourcen.

Hier tauchen wir tief in die Gründe ein, warum diese Token jetzt im Trend liegen, analysieren ihre Nutzenmodelle und Tokenomics, bewerten Wettbewerbseinflüsse und Narrativrisiken, erkunden Bewertungsrahmen und betrachten breitere Implikationen dafür, wie sich Nutzungstoken relativ zu etablierten Wertspeicher-Assets entwickeln könnten.

Warum Nutzungstoken, warum jetzt

Die Konvergenz von KI-Beschleunigung und Blockchain-Infrastruktur hat Bedingungen geschaffen, die reif für die Annahme von Nutzungstoken sind. Mehrere makroökonomische Treiber erklären die aktuelle Dynamik.

Erstens ist die Nachfrage nach KI-Rechenleistung explodiert. Das Training fortschrittlicher Sprachmodelle und die Erstellung synthetischer Medien erfordert massive GPU-Ressourcen, was zu Engpässen in zentralisierten Cloud-Infrastrukturen führt. Traditionelle Anbieter wie AWS und Google Cloud haben Schwierigkeiten, die Nachfrage zu befriedigen, während sich GPU-Engpässe fortsetzen, und Rechenzentren im Durchschnitt nur 12-18% Auslastung zeigen. Dieses Ungleichgewicht zwischen Angebot und Nachfrage hat die Rechenkosten erhöht, was dezentrale Alternativen wirtschaftlich rentabel macht.

Zweitens konzentrierten sich frühere Kryptozyklen hauptsächlich auf DeFi-Protokolle und Wertspeichernarrative. Doch bis 2024-2025 erschienen Infrastruktur und Rechenleistung als dominantes Thema. Die gesamte Marktkapitalisierung von Krypto überschritt 2025 4 Billionen USD, und innerhalb dieses Wachstums zogen KI-Kryptoprojekte bedeutende Aufmerksamkeit von Investoren an. Projekte, die greifbare Infrastruktur anstelle rein finanzieller Produkte anboten, gewannen an Zugkraft, während der Markt reifte.

Drittens bietet die Tokenisierung einzigartige Vorteile für die Koordination verteilter Ressourcen. Dezentrale GPU-Netzwerke wie Render können ungenutzte Rechenleistung global bündeln und ermöglichen Kosteneinsparungen von bis zu 90% im Vergleich zu zentralen Alternativen. Token bieten die wirtschaftliche Koordinierungsschicht: Ersteller zahlen für Renderdienstleistungen in RNDR, Netzbetreiber verdienen Belohnungen für das Bereitstellen von GPU-Kapazitäten und das Protokoll hält Transparenz durch Blockchain-Transaktionen aufrecht.

Das Nutzungsmuster steht in scharfem Kontrast zu Wertspeicher-Token. Der Wertvorschlag von Bitcoin zentriert sich auf begrenzte Angebotsknappheit und seine Positionierung als digitales Gold. Ethereum fügt Programmierbarkeit hinzu, bezieht aber immer noch wesentliche Wertigkeit aus der Rolle als Abwicklungsschicht und Wertaufbewahrungsunterstützung. Nutzungstoken wie TAO, FET und RNDR tragen ihren Wert stattdessen durch Netzwerkbenutzung: mehr KI-Modelle, die auf Bitensor trainiert werden, mehr autonome Agenten, die auf Fetch.ai eingesetzt werden, mehr Bearbeitungsjobs, die im Render Netzwerk bearbeitet werden, was theoretisch zu größerer Nachfrage nach Token führt.

Dieser Trend zu mehr Nutzung ist nicht nur erzählerisch. Das Render Network bearbeitet Rendering-Jobs für große Studios unter Verwendung dezentraler Knoten. Fetch.ai demonstrierte reale Anwendungen, einschließlich autonomer Parkkoordination in Cambridge und Energieshandelssysteme. Die Subnetzarchitektur von Bittensor umfasst 128 aktive Subnetze, die auf unterschiedliche KI-Domänen von Textgenerierung bis Protein-Faltung spezialisiert sind.

Doch die Annahme der Nutzung steht vor Herausforderungen. Die meisten Token werden immer noch hauptsächlich auf spekulativem Wert als auf Nutzungsgrundlagen gehandelt. Token-Velocity - wie schnell Token den Besitzer wechseln - kann die Preisstabilität untergraben, wenn Benutzer Belohnungen sofort in andere Vermögenswerte umwandeln. Die Frage bleibt, ob diese Protokolle genügend Nutzung generieren können, um ihre Bewertungen zu stützen oder ob sie narrativegetriebene Vermögenswerte bleiben, die den Hype-Zyklen unterliegen.

Token 1: Bittensor (TAO) Tiefer Einblick

Was Bittensor ist

Bittensor ist ein quelloffenes Protokoll, das ein dezentrales Netzwerk für maschinelles Lernen betreibt. Im Gegensatz zur traditionellen KI-Entwicklung, die sich auf die Labore von Tech-Giganten konzentriert, schafft Bittensor einen Peer-to-Peer-Marktplatz, auf dem Entwickler maschinelle Lernmodelle einbringen, Validierer deren Qualität beurteilen und Teilnehmer Belohnungen auf Basis des Informationswertes erhalten, den sie zur kollektiven Intelligenz beitragen.

Das Protokoll wurde von Jacob Steeves und Ala Shaabana gegründet, Informatikforscher, die das Netzwerk ins Leben riefen, um die KI-Entwicklung zu demokratisieren. Die Vision ist ehrgeizig: einen Markt für künstliche Intelligenz zu schaffen, in dem Produzenten und Verbraucher in einem vertrauenslosen, transparenten Kontext ohne zentrale Gatekeeper interagieren.

Nutzen und Mechanik

Der TAO-Token erfüllt mehrere Funktionen innerhalb des Ökosystems. Am grundlegendsten gewähren TAO Zugang zur kollektiven Intelligenz des Netzwerks. Benutzer extrahieren Informationen von trainierten Modellen, indem sie mit TAO bezahlen, während Teilnehmer, die Wert zum Netzwerk hinzufügen, einen höheren Einsatz verdienen. Dies schafft ein Anreizsystem, bei dem qualitativ hochwertige Modellbeiträge höhere Belohnungen erhalten.

Das Netzwerk operiert über eine Subnetz-Architektur. Jedes Subnetz ist auf unterschiedliche KI-Aufgaben spezialisiert

- Verarbeitung natürlicher Sprache, Bilderkennung, Datenvorhersage - und verwendet seine eigene Bewertungssystematik. Modelle konkurrieren innerhalb von Subnetzen nach Genauigkeit und Effizienz. Validierer setzen TAO ein, um Modellergebnisse zu bewerten und eine faire Bewertung sicherzustellen. Supporter unterstützen bestimmte Validierer oder Subnetze und teilen sich Belohnungen, ähnlich wie in Delegated Proof-of-Stake Systemen.

Dieses modulare Design ermöglicht Bittensor eine gleichzeitige Skalierung über zahlreiche KI-Domänen. Anstatt ein monolithisches Netzwerk zu sein, fungiert das Protokoll als Infrastruktur für spezialisierte KI-Marktplätze, jeder mit eigenen Bewertungskriterien und Belohnungsverteilungen.

Tokenomics

Die Tokenomics von Bittensor spiegeln das Knappheitsmodell von Bitcoin wider. TAO hat eine begrenzte Versorgung von 21 Millionen Token, wobei die Ausgabe einem Halbierungszeitplan folgt. Die erste Halbierung fand 2025 statt, wobei die tägliche Ausgabe von 7.200 auf 3.600 Token gesenkt wurde. Dieser deflationäre Mechanismus schafft ein Angebotsknappheit ähnlich den vierjährigen Zyklen von Bitcoin.

Derzeit sind ca. 9,6 Millionen TAO-Token im Umlauf, was etwa 46% der Gesamtversorgung entspricht. Die umlaufende Versorgung wird weiter wachsen, jedoch mit einer abnehmenden Rate durch Halbierungen, wobei die vollständige Verteilung über mehrere Jahrzehnte projiziert wird.

Mining-Belohnungen fließen an Teilnehmer, die erfolgreich die Intelligenz des Netzwerks verbessern. Validierer verdienen Belohnungen für die korrekte Bewertung von Modellbeiträgen. Diese doppelte Belohnungsstruktur incentiviert sowohl die Modellentwicklung als auch die Netzwerkintegrität.

Anwendungsfälle

Bittensors Anwendungen erstrecken sich über mehrere Bereiche. Kollektives Lernen ermöglicht es Gesundheitsinstituten, Modelle anhand sensibler medizinischer Daten zu trainieren, ohne die zugrunde liegenden Informationen teilen zu müssen – nachgewiesen durch die Erkennung von COVID-19 aus Röntgenbildern mit 90% Genauigkeit. Finanzinstitute können kollaborativ Betrugserkennungsmodelle trainieren, während proprietäre Daten privat bleiben.

Die Subnetzstruktur ermöglicht spezialisierte KI-Dienste. Textgenerierungssubnetze konkurrieren um qualitativ hochwertige Sprachoutputs. Vorhersagemärkte nutzen die Inferenzfähigkeiten von Bittensor. Embed-Dienste verarbeiten und kodieren Daten für nachgelagerte Anwendungen. Jedes Subnetz arbeitet autonom, während es zum breiteren Intelligenz-Marktplatz beiträgt.

Die Unternehmenseinführung bleibt noch im Anfangsstadium, jedoch zunehmend. Deutsche Digital Assets und Safello lancierten die weltweit erste.. Content: physisch hinterlegtes Bittensor ETP an der SIX Swiss Exchange im November 2025, das institutionellen Anlegern regulierten Zugang zu TAO bietet. Diese Entwicklung signalisiert ein wachsendes Interesse über die Spekulation im Einzelhandel hinaus.

Wettbewerb und Ökosystem

Bittensor konkurriert im dezentralen KI-Bereich mit Projekten wie SingularityNET (AGIX) und Ocean Protocol (OCEAN). SingularityNET betreibt einen KI-Marktplatz, auf dem Entwickler Algorithmen und Dienstleistungen monetarisieren können. Ocean konzentriert sich auf Datenmarktplätze und Compute-to-Data-Anwendungen. Jedes Projekt verfolgt einen anderen Ansatz in der dezentralen KI - Bittensor legt den Schwerpunkt auf kollaboratives Modelltraining, SingularityNET auf Dienstleistungsmarktplätze und Ocean auf Datenvermögen.

Die größte Bedrohung durch Konkurrenz geht jedoch von zentralen KI-Giganten aus. OpenAI, Google DeepMind und Anthropic verfügen über massive Ressourcen, proprietäre Datensätze und modernste Talente. Diese Unternehmen können schneller iterieren und leistungsfähigere Modelle bereitstellen, als dezentrale Alternativen derzeit erreichen. Bittensor muss nachweisen, dass der kollaborative Ansatz Modelle hervorbringt, die mit zentralen Alternativen konkurrenzfähig sind, nicht nur philosophisch ansprechend, sondern technisch überlegen für spezifische Anwendungsfälle.

Das WASM-Smart-Contract-Upgrade des Netzwerks im Jahr 2025 erweiterte die Funktionalität und ermöglichte Funktionen wie Kreditvergabe, automatisierten Handel von Subnetz-Token und abteilungsübergreifende Anwendungen. Diese Infrastrukturentwicklung zielt darauf ab, eine umfassendere digitale Wirtschaft jenseits des reinen Modelltrainings zu schaffen.

Narrativenrisiko und Bewertung

Die Bewertung von Bittensor steht vor mehreren Herausforderungen. Am 12. November 2025 wurde TAO bei etwa $362-390 gehandelt, mit einer Marktkapitalisierung nahe $3,7-4,1 Milliarden. Der Token erreichte Anfang 2025 Höchststände über $400, erlebte jedoch die für Krypto-Assets typische Volatilität.

Befürworter verweisen auf mehrere Wachstumsfaktoren. Der Halbierungsmechanismus übt einen deflationären Druck aus, der potenziell die Preissteigerung unterstützt, wenn die Nachfrage konstant bleibt. Analysten prognostizieren Zielwerte von $360-500 im Jahr 2026 bis hin zu aggressiveren Vorhersagen von über $1.000 für 2027-2030, obwohl diese Prognosen erhebliche Unsicherheit mit sich bringen.

Die grundlegende Frage ist, ob die Nutzung des Netzwerks die Bewertung rechtfertigt. Die Token-Velocity-Theorie legt nahe, dass Utility-Token, die hauptsächlich für Transaktionen verwendet werden, Schwierigkeiten haben, ihren Wert zu halten, da Benutzer Belohnungen schnell in andere Vermögenswerte umwandeln. Bittensor mildert dies durch Staking - Validatoren müssen TAO sperren, um am Konsens des Netzwerks teilzunehmen, wodurch das zirkulierende Angebot und die Geschwindigkeit verringert werden.

Sollte es Bittensor jedoch nicht gelingen, über die derzeitige Subnetzaktivität hinaus sinnvolle KI-Arbeitslasten anzuziehen, wird der Token in erster Linie spekulativ. Das Protokoll muss nachweisen, dass dezentrales Modelltraining Vorteile bietet, die überzeugend genug sind, um Entwickler von etablierten Frameworks wie TensorFlow oder PyTorch in Verbindung mit zentralem Computing abzuwerben.

Risiken umfassen technischen Wettbewerb, regulatorische Unsicherheiten im Zusammenhang mit KI-Systemen, potenzielle Sicherheitsanfälligkeiten im Protokoll und die Herausforderung, die Dezentralisierung beim Wachstum des Netzwerks aufrechtzuerhalten. Der jüngste wöchentliche Rückgang um 20% unterstreicht die anhaltende Volatilität, selbst wenn das institutionelle Interesse wächst.

Token 2: Fetch.ai (FET) im Detail

Fetch.ai ist ein Blockchain-Ökosystem, das KI und Automatisierung nutzt, um autonome wirtschaftliche Agenten zu ermöglichen - digitale Einheiten, die unabhängig Aufgaben im Auftrag von Benutzern, Geräten oder Organisationen ausführen. Gegründet im Jahr 2017 und im März 2019 über eine IEO auf Binance gestartet, zielt Fetch.ai darauf ab, den Zugang zu KI-Technologie durch ein dezentrales Netzwerk zu demokratisieren.

Das entscheidende Merkmal der Plattform sind Autonome Wirtschaftliche Agenten (AEAs). Diese sind Software-Einheiten, die mit einem gewissen Maß an Autonomie arbeiten und Aufgaben wie die Optimierung von Lieferketten, das Management von Energiedistributionen in Smart Grids, die Koordination von Verkehrsnetzen und die Automatisierung von DeFi-Trading ausführen. Agenten entdecken und verhandeln miteinander über ein Offenes Wirtschaftliches Rahmenwerk und schaffen so eine Maschine-zu-Maschine-Wirtschaft.

CEO Humayun Sheikh leitet ein Team, das sich vorstellt, dass KI-basierte Systeme das Datenmonopol großer Technologiefirmen brechen. Durch die Verteilung von KI-Fähigkeiten über ein dezentrales Netzwerk positioniert sich Fetch.ai als Infrastruktur für die "agentische Wirtschaft" - eine Zukunft, in der autonome Agenten Einzelpersonen und Geräte in unzähligen Mikrotransaktionen und Koordinierungsaufgaben repräsentieren.

Nutzen von FET

Der FET-Token dient als primäres Zahlungsmittel im Fetch.ai-Ökosystem. Wenn zwei Agenten miteinander kommunizieren und verhandeln, bezahlt einer den anderen für Daten oder Dienstleistungen mit FET. Wichtig ist, dass der Token Mikrozahlungen von Bruchteilen eines Cents unterstützt, was die granularen Transaktionen ermöglicht, die für eine Maschine-zu-Maschine-Wirtschaft erforderlich sind.

FET hat mehrere spezifische Funktionen. Er bezahlt die Netzwerktrainingsgebühren und die Bereitstellung von KI-Diensten. Entwickler, die autonome Agenten erstellen, zahlen in FET, um auf die maschinellen Lernfunktionen und Rechenressourcen des Netzwerks zuzugreifen. Benutzer können FET staken, um an der Netzwerksicherheit teilzunehmen durch das Proof-of-Stake-Konsensverfahren von Fetch.ai, und Belohnungen für die Beteiligung an Validatorknoten verdienen.

Agenten müssen auch FET hinterlegen, um sich im Netzwerk zu registrieren, und schaffen damit eine Staking-Anforderung, die ihre Betriebsbereitschaft finanziert. Dieser Ablagemechanismus gewährleistet, dass Agenten wirtschaftlich beteiligt sind, Spam reduzieren und qualitativ hochwertige Beiträge incentivieren.

Tokenomics und Struktur

FET existiert in mehreren Formen auf verschiedenen Blockchains. Ursprünglich als ERC-20-Token auf Ethereum gestartet, hat Fetch.ai später sein eigenes Mainnet im Cosmos-Ökosystem bereitgestellt. Benutzer können zwischen der nativen Version und dem ERC-20-Format wechseln, wobei die Wahl die Transaktionsgebühren und die Kompatibilität mit verschiedenen DeFi-Ökosystemen beeinflusst.

Die maximale Versorgung beträgt ungefähr 1 Milliarde FET-Token, obwohl genaue Verteilung und Vesting-Zeiten variieren. Der Token ist sowohl auf Ethereum (für ERC-20-Kompatibilität) als auch auf Binance Smart Chain (als BEP-20-Token) aktiv, wobei eine 1:1-Token-Brücke Benutzern ermöglicht, zwischen Netzwerken basierend auf ihren Bedürfnissen zu wechseln.

Fetch.ai ist Teil der Artificial Superintelligence Alliance, einer Zusammenarbeit mit SingularityNET und Ocean Protocol, die 2024 angekündigt wurde. Die Allianz zielt darauf ab, ein einheitliches dezentrales KI-Ökosystem zu schaffen, wobei die zusammengefasste Marktkapitalisierung ein Ziel unter den Top-20-Kryptowährungen darstellt. Token-Inhaber von AGIX und OCEAN können in FET tauschen, was potenziell Liquidität und Entwicklungsbemühungen über Projekte hinweg konsolidiert.

Anwendungsfälle

Die Anwendungen von Fetch.ai erstrecken sich über mehrere Sektoren. In Smart Cities koordinieren Agenten Parken und Verkehr. Ein Pilotversuch in Cambridge demonstrierte, wie Agenten autonom Parkplätze finden, um Plätze bieten und Zahlungen in Echtzeit abwickeln können. Die Hinzufügung von Ride-Hailing ermöglicht dem Netzwerk, Fahrzeuge basierend auf Nachfrage-Mustern zu verschicken.

Energiemärkte sind ein weiteres großes Anwendungsgebiet. Hausbesitzer mit Solaranlagen auf dem Dach setzen Agenten ein, die überschüssige Energie direkt mit Nachbarn handeln, ohne dass zentrale Dienstleister erforderlich sind. Agenten verhandeln Preise, verifizieren Transaktionen und wickeln Zahlungen in FET ab und schaffen so einen Peer-to-Peer-Energiemarkt.

Im Bereich Logistik und Lieferkette optimieren Agenten die Routenplanung, das Bestandsmanagement und die Auswahl von Frachtführern. Ein Unternehmen kann einen Agenten einsetzen, der Lieferanten durch das Netzwerk entdeckt, Bedingungen aushandelt, Preise vergleicht, Qualitätspunkte überprüft, Bestellungen aufgibt, den Versand arrangiert und Zahlungen abwickelt - alles autonom basierend auf vordefinierten Parametern.

Die DeFi-Automatisierung zeigt Potenzial. Agenten können komplexe Handelsstrategien ausführen, die Bereitstellung von Liquidität über Protokolle optimieren und Sicherheitenpositionen in Kreditmärkten verwalten. Mitte 2025 gewann ein von Fetch.ai unterstützter Agent den UC Berkeley Hackathon für die Koordination des Flugverkehrs, wobei er Fähigkeiten bei der Zuteilung von Flugplätzen, der Verwaltung von Verzögerungen und der Verhandlung von Stauzonen unter autonomen Agenten, die mit Live-Daten arbeiten, demonstrierte.

Die Partnerschaft mit Interactive Strength (TRNR) schuf intelligente Fitness-Coach-Agenten, die Leistungsdaten analysieren, maßgeschneiderte Workouts vorschlagen und Trainingspläne mit Benutzern verhandeln, wobei alle Zahlungen in FET abgewickelt werden.

Wettbewerb und Risiken

Fetch.ai konkurriert mit anderen agentenfokussierten Protokollen wie Autonolas (OLAS), die eine...Content: accelerator program for autonomous agents. Das Virtuals Protocol tauchte Ende 2024 als bedeutender Wettbewerber auf und baute eine KI-Agent-Launchpad auf Base und Solana mit einem eigenen Ökosystem von tokenisierten Agenten auf.

Die größere Wettbewerbsbedrohung geht von zentralisierten KI-Plattformen aus. Google, Amazon und Microsoft bieten fortschrittliche KI-Dienste über ihre Cloud-Plattformen an, ohne dass Benutzer proprietäre Token halten müssen. Damit Fetch.ai erfolgreich ist, muss das dezentrale Agentenmodell klare Vorteile bieten - Datenschutz, Zensurresistenz, direkte Peer-to-Peer-Koordination - die die Komplexität der Verwaltung von Krypto-Assets rechtfertigen.

Regulatorische Unsicherheit birgt Risiken. KI-Systeme, die autonom betrieben werden, könnten unter den aufkommenden Vorschriften überprüft werden. Der risikobasierte Ansatz des EU AI Act könnte die Agenten von Fetch.ai als "hochriskant" einstufen, wenn sie in Sektoren wie Energie oder Logistik tätig sind, was Audits und Aufsicht erfordert, die die Betriebskosten erhöhen.

Skepsis über das Narrativ der Agentenwirtschaft bleibt bestehen. Kritiker bezweifeln, ob autonome Agenten eine breite Akzeptanz erreichen oder eine nischentechnische Kuriosität bleiben werden. Wenn sich die Maschine-zu-Maschine-Wirtschaft nicht im großen Maßstab materialisiert, wird FET zu einer Lösung auf der Suche nach einem Problem.

Am 12. November 2025 wurde FET zwischen 0,25 und 0,30 US-Dollar gehandelt, nachdem es im Laufe des Jahres erhebliche Volatilität erlebte. Der Token gewann Aufmerksamkeit, als Interactive Strength die Pläne für einen Krypto-Schatz von 500 Millionen Dollar ankündigte, der sich auf FET konzentriert, was institutionelles Vertrauen in das langfristige Potenzial des Projekts signalisiert.

Analysten prognostizieren Kursziele von 6,71 US-Dollar bis 2030, obwohl solche Vorhersagen erhebliche Unsicherheiten beinhalten. Die grundlegende Frage ist, ob agentenbasierte Koordination genug Wert bietet, um die Token-Ökonomie zu rechtfertigen, oder ob einfachere, zentralisierte Alternativen gewinnen.

Jüngste Entwicklungen zeigen vielversprechende Ansätze. Fetch.ai startete Anfang 2025 einen Accelerator im Wert von 10 Millionen US-Dollar, um in Start-ups zu investieren, die auf seiner Infrastruktur aufbauen. Dies signalisiert das Engagement für das Wachstum des Ökosystems über den spekulativen Handel hinaus.

Token 3: Render Token (RNDR) Detaillierte Analyse

Was ist Render Network

Render Network ist eine dezentrale GPU-Rendering-Plattform, die Kreative, die Rechenleistung benötigen, mit Einzelpersonen und Organisationen verbindet, die über ungenutzte GPU-Ressourcen verfügen. Ursprünglich 2009 von OTOY-CEO Jules Urbach konzipiert und im April 2020 öffentlich gestartet, hat sich Render zu einem führenden dezentralen physischen Infrastrukturnetzwerk (DePIN) für Grafik- und KI-Workloads entwickelt.

Das Netzwerk operiert als Peer-to-Peer-Marktplatz. Kreative reichen Rendering-Aufträge - 3D-Grafiken, visuelle Effekte, architektonische Visualisierungen, KI-Inferenz - im Netzwerk ein. Knotenbetreiber mit freier GPU-Kapazität nehmen Aufträge entgegen und bearbeiten sie im Austausch für RNDR-Token. Die Plattform nutzt OTOY's führende OctaneRender-Software, um professionelle Renderfähigkeiten durch verteilte Infrastruktur bereitzustellen.

Render Network beseitigt einen grundlegenden Engpass: Hochwertiges Rendering erfordert massive Rechenleistung durch GPUs, doch zentralisierte Cloud-Dienste sind teuer und könnten während Spitzenbelastungen knapp an Kapazität sein. Durch die Aggregation von unterausgelasteten GPUs weltweit, demokratisiert Render den Zugang zu professionellen Rendering-Tools zu einem Bruchteil der traditionellen Kosten.

Utility Token RNDR

Der RNDR-Token (jetzt RENDER nach der Migration zu Solana) dient als native Utility-Token des Netzwerks. Kreative zahlen für Renderdienste in RENDER, wobei die Kosten durch die benötigte GPU-Leistung bestimmt werden, gemessen in OctaneBench (OBH) - eine von OTOY entwickelte standardisierte Einheit zur Quantifizierung der Renderkapazität.

Knotenbetreiber verdienen RENDER für die Erledigung von Aufträgen. Das Netzwerk implementiert ein gestuftes Rufsystem: Tier 1 (Trusted Partners), Tier 2 (Priority) und Tier 3 (Economy). Höherstufige Knotenbetreiber berechnen Premiumtarife, bieten jedoch garantierte Zuverlässigkeit. Die Reputation der Kreativen beeinflusst die Geschwindigkeit der Auftragsvergabe – diejenigen mit starken Verlaufsgeschichten erhalten schneller Zugang zu Ressourcen.

Governance-Rechte begleiten RENDER-Token. Inhaber stimmen über Netzwerk-Upgrades, Protokolländerungen und Finanzierungsvorschläge durch die Render DAO ab. Diese dezentrale Governance stellt sicher, dass die Gemeinschaft die Entwicklung des Netzwerks bestimmt, statt nur einer zentralisierten Stiftung.

Der Burn-and-Mint-Equilibrium-Mechanismus, der im Januar 2023 implementiert wurde, verwaltet das Token-Angebot dynamisch. Wenn Kreative für das Rendering zahlen, werden 95% der Token verbrannt und somit aus dem Umlauf genommen. Knotenbetreiber erhalten neu geschaffene Token, um das wirtschaftliche Gleichgewicht zu halten. Dieses Design macht RENDER potenziell deflationär, da die Netzwerknutzung wächst – die Brennrate kann die Mint-Rate übersteigen, wenn die Nachfrage stark ist.

Tokenomics

RENDER migrierte Ende 2023 von Ethereum zu Solana nach einer Community-Abstimmung. Dieser Wechsel zielte darauf ab, die schnelleren Transaktionen und geringeren Gebühren von Solana zu nutzen. Der ursprüngliche RNDR (ERC-20) Token auf Ethereum wurde auf RENDER (SPL-Token) auf Solana aufgerüstet. Der gesamte Bestand ist auf 644.168.762 Token begrenzt, mit etwa 517 Millionen im Umlauf im Jahr 2025.

Die Token-Verteilung weist 25 % für den öffentlichen Verkauf, 10 % für Reserven und 65 % in Escrow gehalten, um Angebot-Nachfrage-Flüsse zu modulieren. Diese Reserve ermöglicht es der Stiftung, die Token-Verfügbarkeit zu verwalten, während das Netzwerk skaliert.

Anwendungsfälle

Render Network bedient mehrere Industrien. Film- und Fernsehproduktionsunternehmen nutzen das Netzwerk für das Rendering von visuellen Effekten. Große Studios haben Projekte unter Verwendung dezentraler Knoten gerendert, was die Fähigkeit des Systems für professionelle Workflows mit End-to-End-Verschlüsselung für den Schutz von geistigem Eigentum demonstriert.

Spieleentwickler nutzen Render für die Erstellung von 3D-Assets und Echtzeitrendering. Metaversen-Projekte verlassen sich auf das Netzwerk zur Generierung immersiver Umgebungen und Avatar-Grafiken. Die Skalierbarkeit der verteilten GPU-Leistung ermöglicht es Kreativen, Renderkapazitäten nach Bedarf hochzufahren, ohne in teure lokale Hardware zu investieren.

Architekten und Produktdesigner nutzen Render für hochwertige 3D-Visualisierungen. Architekturunternehmen erstellen virtuelle Realitätstouren von Gebäuden vor der Konstruktion. Produktdesigner testen in großem Maßstab, indem sie Texturen und Farben durch paralleles GPU-Rendering prüfen.

AI-Inferenz stellt einen wachsenden Anwendungsfall dar. Im Juli 2025 nahm Render NVIDIA RTX 5090 GPUs speziell für AI-Compute-Workloads in den USA in Betrieb. Das Training bestimmter KI-Modelle, insbesondere solcher, die Bild- oder Videogenerierung umfassen, profitiert von verteiltem GPU-Power. Die Infrastruktur des Netzwerks kann KI-Training erheblich beschleunigen im Vergleich zu Einzelmaschinen-Setups.

Wettbewerbssituation

Render konkurriert sowohl mit zentralisierten als auch dezentralen Anbietern. Traditionelle GPU-Cloud-Dienste von AWS, Google Cloud und spezialisierten Anbietern wie CoreWeave bieten optimierte Oberflächen und zuverlässige SLAs. Allerdings verlangen sie Premiumpreise und könnten während Spitzenbedarfszeiten begrenzte Kapazitäten aufweisen.

Im dezentralen Bereich gehören Akash Network (AKT), io.net (IO) und Aethir zu den Konkurrenten. Jede Plattform geht die GPU-Marktplatz-Koordination unterschiedlich an - Akash konzentriert sich auf umfassendere Cloud-Infrastruktur, io.net legt den Schwerpunkt auf KI/ML-Workloads, Aethir zielt auf Gaming und Unterhaltung ab. Render differenziert sich durch seine Integration mit OTOY's professioneller Render-Software und seinen etablierten Ruf unter kreativen Fachleuten.

Die Frage der Wertschöpfung bleibt bestehen. GPU-Computing wird zunehmend zu einem Massenprodukt, da mehr Anbieter auf den Markt drängen. Render muss zeigen, dass sein dezentrales Modell klare Vorteile bietet - Kosteneffizienz, globale Verfügbarkeit, Zensurresistenz - die die Nutzung von Krypto-Token gegenüber Kreditkarten mit zentralisierten Anbietern rechtfertigen.

Partnerschaften mit großen Unternehmen liefern Validierung. Ari Emanuel (Co-CEO von Endeavor) hat öffentlich Render Network unterstützt, indem Verträge mit Disney, HBO, Facebook und Unity unterzeichnet wurden. Diese Partnerschaften signalisieren eine breite Anerkennung, obwohl die Umwandlung von Beziehungen in konsistente Netzwerknutzung die Herausforderung bleibt.

Am 12. November 2025 wurde RENDER zwischen 4,50-5,00 US-Dollar gehandelt, mit einer Marktkapitalisierung nahe 2,5-3 Milliarden. Der Token erlebte ein signifikantes Wachstum im Jahr 2024, und stieg über...Content: 13.300% von seinem Anfangspreis bis Anfang 2024, obwohl es sich seitdem konsolidiert hat. Analysten schreiben dies AI und GPU/NVIDIA Narrativen zu, wobei die Partnerschaft mit Apple zusätzliche Glaubwürdigkeit verleiht.

Risiken umfassen den Wettbewerb durch zentralisierte Anbieter, die effizienter skalieren, potenzielle Hardware-Zentralisierung, da die Mining-Ökonomie große Betreiber begünstigt, und die Frage, ob dezentrale GPU-Marktplätze nachhaltige Akzeptanz erreichen oder Nischenlösungen bleiben.

Vergleichsanalyse: Utility Tokens vs. Wertaufbewahrungstokens

AI-Utility Tokens operieren unter fundamentally differenten Wertversprechen als Wertaufbewahrungstokens wie Bitcoin und Ethereum. Das Verständnis dieser Unterschiede beleuchtet sowohl Chancen als auch Herausforderungen, denen die Kategorie der Utility Tokens gegenübersteht.

Zweck und Nachfrageantriebe

Der Wert von Bitcoin leitet sich hauptsächlich aus seiner Positionierung als digitales Gold ab - ein knappes, dezentrales Wertaufbewahrungsmittel und Schutz gegen monetäre Inflation. Die Versorgung von Bitcoin ist auf 21 Millionen begrenzt und eine Marktkapitalisierung von über 2 Billionen Dollar positioniert es als Makro-Asset-Klasse. Ethereum fügt Programmierbarkeit hinzu und gewinnt an Wert, indem es als Abwicklungsschicht für DeFi-Protokolle, NFTs und andere Anwendungen fungiert, wobei die Nachfrage nach ETH aus Gasgebühren und Staking-Anforderungen resultiert.

Utility Tokens wie TAO, FET und RENDER leiten ihren Wert stattdessen aus der Netzwerknutzung ab. Die Nachfrage korreliert theoretisch mit den verarbeiteten Rechenaufgaben, den eingesetzten Agenten und den abgeschlossenen Rendering-Aufgaben. Mehr AI-Modelle, die auf Bittensor trainiert werden, sollten die Nachfrage nach TAO für den Zugang zu Intelligenz erhöhen. Mehr autonome Agenten auf Fetch.ai sollten FET-Transaktionen antreiben. Mehr Rendering-Aufgaben sollten mehr RENDER-Tokens verbrennen.

Tokenomics und Governance

Wertaufbewahrungstokens betonen die Knappheit. Die begrenzte Versorgung von Bitcoin und die Halbierungszyklen schaffen eine vorhersehbare Ausgabe-Reduktion. Ethereum wechselte zu Proof-of-Stake mit EIP-1559, das Transaktionsgebühren verbrennt und deflationären Druck bei hoher Netzwerknutzung einführt.

Utility Tokens verwenden verschiedene Ansätze. Bittensor ahmt das Halbierungsmodell von Bitcoin nach, um Knappheit zu schaffen. Renders Burn-and-Mint Equilibrium bindet das Angebot an die Nutzung - hohe Nachfrage verbrennt mehr Tokens, als geprägt werden, was das Angebot reduziert. Fetch.ai hält ein festgelegtes Angebot aufrecht, setzt aber auf Staking-Anreize, um die Umlaufgeschwindigkeit zu reduzieren.

Governance unterscheidet sich erheblich. Bitcoin verfolgt einen konservativen Entwicklungsansatz mit minimalen Protokolländerungen. Ethereum nutzt Off-Chain-Koordination und einen endgültigen groben Konsens. Utility Tokens implementieren oft direkte On-Chain-Governance, wobei Tokeninhaber über Protokoll-Upgrades, Finanzierungsvorschläge und Parameteranpassungen abstimmen, um der Gemeinschaft eine aktivere Betreuung zu ermöglichen.

Adoptionspfade und Benutzerbasis

Wertaufbewahrungstokens zielen auf Investoren ab, die sich Kryptowerte aussetzen oder sich gegen das traditionelle Finanzwesen absichern möchten. Bitcoin spricht diejenigen an, die an Prinzipien des "soliden Geldes" glauben. Ethereum zieht Entwickler und Benutzer an, die sich mit DeFi und Web3-Anwendungen befassen.

Utility Tokens müssen bestimmte Benutzertypen anziehen. Bittensor benötigt AI-Forscher und Datenwissenschaftler, die dezentrales Modelltraining über etablierte Frameworks wählen. Fetch.ai erfordert Entwickler, die autonome Agenten für reale Anwendungen bauen. Render benötigt kreative Profis, die der dezentralen Infrastruktur für Produktions-Workflows vertrauen.

Diese Akzeptanzhürden sind steiler. Entwickler sehen sich mit Umstellungskosten von bestehenden Werkzeugen konfrontiert. Unternehmen erfordern Zuverlässigkeit und Unterstützung, die aufstrebende dezentrale Netzwerke möglicherweise schwer bieten können. Utility Tokens müssen klare Vorteile - Kosten, Leistung, Funktionen - demonstrieren, um die Trägheit zu überwinden.

Wertabschöpfungsmechanismen

Wertaufbewahrungstokens schöpfen ihren Wert durch Knappheit und Netzwerkeffekte. Wenn mehr Teilnehmer Bitcoin als Wertaufbewahrungsmittel erkennen, steigt die Nachfrage, während das Angebot konstant bleibt, was die Preise nach oben treibt. Diese spekulative Schleife verstärkt sich selbst, schafft jedoch auch Volatilität.

Utility Tokens sehen sich dem Geschwindigkeitsproblem gegenüber. Wenn Benutzer verdiente Tokens sofort in Fiat oder andere Krypto umwandeln, verhindert hohe Geschwindigkeit die Wertakkumulation. Die Gleichung des Austauschs (M×V = P×Q) legt nahe, dass für ein gegebenes Transaktionsvolumen (P×Q) höhere Geschwindigkeit (V) eine niedrigere Marktkapitalisierung (M) bedeutet.

Protokolle mindern die Geschwindigkeit durch verschiedene Mechanismen. Staking-Anforderungen sperren Tokens, reduzieren das Umlaufangebot. Bittensor erfordert, dass Validierer TAO staken. Fetch.ai belohnt Staker mit Netzwerksgebühren. Verbrennungsmechanismen wie bei Render entfernen Tokens dauerhaft aus dem Umlauf. Governance-Rechte schaffen Anreize, Tokens für Stimmrechte zu halten.

Marktperformance und Entwicklungsrichtungen

Bitcoin erreichte Allzeithochs über 126.000 Dollar im Jahr 2025 und setzte seine Entwicklung als Makro-Asset fort. Ethereum erholte sich von den Kursrückgängen nach 2022 und behielt seine Position als primäre Smart-Contract-Plattform bei.

AI-Utility Tokens zeigten volatilere Leistungen. TAO handelte zwischen 200-750 Dollar von 2024-2025, wobei die Marktkapitalisierung bei Spitzenwerten 3,7-4,1 Milliarden Dollar erreichte. FET erlebte signifikante Bewegungen, insbesondere rund um die Artificial Superintelligence Alliance-Ankündigung. RENDER sah explosives Wachstum in 2023-2024, bevor es konsolidierte.

Diese Tokens handeln sowohl spekulativ als auch fundamental. Wenn AI-Erzählungen die Kryptodiskurse dominieren, übertreffen Utility Tokens. In Abschwungphasen schneiden sie häufig schlechter ab als Bitcoin und Ethereum, da Investoren zu vermeintlich sichereren Anlagen fliehen.

Koexistenz oder Konkurrenz?

Die Frage ist, ob Utility Tokens die "nächste Welle" darstellen oder als komplementäre Kategorie koexistieren. Beweise deuten darauf hin, dass die Koexistenz wahrscheinlicher ist. Wertaufbewahrungstoken erfüllen unterschiedliche Zwecke als betriebliche Tokens. Bitcoin fungiert als digitales Gold, Ethereum als programmierbare Abwicklungsschicht, während Utility Tokens als Treibstoff für spezifische Anwendungen dienen.

Erfolg ist jedoch nicht garantiert. Die meisten Utility Tokens können scheitern, wenn die Nutzung nicht materialisiert oder zentralisierte Alternativen überlegen sind. Die AI-Krypto-Marktkapitalisierung erreichte 24-27 Milliarden Dollar im Jahr 2025, beträchtlich, aber klein im Vergleich zu Bitcoin allein, das über 2 Billionen Dollar hinausgeht.

Erfolgreiche Beispiele werden wahrscheinlich demonstrieren:

- Nachhaltige Netzwerknutzung, die unabhängig von Spekulation wächst

- Klare Vorteile gegenüber zentralisierten Alternativen

- Starke Entwicklerökosysteme und Unternehmensakzeptanz

- Effektive Geschwindigkeitsminderung durch Staking oder Verbrennen

- Governance-Modelle, die Dezentralisierung mit Effizienz ausbalancieren

Der ultimative Test ist, ob Utility Tokens zur Infrastruktur für AI-Workloads im großen Umfang werden, oder ob sie Nischenlösungen bleiben, die von zentralisierten Cloud-Anbietern überschattet werden.

Bewertung, Akzeptanzmetriken & Narrativrisiko

Die Bewertung von Utility Tokens erfordert andere Rahmenwerke als die Bewertung von Wertaufbewahrungsgütern. Während Bitcoin durch Stock-to-Flow-Modelle oder als digitales Gold vergleichbar mit Edelmetallen bewertet werden kann, erfordern Utility Tokens nutzungsbasierte Metriken.

Schlüsselmessgrößen für Utility Tokens

Netzwerknutzungsstatistiken bilden die Grundlage. Für Bittensor sind aussagekräftige Metriken:

- Anzahl der aktiven Subnetze und deren Spezialisierungen

- Rechenstunden, die dem Modelltraining gewidmet sind

- Anzahl der Miner und Validatoren, die das Netzwerk sichern

- Transaktionsvolumen, das durch das Protokoll fließt

- Erfolgreiche Modelleinsätze, die realen Anwendungen dienen

Bittensor meldet 128 aktive Subnetze bis Ende 2025, ein bedeutender Anstieg gegenüber früheren

Für Fetch.ai relevante Metriken beinhalten:

- Anzahl der eingesetzten autonomen Agenten

- Agent-zu-Agent-Interaktionen und Transaktionsvolumen

- Reale Integrationen über Branchen hinweg

- Partnerschaften mit Unternehmen oder Regierungen

- Staking-Teilnahme und Anzahl der Validatoren

Fetch.ai demonstrierte Proof-of-Concepts in den Bereichen Parkkoordination, Energiehandel und Logistik, aber die Skalierung von Pilotprojekten auf breite Akzeptanz bleibt die Herausforderung.

Für das Render-Netzwerk sind entscheidende Indikatoren:

- Monatlich verarbeitete Renderaufträge

- Anzahl der aktiven Knotenbetreiber, die GPU-Kapazität bereitstellen

- Unternehmenskunden, die das Netzwerk für Produktions-Workflows nutzen

- Verbrennungsrate im Vergleich zur Prägequote unter Burn-and-Mint Equilibrium

- Genutzte GPU-Stunden im dezentralen Netzwerk

Render hat wichtige Studio-Partnerschaften gesichert und verarbeitet echte Rendering-Workloads, was konkretere Nutzungshinweise gibt als viele Utility Tokens.

Token-Geschwindigkeit und Verbrennungsmetriken

Token-Geschwindigkeit misst, wie schnell Tokens durch die Wirtschaft zirkulieren. Hohe Geschwindigkeit deutet darauf hin, dass Benutzer Tokens sofort ausgeben oder umwandeln, wodurch Wertakkumulation verhindert wird. Niedrige Geschwindigkeit deutet darauf hin, dass Tokens länger gehalten werden, möglicherweise als Wertaufbewahrungsmittel oder für Staking-Belohnungen.

Bitcoin zeigt eine Geschwindigkeit von 4,1 %, Ethereum 3,6 %, was auf reifere Vermögenswerte hinweist, die überwiegend anstatt zu Translation of Content:

Skip translation for markdown links.

Content: abgewickelt. Nutzen-Token zeigen typischerweise anfänglich höhere Geschwindigkeiten, da Benutzer Token für Arbeit erhalten und sie sofort in stabile Währungen umwandeln.

Brennmechanismen bekämpfen hohe Geschwindigkeit. Das System von Render verbrennt 95 % der Zahlungstoken bei jeder Transaktion, was das Angebot reduziert. Wenn die Verbrennungsrate die Prägegeschwindigkeit übersteigt, nimmt das umlaufende Angebot ab, was potenziell die Preissteigerung unterstützt, wenn die Nachfrage konstant bleibt.

Die Bewertung von Verbrennungen erfordert Transparenz. Projekte sollten regelmäßige Berichte über die Verbrennungen veröffentlichen, die die aus dem Umlauf genommenen Token zeigen. Render stellt diese Daten zur Verfügung und ermöglicht so die unabhängige Überprüfung der deflationären Behauptungen.

Partnerschaften und Integrationen aus der realen Welt

Unternehmensakzeptanz signalisiert echten Nutzen. Der erste ETP-Start von Bittensor an der SIX Swiss Exchange bietet institutionellen Zugang. Die 500 Millionen USD FET-Treasury von Interactive Strength zeigt Unternehmensvertrauen. Die Partnerschaften von Render mit Disney, HBO und Unity validieren die Fähigkeiten der Plattform für Produktions-Workflows.

Allerdings garantieren Partnerschaften allein nicht die dauerhafte Nutzung. Viele Blockchain-Projekte kündigen Partnerschaften an, die sich nicht in signifikante Umsätze oder Netzwerkaktivitäten umsetzen. Die Nachverfolgung des tatsächlichen Transaktionsvolumens, das aus Unternehmensbeziehungen resultiert, bietet klarere Einblicke.

Narrative Risiken

Mehrere narrative Risiken bedrohen die Bewertungen von Nutzen-Token:

AI + Crypto-Hype ohne Lieferung: Die Konvergenz von KI und Blockchain schafft mächtige Erzählungen, aber wenn dezentralisierte KI-Systeme nicht die Leistung zentralisierter Alternativen erreichen, sinken die Bewertungen. Die meisten Experten erwarten, dass nur ausgewählte AI-Krypto-Projekte langfristig erfolgreich sein werden, wobei viele spekulativ bleiben.

Rechenleistung ohne Nachfrage: Der Aufbau einer dezentralen GPU-Infrastruktur ist bedeutungslos, wenn Entwickler sie nicht nutzen. Wenn die Nutzung nicht über frühe Anwender und Evangelisten hinaus skaliert, werden Token zu Lösungen, die nach Problemen suchen. Die Frage ist, ob dezentralisierte Rechenleistung einen bedeutenden Marktanteil von AWS, Google Cloud und anderen zentralisierten Giganten erobern kann.

Regulatorische Bedrohungen: Regierungen weltweit entwickeln KI-Vorschriften. Der risikobasierte Rahmen des EU AI Act könnte bestimmte KI-Systeme als hohes Risiko einstufen und Audits und Aufsicht erfordern. Autonome Agenten, die wirtschaftliche Entscheidungen treffen, könnten unter die Lupe genommen werden. Die Unsicherheit darüber, ob Nutzen-Token Wertpapiere darstellen, erhöht das regulatorische Risiko.

Hardware-Zentralisierung: Dezentrale Netzwerke riskieren eine Rezentralisierung. Wenn der Betrieb von Mining oder Knoten nur für große Akteure mit Skaleneffekten wirtschaftlich tragfähig wird, verblasst das Versprechen der Dezentralisierung. GPU-Netzwerke könnten sich um große Rechenzentren konsolidieren, was den Zweck der Peer-to-Peer-Infrastruktur untergräbt.

Technische Einschränkungen: Dezentrale Systeme stehen vor inhärenten Kompromissen. Koordinationsaufwand, Latenz und Zuverlässigkeitsbedenken können verhindern, dass Nutzen-Token mit optimierten zentralen Alternativen konkurrieren. Wenn sich technische Einschränkungen als unüberwindbar erweisen, stagniert die Akzeptanz.

Bewertungsrahmen

Traditionelle Finanzmodelle kämpfen mit Nutzen-Token. Discounted Cash Flow (DCF) funktioniert für Token mit Gewinnbeteiligung - Augur zahlt Augur-Nutzern für Netzwerkarbeit, wodurch Cashflows entstehen, die sich für DCF-Analysen eignen. Aber reine Nutzen-Token ohne Dividenden haben keine offensichtlichen Cashflows, um abzuzinsen.

Die Gleichung des Austauschs bietet einen Ansatz: M × V = P × Q, wobei M die Marktkapitalisierung ist (was wir lösen), V die Geschwindigkeit, P der Preis pro Transaktion und Q die Menge der Transaktionen. Umgestellt: M = P × Q / V. Dies impliziert, dass die Marktkapitalisierung dem Transaktionsvolumen geteilt durch die Geschwindigkeit entspricht.

Höheres Transaktionsvolumen (P × Q) unterstützt höhere Bewertungen. Niedrigere Geschwindigkeit (V) unterstützt ebenfalls höhere Bewertungen. Projekte müssen entweder die Nutzung erhöhen oder die Geschwindigkeit senken – idealerweise beides. Staking verringert die Geschwindigkeit; Verbrennungsmechanismen reduzieren das Angebot; echter Nutzen erhöht das Transaktionsvolumen.

Metcalfe's Law schlägt vor, dass der Netzwerkwert proportional zum Quadrat der Benutzer wächst. Während mehr Teilnehmer Bittensor, Fetch.ai oder Render beitreten, könnten Netzwerkeffekte exponentielles Wachstum des Wertes antreiben. Allerdings nimmt dieses Gesetz an, dass alle Verbindungen wertvoll sind - was für Netzwerke im Frühstadium nicht immer zutrifft.

Vergleichende Bewertung betrachtet ähnliche Projekte. Wenn Bittensor eine ähnliche Netzwerknutzung wie SingularityNET oder Ocean Protocol erreicht, bietet der Vergleich der Marktkapitalisierungen grobe Benchmarks. Allerdings begrenzen die einzigartigen Tokenomics und Anwendungsfälle jedes Projekts die Nützlichkeit eines direkten Vergleichs.

Letztendlich bleibt die Bewertung von Nutzen-Token spekulativ. Bis Netzwerke eine nachhaltige Nutzung unabhängig von Spekulationen nachweisen, spiegeln Preise die narrative Kraft und die Marktstimmung ebenso wie den fundamentalen Wert wider.

Was kommt als Nächstes: Szenarien für die Zukunft

Die Entwicklung von AI-Nutzentoken hängt von mehreren unsicheren Variablen ab: den Raten der Technologieakzeptanz, regulatorischen Entwicklungen, dem Wettbewerb durch zentralisierte Anbieter und der Fähigkeit der Token, Wert aus der Netzwerknutzung zu gewinnen. Drei breite Szenarien beleuchten mögliche Zukünfte.

Bestes Szenario: Infrastruktur-Token werden zur Kernschicht

In diesem optimistischen Szenario erreicht die dezentrale KI-Infrastruktur die breite Akzeptanz. Bittensor wird zur bevorzugten Plattform für das kollaborative Training von KI-Modellen und zieht große Forschungseinrichtungen und Unternehmen an. Die Subnetzarchitektur erweist sich für bestimmte Anwendungsfälle als überlegen gegenüber zentralen Rahmen - privatsphäre-schützende Gesundheits-KI, dezentrale Modellmarktplätze, crowdsourced Intelligence.

Die autonomen Agenten von Fetch.ai verbreiten sich in verschiedenen Branchen. Intelligente Städte setzen Agentennetzwerke für die Verkehrskoordination, Energieverteilung und öffentliche Dienstleistungen ein. Lieferketten standardisieren die agentenbasierte Optimierung. DeFi-Protokolle integrieren Agenten für die automatische Strategieausführung. Die "agentische Wirtschaft" materialisiert sich wie vorhergesagt, mit Milliarden von Mikrodeals, die von autonomer Software koordiniert werden.

Das Render-Netzwerk gewinnt signifikante Marktanteile von zentralisierten GPU-Anbietern. Kreative Fachleute und KI-Forscher nutzen routinemäßig dezentralisierte Rechenleistung für Produktions-Workflows. Der globale Cloud-Gaming-Markt, der bis 2032 auf 121 Milliarden Dollar geschätzt wird, treibt die Nachfrage nach verteilten GPU-Infrastrukturen an.

In diesem Szenario gewinnen Nutzen-Token an bleibendem Wert durch:

- Nachhaltiges Wachstum der Nutzung: Die Netzwerkaktivität steigt unabhängig von Spekulationen

- Mitigierung der Geschwindigkeit: Staking, Verbrennung und Governance-Anreize halten Token, anstatt sie sofort zu verkaufen

- Netzwerkeffekte: Je mehr Benutzer beitreten, desto wertvoller werden die Plattformen für alle Teilnehmer

- Regulatorische Klarheit: Rahmenbedingungen entstehen, die dezentralisierte KI unter Schutz der Verbraucher zulassen

In diesem Szenario könnten die Token-Preise optimistische Analystenprojektionen erreichen - TAO über 1.000 USD, FET nähert sich 6-10 USD, RENDER übersteigt 20 USD - wenn die Nutzung der Fundamentaldaten die Bewertungen rechtfertigt. Marktkapitalisierungen würden proportional wachsen, wobei führende AI-Nutzentoken potenziell Marktbewertungen von 20-50 Milliarden Dollar erreichen, während sie Teile der Billionen-Dollar-Märkte für KI und Cloud-Computing einnehmen.

Für Investoren bedeutet dies eine erhebliche Wertsteigerung gegenüber dem derzeitigen Niveau. Für Entwickler validiert es dezentralisierte Infrastrukturen als tragfähige Alternative zu zentralisierten Cloud-Anbietern. Für Kryptomärkte beweist es, dass sich Nutzen-Token von spekulativen Objekten zu funktionalen Infrastrukturwerten entwickeln können.

Basisfall: Ausgewählte Token erfolgreich, viele stagnieren

Ein realistischeres Szenario erkennt an, dass nur ein Teil der aktuellen AI-Nutzentoken nachhaltige Akzeptanz erreichen wird. Gewinner unterscheiden sich durch überlegene Technologie, starke Ökosysteme, echte Partnerschaften und effektive Wertschöpfungsmechanismen. Die meisten Projekte stagnieren oder verschwinden, da Benutzer den begrenzten praktischen Nutzen erkennen.

In diesem Szenario haben Bittensor, Fetch.ai und Render - als führende Projekte - bessere Chancen als kleinere Konkurrenten. Doch auch sie stehen vor Herausforderungen. Dezentralisierte KI erweist sich als wertvoll für spezifische Nischen - datenschutzkritische Anwendungen, zensurresistente Netzwerke, bestimmte Forschungskategorien - jedoch nicht als Ersatz für zentrale Anbieter in den meisten Anwendungsfällen.

Wertspeicher-Token bleiben dominant. Bitcoin festigt seine Position als digitales Gold. Ethereum dient weiterhin als primäre Abwicklungsschicht für dezentrale Anwendungen. AI-Nutzentoken koexistieren als Infrastruktur für spezialisierte Anwendungen anstatt als allgemeine Plattformen.

Token-Preise spiegeln moderates Nutzungspotenzial wider. TAO könnte 500-800 USD, FET 2-4 USD, RENDER 8-12 USD in den kommenden Jahren erreichen - eine bedeutende Wertsteigerung, aber weit von explosiven Prognosen entfernt. Marktkapitalisierungen wachsen, bleiben aber Größenordnungen unterhalb von Bitcoin und Ethereum.

Mehrere Faktoren kennzeichnen dieses Basisszenario:

- Nischenakzeptanz: Nutzen-Token dienen effektiv spezifischen vertikalen Märkten oder Anwendungsfällen

- Konzentration Konkurrenz: AWS, Google Cloud und andere Riesen dominieren weiterhin den allgemeinen Rechenmarkt

- Regulatorischer Aufwand: Compliance-Anforderungen erhöhen die Reibung für dezentrale Plattformen

- Technische Kompromisse: Dezentralisierte Systeme erweisen sich in vielen Anwendungen als langsamer, komplexer oder weniger zuverlässig als zentralealternativen

Für Investoren belohnt moderate Wertsteigerung frühe Unterstützer, aber sie bleibt hinter den optimistischsten Projektionen zurück. Für Kryptomärkte etablieren sich Nutzen-Token als eigene Vermögenskategorie, die sich von Wertaufbewahrungstoken unterscheidet, aber mit mehr moderaten Enthusiasmus.### Nachteil: Nutzung materialisiert sich nicht

Im pessimistischen Szenario können Dienstprogramm-Token technische Fähigkeiten nicht in eine nachhaltige Nachfrage umsetzen. Trotz beeindruckender Infrastruktur migrieren Benutzer nicht von etablierten Plattformen. Entwickler nutzen weiter TensorFlow, PyTorch und zentralisierte Cloud-Computing-Dienste, anstatt neue dezentrale Protokolle zu erlernen. Kreativprofis bleiben bei Adobe, Autodesk und traditionellen Renderfarmen, anstatt mit krypto-basierten Alternativen zu experimentieren.

In diesem Szenario werden KI-Dienstprogramm-Token hauptsächlich zu spekulativen Vermögenswerten. Die Preise schwanken mehr aufgrund der breiteren Krypto-Marktstimmung und KI-Hypes als aufgrund der fundamentalen Nutzung. Wenn die Erzählungen verblassen – wie es bei vielen ICO-Token von 2017-2018 der Fall war – brechen die Bewertungen ein.

Mehrere Dynamiken könnten dieses Ergebnis hervorbringen:

- Benutzererfahrungs-Reibungen: Das Verwalten von Wallets, das Bezahlen von Gasgebühren und das Navigieren durch dezentrale Protokolle erweist sich für Mainstream-Benutzer als zu umständlich.

- Leistungslücken: Zentralisierte Alternativen bleiben schneller, zuverlässiger und funktionsreicher als dezentrale Optionen.

- Wirtschaftliche Tragfähigkeit: Die Token-Ökonomie versagt dabei, Anreize richtig auszurichten, was zu Anbieterwechseln, Qualitätsproblemen oder Netzwerkinstabilitäten führt.

- Regulatorische Einbrüche: Regierungen klassifizieren Dienstprogramm-Token als Wertpapiere oder verbieten bestimmte Anwendungen, was die legale Nutzung einschränkt.

Die Token-Preise würden auf spekulative Tiefstände zurückgehen. TAO könnte unter 200 USD fallen, FET unter 0,50 USD, RENDER unter 3 USD, da Investoren den Mangel an fundamentaler Nachfrage erkennen. Projekte könnten mit engagierten Gemeinschaften überleben, aber es nicht schaffen, eine bedeutende Größenordnung zu erreichen.

Dieses Szenario stellt ein existenzielles Risiko für die Kategorie der Dienstprogramm-Token dar. Wenn führende Projekte mit umfangreicher Finanzierung, talentierten Teams und echten Partnerschaften keine Produkt-Markt-Fit nachweisen können, deutet dies darauf hin, dass das Modell der dezentralisierten KI/Computing-Infrastruktur grundsätzlich nicht im großen Maßstab funktioniert.

Auswirkungen über Szenarien hinweg

Für Investoren: Risiko-Ertrags-Profile variieren drastisch über die Szenarien hinweg. Das beste Szenario bietet Mehrfach-Renditen, erfordert jedoch, dass sich mehrere Unsicherheiten günstig auflösen. Die Basislinie bietet eine bescheidene Wertsteigerung bei geringerem Risiko. Der Nachteil bedeutet signifikante Verluste.

Die Portfolio-Konstruktion sollte Szenarien-Wahrscheinlichkeiten berücksichtigen. Die Zuweisung kleiner Prozentsätze zu Dienstprogramm-Token bietet asymmetrisches Aufwärtspotenzial, wenn sich das beste Szenario verwirklicht, während es die Abwärtsrisiken begrenzt. Die Konzentration auf Dienstprogramm-Token anstelle von Wertaufbewahrungs-Assets erhöht Volatilität und Risiko.

Für Entwickler: Der Aufbau auf Dienstprogramm-Token-Plattformen erfordert eine Bewertung der langfristigen Tragfähigkeit. Wenn sich das Basis- oder Nachteilenis Szenario realisiert, könnten Anwendungen auf diesen Plattformen Schwierigkeiten haben, Benutzer oder Finanzierung zu finden. Entwickler sollten sich Optionen offen halten – Anwendungen designen, die über Plattformen hinweg portabel sind oder in der Lage sind, mit zentralisierten Backends zu arbeiten, wenn die dezentrale Infrastruktur unzureichend ist.

Für die Krypto-Marktstruktur: Der Erfolg oder Misserfolg von Dienstprogramm-Token prägt die Entwicklung des Kryptos. Wenn das beste Szenario eintritt, expandiert Krypto über Wertaufbewahrung und DeFi hinaus in echte Infrastruktur. Wenn der Nachteil eintritt, bleibt Krypto vor allem eine spekulative und finanzielle Domäne.

Was zu beobachten ist

Mehrere Indikatoren werden klären, welches Szenario eintritt:

Knotenanzahl und Beteiligung: Wachsende Zahlen von Minern, Validierern und GPU-Anbietern signalisieren echte Netzwerkeffekte. Stagnierende oder rückläufige Teilnahme deutet auf die mangelnde wirtschaftliche Tragfähigkeit hin.

Verarbeitete Rechenaufträge: Tatsächliche Rendering-Aufträge, KI-Training-Durchläufe und Agenteninteraktionen – nicht nur Testnetzaktivitäten – zeigen echte Nachfrage. Projekte sollten transparente Nutzungsstatistiken veröffentlichen.

Unternehmenspartnerschaften: Die Umwandlung angekündigter Partnerschaften in messbares Transaktionsvolumen validiert Geschäftsmodelle. Partnerschaften ohne dazugehörige Nutzung deuten auf potenzielles Vaporware hin.

Token-Burns und Staking: Bei Projekten mit Burn-Mechanismen zeigt eine Burn-Rate, die die Mint-Rate übersteigt, starke Nachfrage. Hohe Staking-Teilnahme reduziert die Geschwindigkeit und zeigt langfristiges Vertrauen der Inhaber an.

Entwickler-Aktivitäten: Wachsende Entwicklerökosysteme – gemessen an Github-Commits, neuen Protokollen, die auf Plattformen aufgebaut sind, Hackathon-Teilnahmen – signalisieren gesunde Grundlagen. Nachlassendes Entwicklerinteresse deutet auf Stagnation hin.

Regulatorische Klarheit: Klarere Rahmenbedingungen für Dienstprogramm-Token, KI-Systeme und dezentrale Infrastrukturen reduzieren Unsicherheit. Förderliche Vorschriften beschleunigen die Adoption; einschränkende behindern sie.

Hardware-Ökosysteme: Die Integration mit großen GPU-Herstellern oder Cloud-Anbietern legitimiert dezentrales Computing. Nvidia, AMD und andere Partnerschaften mit oder Anerkennungen von Dienstprogramm-Token-Plattformen würden eine Mainstream-Validierung signalisieren.

Die Beobachtung dieser Metriken von 2025-2027 wird klären, ob KI-Dienstprogramm-Token genuine Infrastrukturinnovationen repräsentieren oder hauptsächlich spekulative Vehikel sind. Die Unterscheidung wird bestimmen, ob diese Vermögenswerte dauerhafte Bedeutung in den Krypto-Märkten erreichen oder als weiterer Erzählzyklus verblassen.

Abschließende Gedanken

KI-Dienstprogramm-Token stellen eine bedeutende Evolution in der architektonischen Erzählung von Krypto dar. Bittensor, Fetch.ai und Render Network zeigen, dass Token über Wertaufbewahrung oder spekulativen Handel hinaus dienen können – sie können dezentrale Infrastrukturen koordinieren, rechnerische Arbeit anreizen und maschinen-zum-Maschinen-Wirtschaften ermöglichen.

Die grundlegende These ist überzeugend. Dezentrale GPU-Netzwerke aggregieren ungenutzte Ressourcen, senken die Kosten und demokratisieren den Zugang. Autonome Agenten ermöglichen eine Koordination in Größenordnungen, die für menschliche Vermittlung unpraktisch sind. Kollaborative KI-Entwicklung verteilt die Intelligenzerschaffung jenseits der Monopole der Technologieriesen. Diese Visionen adressieren reale Probleme in der Skalierbarkeit der Infrastruktur, Zugänglichkeit der KI und wirtschaftlicher Koordination.

Doch die Vision in eine nachhaltige Adoption umzusetzen, bleibt die kritische Herausforderung. Dienstprogramm-Token müssen klare Vorteile gegenüber zentralisierten Alternativen demonstrieren und gleichzeitig die in dezentrale Systeme innewohnenden Reibungen überwinden. Sie müssen über Nutzung und nicht über Spekulationen Wert erfassen, das Geschwindigkeitsproblem durch effektive Tokenomics lösen und Produkt-Markt-Fit mit Unternehmen und Entwicklern erreichen.

Der Wechsel von Wertaufbewahrungs- zu Dienstprogramm-Token ist entscheidend für die nächste Phase von Krypto. Wenn erfolgreich, beweisen Dienstprogramm-Token, dass Krypto funktionale Infrastrukturen ermöglicht und nicht nur finanzielle Vermögenswerte. Dies erweitert den insgesamt adressierbaren Markt erheblich – von Investoren, die eine Exposition gegenüber digitalem Gold oder DeFi-Renditen suchen, bis hin zu Entwicklern, die Rechenressourcen benötigen, und Unternehmen, die ihre Abläufe optimieren.

Die Beweislage bleibt gemischt. Reale Nutzung existiert – Render verarbeitet Produktions-Rending-Aufträge, Fetch.ai hat Pilotprojekte in verschiedenen Branchen umgesetzt, Bittensor betreibt aktive KI-Subnetze. Doch die Nutzung bleibt gering im Verhältnis zu den Bewertungen. Market Caps in Milliarden preisen substantielles zukünftiges Wachstum ein, das sich möglicherweise nicht materialisiert.

Die kommenden Jahre werden bestimmen, welches Szenario eintritt. Wird die dezentrale KI-Infrastruktur bedeutende Teile milliardenschwerer Märkte erfassen? Werden autonome Agentenwirtschaften über Nischenanwendungen hinaus proliferieren? Oder werden die Vorteile zentralisierter Alternativen in Bezug auf Leistung, Zuverlässigkeit und Benutzererfahrung sich als unüberwindbar erweisen?

Für Investoren und Entwickler trennt die Verfolgung der Nutzung und des Infrastrukturwachstums echte Gewinner von Erzählprojekten. Betreiberzahlen von Knoten, verarbeitete Rechenaufträge, Token-Burn-Raten, Unternehmenspartnerschaften und Entwicklerökosysteme liefern Signale inmitten von Spekulationen.

Die wichtigste Erkenntnis ist, dass Dienstprogramm-Token grundlegend andere Herausforderungen als Wertaufbewahrungs-Assets stehen. Bitcoin hatte Erfolg, indem es knapp und sicher war – die Adoption bedeutete, Menschen davon zu überzeugen, es zu halten. Dienstprogramm-Token müssen genutzt werden – die Adoption bedeutet, Entwickler davon zu überzeugen, darauf aufzubauen, und Unternehmen, sie in Produktionsabläufe zu integrieren. Dies ist eine höhere Hürde, aber auch potenziell beeindruckender, wenn es erreicht wird.

Während sich die Kryptomärkte über reine Spekulation hinaus zu funktionaler Infrastruktur weiterentwickeln, werden KI-Dienstprogramm-Token entweder diese Evolution validieren oder als warnende Geschichten über das Überversprechen und Unterliefern dienen. Die Technologie existiert, die Vision ist artikuliert, und das Kapital ist verfügbar. Was bleibt, ist ungewiss, ob die Nachfrage im großen Maßstab sich materialisiert – oder ob Krypto einmal mehr Infrastruktur geschaffen hat, die auf Benutzer wartet, die möglicherweise nie kommen.