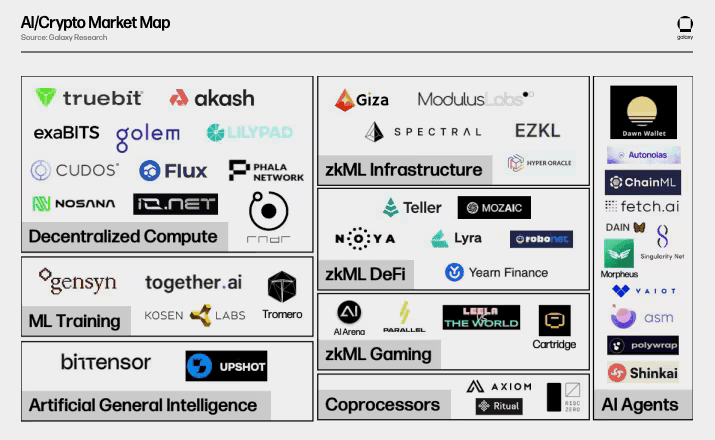

Una nuova categoria di criptovalute sta attirando l'attenzione del mercato: token di utilità AI che promettono di colmare il divario tra l'economia digitale e le infrastrutture computazionali nel mondo reale. Mentre l'intelligenza artificiale rimodella le industrie, dalla creazione di contenuti alla scoperta di farmaci, un'evoluzione parallela è in corso nei mercati crypto, dove i token non sono più meramente asset speculativi ma strumenti funzionali che alimentano reti decentralizzate.

Tre progetti sono in prima linea in questo cambiamento: Bittensor (TAO), Fetch.ai (FET) e Render Token (RNDR).

Bittensor opera una rete di machine learning decentralizzata dove i collaboratori addestrano modelli di intelligenza artificiale e guadagnano ricompense. Fetch.ai distribuisce agenti economici autonomi che eseguono compiti attraverso catene di approvvigionamento, mercati energetici e finanza decentralizzata. Render Network trasforma il potere GPU inutilizzato in un marketplace peer-to-peer per rendering 3D, effetti visivi e inferenza AI.

Questi token rappresentano più di un'innovazione incrementale. Segnalano un potenziale cambiamento architetturale nel crypto, passando dalle narrazioni di "oro digitale" incentrate sulla scarsità e sulle proprietà di riserva di valore verso ecosistemi guidati dall'utilità dove i token facilitano il lavoro computazionale reale. Mentre Bitcoin ed Ethereum si sono affermati attraverso narrazioni monetarie e di piattaforma, i token di utilità AI propongono una tesi di valore differente: token come chiavi di accesso a infrastrutture decentralizzate, reti di pagamento per economie machine-to-machine e meccanismi di ricompensa per risorse computazionali.

In questo articolo analizziamo in profondità perché questi token sono di tendenza ora, esaminiamo i loro modelli di utilità e tokenomics, valutiamo le dinamiche competitive e i rischi narrativi, esploriamo gli schemi di valutazione e consideriamo le implicazioni più ampie su come i token di utilità potrebbero evolversi rispetto agli asset di riserva di valore consolidati.

Perché i Token di Utilità, Perché Ora

La convergenza tra accelerazione dell'AI e infrastruttura blockchain ha creato condizioni mature per l'adozione di token di utilità. Diversi fattori macro spiegano l'attuale slancio.

Prima di tutto, la domanda di calcolo AI è esplosa. Addestrare modelli di linguaggi avanzati e generare media sintetici richiede risorse GPU massive, creando colli di bottiglia nell'infrastruttura cloud centralizzata. I fornitori tradizionali come AWS e Google Cloud hanno lottato per soddisfare la domanda, con centri dati che in media raggiungono solo il 12-18% di utilizzo mentre le carenze di GPU persistono. Questo squilibrio tra domanda e offerta ha spinto i costi di calcolo più in alto, rendendo le alternative decentralizzate economicamente vantaggiose.

In secondo luogo, i cicli crypto precedenti si sono concentrati principalmente sui protocolli DeFi e narrazioni di riserva di valore. Ma tra il 2024-2025, infrastruttura e calcolo sono emersi come un tema dominante. Il capitale totale di mercato crypto ha superato i 4 trilioni di dollari nel 2025, e all'interno di tale crescita, i progetti AI-crypto hanno catturato un'attenzione significativa degli investitori. I progetti che offrono infrastrutture tangibili piuttosto che prodotti puramente finanziari hanno guadagnato terreno man mano che il mercato maturava.

In terzo luogo, la tokenizzazione offre vantaggi unici per coordinare risorse distribuite. Le reti GPU decentralizzate come Render possono aggregare la capacità di calcolo inutilizzata globalmente, permettendo risparmi sui costi fino al 90% rispetto alle alternative centralizzate. I token forniscono il livello di coordinamento economico: i creatori pagano per i servizi di rendering in RNDR, gli operatori di nodi guadagnano ricompense per contribuire con capacità GPU, e il protocollo mantiene la trasparenza attraverso le transazioni blockchain.

Il modello di utilità contrasta nettamente con i token di riserva di valore. Il valore di Bitcoin si basa sulla scarsità dell'offerta fissa e la sua posizione di oro digitale. Ethereum aggiunge programmabilità ma ancora deriva valore significativo dal fungere da livello di regolamento e riserva di asset. I token di utilità come TAO, FET e RNDR invece derivano valore dall'uso della rete: più modelli AI addestrati su Bittensor, più agenti autonomi distribuiti su Fetch.ai, più lavori di rendering processati su Render Network si traducono teoricamente in una maggiore domanda di token.

Questo cambiamento verso l'utilità non è meramente narrativo. Render Network processa lavori di rendering per studi importanti usando nodi decentralizzati. Fetch.ai ha dimostrato applicazioni reali, tra cui coordinamento autonomo dei parcheggi a Cambridge e sistemi di trading energetico. L'architettura a subnet di Bittensor include ora 128 subnet attive focalizzate su diversi domini AI, dalla generazione di testo al folding proteico.

Tuttavia, l'adozione di utilità affronta sfide. La maggior parte dei token ancora si scambia principalmente sul valore speculativo piuttosto che su fondamentali di utilizzo. La velocità del token – la rapidità con cui i token cambiano di mano – può minare la stabilità dei prezzi se gli utenti convertono immediatamente le ricompense in altri asset. La domanda diventa se questi protocolli possono generare un utilizzo sufficiente a supportare le loro valutazioni o se rimangono asset guidati dalla narrativa soggetti a cicli di hype.

Token 1: Bittensor (TAO) Approfondimento

Cosa è Bittensor

Bittensor è un protocollo open-source che alimenta una rete di machine learning decentralizzata. A differenza dello sviluppo tradizionale di AI concentrato nei laboratori dei giganti tecnologici, Bittensor crea un mercato peer-to-peer dove gli sviluppatori contribuiscono con modelli di machine learning, i validatori ne valutano la qualità e i collaboratori guadagnano ricompense basate sul valore informativo che forniscono all'intelligenza collettiva.

Il protocollo è stato fondato da Jacob Steeves e Ala Shaabana, ricercatori in scienze informatiche che hanno lanciato la rete per democratizzare lo sviluppo di AI. La visione è ambiziosa: creare un mercato per l'intelligenza artificiale dove produttori e consumatori interagiscono in un contesto senza fiducia e trasparente senza guardiani centralizzati.

Utilità e Meccaniche

Il token TAO svolge funzioni multiple all'interno dell'ecosistema. Fondamentalmente, TAO concede accesso all'intelligenza collettiva della rete. Gli utenti estraggono informazioni dai modelli addestrati pagando in TAO, mentre i collaboratori che aggiungono valore alla rete guadagnano più partecipazioni. Questo crea una struttura di incentivi dove i contributi di modelli di alta qualità ricevono maggiori ricompense.

La rete opera attraverso un'architettura a subnet. Ogni subnet si specializza in diversi compiti AI - elaborazione del linguaggio naturale, riconoscimento di immagini, predizione dei dati - e utilizza la sua logica di valutazione. I modelli competono all'interno delle subnet in base ad accuratezza ed efficienza. I validatori mettono in staking TAO per valutare gli output dei modelli e garantire una valutazione equa. I nominatori sostengono validatori o subnet specifici e condividono le ricompense, simile ai sistemi delegati di proof-of-stake.

Questo design modulare permette a Bittensor di scalare contemporaneamente in numerosi domini dell'AI. Piuttosto che una rete monolitica, il protocollo funge da infrastruttura per mercati AI specializzati, ciascuno con criteri di valutazione personalizzati e distribuzioni di ricompense.

Tokenomics

La tokenomics di Bittensor rispecchia il modello di scarsità di Bitcoin. TAO ha una fornitura fissa di 21 milioni di token, con emissioni seguenti un programma di dimezzamenti. Il primo dimezzamento è avvenuto nel 2025, riducendo l'emissione giornaliera da 7.200 a 3.600 token. Questo meccanismo deflazionistico crea una scarsità di offerta simile ai cicli quadriennali di Bitcoin.

Attualmente, circa 9,6 milioni di token TAO sono in circolazione, rappresentando approssimativamente il 46% della fornitura totale. La fornitura circolante continuerà a crescere ma a un ritmo decrescente a causa dei dimezzamenti, con una piena distribuzione proiettata nel corso di diversi decenni.

Le ricompense di mining vanno a chi contribuisce con successo migliorando l'intelligenza della rete. I validatori guadagnano ricompense per una valutazione accurata dei contributi dei modelli. Questa struttura di doppia ricompensa incentiva sia lo sviluppo dei modelli che l'integrità della rete.

Casi d'Uso

Le applicazioni di Bittensor spaziano in diversi domini. L'apprendimento collettivo permette alle istituzioni sanitarie di addestrare modelli su dati medici sensibili senza condividere informazioni sottostanti—dimostrato nel rilevamento di COVID-19 da radiografie toraciche con il 90% di accuratezza. Le istituzioni finanziarie possono addestrare collaborativamente modelli di rilevamento delle frodi mantenendo privati i dati proprietari.

La struttura a subnet abilita servizi AI specializzati. Le subnet di generazione di testo competono per produrre output linguistici di alta qualità. I mercati predittivi sfruttano le capacità inferenziali di Bittensor. I servizi di embedding elaborano e codificano dati per applicazioni a valle. Ogni subnet opera autonomamente pur contribuendo al mercato di intelligenza più ampio.

L'adozione aziendale rimane nascente ma in crescita. Deutsche Digital Assets e Safello hanno lanciato il primo mercato al mondo basato su... Contenuto: "ETP Bittensor sostenuto fisicamente sul SIX Swiss Exchange a novembre 2025, fornendo agli investitori istituzionali un'esposizione regolamentata a TAO. Questo sviluppo segnala un crescente interesse oltre la speculazione al dettaglio."

Competizione ed Ecosistema

Bittensor compete nell'arena dell'IA decentralizzata con progetti come SingularityNET (AGIX) e Ocean Protocol (OCEAN). SingularityNET gestisce un mercato dell'IA dove gli sviluppatori monetizzano algoritmi e servizi. Ocean si concentra sui mercati dei dati e sulle applicazioni compute-to-data. Ogni progetto affronta l'IA decentralizzata in modo diverso - Bittensor enfatizza l'addestramento modello collaborativo, SingularityNET si concentra sui mercati dei servizi, Ocean dà priorità agli asset di dati.

Tuttavia, la maggiore minaccia competitiva proviene dai giganti dell'IA centralizzati. OpenAI, Google DeepMind e Anthropic dispongono di risorse massicce, set di dati proprietari e talenti all'avanguardia. Queste entità possono iterare più velocemente e distribuire modelli più capaci di quanto attualmente ottenuto dalle alternative decentralizzate. Bittensor deve dimostrare che il suo approccio collaborativo produce modelli competitivi con le alternative centralizzate, non solo filosoficamente attraenti, ma anche tecnicamente superiori per determinati casi d'uso.

L'aggiornamento dei contratti intelligenti WebAssembly (WASM) della rete nel 2025 ha ampliato la funzionalità, abilitando funzioni come il prestito, il trading automatizzato di token di sottorete e le applicazioni cross-subnet. Questo sviluppo infrastrutturale mira a creare un'economia digitale più completa oltre il semplice addestramento di modelli.

Rischio Narrativo e Valutazione

La valutazione di Bittensor affronta diverse tensioni. Il 12 novembre 2025, TAO è stato scambiato intorno ai $362-390, con una capitalizzazione di mercato vicina ai $3.7-4.1 miliardi. Il token ha raggiunto picchi superiori ai $400 all'inizio del 2025, ma ha subito la volatilità tipica degli asset crittografici.

I rialzisti indicano diversi fattori di crescita. Il meccanismo di dimezzamento crea pressione deflazionistica, sostenendo potenzialmente l'apprezzamento dei prezzi se la domanda rimane costante. Gli analisti proiettano target che vanno dai $360-500 nel 2026 a previsioni più aggressive che superano i $1.000 entro il 2027-2030, sebbene queste previsioni comportano un'incertezza significativa.

La domanda fondamentale è se l'uso della rete giustifica la valutazione. La teoria della velocità del token suggerisce che i token di utilità utilizzati principalmente per le transazioni lottano per mantenere il valore perché gli utenti convertono rapidamente le ricompense in altri asset. Bittensor attenua questo attraverso lo staking - i validatori devono bloccare TAO per partecipare al consenso della rete, riducendo la fornitura in circolazione e la velocità.

Tuttavia, se Bittensor non riesce ad attrarre carichi di lavoro significativi di IA oltre la sua attuale attività di sottorete, il token diventa principalmente speculativo. Il protocollo deve dimostrare che l'addestramento modello decentralizzato offre vantaggi sufficientemente attraenti da giustificare la migrazione degli sviluppatori dai framework stabiliti come TensorFlow o PyTorch combinati con il calcolo centralizzato.

I rischi includono la competizione tecnologica, l'incertezza normativa attorno ai sistemi di IA, le potenziali vulnerabilità di sicurezza nel protocollo e la sfida di mantenere la decentralizzazione mentre la rete si espande. Il recent 20% weekly dip evidenzia la volatilità persistente nonostante l'interesse istituzionale più ampio cresca.

Token 2: Analisi Approfondita di Fetch.ai (FET)

Cos'è Fetch.ai

Fetch.ai è un ecosistema blockchain che sfrutta l'IA e l'automazione per abilitare agenti economici autonomi - entità digitali che eseguono compiti indipendentemente per conto di utenti, dispositivi o organizzazioni. Fondato nel 2017 e lanciato tramite IEO su Binance a marzo 2019, Fetch.ai intende democratizzare l'accesso alla tecnologia IA attraverso una rete decentralizzata.

La caratteristica distintiva della piattaforma sono gli Agenti Economici Autonomi (AEA). Questi sono entità software che operano con un certo grado di autonomia, svolgendo compiti come ottimizzazione delle catene di approvvigionamento, gestione della distribuzione di energia con reti intelligenti, coordinazione delle reti di trasporto e automazione delle operazioni DeFi. Gli agenti scoprono e negoziano tra loro attraverso un Open Economic Framework, creando un'economia macchina-a-macchina.

Il CEO Humayun Sheikh guida un team che immagina sistemi basati sull'IA che rompano il monopolio dei dati detenuto dalle grandi aziende tecnologiche. Distribuendo le capacità di IA attraverso una rete decentralizzata, Fetch.ai si posiziona come infrastruttura per l'"economia agentica" - un futuro dove agenti autonomi rappresentano individui e dispositivi in innumerevoli micro-transazioni e compiti di coordinazione.

Utilità di FET

Il token FET serve come principale mezzo di scambio nell'ecosistema Fetch.ai. Quando due agenti si connettono, comunicano e negoziano, uno paga l'altro per dati o servizi utilizzando FET. Importante, il token supporta micro-pagamenti di frazioni di centesimo, abilitando le transazioni granulari necessarie per un'economia macchina-a-macchina.

FET ha diverse funzioni specifiche. Esso paga le commissioni di transazione della rete e il dispiegamento di servizi IA. Gli sviluppatori che costruiscono agenti autonomi pagano in FET per accedere alle utility di machine learning della rete e alle risorse computazionali. Gli utenti possono stake FET per partecipare alla sicurezza della rete attraverso il meccanismo di consenso Proof-of-Stake di Fetch.ai, guadagnando ricompense per il contributo ai nodi validatori.

Gli agenti devono anche depositare FET per registrarsi sulla rete, creando un requisito di staking che finanzia il loro diritto di operare. Questo meccanismo di deposito garantisce che gli agenti abbiano un interesse economico in gioco, riducendo lo spam e incentivando contributi di qualità.

Tokenomics e Struttura

FET esiste in più forme su diverse blockchain. Originariamente lanciato come token ERC-20 su Ethereum, Fetch.ai ha successivamente distribuito la sua propria mainnet costruita nell'ecosistema Cosmos. Gli utenti possono fare bridge tra la versione nativa e il formato ERC-20, con la scelta che influenza le commissioni di transazione e la compatibilità con diversi ecosistemi DeFi.

La fornitura massima è di circa 1 miliardo di token FET, sebbene la distribuzione esatta e i piani di ripresa variano. Il token opera sia su Ethereum (per la compatibilità ERC-20) che su Binance Smart Chain (come token BEP-20), con un bridge token 1:1 che consente agli utenti di scambiare tra reti in base alle loro esigenze.

Fetch.ai fa parte della Artificial Superintelligence Alliance, una collaborazione con SingularityNET e Ocean Protocol annunciata nel 2024. L'alleanza mira a creare un ecosistema unificato di IA decentralizzata con una capitalizzazione di mercato combinata che punta a uno stato di top-20 critto. I detentori di token AGIX e OCEAN possono scambiare in FET, potenzialmente consolidando liquidità e sforzi di sviluppo tra i progetti.

Casi d'Uso

Le applicazioni di Fetch.ai si estendono su più settori. Nelle smart city, gli agenti coordinano il parcheggio e il traffico. Un pilota a Cambridge ha dimostrato che gli agenti trovano autonomamente spazi di parcheggio, fanno offerte per gli spazi e processano i pagamenti in tempo reale. Aggiungere il ride-hailing consente alla rete di inviare veicoli in base ai modelli di domanda.

I mercati energetici rappresentano un altro importante caso d'uso. I proprietari di case con impianti solari sul tetto dispongono di agenti che scambiano energia in eccesso direttamente con i vicini, bypassando le utility centralizzate. Gli agenti negoziano i prezzi, verificano le transazioni e liquidano pagamenti in FET, creando un mercato energetico peer-to-peer.

In logistica e supply chain, gli agenti ottimizzano il routing, la gestione dell'inventario e la selezione dei vettori. Un'azienda può distribuire un agente che scopre i fornitori attraverso la rete, negozia i termini, confronta i prezzi, controlla i punteggi di qualità, effettua ordini, organizza spedizioni e gestisce i pagamenti - tutto autonomamente in base a parametri predefiniti.

L'automazione DeFi mostra promesse. Gli agenti possono eseguire strategie di trading complesse, ottimizzare la fornitura di liquidità attraverso i protocolli e gestire posizioni collaterali nei mercati di prestito. A metà 2025, un agente supportato da Fetch.ai ha vinto l'hackathon di UC Berkeley per il coordinamento del traffico aereo, dimostrando capacità nell'assegnare slot di volo, gestire ritardi e negoziare zone di congestione tra agenti autonomi che lavorano con dati in tempo reale.

La partnership con Interactive Strength (TRNR) ha creato agenti di allenamento fitness intelligenti che analizzano i dati delle performance, suggeriscono allenamenti personalizzati e negoziano piani di allenamento con gli utenti, tutti regolati attraverso pagamenti FET.

Paesaggio Competitivo e Rischio

Fetch.ai compete con altri protocolli centrati sugli agenti come Autonolas (OLAS), che offre una...a tenfold increase over the course of the year. Analysts project further growth based on expanding demand for decentralized rendering workloads. However, uncertainty around blockchain regulation and potential competition suppresses more bullish forecasts.

Continued innovation and ecosystem development will be key. Render plans to integrate with more GPU hardware manufacturers and expand its presence in emerging markets like India and Brazil. The platform's roadmap includes further enhancements to scalability and ease of use, aiming to onboard a wider range of creators across industries.

As the ecosystem matures, Render Network's value proposition must remain clear—offering cost-effective access to high-quality GPU rendering capabilities while maintaining the benefits of decentralization. The tension between staying true to its decentralized roots and scaling to meet growing demand will shape the network's trajectory in the coming years.

Translation to Italian with Markdown links preserved:

Contenuto: accelerator program for autonomous agents. Il Virtuals Protocol è emerso alla fine del 2024 come un grande concorrente, costruendo una piattaforma di lancio di agenti AI su Base e Solana con il proprio ecosistema di agenti tokenizzati.

La minaccia competitiva più ampia proviene dalle piattaforme AI centralizzate. Google, Amazon e Microsoft offrono servizi AI sofisticati attraverso le loro piattaforme cloud senza richiedere agli utenti di detenere token proprietari. Per Fetch.ai avere successo, il modello di agente decentralizzato deve offrire vantaggi chiari - preservazione della privacy, resistenza alla censura, coordinamento diretto peer-to-peer - che giustifichino la complessità di gestire asset crypto.

L'incertezza normativa comporta rischi. I sistemi AI che operano autonomamente potrebbero essere soggetti a controlli in base alle regolamentazioni emergenti. L'approccio basato sul rischio dell'EU AI Act potrebbe classificare gli agenti di Fetch.ai come "ad alto rischio" quando operano in settori come l'energia o la logistica, richiedendo audit e supervisione che aumentano i costi operativi.

Permane scetticismo riguardo alla narrativa dell'economia degli agenti. I critici si chiedono se gli agenti autonomi raggiungeranno un'adozione mainstream o rimarranno una curiosità tecnica di nicchia. Se l'economia macchina-macchina non si materializzerà su larga scala, FET diventerà una soluzione in cerca di un problema.

Il 12 novembre 2025, FET ha scambiato tra $0.25 e $0.30, avendo sperimentato una significativa volatilità per tutto l'anno. Il token ha ottenuto attenzione quando Interactive Strength ha annunciato piani per un tesoro crypto da $500 milioni centrato su FET, segnalando fiducia istituzionale nel potenziale a lungo termine del progetto.

Gli analisti prevedono obiettivi di prezzo di $6.71 entro il 2030, sebbene tali previsioni portino con sé un'incertezza sostanziale. La domanda fondamentale è se il coordinamento basato su agenti offre abbastanza valore da giustificare l'economia dei token, o se prevarranno alternative centralizzate più semplici.

Sviluppi recenti mostrano promesse. Fetch.ai ha lanciato un acceleratore da $10 milioni all'inizio del 2025 per investire in startup che costruiscono sulla sua infrastruttura. Questo segnala l'impegno per la crescita dell'ecosistema oltre il trading speculativo.

Token 3: Approfondimento su Render Token (RNDR)

Cos'è Render Network

Render Network è una piattaforma di rendering GPU decentralizzata che connette creatori in cerca di potenza computazionale con individui e organizzazioni che offrono risorse GPU inattive. Conceputa originariamente nel 2009 dal CEO di OTOY Jules Urbach e lanciata pubblicamente nell'aprile 2020, Render è evoluta in una rete di infrastrutture fisiche decentralizzate leader (DePIN) per carichi di lavoro grafici e AI.

La rete opera come un mercato peer-to-peer. I creatori inviano lavori di rendering - grafica 3D, effetti visivi, visualizzazioni architettoniche, inferenza AI - alla rete. Gli operatori di nodi con capacità GPU inutilizzata acquisiscono lavori e li processano in cambio di token RNDR. La piattaforma sfrutta il software OctaneRender leader di settore di OTOY, fornendo capacità di rendering a livello professionale tramite infrastrutture distribuite.

Render Network affronta un collo di bottiglia fondamentale: il rendering di alta qualità richiede enormi potenze GPU, ma i servizi cloud centralizzati sono costosi e possono mancare di capacità durante le richieste di picco. Aggregando GPU sottoutilizzate globalmente, Render democratizza l'accesso agli strumenti di rendering professionali a una frazione dei costi tradizionali.

Token di Utilità RNDR

Il token RNDR (ora RENDER dopo la migrazione a Solana) funge da token di utilità nativo della rete. I creatori pagano per i servizi di rendering in RENDER, con i costi determinati dalla potenza GPU richiesta, misurata in OctaneBench (OBH) - un'unità standardizzata sviluppata da OTOY per quantificare la capacità di rendering.

Gli operatori di nodo guadagnano RENDER completando i lavori. La rete implementa un sistema di reputazione a livelli: Livello 1 (Partner Fidati), Livello 2 (Prioritario) e Livello 3 (Economico). Gli operatori di nodo di livello superiore addebitano tariffe premium ma offrono affidabilità garantita. I punteggi di reputazione dei creator influenzano la velocità di assegnazione dei lavori: quelli con storie forti accedono più rapidamente alle risorse.

Diritti di governance accompagnano i token RENDER. I possessori votano sugli aggiornamenti della rete, i cambiamenti del protocollo e le proposte di finanziamento tramite la Render DAO. Questa governance decentralizzata assicura che la comunità plasmi l'evoluzione della rete piuttosto che una fondazione centralizzata da sola.

Il meccanismo Burn-and-Mint Equilibrium implementato nel gennaio 2023 gestisce l'offerta di token in modo dinamico. Quando i creatori pagano per il rendering, il 95% dei token viene bruciato, rimuovendoli dalla circolazione. Gli operatori di nodo ricevono token di nuova emissione per mantenere l'equilibrio economico. Questo design rende RENDER potenzialmente deflazionistico man mano che l'uso della rete cresce, poiché il tasso di bruciatura può superare il tasso di emissione se la domanda è forte.

Tokenomics

RENDER è migrato da Ethereum a Solana alla fine del 2023 a seguito di un voto della comunità. Questa transizione mirava a sfruttare le transazioni più rapide e le commissioni più basse di Solana. L'RNDR originale (token ERC-20) su Ethereum è stato aggiornato a RENDER (token SPL) su Solana. L'offerta totale è limitata a 644.168.762 token, con circa 517 milioni in circolazione a partire dal 2025.

La distribuzione dei token ha allocato il 25% alle vendite pubbliche, il 10% alle riserve e il 65% tenuto in escrow per modulare i flussi di offerta e domanda. Questa riserva consente alla fondazione di gestire la disponibilità dei token man mano che la rete cresce.

Casi d'Uso

Render Network serve molteplici settori. Le aziende di produzione cinematografica e televisiva utilizzano la rete per il rendering degli effetti visivi. Grandi studi hanno renderizzato progetti utilizzando nodi decentralizzati, dimostrando la capacità del sistema per flussi di lavoro professionali con crittografia end-to-end che garantisce la protezione della proprietà intellettuale.

Gli sviluppatori di videogiochi sfruttano Render per la creazione di asset 3D e il rendering in tempo reale. I progetti nel metaverso si affidano alla rete per generare ambienti immersivi e grafiche degli avatar. La scalabilità della potenza GPU distribuita consente ai creatori di aumentare la capacità di rendering secondo necessità senza investire in hardware locale costoso.

Architetti e designer di prodotti utilizzano Render per visualizzazioni 3D di alta qualità. Studi di architettura creano walkthrough di realtà virtuale degli edifici prima della costruzione. I designer di prodotti prototipano su larga scala, testando trame e colori tramite rendering GPU parallelizzato.

L'inferenza AI rappresenta un caso d'uso in crescita. Nel luglio 2025, Render ha integrato gli NVIDIA RTX 5090 GPU specificamente per carichi di lavoro computazionali AI negli Stati Uniti. Allenare certi modelli AI, soprattutto quelli che coinvolgono la generazione di immagini o video, beneficia della potenza GPU distribuita. L'infrastruttura della rete può accelerare significativamente l'addestramento AI rispetto alle configurazioni su singola macchina.

Dinamiche Competitiva

Render compete sia con fornitori centralizzati che decentralizzati. I servizi cloud GPU tradizionali da AWS, Google Cloud e fornitori specializzati come CoreWeave offrono interfacce semplificate e SLA affidabili. Tuttavia, richiedono prezzi premium e possono avere capacità limitata durante i periodi di domanda di picco.

Nello spazio decentralizzato, i concorrenti includono Akash Network (AKT), io.net (IO) e Aethir. Ogni piattaforma approccia in modo diverso il coordinamento del mercato GPU - Akash si concentra su infrastrutture cloud più ampie, io.net enfatizza carichi di lavoro AI/ML e Aethir mira a giochi ed intrattenimento. Render si differenzia grazie all'integrazione con il software di rendering professionale di OTOY e alla sua reputazione consolidata tra i professionisti creativi.

La domanda sulla cattura del valore persiste. Il calcolo GPU sta diventando sempre più commoditizzato man mano che più fornitori entrano nel mercato. Render deve dimostrare che il suo modello decentralizzato offre vantaggi chiari - efficienza dei costi, disponibilità globale, resistenza alla censura - che giustifichino l'uso di token crypto invece delle carte di credito con fornitori centralizzati.

La partnership con grandi aziende fornisce validazione. Ari Emanuel (Co-CEO di Endeavor) ha pubblicamente sostenuto Render Network, firmando accordi con Disney, HBO, Facebook e Unity. Queste partnership segnalano il riconoscimento mainstream, sebbene convertire le relazioni in uso della rete costante resti la sfida.

Il 12 novembre 2025, RENDER ha scambiato tra $4.50-5.00, con una capitalizzazione di mercato vicina ai 2.5-3 miliardi. Il token ha sperimentato una crescita significativa nel 2024, salendo di dieci volte nel corso dell'anno. Gli analisti prevedono ulteriori crescite basate sulla domanda crescente per i carichi di lavoro di rendering decentralizzato. Tuttavia, l'incertezza riguardante le regolamentazioni blockchain e la potenziale concorrenza sopprimono previsioni più rialziste.

L'innovazione continuata e lo sviluppo dell'ecosistema saranno cruciali. Render ha in programma di integrare con più produttori di hardware GPU ed espandere la sua presenza nei mercati emergenti come l'India e il Brasile. La roadmap della piattaforma include ulteriori miglioramenti alla scalabilità e alla facilità d'uso, con l'obiettivo di attrarre un ventaglio più ampio di creatori attraverso settori diversi.

Mentre l'ecosistema matura, la proposta di valore di Render Network deve rimanere chiara: offrire accesso conveniente a capacità di rendering GPU di alta qualità mantenendo i benefici della decentralizzazione. La tensione tra restare fedeli alle sue radici decentralizzate e scalare per rispondere alla crescente domanda plasmerà la traiettoria della rete negli anni a venire.Contenuto: 13.300% dal suo prezzo iniziale entro l'inizio del 2024, sebbene si sia poi consolidato. Gli analisti attribuiscono questo ai narrativi su AI e GPU/NVIDIA, con la partnership con Apple che fornisce ulteriore credibilità.

I rischi includono la concorrenza da parte di fornitori centralizzati che scalano più efficientemente, la potenziale centralizzazione dell'hardware dato che l'economia del mining favorisce operatori di grandi dimensioni, e la questione se i marketplace di GPU decentralizzati otterranno un'adozione sostenibile o rimarranno soluzioni di nicchia.

Analisi Comparativa: Token di Utilità vs Token di Riserva di Valore

I token di utilità AI operano con proposte di valore fondamentalmente diverse rispetto ai token di riserva di valore come Bitcoin ed Ethereum. Comprendere queste distinzioni illumina sia le opportunità sia le sfide che affronta la categoria dei token di utilità.

Scopo e Driver della Domanda

Il valore di Bitcoin deriva principalmente dalla sua posizione come oro digitale - una riserva di valore scarsa e decentralizzata e una copertura contro l'inflazione monetaria. Il limite di fornitura di 21 milioni di Bitcoin e la capitalizzazione di mercato che supera i $2 trilioni lo posizionano come una classe di attività macro. Ethereum aggiunge programmabilità, traendo valore dal servire come strato di regolamento per i protocolli DeFi, gli NFT e altre applicazioni, con la domanda di ETH proveniente dalle commissioni sul gas e dai requisiti di staking.

I token di utilità come TAO, FET e RENDER derivano invece valore dall'uso del network. La domanda teoricamente correla con i lavori computazionali processati, gli agenti impiegati e le attività di rendering completate. Più modelli AI addestrati su Bittensor dovrebbero aumentare la domanda di TAO per l'accesso all'intelligenza. Più agenti autonomi su Fetch.ai dovrebbero guidare le transazioni FET. Maggiori lavori di rendering dovrebbero bruciare più token RENDER.

Tokenomics e Governanza

I token di riserva di valore enfatizzano la scarsità. La fornitura fissa e i cicli di dimezzamento di Bitcoin creano una riduzione prevedibile dell'emissione. Ethereum è passato a Proof-of-Stake con EIP-1559 bruciando le commissioni di transazione, introducendo pressione deflazionistica quando l'uso del network è elevato.

I token di utilità impiegano approcci variati. Bittensor imita il modello di dimezzamento di Bitcoin, creando scarsità. Il Burn-and-Mint Equilibrium di Render lega la fornitura all'uso - una domanda elevata brucia più token di quanti ne vengano emessi, riducendo la fornitura. Fetch.ai mantiene una fornitura fissa ma si affida agli incentivi di staking per ridurre la velocità.

La governanza differisce significativamente. Bitcoin mantiene un approccio di sviluppo conservativo con cambiamenti minimi al protocollo. Ethereum utilizza il coordinamento off-chain e il consenso approssimativo eventuale. I token di utilità spesso implementano una governanza on-chain diretta in cui i titolari di token votano su aggiornamenti di protocollo, proposte di finanziamento e aggiustamenti dei parametri, dando alle comunità una gestione più attiva.

Percorsi di Adozione e Base Utente

I token di riserva di valore prendono di mira gli investitori in cerca di esposizione agli asset crypto o che intendono coprire posizioni nella finanza tradizionale. Bitcoin attrae coloro che credono nei principi della moneta solida. Ethereum attira sviluppatori e utenti che interagiscono con applicazioni DeFi e Web3.

I token di utilità devono attirare specifici tipi di utenti. Bittensor ha bisogno di ricercatori AI e data scientist che scelgano la formazione di modelli decentralizzata rispetto ai framework stabiliti. Fetch.ai richiede sviluppatori che costruiscano agenti autonomi per applicazioni reali. Render ha bisogno di professionisti creativi che si fidino dell'infrastruttura decentralizzata per i flussi di lavoro di produzione.

Questi ostacoli all'adozione sono più ripidi. Gli sviluppatori affrontano costi di cambio rispetto agli strumenti esistenti. Le imprese richiedono affidabilità e supporto che le reti decentralizzate nascenti potrebbero non riuscire a fornire. I token di utilità devono dimostrare chiari vantaggi - costi, prestazioni, caratteristiche - per superare l'inerzia.

Meccanismi di Cattura del Valore

I token di riserva di valore catturano valore attraverso scarsità ed effetti di rete. Man mano che più partecipanti riconoscono Bitcoin come una riserva di valore, la domanda aumenta mentre la fornitura rimane fissa, spingendo i prezzi verso l'alto. Questo ciclo speculativo si rinforza di per sé, sebbene crei anche volatilità.

I token di utilità affrontano il problema della velocità. Se gli utenti convertono immediatamente i token guadagnati in fiat o altre criptovalute, l'elevata velocità impedisce l'accumulo di valore. L'Equazione dello Scambio (M×V = P×Q) suggerisce che per un dato volume di transazioni (P×Q), una maggiore velocità (V) significa una minore capitalizzazione di mercato (M).

I protocolli mitigano la velocità attraverso diversi meccanismi. I requisiti di staking bloccano i token, riducendo la fornitura circolante. Bittensor richiede ai validatori di mettere in staking TAO. Fetch.ai premia gli stakers con commissioni sul network. I meccanismi di bruciatura come quello di Render rimuovono i token dalla circolazione in modo permanente. I diritti di governanza creano incentivi a detenere i token per il potere di voto.

Prestazioni del Mercato e Traiettorie

Bitcoin ha raggiunto massimi storici superiori a $126,000 nel 2025, continuando la sua traiettoria come asset macro. Ethereum si è ripreso dai cali post-2022, mantenendo la sua posizione come principale piattaforma di smart contract.

I token di utilità AI hanno mostrato prestazioni più volatili. TAO ha commerciato tra $200-$750 nel 2024-2025, con capitalizzazione di mercato che raggiunge $3.7-4.1 miliardi ai picchi. FET ha sperimentato movimenti significativi, in particolare intorno all'annuncio dell'Artificial Superintelligence Alliance. RENDER ha visto una crescita esplosiva nel 2023-2024 prima di consolidarsi.

Questi token trattano sia su base di speculazione sia di fondamentali. Quando i narrativi AI dominano il discorso crypto, i token di utilità sovraperformano. Durante i ribassi, spesso sottoperformano Bitcoin ed Ethereum mentre gli investitori si rifugiano in asset percepiti come più sicuri.

Coesistenza o Concorrenza?

La domanda è se i token di utilità rappresentino la "prossima onda" o coesistano come categoria complementare. Le prove suggeriscono che la coesistenza è più probabile. I token di riserva di valore servono a scopi diversi rispetto ai token operativi. Bitcoin funziona come oro digitale, Ethereum come livello di regolamento programmabile, mentre i token di utilità agiscono come carburante per applicazioni specifiche.

Tuttavia, il successo non è garantito. La maggior parte dei token di utilità potrebbe fallire se l'uso non si materializza o se le alternative centralizzate si dimostrano superiori. La capitalizzazione di mercato AI-crypto ha raggiunto $24-27 miliardi nel 2025, sostanziale ma piccola rispetto al solo Bitcoin che supera $2 trilioni.

I vincitori probabilmente dimostreranno:

- Uso sostenuto del network in crescita indipendente dalla speculazione

- Vantaggi chiari rispetto alle alternative centralizzate

- Forti ecosistemi di sviluppo e adozione aziendale

- Mitigazione efficace della velocità tramite staking o bruciatura

- Modelli di governanza che bilanciano decentralizzazione con efficienza

Il test finale è se i token di utilità diventano infrastruttura per carichi di lavoro AI su larga scala, o se rimangono soluzioni di nicchia oscurate dai fornitori di cloud centralizzati.

Valutazione, Metriche di Adozione e Rischi Narrativi

Valutare i token di utilità richiede quadri diversi rispetto alla valutazione degli asset di riserva di valore. Mentre Bitcoin può essere valutato tramite modelli stock-to-flow o come oro digitale comparabile ai metalli preziosi, i token di utilità richiedono metriche basate sull'uso.

Metriche Chiave per i Token di Utilità

Le statistiche sull'uso del network forniscono la base. Per Bittensor, le metriche significative includono:

- Numero di subnet attive e le loro specializzazioni

- Ore di calcolo dedicate all'addestramento dei modelli

- Numero di minatori e validatori che mettono in sicurezza il network

- Volume di transazioni che fluiscono attraverso il protocollo

- Distribuzioni di modelli di successo che servono applicazioni reali

Bittensor riporta 128 subnet attive alla fine del 2025, un aumento sostanziale rispetto ai periodi precedenti. Tuttavia, valutare se queste subnet generano domanda genuina rispetto all'attività speculativa richiede un'indagine più approfondita.

Per Fetch.ai, le metriche rilevanti includono:

- Numero di agenti autonomi distribuiti

- Interazioni agent-to-agent e volume di transazioni

- Integrazioni reali in vari settori

- Partnership con imprese o governi

- Partecipazione allo staking e conteggio dei validatori

Fetch.ai ha dimostrato prove di concetti in coordinamento parcheggi, trading energetico e logistica, ma il passaggio da progetti pilota all'adozione diffusa rimane la sfida.

Per Render Network, gli indicatori critici sono:

- Lavori di rendering processati mensilmente

- Numero di operatori nodi attivi che forniscono capacità GPU

- Clienti aziendali che usano il network per flussi di lavoro di produzione

- Tasso di bruciatura rispetto al tasso di emissione sotto Burn-and-Mint Equilibrium

- Ore GPU utilizzate attraverso il network decentralizzato

Render ha assicurato partnership importanti con studi e processa reali carichi di lavoro di rendering, fornendo più prove concrete di utilizzo rispetto a molti token di utilità.

Velocità dei Token e Metriche di Bruciatura

La velocità dei token misura quanto rapidamente i token circolano attraverso l'economia. Una velocità elevata indica utenti che spendono o convertono immediatamente i token, impedendo l'accumulazione di valore. Una velocità bassa suggerisce che i token siano detenuti più a lungo, potenzialmente come riserva di valore o per ricompense di staking.

Bitcoin dimostra una velocità del 4.1%, Ethereum del 3.6%, indicando asset maturi detenuti prevalentemente piuttosto cheSure, here's the translation of the content with markdown links unchanged:

Contenuto: transacted. I token di utilità mostrano tipicamente velocità più elevate inizialmente, poiché gli utenti ricevono i token per il lavoro e li convertono immediatamente in valute stabili.

I meccanismi di burning combattono l'alta velocità. Il sistema di Render brucia il 95% dei token di pagamento con ogni transazione, rimuovendo l'offerta. Se il tasso di bruciatura supera il tasso di conio, l'offerta in circolazione diminuisce, potenzialmente supportando l'apprezzamento del prezzo se la domanda rimane costante.

Valutare le bruciature richiede trasparenza. I progetti dovrebbero pubblicare regolari rapporti di bruciatura che mostrano i token rimossi dalla circolazione. Render fornisce questi dati, permettendo una verifica indipendente delle affermazioni deflazionistiche.

Partenariati e Integrazioni del Mondo Reale

L'adozione aziendale segnala un'autentica utilità. Il primo lancio di ETP di Bittensor sulla SIX Swiss Exchange fornisce accesso istituzionale. Il $500 milioni di tesoreria FET di Interactive Strength dimostra fiducia aziendale. Le partnership di Render con Disney, HBO e Unity convalidano le capacità della piattaforma per flussi di lavoro di produzione.

Tuttavia, le partnership da sole non garantiscono un uso sostenuto. Molti progetti blockchain annunciano partnership che non si concretizzano in entrate significative o attività di rete. Monitorare il volume effettivo delle transazioni derivanti dalle relazioni aziendali fornisce un'indicazione più chiara.

Rischi Narrativi

Diversi rischi narrativi minacciano le valutazioni dei token di utilità:

AI + Cripto Hype Senza Consegna: La convergenza di AI e blockchain crea narrative potenti, ma se i sistemi AI decentralizzati non riescono a eguagliare le prestazioni delle alternative centralizzate, le valutazioni si sgonfiano. La maggior parte degli esperti si aspetta che solo alcuni progetti AI-cripto abbiano successo a lungo termine, mentre molti rimangono speculativi.

Calcolo Senza Domanda: Costruire un'infrastruttura GPU decentralizzata è inutile se gli sviluppatori non la usano. Se l'uso non riesce a scalare oltre i primi utilizzatori e evangelisti, i token diventano soluzioni in cerca di problemi. La domanda è se il calcolo decentralizzato possa catturare una quota di mercato significativa da AWS, Google Cloud e altri giganti centralizzati.

Minacce Regolatorie: I governi di tutto il mondo stanno sviluppando regolamentazioni sull'IA. Il quadro di rischio dell'EU AI Act potrebbe classificare alcuni sistemi AI come ad alto rischio, richiedendo audit e supervisione. Gli agenti autonomi che prendono decisioni economiche potrebbero essere sottoposti a scrutinio. L'incertezza sul fatto che i token di utilità costituiscano titoli aggiunge rischio regolatorio.

Centralizzazione Hardware: Le reti decentralizzate rischiano di recentralizzarsi. Se il mining o l'operazione dei nodi diventa economicamente fattibile solo per i grandi player con economie di scala, la promessa di decentralizzazione svanisce. Le reti GPU potrebbero consolidarsi attorno ai principali centri dati, sconfiggendo lo scopo dell'infrastruttura peer-to-peer.

Limitazioni Tecniche: I sistemi decentralizzati affrontano compromessi intrinseci. Il sovraccarico di coordinazione, la latenza e le preoccupazioni sulla affidabilità possono impedire ai token di utilità di competere con le alternative centralizzate ottimizzate. Se le limitazioni tecniche si rivelano insormontabili, l'adozione si blocca.

Quadri di Valutazione

I modelli finanziari tradizionali lottano con i token di utilità. Il flusso di cassa scontato (DCF) funziona per i token con condivisione dei profitti—Augur paga i detentori di REP per il lavoro di rete, creando flussi di cassa analizzabili tramite DCF. Ma i token di pura utilità senza dividendi mancano di flussi di cassa evidenti da scontare.

L'Equazione di Scambio offre un approccio: M×V = P×Q, dove M è la capitalizzazione di mercato (ciò che stiamo risolvendo), V è la velocità, P è il prezzo per transazione, e Q è la quantità di transazioni. Riorganizzando: M = P×Q / V. Questo implica che la capitalizzazione di mercato è uguale al volume delle transazioni diviso per la velocità.

Un volume di transazioni più alto (P×Q) supporta valutazioni più alte. Una velocità più bassa (V) supporta anche valutazioni più alte. I progetti devono o aumentare l'uso o ridurre la velocità - idealmente entrambi. Lo staking riduce la velocità; i meccanismi di bruciatura riducono l'offerta; la vera utilità aumenta il volume delle transazioni.

La Legge di Metcalfe suggerisce che il valore di rete cresce proporzionalmente al quadrato degli utenti. Con il crescere del numero di partecipanti a Bittensor, Fetch.ai o Render, gli effetti di rete potrebbero guidare una crescita di valore esponenziale. Tuttavia, questa legge presume che tutte le connessioni siano preziose - non sempre vero per le reti in fase iniziale.

La valutazione comparativa guarda a progetti simili. Se Bittensor raggiunge un uso di rete simile a SingularityNET o Ocean Protocol, confrontare le capitalizzazioni di mercato fornisce benchmark approssimativi. Tuttavia, la tokenomica unica e i casi d'uso di ciascun progetto limitano l'utilità di confronti diretti.

In definitiva, la valutazione dei token di utilità rimane speculativa. Finché le reti non dimostrano un uso sostenuto indipendentemente dalla speculazione, i prezzi riflettono la forza narrativa e il sentiment del mercato tanto quanto il valore fondamentale.

Cosa Viene Dopo: Scenari per il Futuro

La traiettoria per i token utilità-AI dipende da diverse variabili incerte: tassi di adozione tecnologica, sviluppi regolatori, concorrenza da parte dei fornitori centralizzati e la capacità dei token di catturare valore dall'uso della rete. Tre ampi scenari illuminano i possibili futuri.

Miglior Scenario: I Token di Infrastruttura Diventano Livello Core

In questo scenario ottimistico, l'infrastruttura AI decentralizzata raggiunge l'adozione mainstream. Bittensor diventa la piattaforma preferita per l'addestramento collaborativo di modelli AI, attirando importanti istituzioni di ricerca e imprese. L'architettura subnet si dimostra superiore ai framework centralizzati per alcuni casi d'uso - AI sanitaria che preserva la privacy, marketplace di modelli decentralizzati, intelligenza crowdsourced.

Gli agenti autonomi di Fetch.ai proliferano tra le industrie. Le città intelligenti implementano reti di agenti per il coordinamento del traffico, la distribuzione energetica e i servizi pubblici. Le catene di fornitura standardizzano su ottimizzazione basata su agenti. I protocolli DeFi integrano agenti per l'esecuzione automatizzata della strategia. L'"economia agentica" si materializza come previsto, con miliardi di micro-transazioni coordinate da software autonomo.

Render Network cattura una quota di mercato significativa dai fornitori di GPU centralizzati. I professionisti creativi e i ricercatori AI utilizzano abitualmente il calcolo decentralizzato per i flussi di lavoro di produzione. Il mercato globale del cloud gaming, proiettato per raggiungere $121 miliardi entro il 2032 spinge la domanda per l'infrastruttura GPU distribuita.

In questo scenario, i token di utilità acquisiscono valore duraturo attraverso:

- Crescita dell'uso sostenuta: L'attività di rete aumenta indipendentemente dalla speculazione

- Mitigazione della velocità: Meccanismi di staking, burning e incentivi di governance mantengono i token detenuti invece che venduti immediatamente

- Effetti di rete: Man mano che più utenti si uniscono, le piattaforme diventano più preziose per tutti i partecipanti

- Chiarezza regolatoria: Emergere di framework che consentono AI decentralizzati proteggendo i consumatori

I prezzi dei token potrebbero raggiungere proiezioni ottimistiche degli analisti - TAO superando $1,000, FET avvicinandosi a $6-10, RENDER superando $20 - se i fondamenti dell'uso giustificano le valutazioni. Le capitalizzazioni di mercato crescerebbero proporzionalmente, con i principali token AI-utilità che potrebbero raggiungere valutazioni di $20-50 miliardi mentre catturano porzioni dei mercati AI e cloud computing da trilioni di dollari.

Per gli investitori, questo rappresenta un apprezzamento significativo rispetto ai livelli attuali. Per gli sviluppatori, convalida l'infrastruttura decentralizzata come alternativa valida ai fornitori di cloud centralizzati. Per i mercati cripto, dimostra che i token di utilità possono evolversi oltre la speculazione in asset infrastrutturali funzionali.

Scenario di Base: Alcuni Token Raggiungono il Successo, Molti Stagnano

Uno scenario realistico riconosce che solo un sottoinsieme degli attuali token di utilità-AI raggiungerà un'adozione sostenuta. I vincitori si distinguono per la tecnologia superiore, forti ecosistemi, vere partnership e meccanismi efficaci di cattura del valore. La maggior parte dei progetti raggiunge un plateau o scompare man mano che gli utenti riconoscono una utilità pratica limitata.

In questo scenario, Bittensor, Fetch.ai e Render - come progetti leader - hanno migliori possibilità rispetto a concorrenti più piccoli. Tuttavia, anche questi affrontano sfide. L'AI decentralizzata si dimostra preziosa per specifici segmenti di mercato - applicazioni critiche per la privacy, reti resistenti alla censura, alcuni domini di ricerca - ma non riesce a sostituire i fornitori centralizzati per la maggior parte dei casi d'uso.

I token di riserva di valore rimangono dominanti. Bitcoin solidifica la sua posizione come oro digitale. Ethereum continua a servire come principale livello di regolamento per applicazioni decentralizzate. I token utilità-AI coesistono come infrastrutture per applicazioni specializzate piuttosto che piattaforme di uso generale.

I prezzi dei token riflettono una crescita modesta dell'uso. TAO potrebbe raggiungere $500-800, FET $2-4, RENDER $8-12 nei prossimi anni - apprezzamento significativo ma lontano dalle previsioni esplosive. Le capitalizzazioni di mercato crescono, ma rimangono ordini di grandezza al di sotto di Bitcoin e Ethereum.

Diversi fattori caratterizzano questo scenario di base:

- Adozione di nicchia: I token di utilità servono efficacemente specifici verticali o casi d'uso

- Competizione centralizzata: AWS, Google Cloud e altri giganti mantengono il predominio per il calcolo generale

- Sovraccarico regolatorio: I requisiti di conformità aggiungono attrito alle piattaforme decentralizzate

- Compromessi tecnici: I sistemi decentralizzati si dimostrano più lenti, complessi o meno affidabili delle alternative centralizzate per molte applicazioni

Per gli investitori, un apprezzamento moderato ricompensa i primi sostenitori ma underperform rispetto alla maggior parte delle previsioni più ottimistiche. Per i mercati cripto, i token di utilità stabiliscono legittimità come categoria di asset distinta dai token di riserva di valore, ma con una crescita più moderata.

Let me know if you need further assistance!Sure, here's the translated content with markdown links skipped:

Svantaggio: l'uso non si materializza

Lo scenario pessimista vede i token di utilità incapaci di tradurre le capacità tecniche in una domanda sostenuta. Nonostante l'infrastruttura impressionante, gli utenti non migrano dalle piattaforme consolidate. Gli sviluppatori continuano a utilizzare TensorFlow, PyTorch e il cloud computing centralizzato anziché apprendere nuovi protocolli decentralizzati. I professionisti creativi rimangono fedeli ad Adobe, Autodesk e alle tradizionali farm per il rendering invece di sperimentare alternative abilitate per criptovalute.

In questo scenario, i token di utilità AI diventano principalmente asset speculativi. I prezzi fluttuano basandosi sul sentimento del mercato delle criptovalute più ampio e sui cicli di moda dell'AI piuttosto che sull'uso fondamentale. Quando le narrazioni svaniscono - come è successo per molti token ICO del 2017-2018 - le valutazioni crollano.

Diverse dinamiche potrebbero produrre questo risultato:

- Attrito nell'esperienza utente: gestire portafogli, pagare le tasse di transazione e navigare nei protocolli decentralizzati risulta troppo faticoso per gli utenti comuni

- Gap di prestazioni: le alternative centralizzate rimangono più veloci, affidabili e ricche di funzionalità rispetto alle opzioni decentralizzate

- Viabilità economica: l'economia del token non riesce ad allineare correttamente gli incentivi, portando a abbandoni da parte dei fornitori, problemi di qualità o instabilità della rete

- Repressioni normative: i governi classificano i token di utilità come titoli o vietano determinate applicazioni, limitando l'uso legale

I prezzi dei token tornerebbero a livelli speculativi bassi. TAO potrebbe scendere sotto i 200 dollari, FET sotto i 0,50 dollari, RENDER sotto i 3 dollari poiché gli investitori riconoscono la mancanza di domanda fondamentale. I progetti potrebbero sopravvivere con comunità dedicate ma non riuscire ad raggiungere una scala significativa.

Questo scenario rappresenta un rischio esistenziale per la categoria dei token di utilità. Se i progetti principali con finanziamenti sostanziali, team talentuosi e reali partnership non riescono a dimostrare un fit nel prodotto-mercato, suggerisce che il modello decentralizzato AI/compute fondamentalmente non funziona su larga scala.

Implicazioni in tutti gli scenari

Per gli investitori: i profili di rischio-rendimento variano notevolmente nei diversi scenari. Il caso migliore offre ritorni multipli, ma richiede che diverse incertezze si risolvano favorevolmente. Il caso base fornisce un apprezzamento modesto con minore rischio. Il lato negativo implica perdite significative.

La costruzione del portafoglio dovrebbe tenere conto delle probabilità degli scenari. Allocare piccole percentuali ai token di utilità offre un vantaggio asimmetrico se si materializza il caso migliore, limitando al contempo l'esposizione al rischio. Concentrarsi nei token di utilità rispetto agli asset di riserva di valore aumenta la volatilità e il rischio.

Per gli sviluppatori: costruire su piattaforme di token di utilità richiede di valutare la viabilità a lungo termine. Se si materializzano scenari di base o negativi, le applicazioni costruite su queste piattaforme potrebbero avere difficoltà a trovare utenti o finanziamenti. Gli sviluppatori dovrebbero mantenere l'opzionalità, progettando applicazioni portabili attraverso le piattaforme o capaci di operare con backend centralizzati, se l'infrastruttura decentralizzata si dimostrasse inadeguata.

Per la struttura del mercato delle criptovalute: il successo o il fallimento dei token di utilità modella l'evoluzione delle criptovalute. Se si realizza il caso migliore, le criptovalute si espandono oltre la riserva di valore e la DeFi verso una vera infrastruttura. Se si verifica il lato negativo, le criptovalute rimangono principalmente un dominio speculativo e finanziario.

Cosa osservare

Diversi indicatori chiariranno quale scenario si svilupperà:

Conteggio dei nodi e partecipazione: un numero crescente di miner, validatori e fornitori di GPU segnala veri effetti di rete. Partecipazione stagnante o in declino suggerisce mancanza di viabilità economica.

Lavori di calcolo elaborati: lavori di rendering reali, esecuzioni di addestramento AI e interazioni tra agenti - non solo attività su testnet - dimostrano una vera domanda. I progetti dovrebbero pubblicare statistiche di utilizzo trasparenti.

Partnership aziendali: convertire le partnership annunciate in volume di transazioni misurabile valida i modelli di business. Le partnership senza un uso accompagnatorio indicano potenziale vaporware.

Bruciature di token e staking: per i progetti con meccanismi di bruciatura, un tasso di bruciatura superiore al tasso di conio indica una forte domanda. Un'alta partecipazione allo staking riduce la velocità e mostra fiducia a lungo termine nei detentori.

Attività degli sviluppatori: ecosistemi di sviluppatori in crescita - misurati dai commit su GitHub, nuovi protocolli costruiti sulle piattaforme, partecipazione a hackathon - segnalano fondamenta sane. Un interesse degli sviluppatori in declino prefigura stagnazione.

Chiarezza normativa: quadri più chiari sui token di utilità, sistemi AI e infrastruttura decentralizzata riducono l'incertezza. Normative favorevoli accelerano l'adozione; quelle restrittive la ostacolano.

Ecosistemi hardware: l'integrazione con i principali produttori di GPU o fornitori di cloud legittimizza il calcolo decentralizzato. Nvidia, AMD e altri che collaborano o riconoscono le piattaforme di token di utilità segnalerebbero una convalida mainstream.

Seguire queste metriche nel periodo 2025-2027 chiarirà se i token di utilità-AI rappresentano una vera innovazione nell'infrastruttura o principalmente veicoli speculativi. La distinzione determinerà se questi asset raggiungeranno un'importanza duratura nei mercati delle criptovalute o sbiadiranno come un altro ciclo narrativo che si conclude.

Pensieri finali

I token di utilità-AI rappresentano un'evoluzione significativa nella narrativa architettonica delle criptovalute. Bittensor, Fetch.ai e Render Network dimostrano che i token possono servire a scopi oltre alla riserva di valore o al trading speculativo: possono coordinare infrastrutture decentralizzate, incentivare il lavoro computazionale e abilitare economie macchina-a-macchina.

La tesi fondamentale è convincente. Le reti GPU decentralizzate aggregano risorse sottoutilizzate, riducendo i costi e democratizzando l'accesso. Gli agenti autonomi abilitano la coordinazione a scale impraticabili per la mediazione umana. Lo sviluppo collaborativo di AI distribuisce la creazione di intelligenza oltre i monopoli dei giganti tecnologici. Queste visioni affrontano problemi reali nella scalabilità dell'infrastruttura, nell'accessibilità all'AI e nella coordinazione economica.

Tuttavia, tradurre la visione in un'adozione sostenuta rimane la sfida cruciale. I token di utilità devono dimostrare vantaggi chiari rispetto alle alternative centralizzate mentre superano l'attrito intrinseco ai sistemi decentralizzati. Devono catturare valore attraverso l'uso piuttosto che la speculazione, risolvere il problema della velocità attraverso una tokenomica efficace e raggiungere il fit nel prodotto-mercato con le aziende e gli sviluppatori.

Il passaggio dalla riserva di valore ai token di utilità è importante per la prossima fase delle criptovalute. Se riusciti, i token di utilità dimostrano che le criptovalute abilitano un'infrastruttura funzionale, non solo asset finanziari. Questo espande notevolmente il mercato indirizzabile totale - dagli investitori che cercano esposizione all'oro digitale o ai rendimenti DeFi, agli sviluppatori che necessitano di risorse computazionali e alle imprese che ottimizzano le operazioni.

Le evidenze restano miste. Esistono usi reali - Render processa lavori di rendering di produzione, Fetch.ai ha implementato piloti in vari settori, Bittensor opera sub-network AI attive. Eppure i volumi di utilizzo restano piccoli rispetto alle valutazioni. Capitalizzazioni di mercato in miliardi prezzano una crescita futura sostanziale che potrebbe non materializzarsi.

I prossimi anni determineranno quale scenario si svilupperà. L'infrastruttura AI decentralizzata catturerà porzioni significative di mercati da trilioni di dollari? Le economie di agenti autonomi prolifereranno oltre le applicazioni di nicchia? Oppure i vantaggi delle alternative centralizzate in termini di prestazioni, affidabilità ed esperienza utente risulteranno insormontabili?

Per gli investitori e gli sviluppatori, monitorare l'uso e la crescita dell'infrastruttura separa i veri vincitori dai progetti di sole narrazioni. Il conteggio degli operatori di nodi, i lavori di calcolo elaborati, i tassi di bruciatura dei token, le partnership aziendali e gli ecosistemi degli sviluppatori forniscono segnali in mezzo alla speculazione.

La realizzazione più importante è che i token di utilità affrontano sfide fondamentalmente diverse rispetto agli asset di riserva di valore. Bitcoin ha avuto successo essendo scarso e sicuro - l'adozione significava convincere le persone a detenerlo. I token di utilità devono essere utilizzati - l'adozione significa convincere gli sviluppatori a costruire su di essi e le imprese a integrarli nei workflows di produzione. Questa è un'asticella più alta, ma anche potenzialmente più impattante se raggiunta.

Man mano che i mercati delle criptovalute maturano oltre la pura speculazione verso un'infrastruttura funzionale, i token di utilità AI convalidano questa evoluzione o fungono da avvertimento sui rischi di promettere troppo e mantenere poco. La tecnologia esiste, la visione è articolata e il capitale è disponibile. Ciò che rimane incerto è se la domanda su larga scala si materializzerà o se, ancora una volta, le criptovalute abbiano costruito infrastrutture in attesa di utenti che potrebbero non arrivare mai.